add doc

Showing

doc/DEPLOY.md

0 → 100644

doc/deploy/.DS_Store

0 → 100755

文件已添加

doc/deploy/cluster-info.png

0 → 100755

98.2 KB

doc/deploy/concole.png

0 → 100755

109.7 KB

doc/deploy/conf-download.png

0 → 100755

70.9 KB

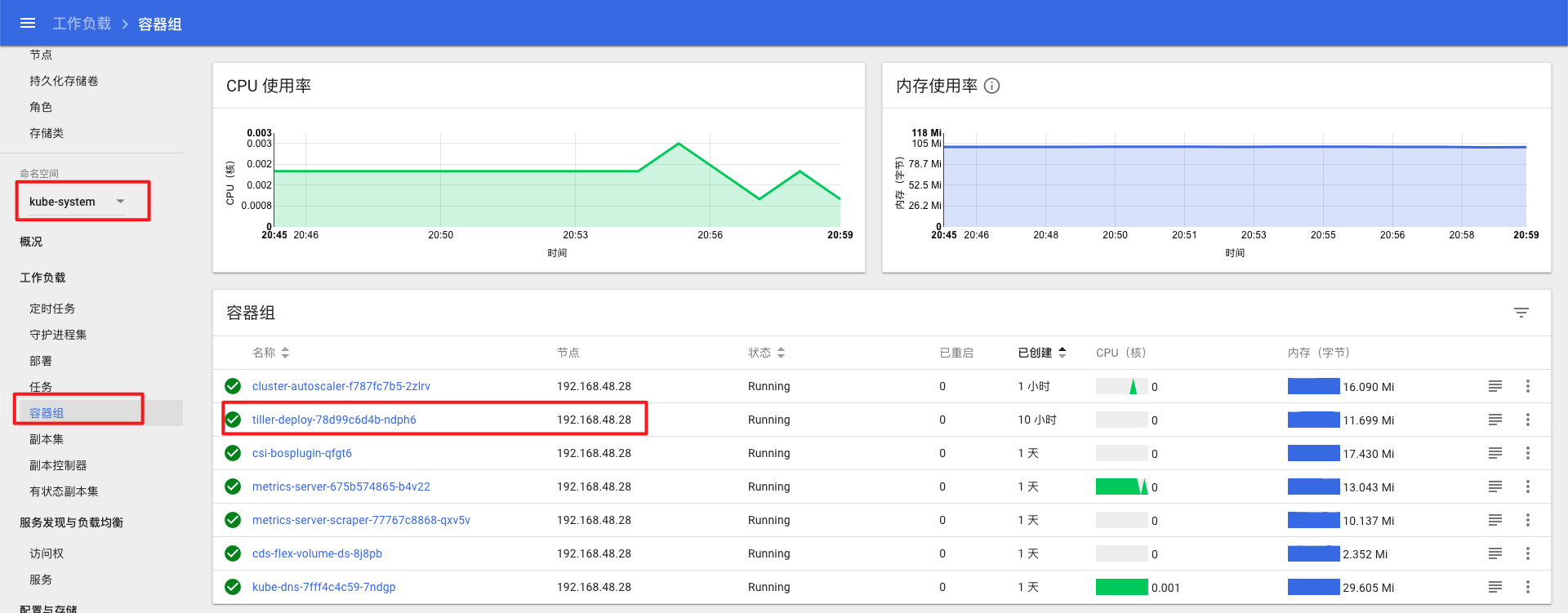

doc/deploy/ctr-running.png

0 → 100755

26.1 KB

doc/deploy/eip.png

0 → 100755

39.1 KB

doc/deploy/helm-version.png

0 → 100755

24.7 KB

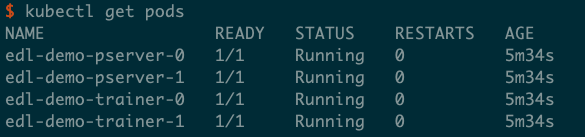

doc/deploy/kubectl-version.png

0 → 100755

45.3 KB

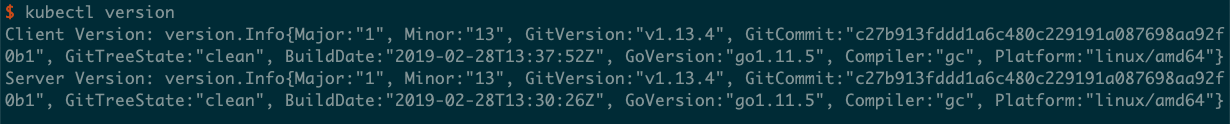

doc/deploy/tiller.png

0 → 100755

163.6 KB

doc/deploy/trainer-log.png

0 → 100755

138.9 KB

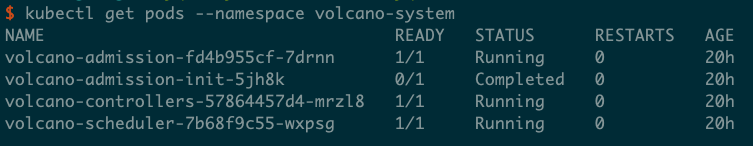

doc/deploy/volcano.png

0 → 100755

33.9 KB

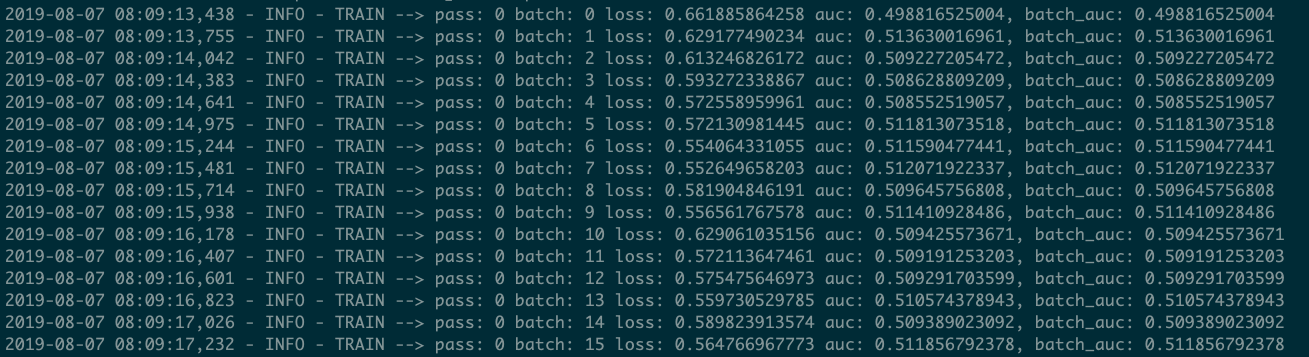

doc/deploy/workload.png

0 → 100755

125.1 KB