Merge branch 'master' of https://github.com/PaddlePaddle/PaddleSeg

pull before pr

Showing

configs/icnet_pet.yaml

0 → 100644

172.9 KB

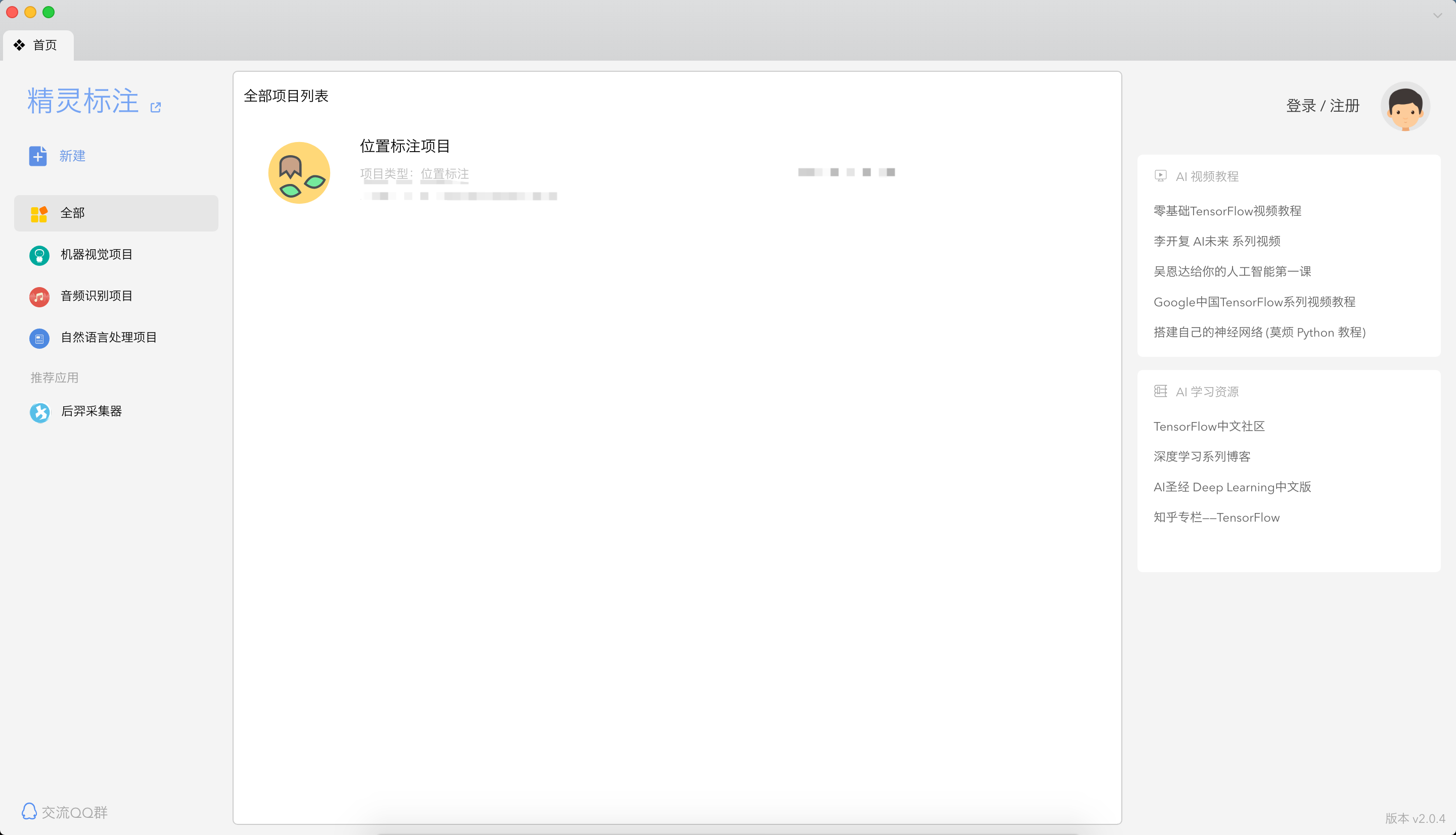

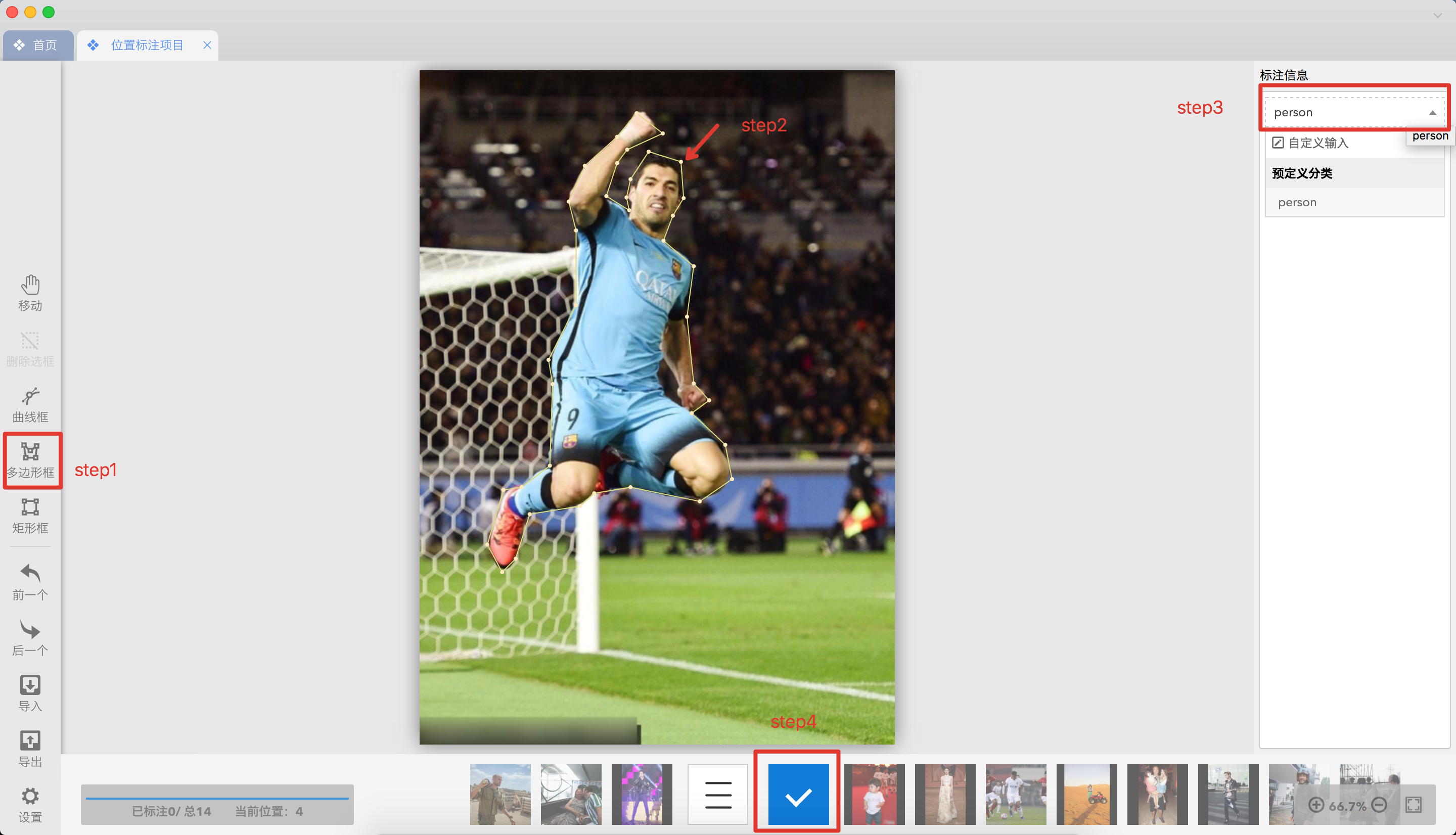

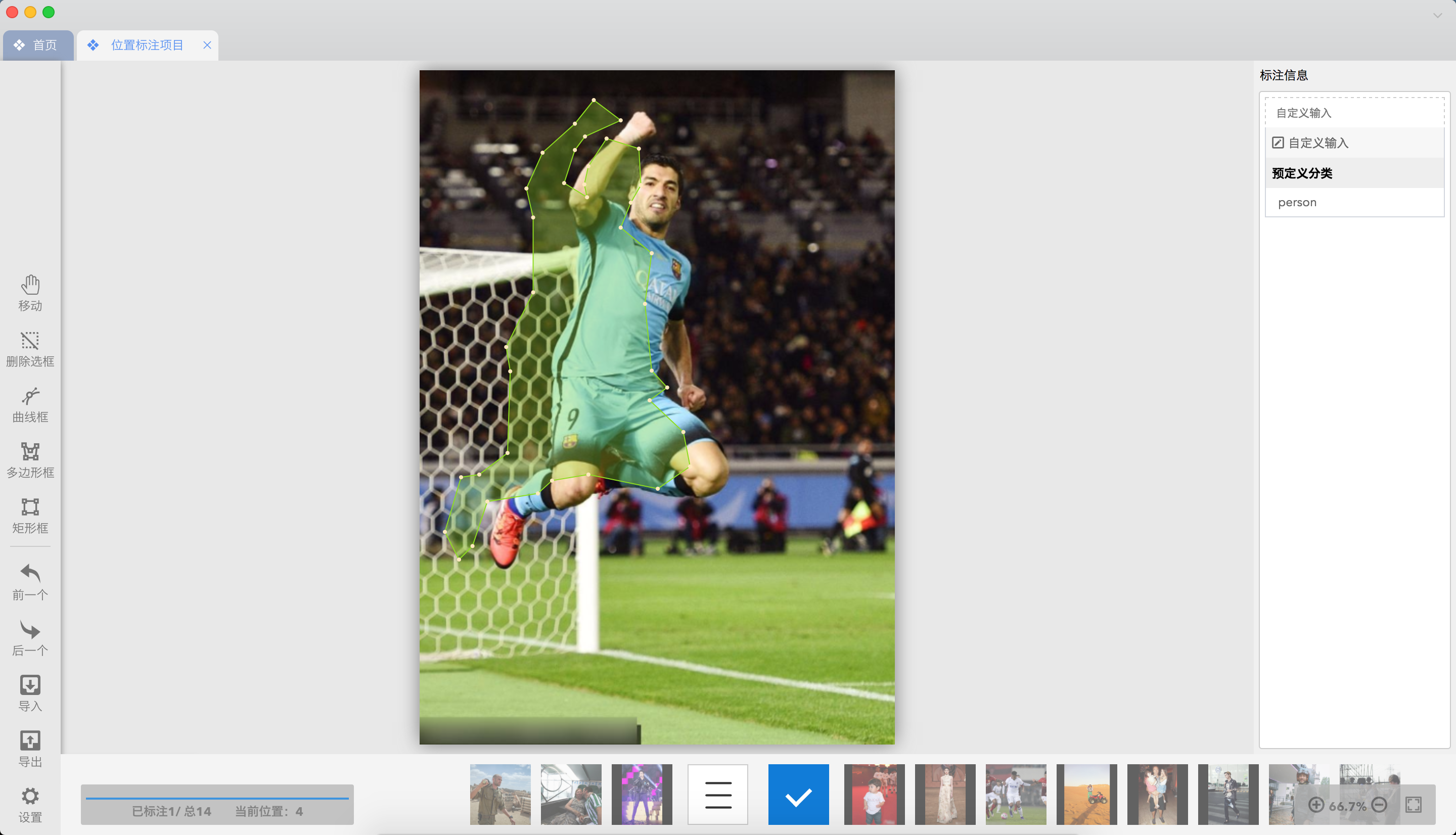

docs/annotation/jingling2seg.md

0 → 100644

docs/annotation/jingling2seg.py

0 → 100644

docs/annotation/labelme2seg.md

0 → 100644

docs/check.md

0 → 100644

260.6 KB

2.1 MB

2.1 MB

15.8 KB

153.7 KB

| W: | H:

| W: | H:

629.1 KB

| W: | H:

| W: | H:

docs/imgs/qq_group2.png

0 → 100644

4.6 KB

docs/model_export.md

0 → 100644

pdseg/models/modeling/pspnet.py

0 → 100644

turtorial/finetune_icnet.md

0 → 100644

turtorial/finetune_pspnet.md

0 → 100644

turtorial/finetune_unet.md

0 → 100644