Repalce fruit dataset with roadsign dataset, and update QUICK_STARTED, use...

Repalce fruit dataset with roadsign dataset, and update QUICK_STARTED, use PP-YOLO as demo, test=document_fix. (#1407)

Showing

demo/road554.png

0 → 100644

188.8 KB

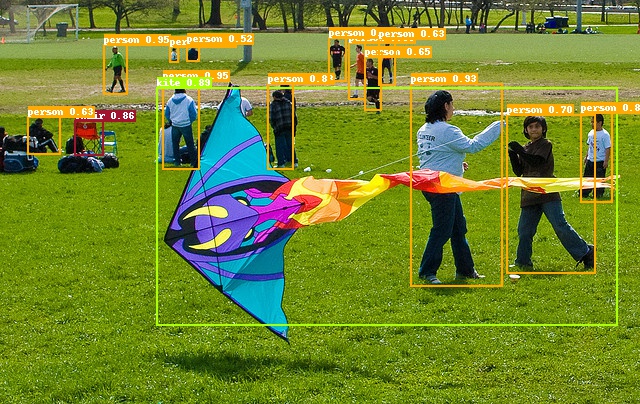

docs/images/000000014439.jpg

0 → 100644

202.7 KB

273.6 KB

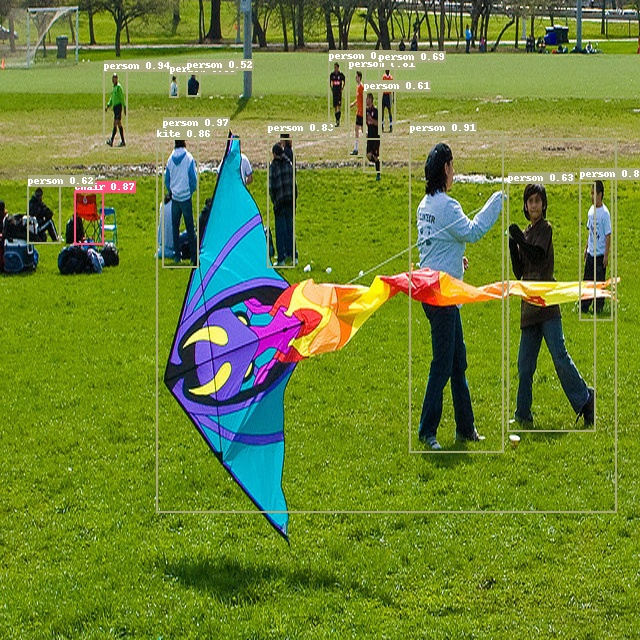

docs/images/road554.png

0 → 100644

142.3 KB