更新3. Spider/2.png, 3. Spider/3.png, 3. Spider/4.png, 3. Spider/5.png, 3....

更新3. Spider/2.png, 3. Spider/3.png, 3. Spider/4.png, 3. Spider/5.png, 3. Spider/6.png, 3. Spider/7.png, 3. Spider/8.png, 3. Spider/9.png, 3. Spider/家里蹲.png, 3. Spider/爬.md, 开发者界面.png, 开发者界面2.png, 爬虫.md

Showing

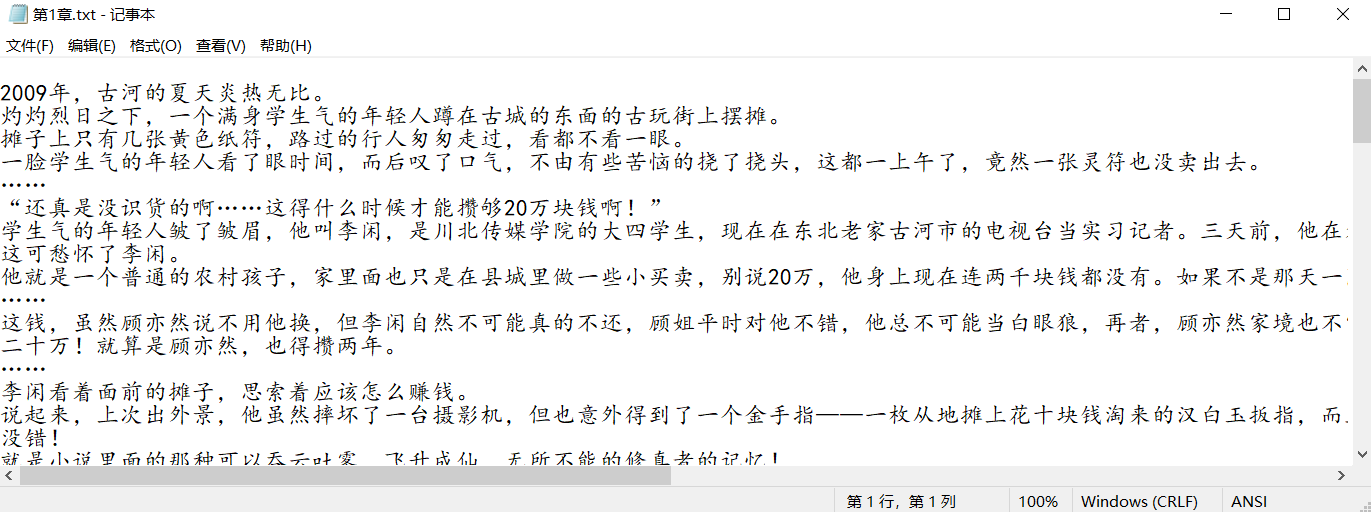

3. Spider/2.png

0 → 100644

109.7 KB

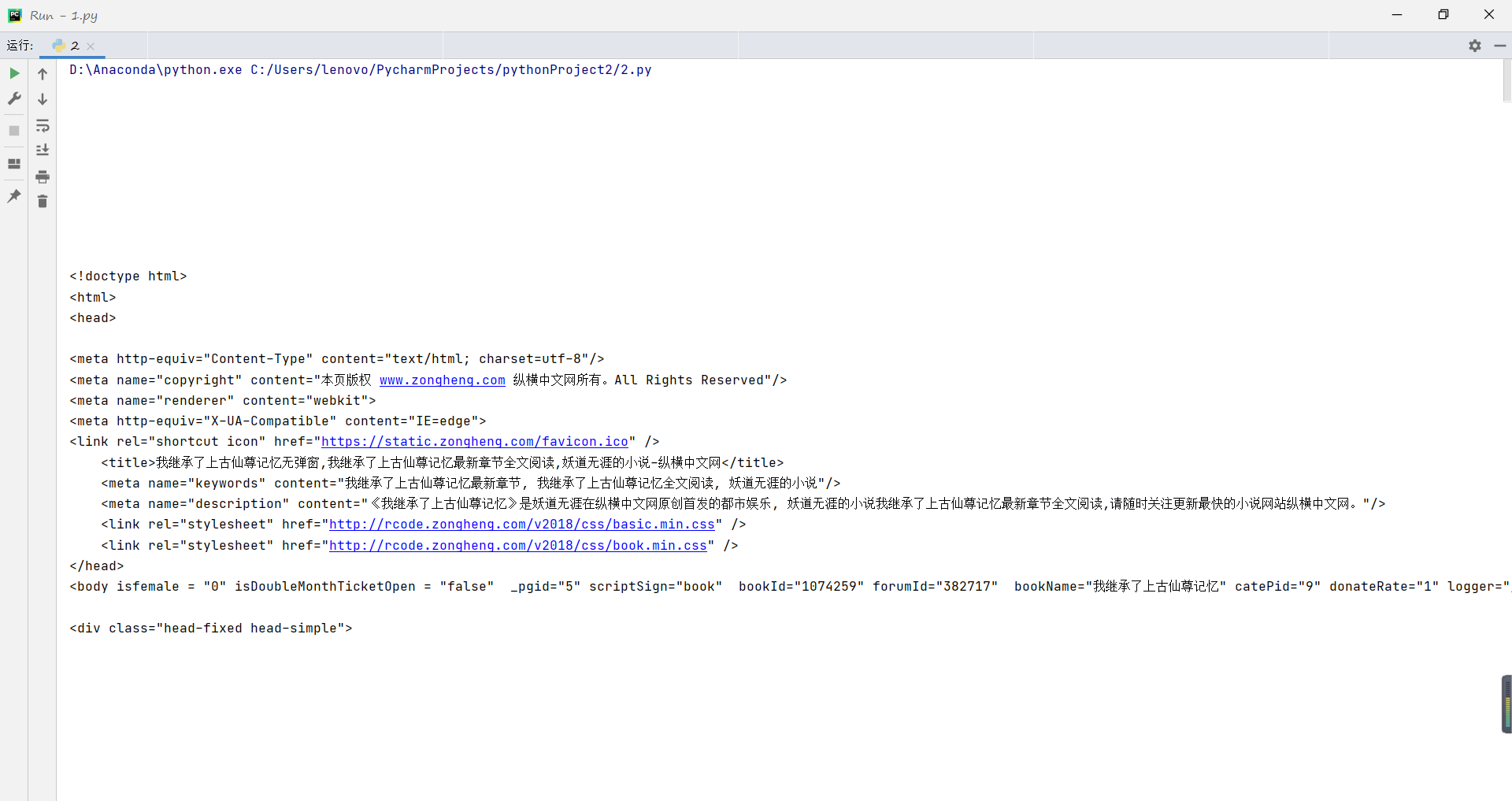

3. Spider/3.png

0 → 100644

140.7 KB

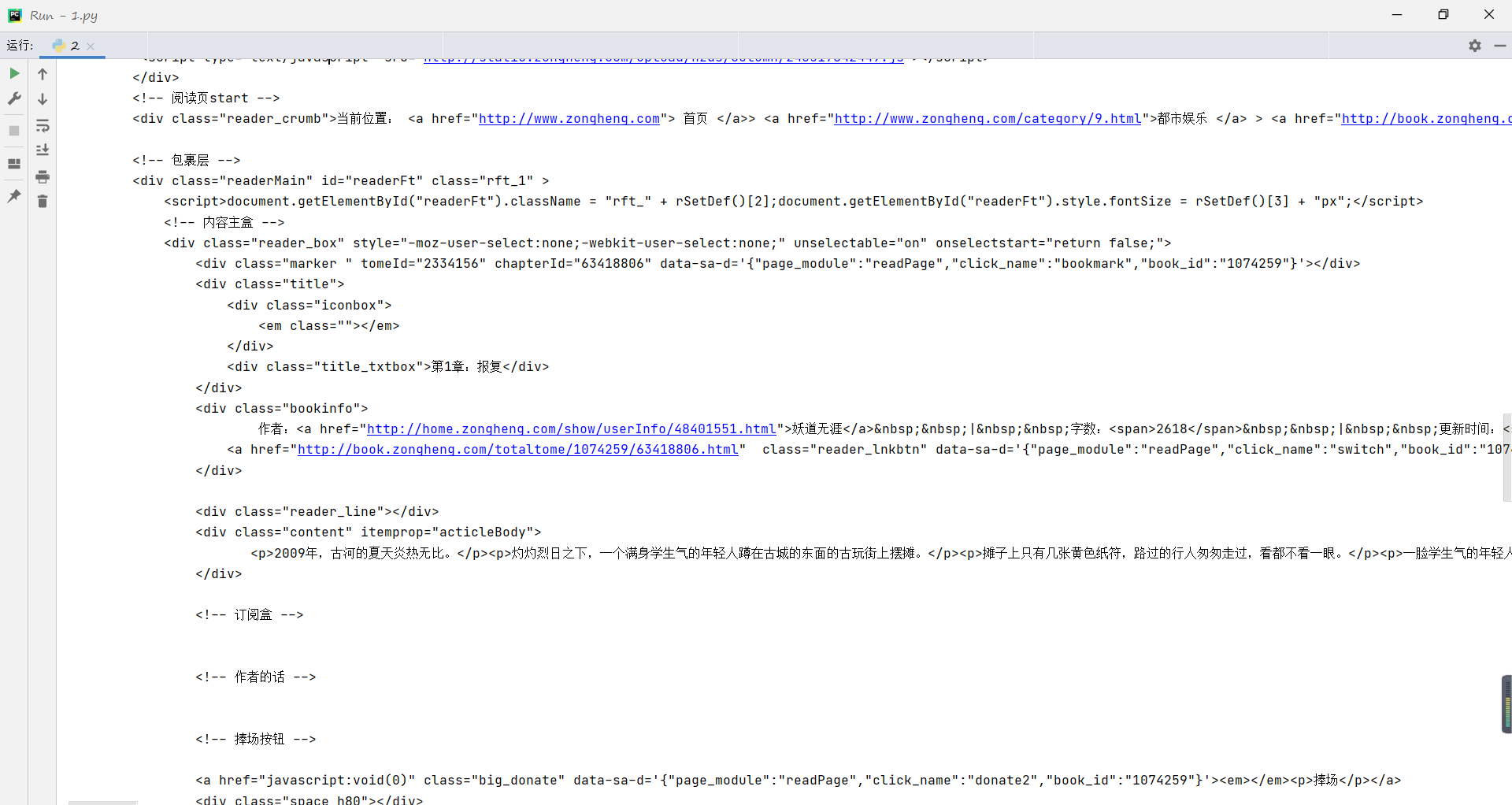

3. Spider/4.png

0 → 100644

32.4 KB

3. Spider/5.png

0 → 100644

106.7 KB

3. Spider/6.png

0 → 100644

122.1 KB

3. Spider/7.png

0 → 100644

91.2 KB

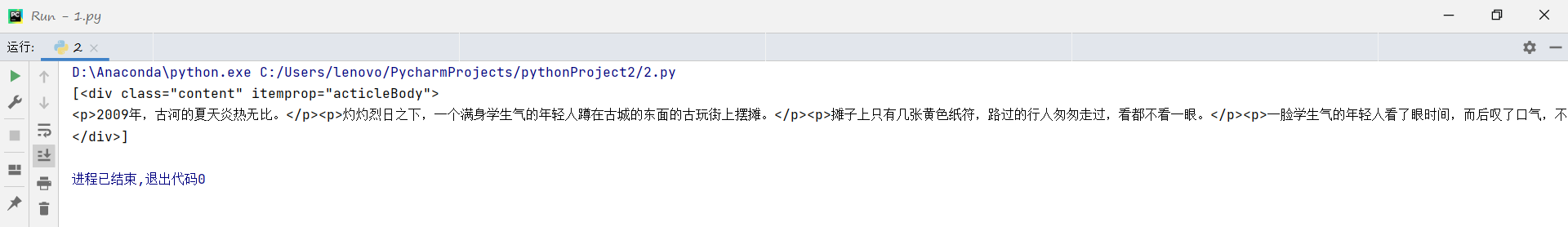

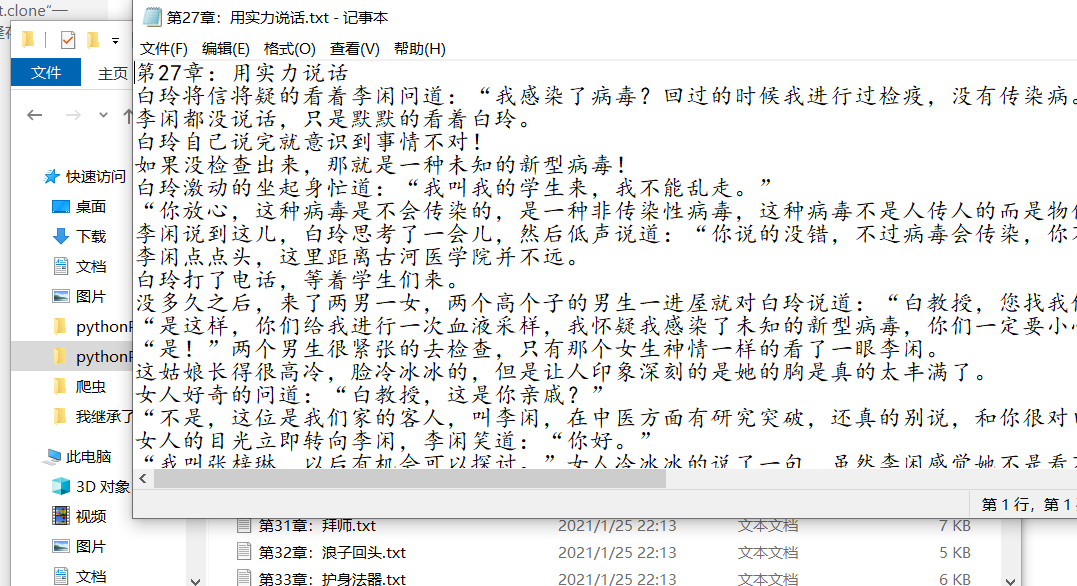

3. Spider/8.png

0 → 100644

90.6 KB

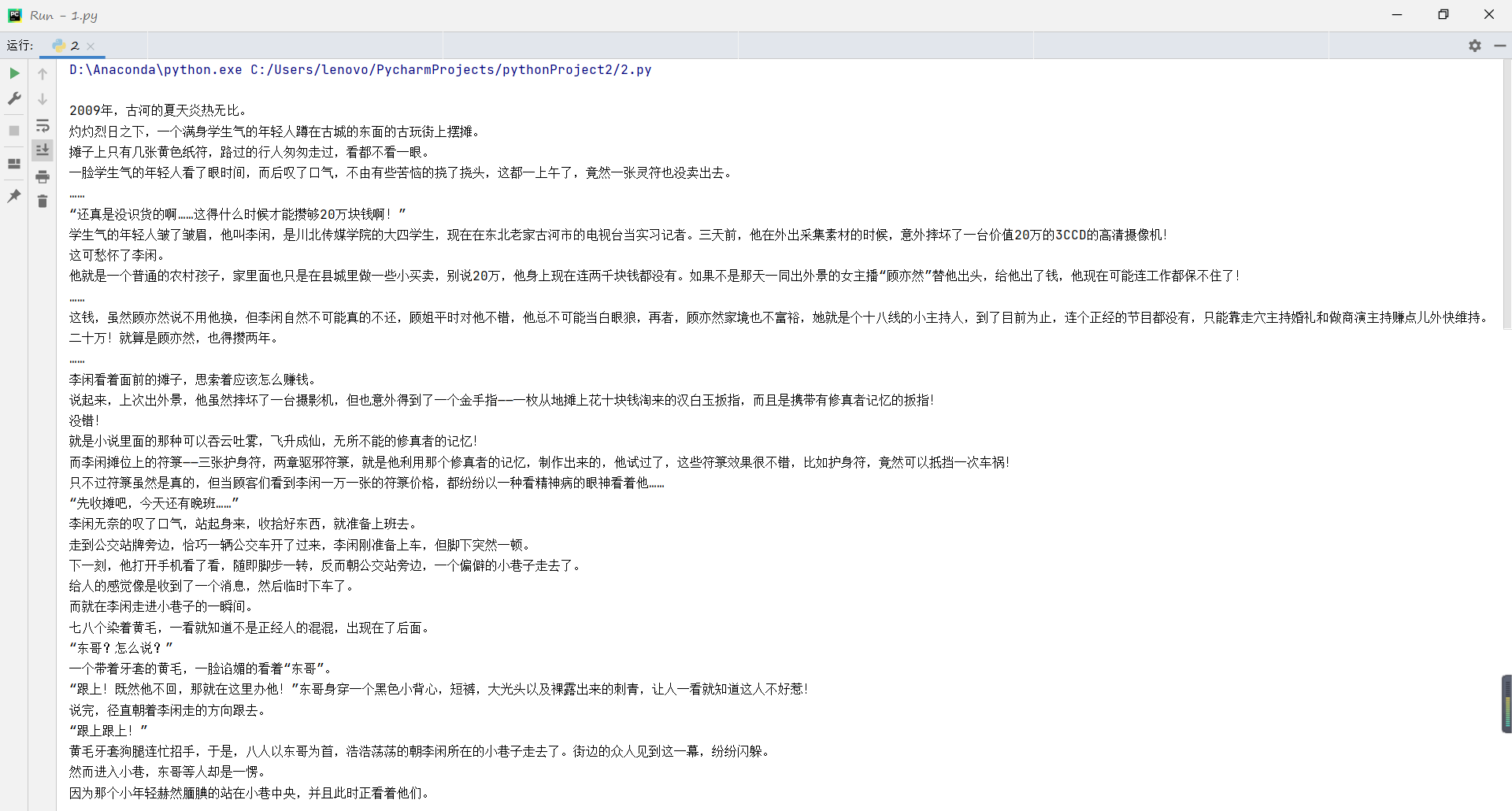

3. Spider/9.png

0 → 100644

173.4 KB

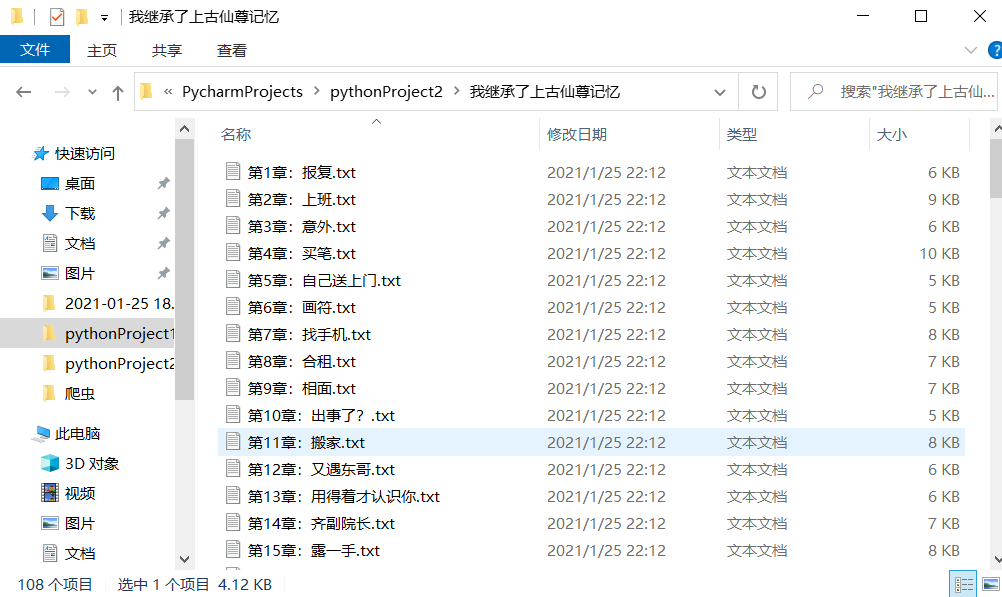

3. Spider/家里蹲.png

0 → 100644

31.8 KB

3. Spider/爬.md

0 → 100644

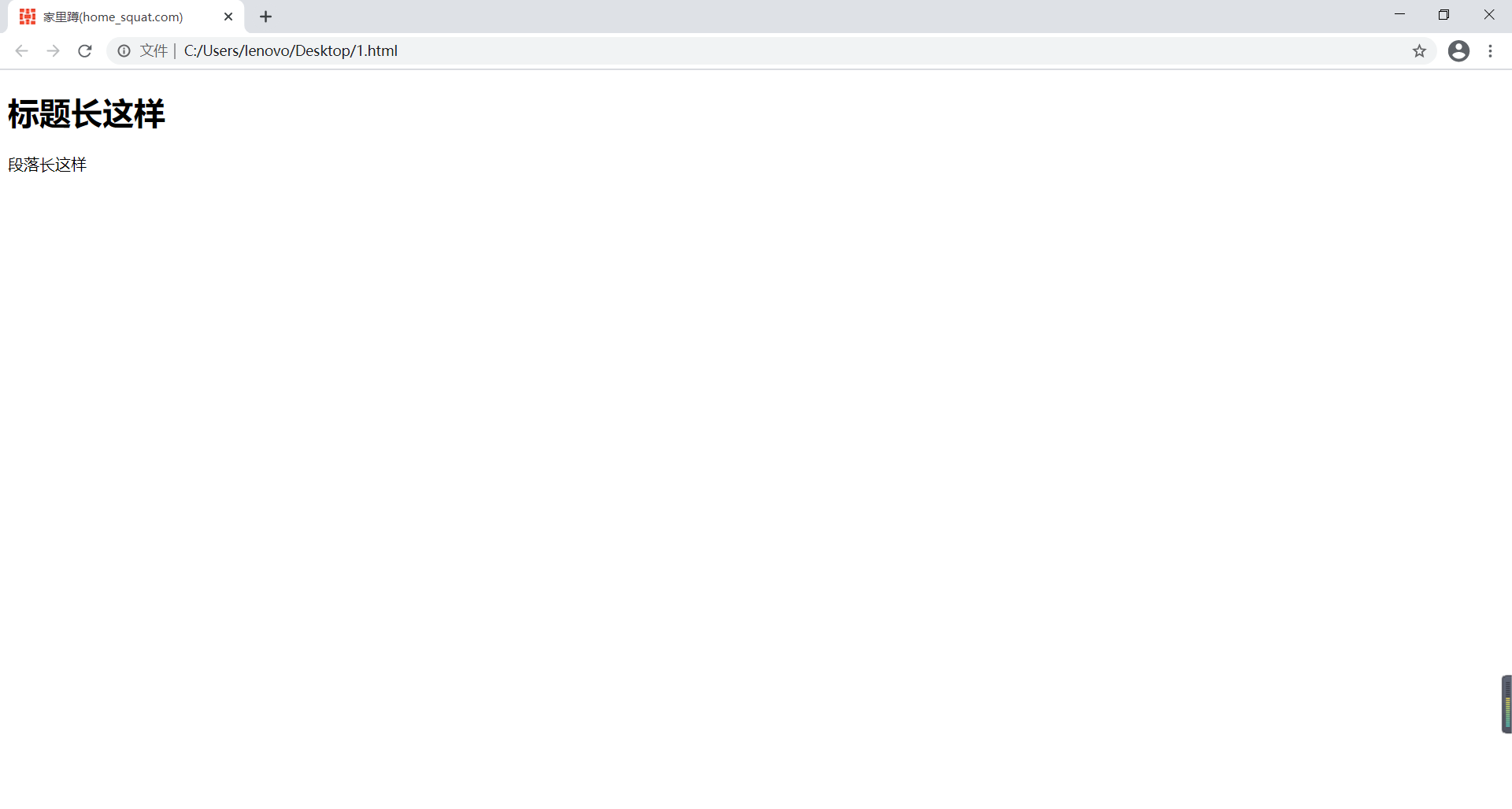

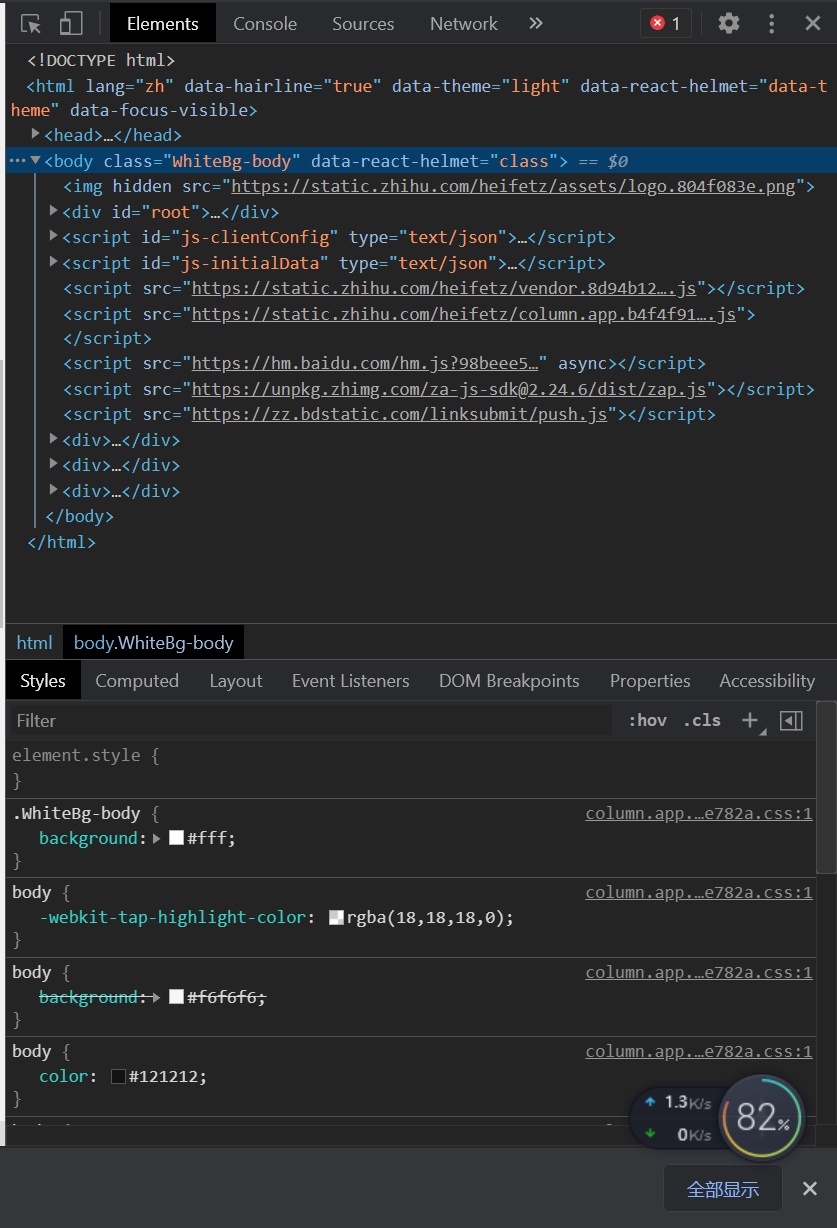

开发者界面.png

0 → 100644

137.1 KB

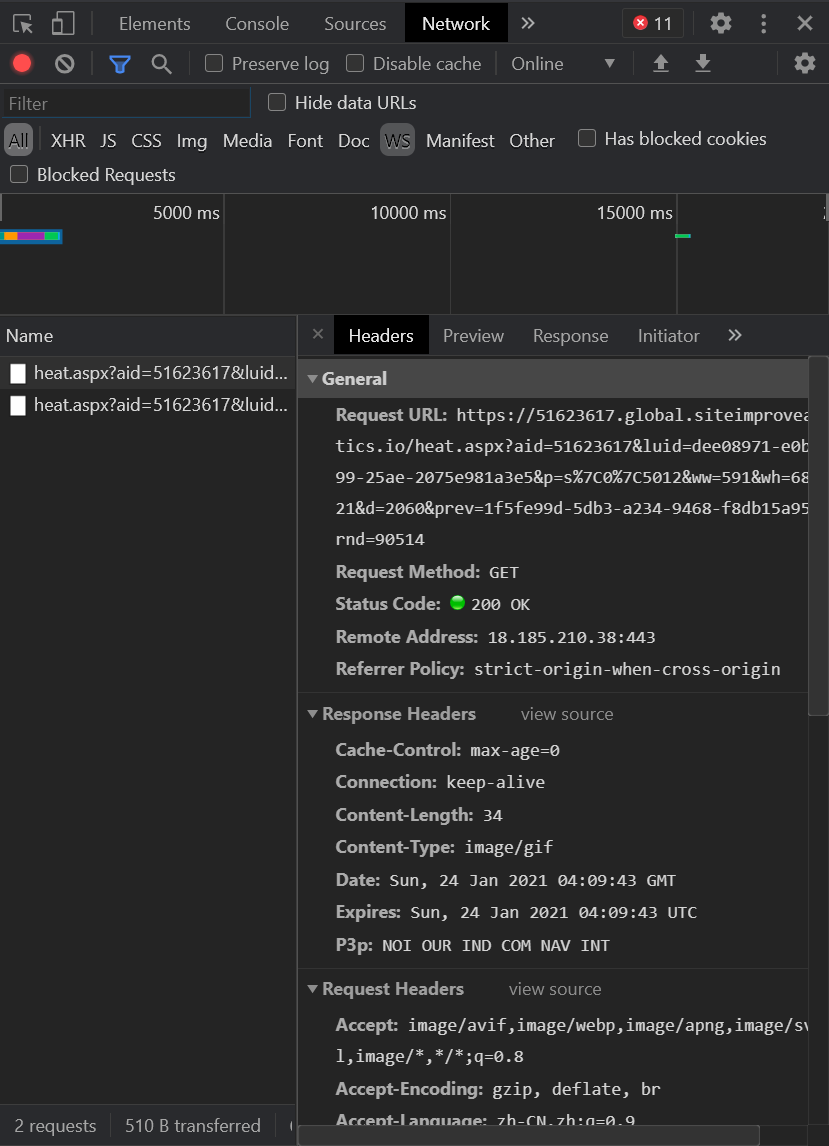

开发者界面2.png

0 → 100644

72.4 KB

爬虫.md

0 → 100644