Merge https://github.com/PaddlePaddle/PaddleOCR into dygraph

Showing

README_ch.md

100644 → 100755

doc/doc_ch/FAQ.md

100644 → 100755

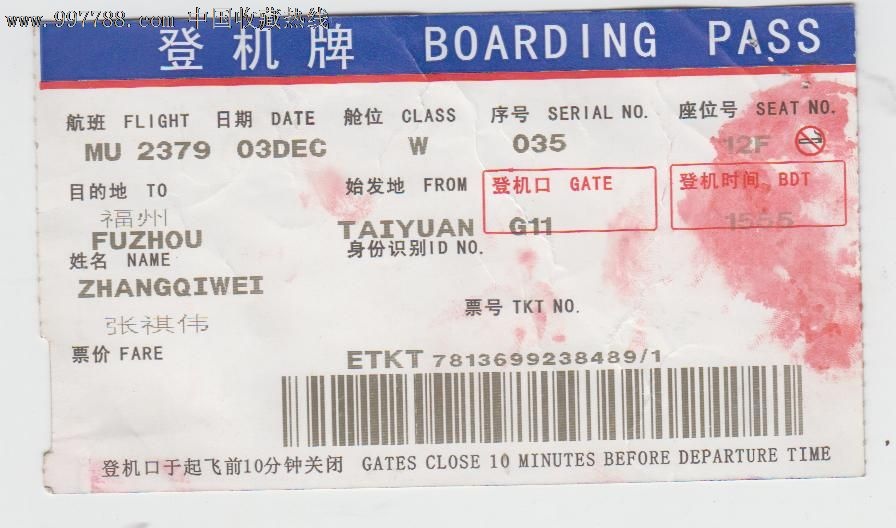

doc/imgs/00006737.jpg

0 → 100755

125.7 KB

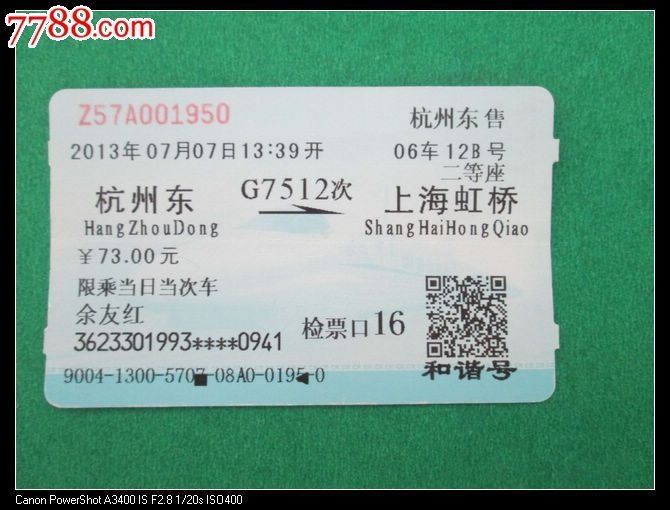

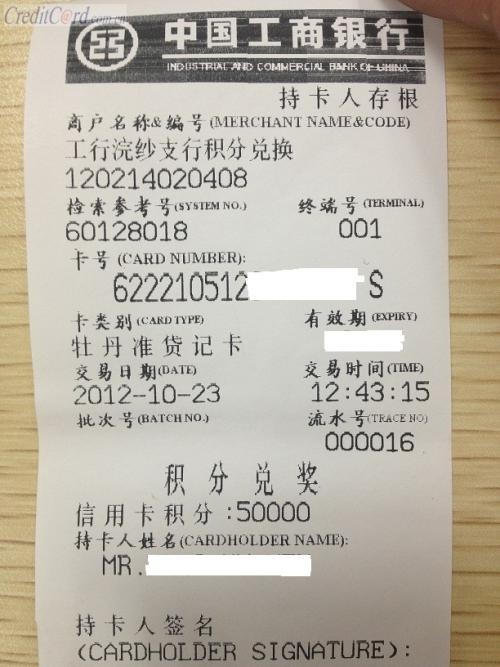

doc/imgs/00009282.jpg

0 → 100755

42.5 KB

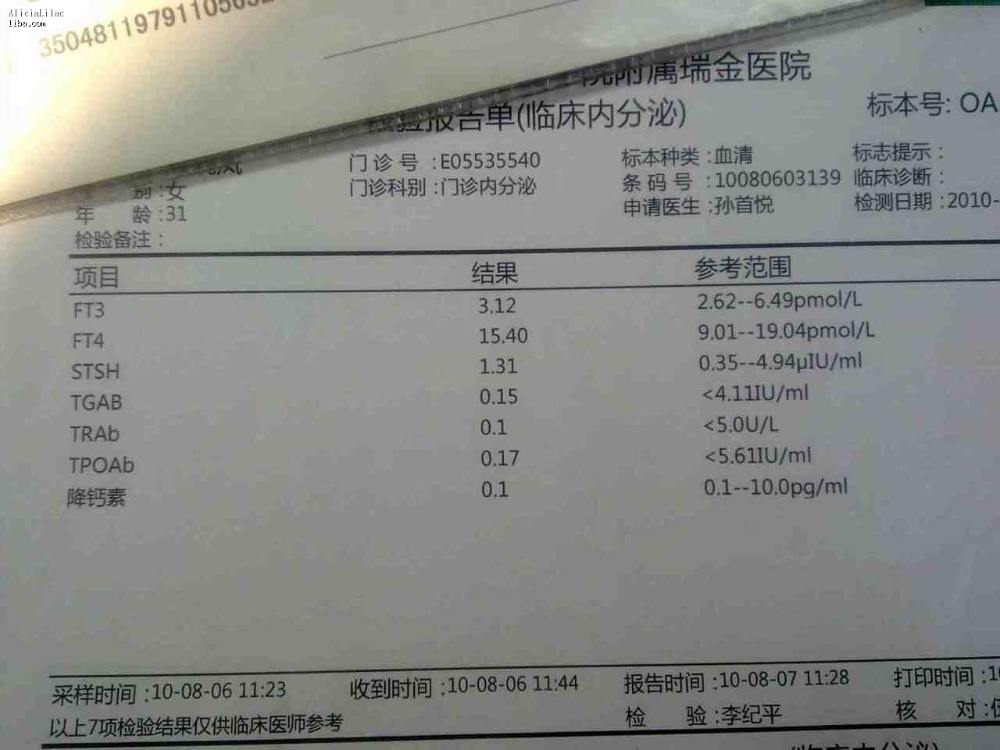

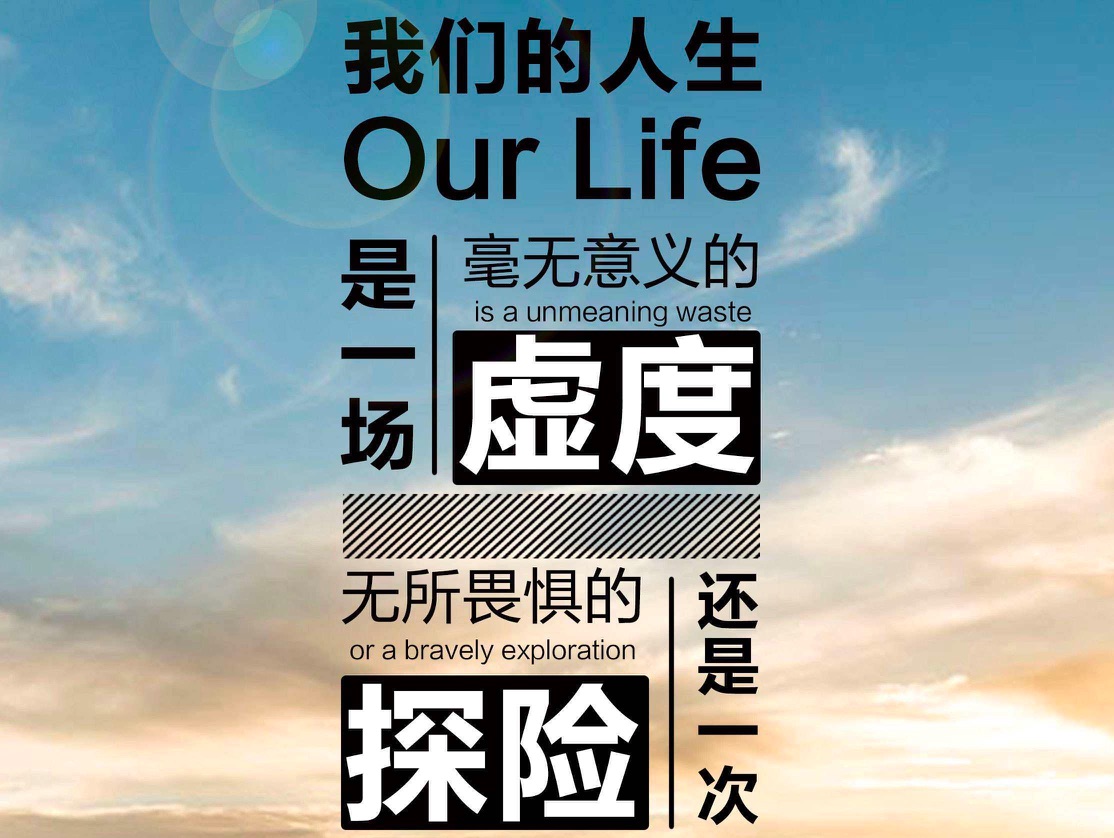

doc/imgs/00015504.jpg

0 → 100755

88.9 KB

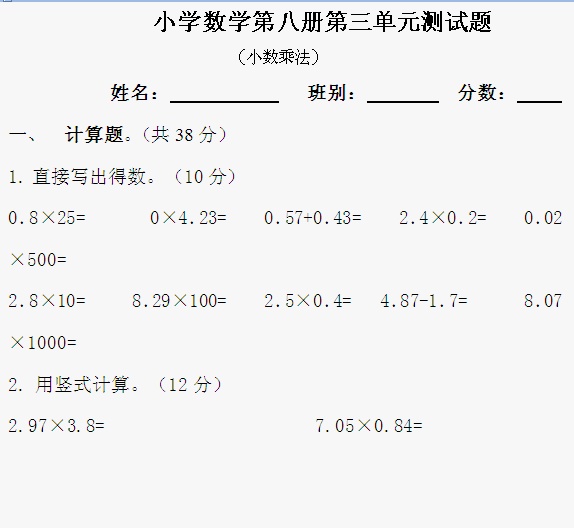

doc/imgs/00018069.jpg

0 → 100755

66.6 KB

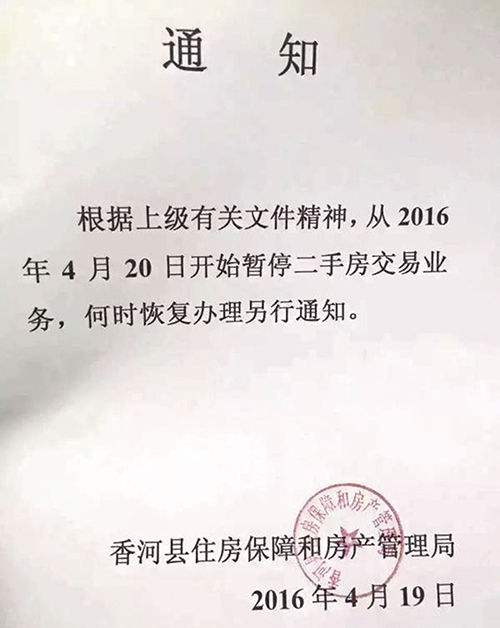

doc/imgs/00056221.jpg

0 → 100755

100.1 KB

doc/imgs/00057937.jpg

0 → 100755

149.8 KB

doc/imgs/00059985.jpg

0 → 100755

53.6 KB

doc/imgs/00077949.jpg

0 → 100755

122.4 KB

doc/imgs/00111002.jpg

0 → 100755

97.5 KB

doc/imgs/00207393.jpg

0 → 100755

49.3 KB

doc/imgs/10.jpg

已删除

100755 → 0

25.1 KB

doc/imgs/13.png

已删除

100644 → 0

1011.7 KB

doc/imgs/15.jpg

已删除

100644 → 0

197.9 KB

doc/imgs/16.png

已删除

100644 → 0

225.6 KB

doc/imgs/17.png

已删除

100644 → 0

166.8 KB

doc/imgs/2.jpg

已删除

100644 → 0

44.0 KB

doc/imgs/22.jpg

已删除

100644 → 0

46.9 KB

doc/imgs/3.jpg

已删除

100644 → 0

233.3 KB

doc/imgs/4.jpg

已删除

100755 → 0

51.3 KB

doc/imgs/5.jpg

已删除

100644 → 0

62.2 KB

doc/imgs/6.jpg

已删除

100644 → 0

80.9 KB

doc/imgs/7.jpg

已删除

100644 → 0

90.5 KB

doc/imgs/8.jpg

已删除

100755 → 0

28.2 KB

doc/imgs/9.jpg

已删除

100644 → 0

245.6 KB

doc/imgs_results/2.jpg

已删除

100644 → 0

92.2 KB

85.9 KB

77.3 KB

76.3 KB