更新了部分文档

Showing

Day66-70/code/Day68.ipynb

0 → 100644

Day66-70/code/Day69.ipynb

0 → 100644

Day66-70/code/Day70.ipynb

0 → 100644

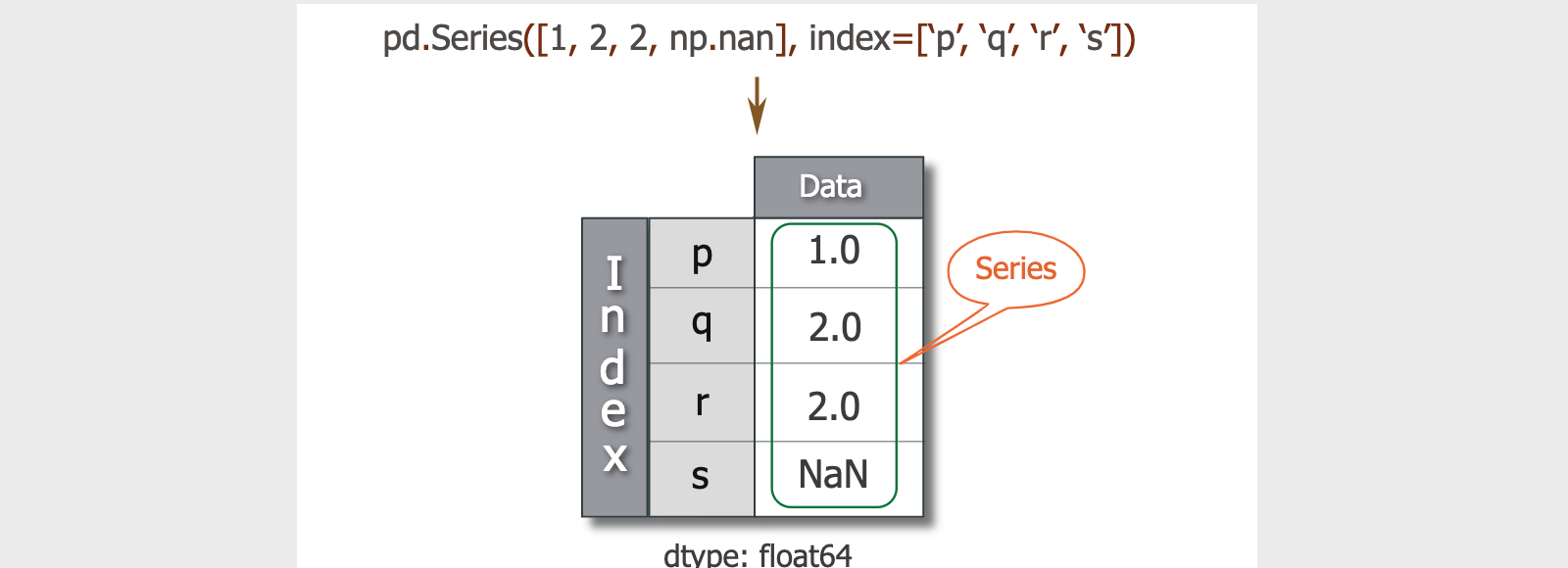

Day66-70/res/pandas-series.png

0 → 100644

80.1 KB

从无法访问的项目Fork

80.1 KB