Deploy to GitHub Pages: e4952ca6

Showing

无法预览此类型文件

此差异已折叠。

11.3 KB

doc_cn/_sources/faq/index.txt

0 → 100644

此差异已折叠。

doc_cn/faq/index.html

0 → 100644

此差异已折叠。

无法预览此类型文件

此差异已折叠。

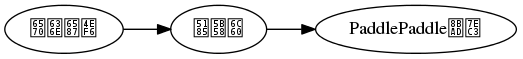

Fork自 PaddlePaddle / Paddle

11.3 KB