“ebb92b7830e269a79de9602176b37d326c78fdf7”上不存在“develop/doc/dev/write_docs_en.html”

paddleDetection yaml中的batch_size在同步和异步读取时的含义

Created by: ellinyang

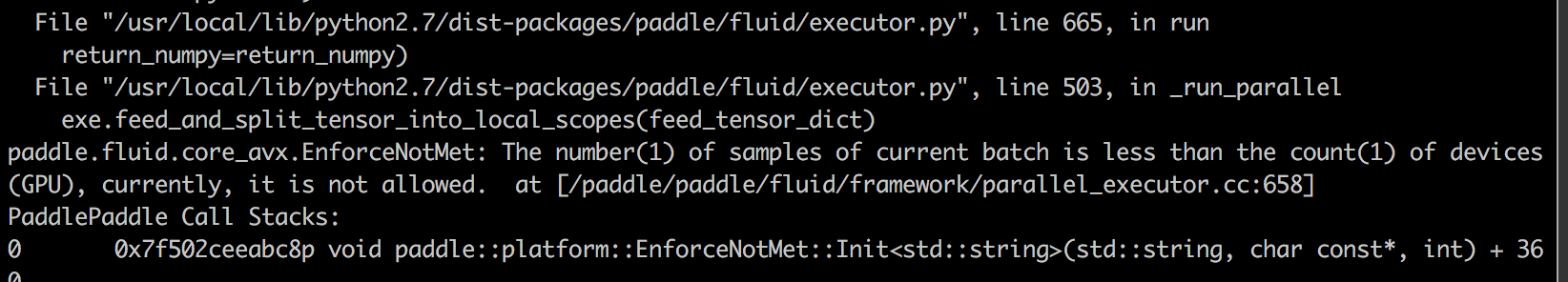

代码:paddleDeteciton 环境:v100, paddle1.5.1; GPU=2;batch_size=1

背景:将paddleDeteciton yaml文件中的batch_size设为1,两个gpu训练,原始代码训练正常;但由于业务需求,需将异步读取改为同步读取,即feed模式,训练报错;

问题:

- yml 里的 batch_size ,对于异步读取的pyreader来说是每个GPU的batch_size;

对于同步读取的feed来说是所有GPUs的总batch_size;

请问是什么原因导致这样的差别?是否有策略让两种读取方式最后输出的batch_size保持一致? 2.每个迭代 Images分配给GPUs的策略 平均分?还是优先第一个gpu?