Imagenet图像分类工程,内存一直不停增长直到占满

Created by: Yogurt2019

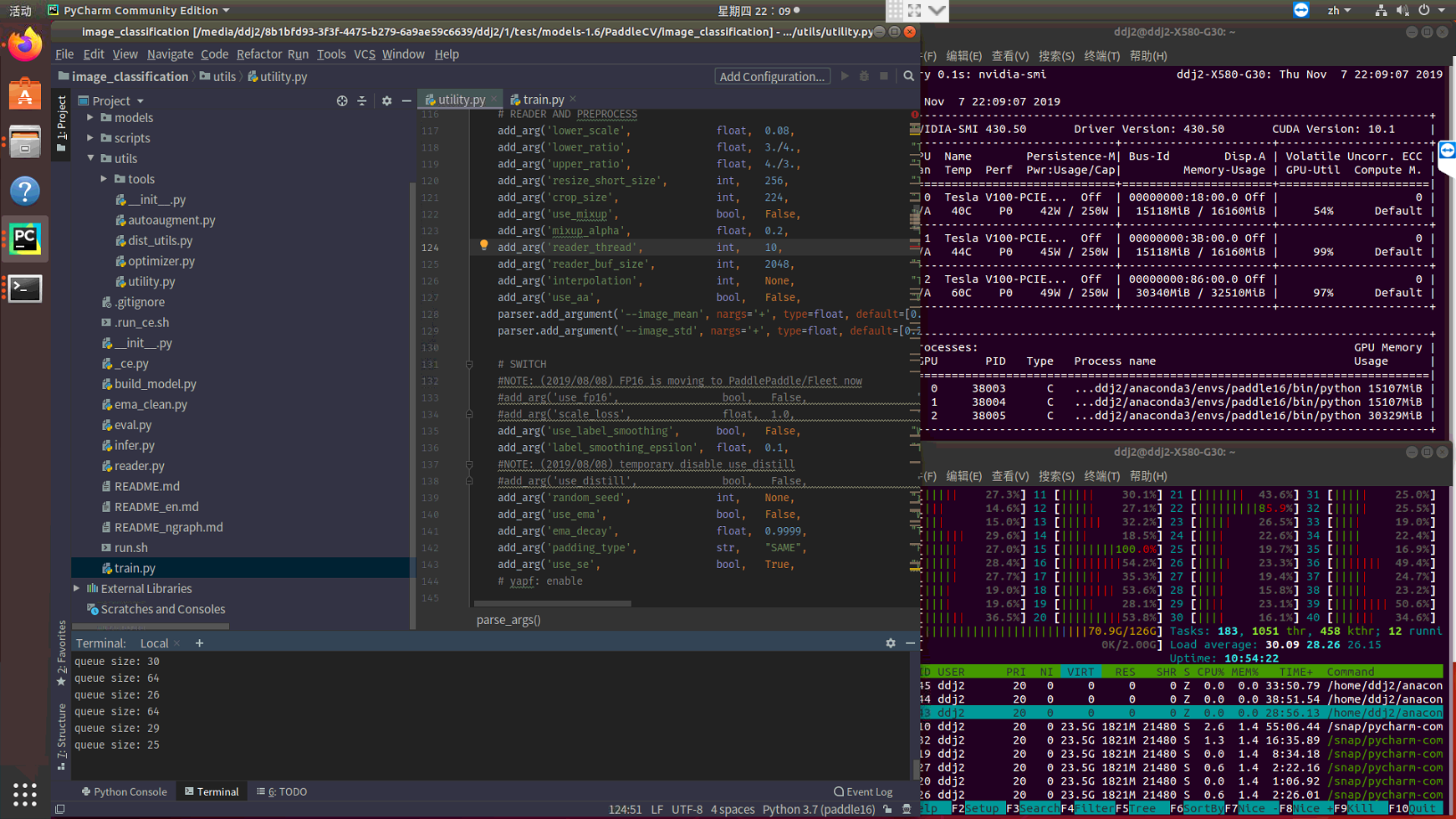

你好,我使用的是github上最新1.6版本的models工程PaddleCV中的image_classification,PaddlePaddle版本1.6,工程基本没有改动,使用我自己的数据集,在多进程训练时,内存会一直不停增长,直到内存全部占满。 我的内存大小是128G,使用的显卡是Tesla V100 另外我尝试调整过reader_thread、reader_buf_size和batch size,已经调整到足够小了,再小的话会影响性能,reader_thread为6,reader_buf_size为512,PyReader的capacity调整为4,而且我开启了FLAGS_eager_delete_tensor_gb=0,打开inplace策略等,内存还是会一直不停增长,直到128G内存全部占满。 请问这种情况如何解决?

我刚刚试了一下,使用imagenet数据集来训练,内存会一直不断的上涨,我的训练参数是:

python -m paddle.distributed.launch train.py

--model=ResNet34

--batch_size=300

--reader_thread=12

--reader_buf_size=2048

其他全部为默认值,内存依然不断上涨,内存已经占超过70G了