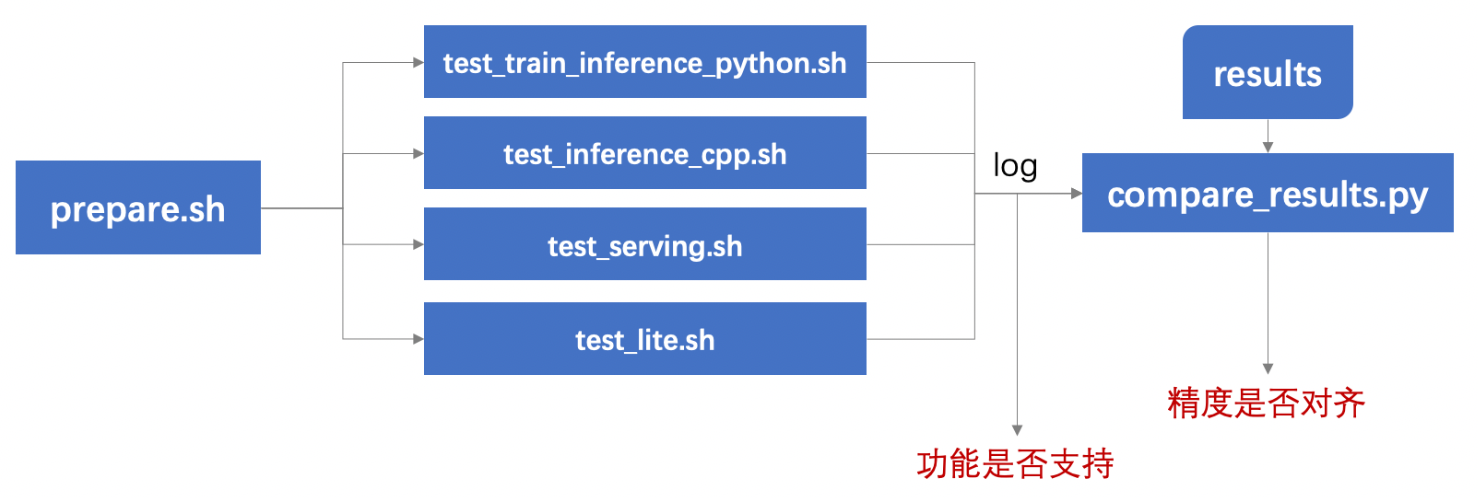

add tipc doc for cpp infer (#5371)

* add tipc doc for cpp infer * add images * fix * fix * fix

Showing

315.6 KB

41.8 KB

67.1 KB

261.7 KB

615.9 KB

46.7 KB

docs/tipc_test/测试文档/TIPC测试文档规范.md

0 → 100644

674.7 KB

72.8 KB

674.7 KB

337.8 KB

229.5 KB

975.9 KB

138.3 KB

914.0 KB

240.2 KB

543.7 KB

223.8 KB