fix inference log (#5401)

* fix inference log * add train infer python md * fix

Showing

| W: | H:

| W: | H:

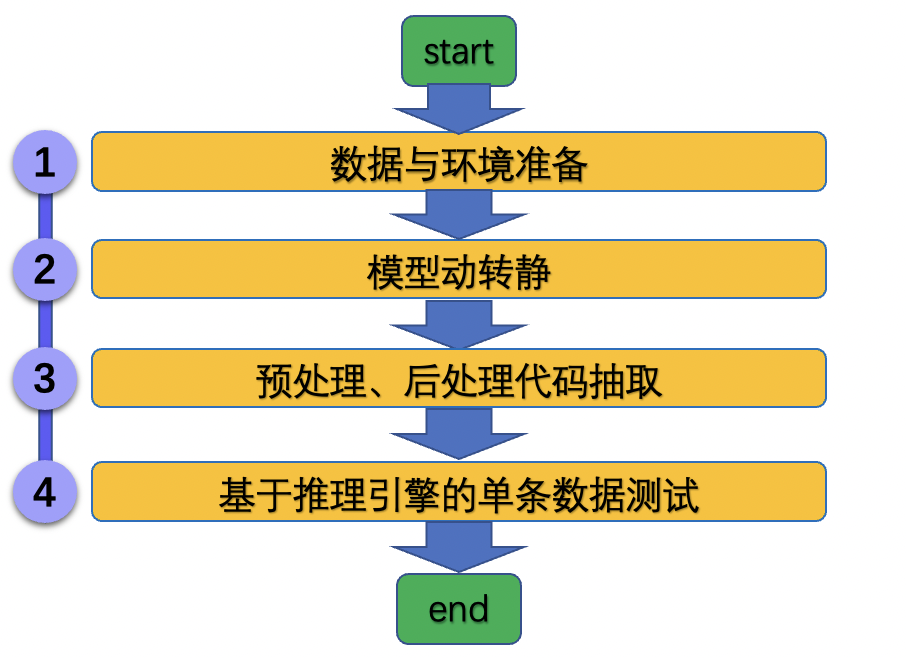

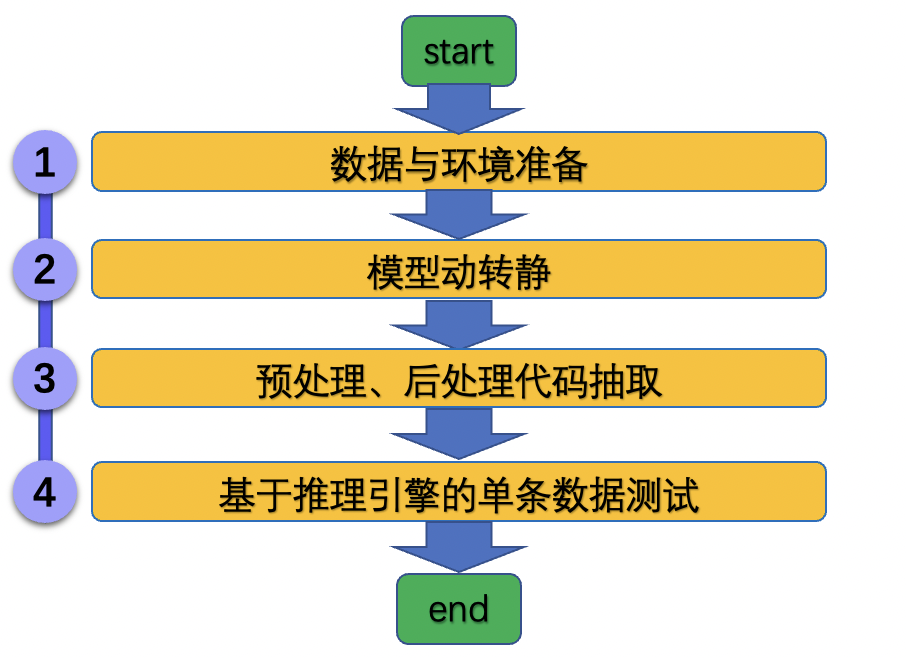

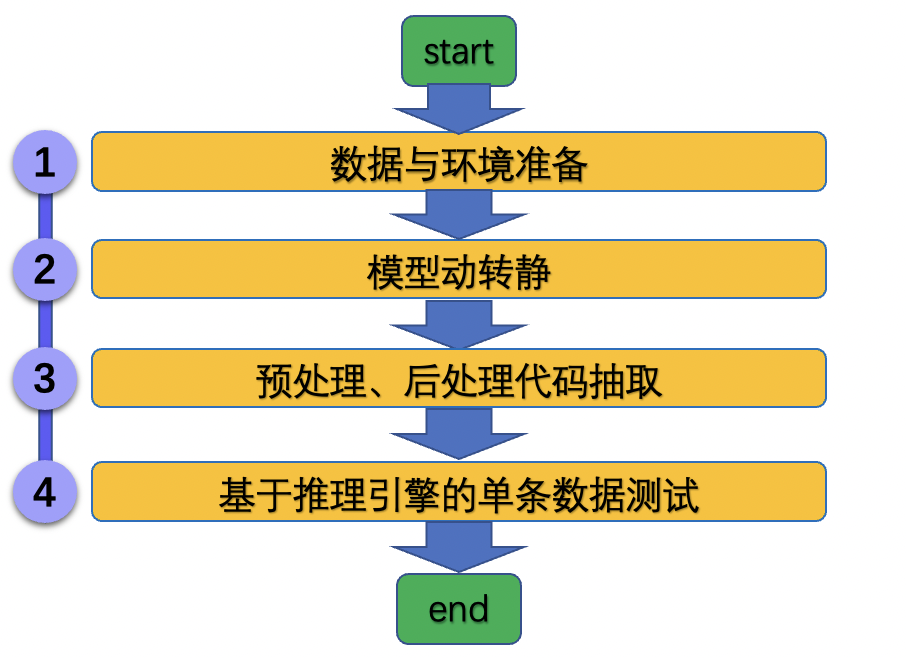

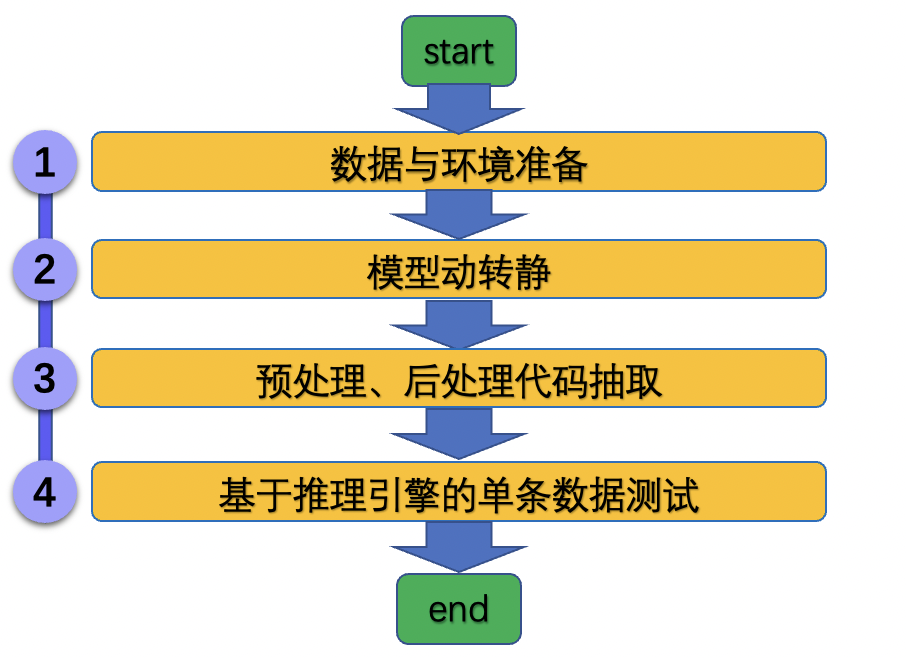

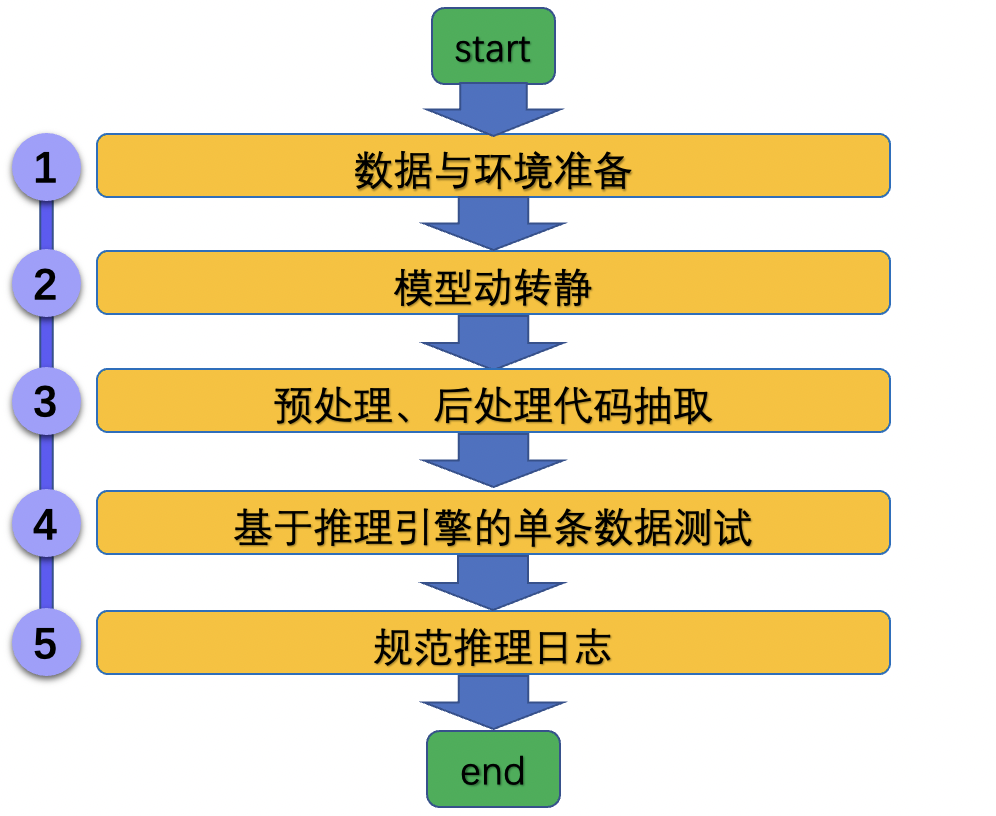

docs/tipc/train_infer_python.md

0 → 100644

* fix inference log * add train infer python md * fix

277.6 KB | W: | H:

352.4 KB | W: | H: