Merge pull request #59 from PaddlePaddle/develop_doc

Develop doc

Showing

docs/FAQ.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/Makefile

100644 → 100755

文件模式从 100644 更改为 100755

docs/README.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/_templates/layout.html

0 → 100644

docs/apis/datasets.md

已删除

100644 → 0

docs/apis/datasets/detection.md

0 → 100755

docs/apis/datasets/index.rst

0 → 100755

docs/apis/deploy.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/apis/images/insect_bbox_pr_curve(iou-0.5).png

100644 → 100755

文件模式从 100644 更改为 100755

docs/apis/index.rst

100644 → 100755

docs/apis/load_model.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/apis/models.md

已删除

100644 → 0

此差异已折叠。

docs/apis/models/detection.md

0 → 100755

docs/apis/models/index.rst

0 → 100755

docs/apis/slim.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/apis/transforms/cls_transforms.md

100644 → 100755

docs/apis/transforms/det_transforms.md

100644 → 100755

docs/apis/transforms/index.rst

100644 → 100755

文件模式从 100644 更改为 100755

docs/apis/transforms/seg_transforms.md

100644 → 100755

docs/apis/visualize.md

100644 → 100755

文件模式从 100644 更改为 100755

文件已移动

文件已移动

docs/appendix/index.rst

0 → 100755

docs/metrics.md

→

docs/appendix/metrics.md

100644 → 100755

docs/client_use.md

已删除

100644 → 0

docs/conf.py

100644 → 100755

文件模式从 100644 更改为 100755

docs/convertor.md

已删除

100644 → 0

docs/cv_solutions.md

0 → 100755

210 字节

docs/images/00_loaddata.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/01_datasplit.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/02_newproject.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/03_choosedata.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/04_parameter.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/05_train.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/06_VisualDL.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/07_evaluate.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/08_deploy.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/PaddleX-Pipe-Line.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/QQGroup.jpeg

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/anaconda_windows.png

100644 → 100755

文件模式从 100644 更改为 100755

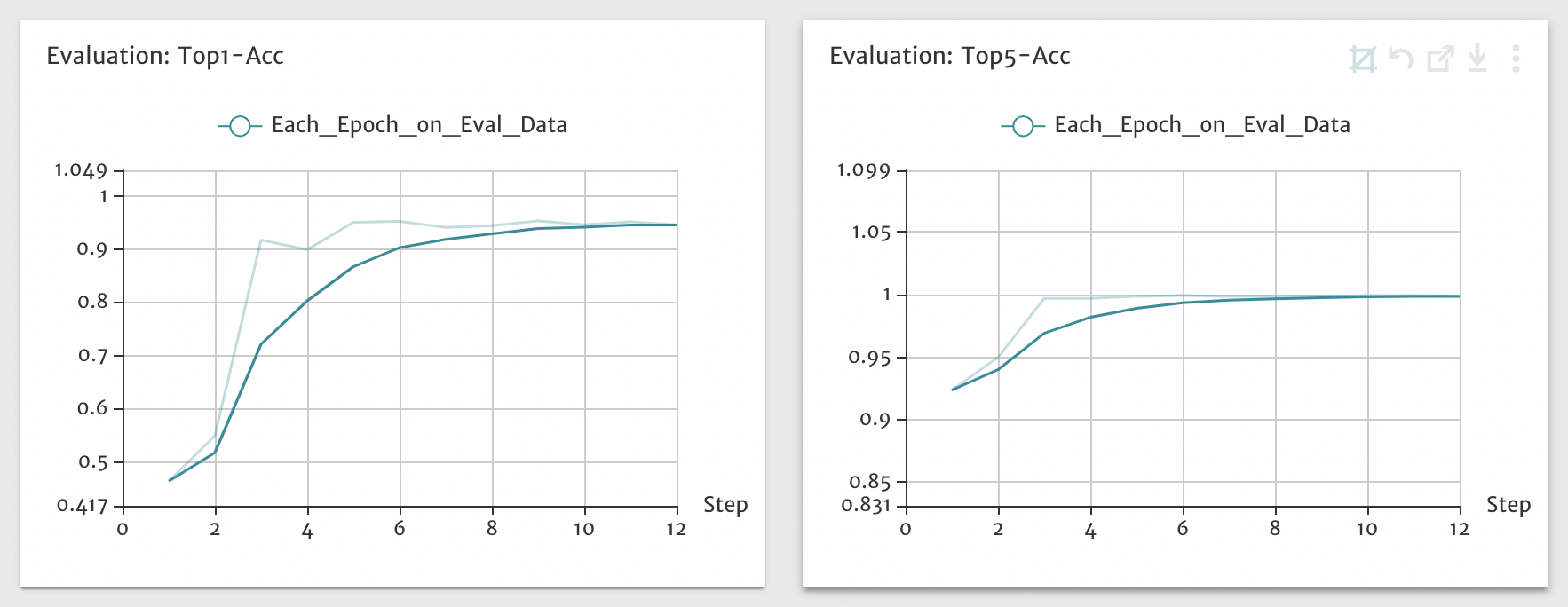

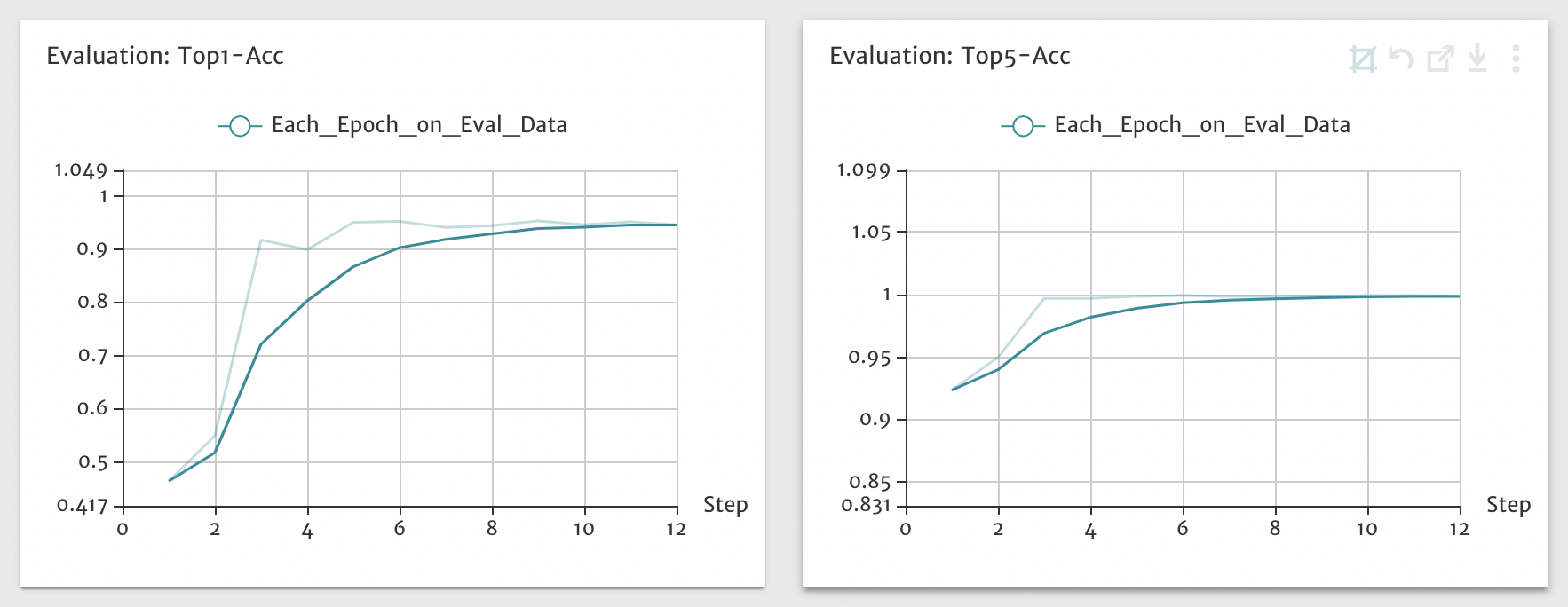

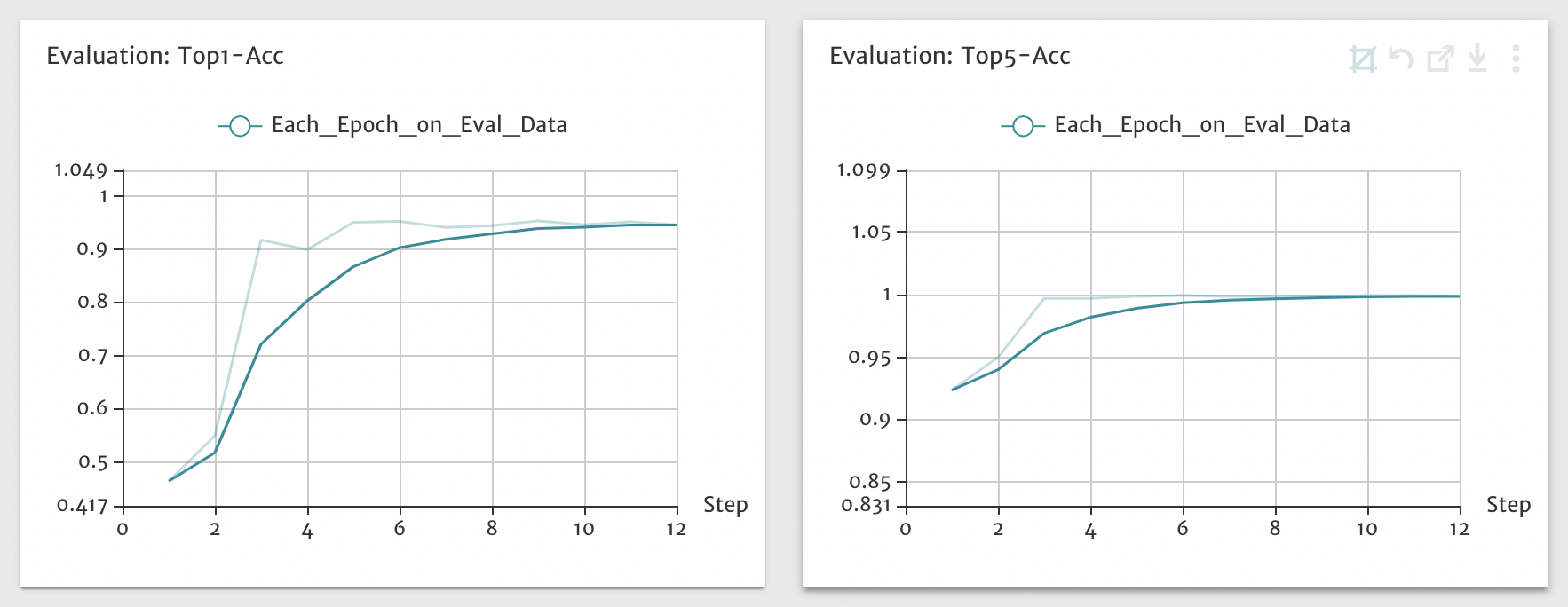

docs/images/cls_eval.png

100644 → 100755

文件模式从 100644 更改为 100755

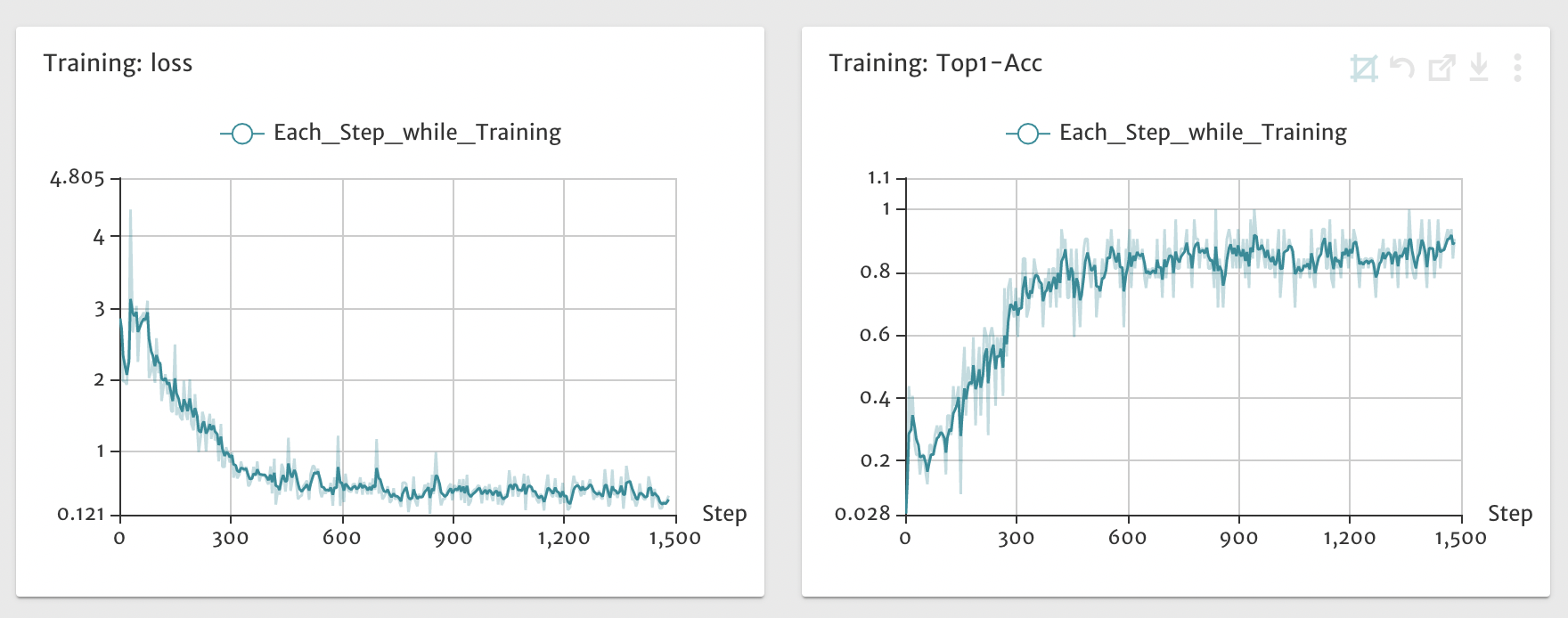

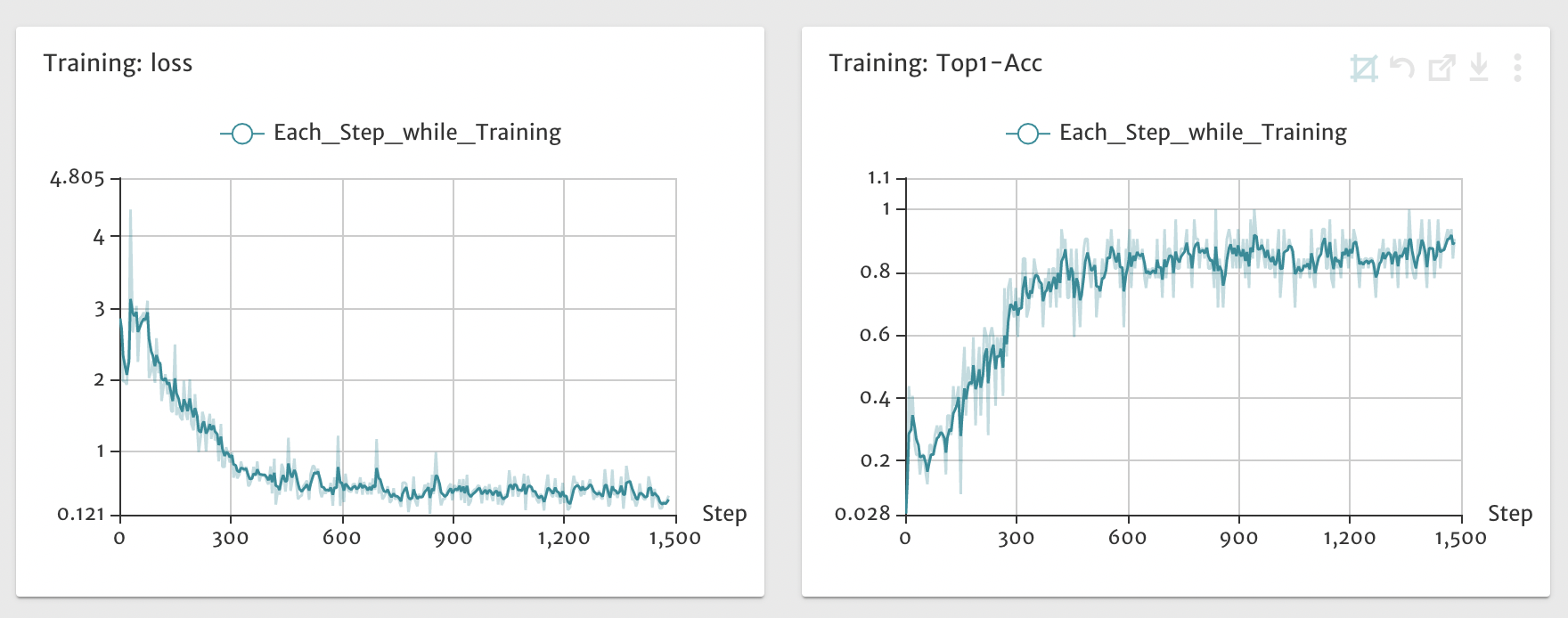

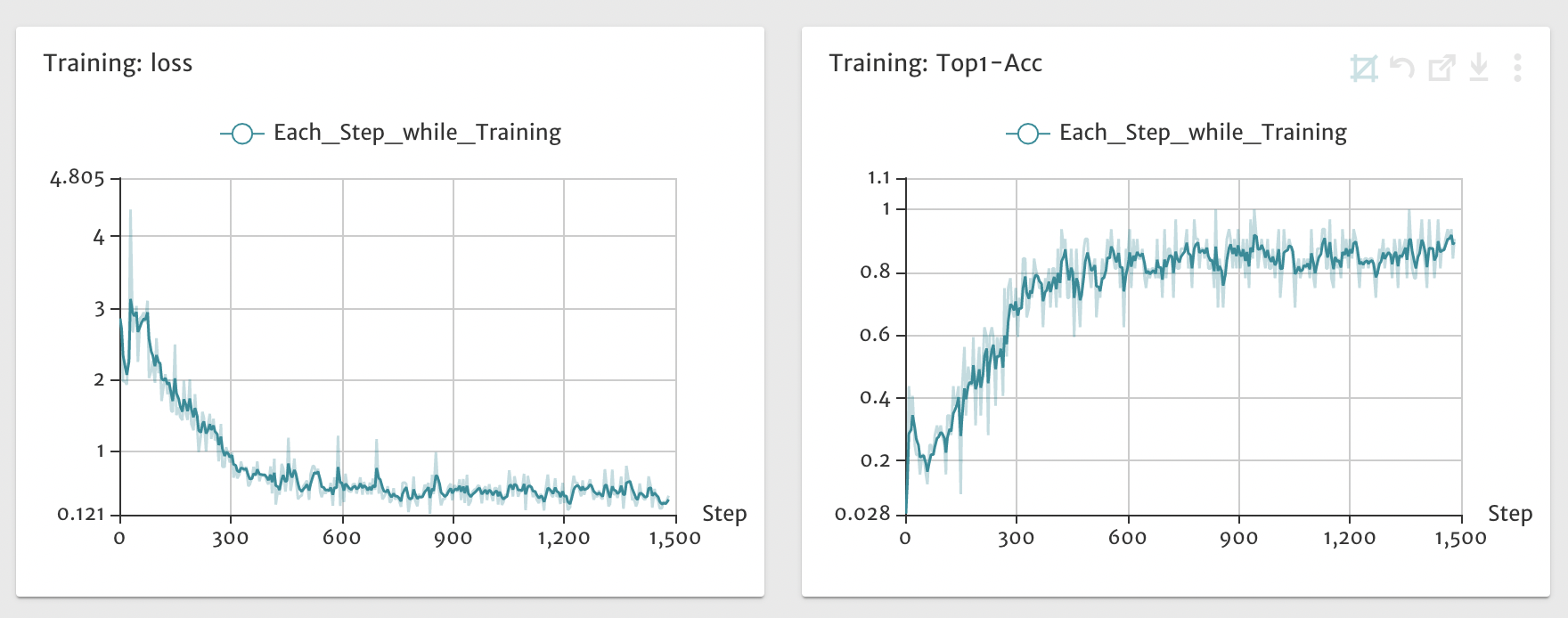

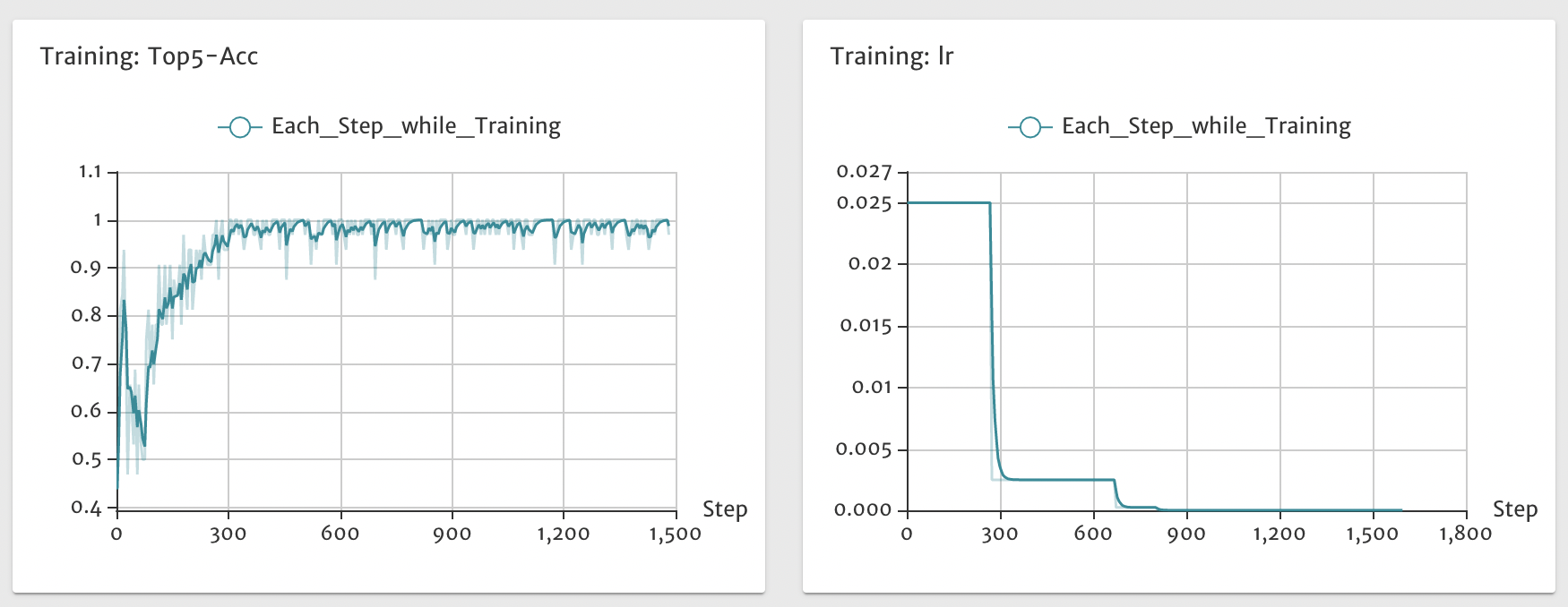

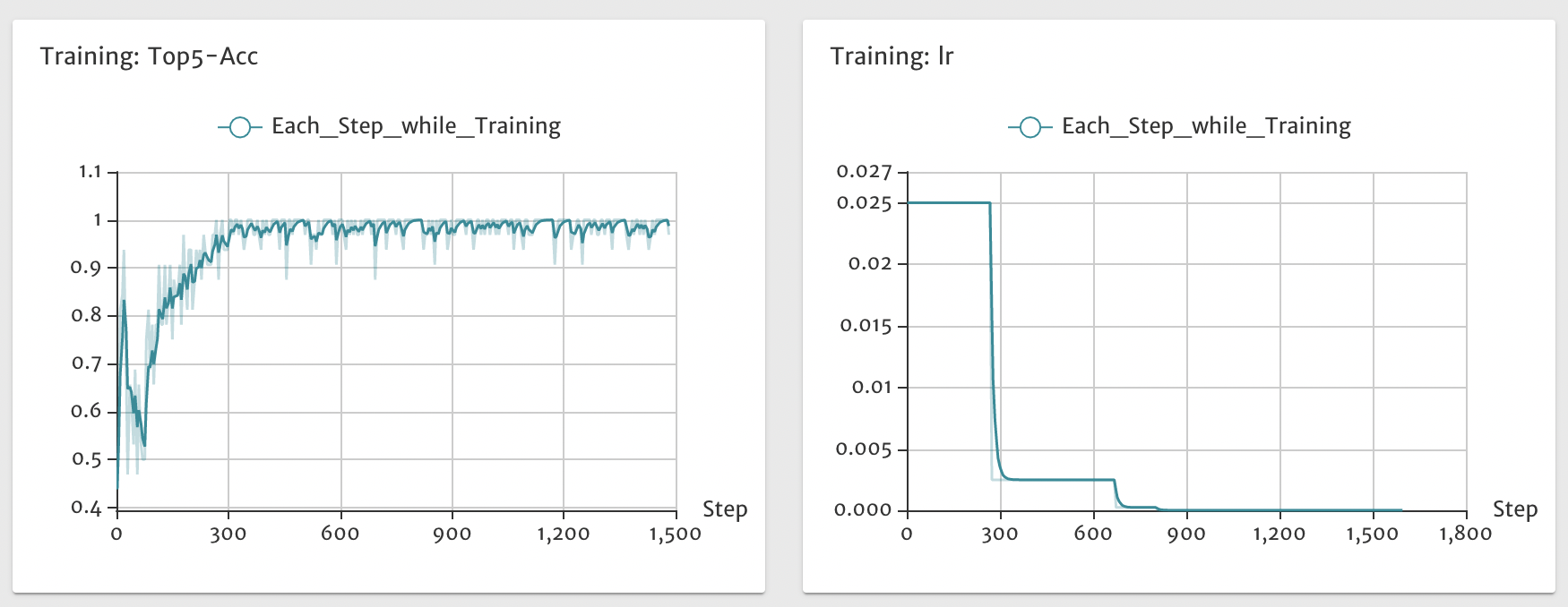

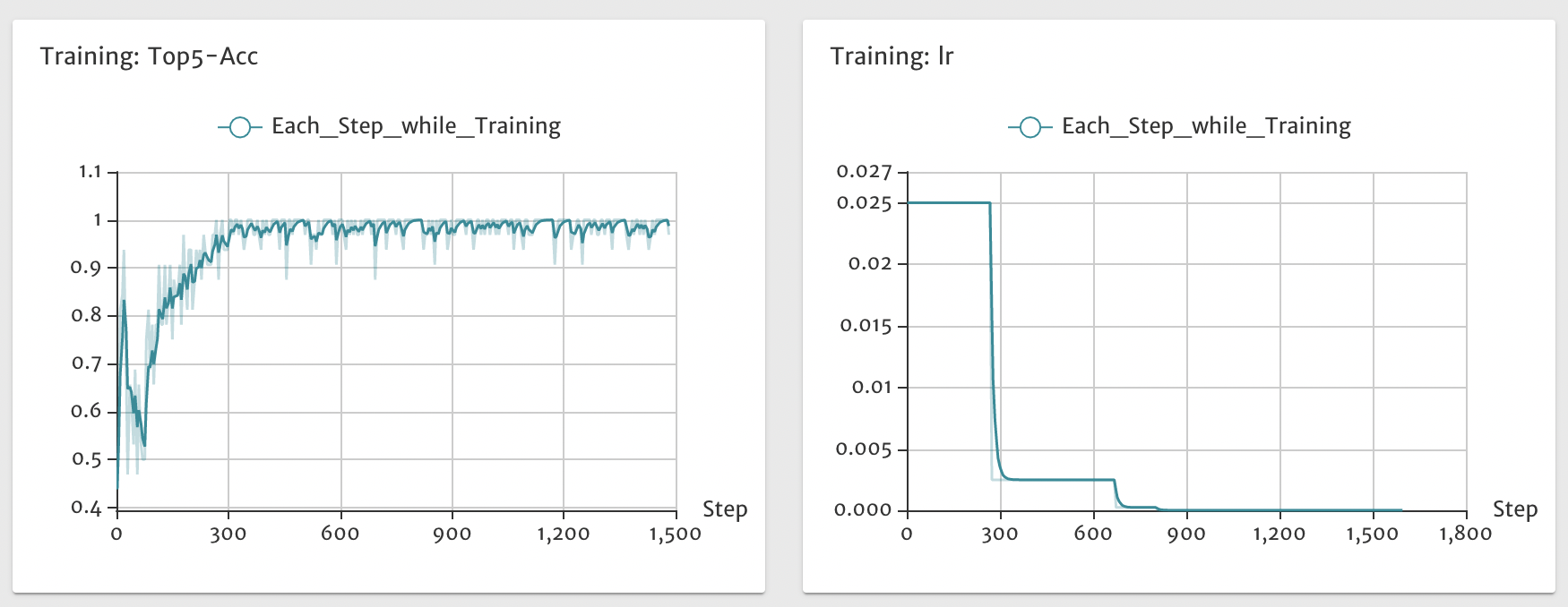

docs/images/cls_train.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/faster_eval.png

100644 → 100755

文件模式从 100644 更改为 100755

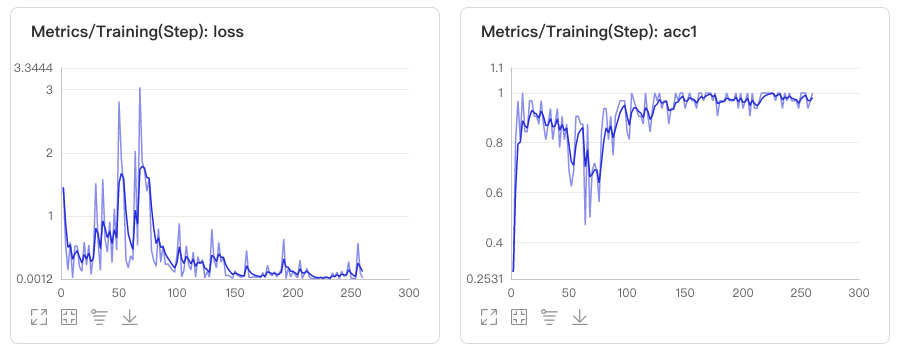

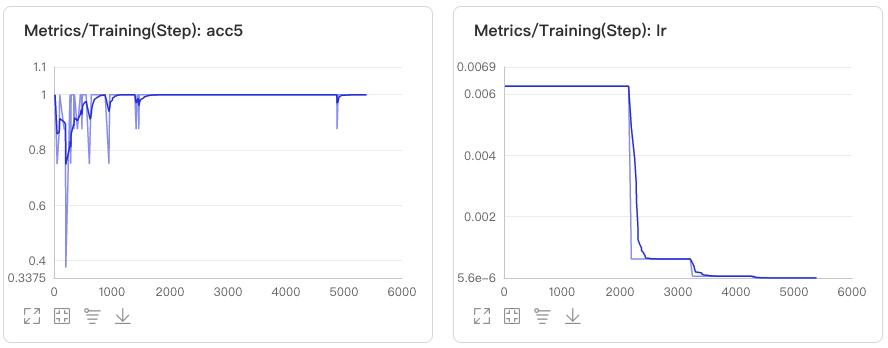

docs/images/faster_train.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/garbage.bmp

100644 → 100755

文件模式从 100644 更改为 100755

176.2 KB

213.8 KB

docs/images/mask_eval.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/mask_train.png

100644 → 100755

文件模式从 100644 更改为 100755

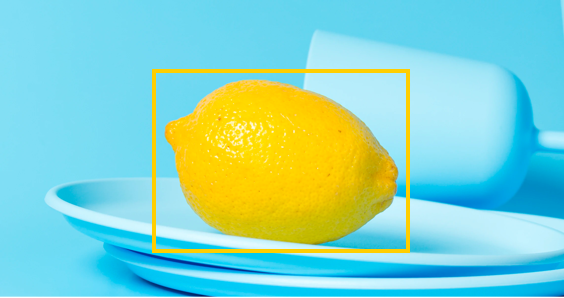

docs/images/object_detection.png

0 → 100644

214.7 KB

docs/images/paddlex.jpg

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/paddlex.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/seg_eval.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/seg_train.png

100644 → 100755

文件模式从 100644 更改为 100755

212.3 KB

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

docs/images/visualized_deeplab.jpg

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/visualized_fasterrcnn.jpg

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/visualized_maskrcnn.jpeg

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/voc_eval.png

100644 → 100755

文件模式从 100644 更改为 100755

docs/images/yolo_train.png

100644 → 100755

文件模式从 100644 更改为 100755

43.5 KB

docs/index.rst

100644 → 100755

docs/install.md

100644 → 100755

docs/make.bat

100644 → 100755

文件模式从 100644 更改为 100755

docs/paddlex_gui/download.md

0 → 100644

docs/paddlex_gui/how_to_use.md

0 → 100644

docs/paddlex_gui/index.rst

0 → 100755

docs/paddlex_gui/xx.md

0 → 100644

docs/quick_start.md

100644 → 100755

docs/requirements.txt

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/README.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/compress/classification.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/compress/detection.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/compress/index.rst

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/compress/segmentation.md

100644 → 100755

文件模式从 100644 更改为 100755

文件已移动

文件已移动

文件已移动

docs/tutorials/dataset_prepare.md

0 → 100644

docs/datasets.md

→

docs/tutorials/datasets.md

100644 → 100755

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

docs/tutorials/deploy/index.rst

0 → 100644

此差异已折叠。

docs/tutorials/index.rst

100644 → 100755

此差异已折叠。

docs/tutorials/train/classification.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/train/detection.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/train/index.rst

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/train/instance_segmentation.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/train/segmentation.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/tutorials/train/visualdl.md

100644 → 100755

文件模式从 100644 更改为 100755

docs/update.md

0 → 100644

此差异已折叠。

docs/xx

0 → 100644

此差异已折叠。

%20BDSZYF000132754-docs%20jiangjiajun$%20pwd%20:Users:jiangjiajun:Downloads:PaddleX-develop:docs:vdl1.png)

%20BDSZYF000132754-docs%20jiangjiajun$%20pwd%20:Users:jiangjiajun:Downloads:PaddleX-develop:docs:vdl1.png)