turnoff ir_optim on arm platform

Showing

docs/deploy/hub_serving.md

0 → 100644

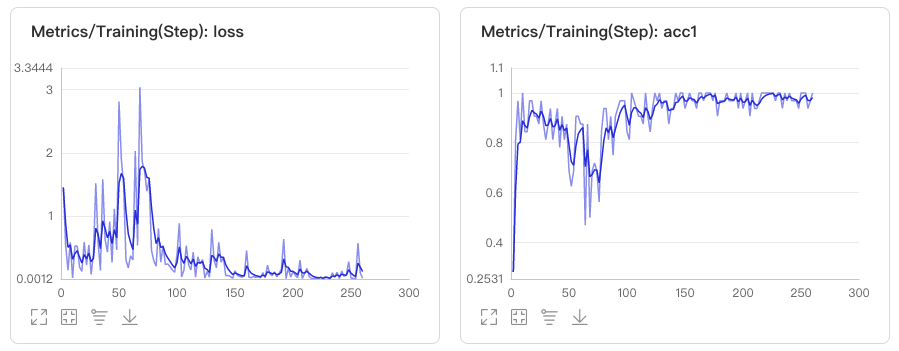

docs/images/vdl1.jpg

0 → 100644

47.0 KB

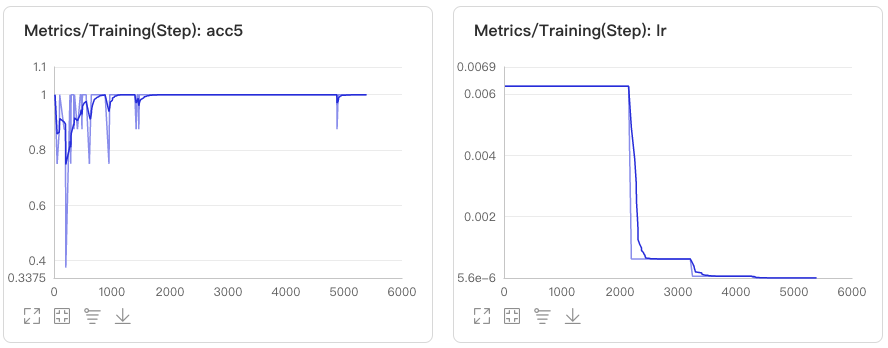

docs/images/vdl2.jpg

0 → 100644

28.2 KB

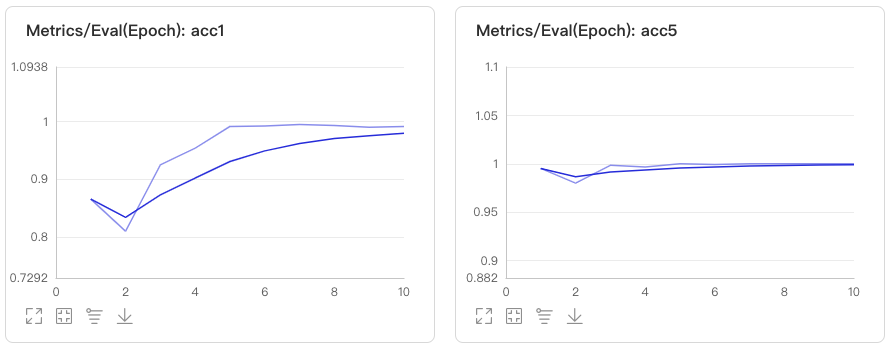

docs/images/vdl3.jpg

0 → 100644

29.8 KB

docs/images/xiaoduxiong.jpeg

0 → 100644

175.2 KB

docs/train/visualdl.md

0 → 100755