fix exit unnormally when shapely cannot be imported, fix doc error for meter...

fix exit unnormally when shapely cannot be imported, fix doc error for meter reader, add vdltrain in docs, add mkl_thread_num

Showing

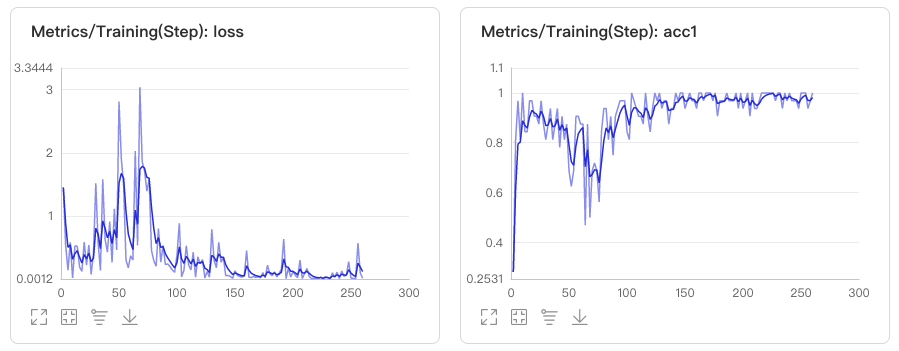

docs/images/vdl1.jpg

0 → 100644

47.0 KB

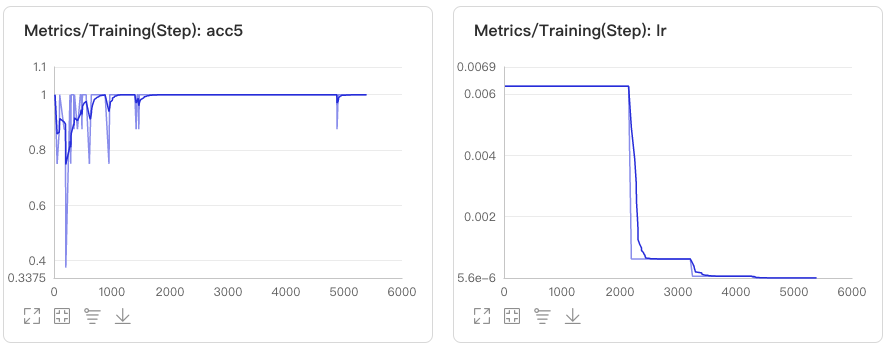

docs/images/vdl2.jpg

0 → 100644

28.2 KB

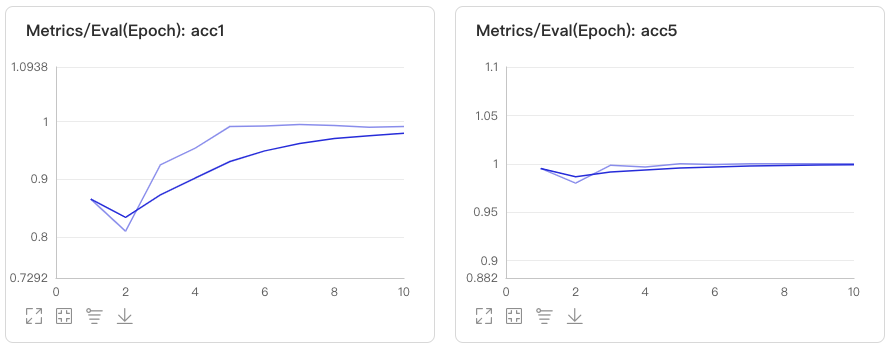

docs/images/vdl3.jpg

0 → 100644

29.8 KB

docs/images/xiaoduxiong.jpeg

0 → 100644

175.2 KB

docs/train/visualdl.md

0 → 100755