update docs

Showing

docs/apis/datasets/index.rst

已删除

100755 → 0

docs/appendix/datasets.md

已删除

100644 → 0

74.6 KB

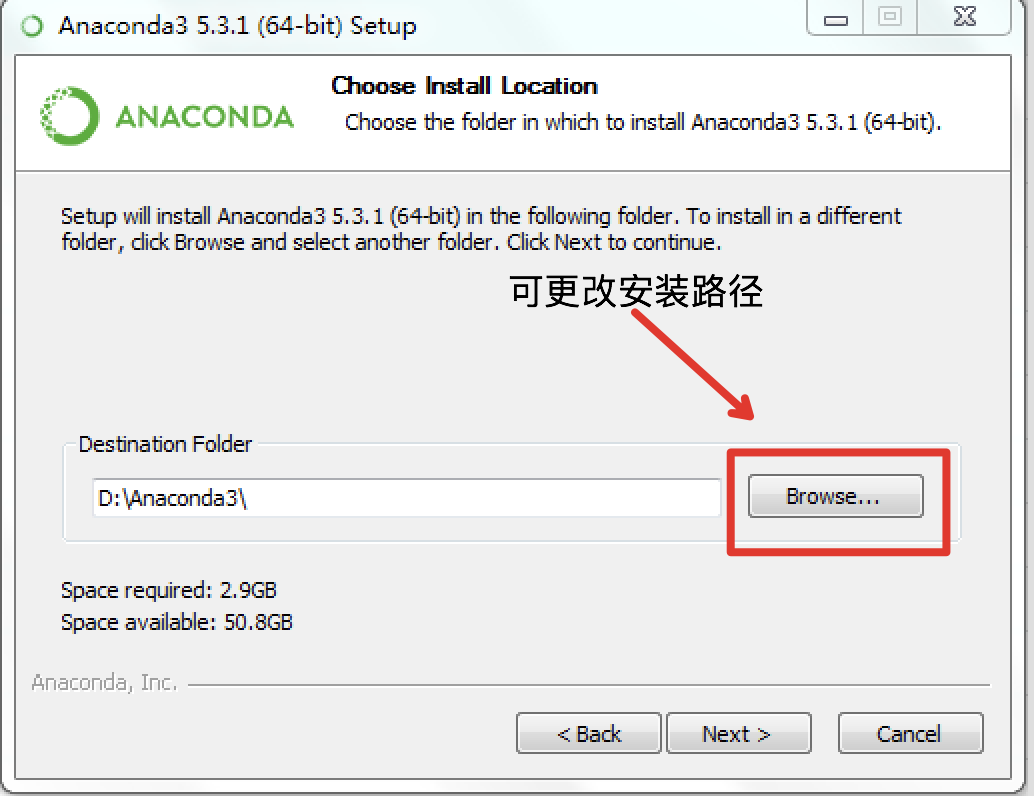

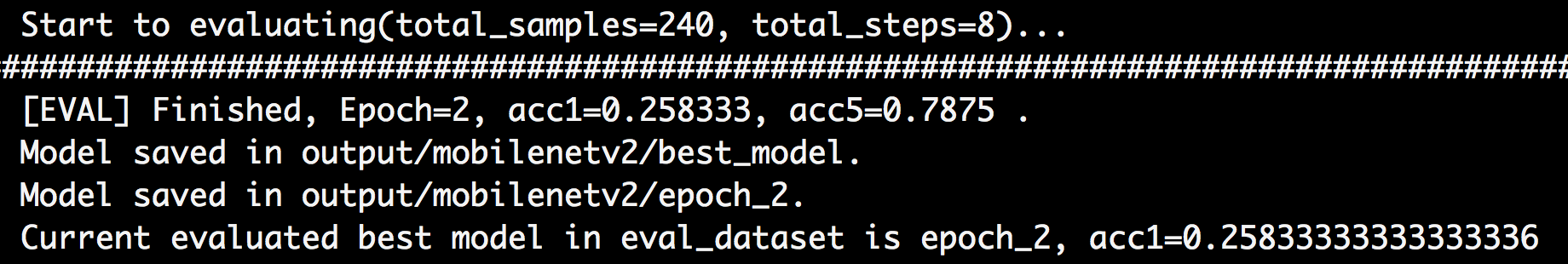

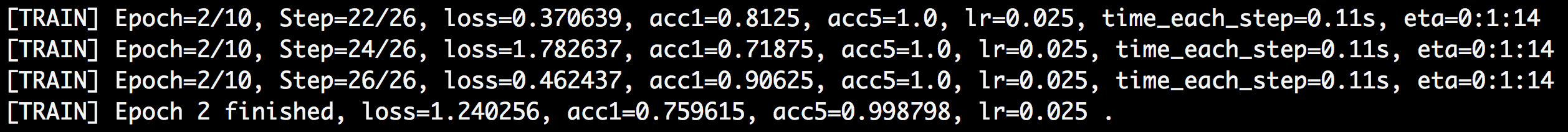

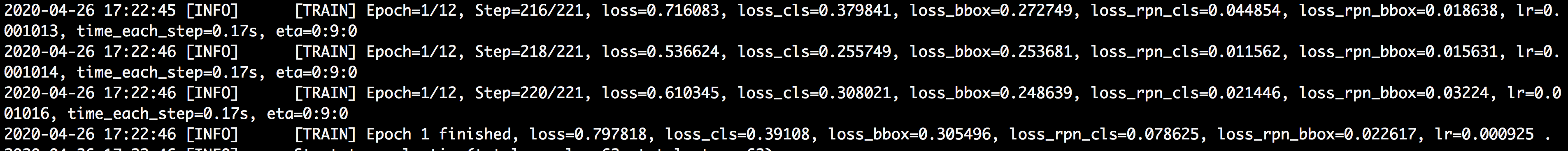

docs/appendix/images/cls_eval.png

0 → 100755

80.4 KB

94.6 KB

263.2 KB

165.5 KB

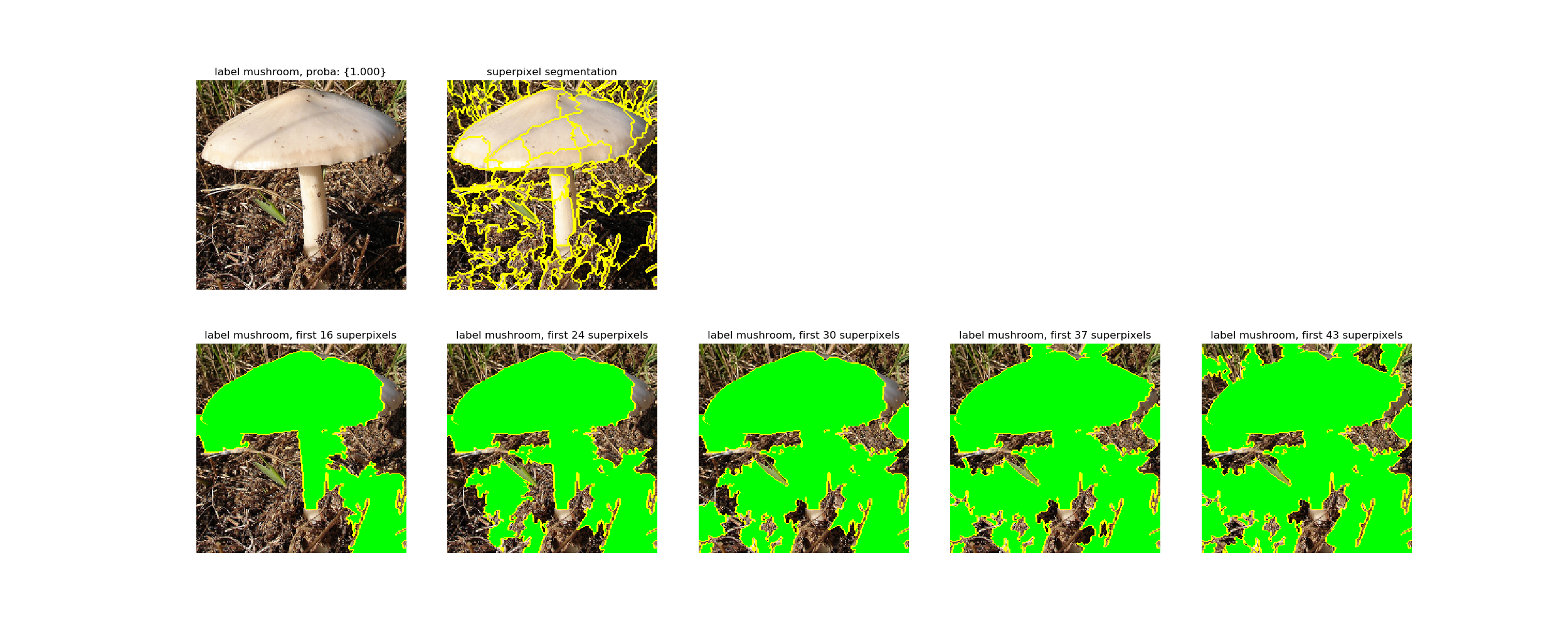

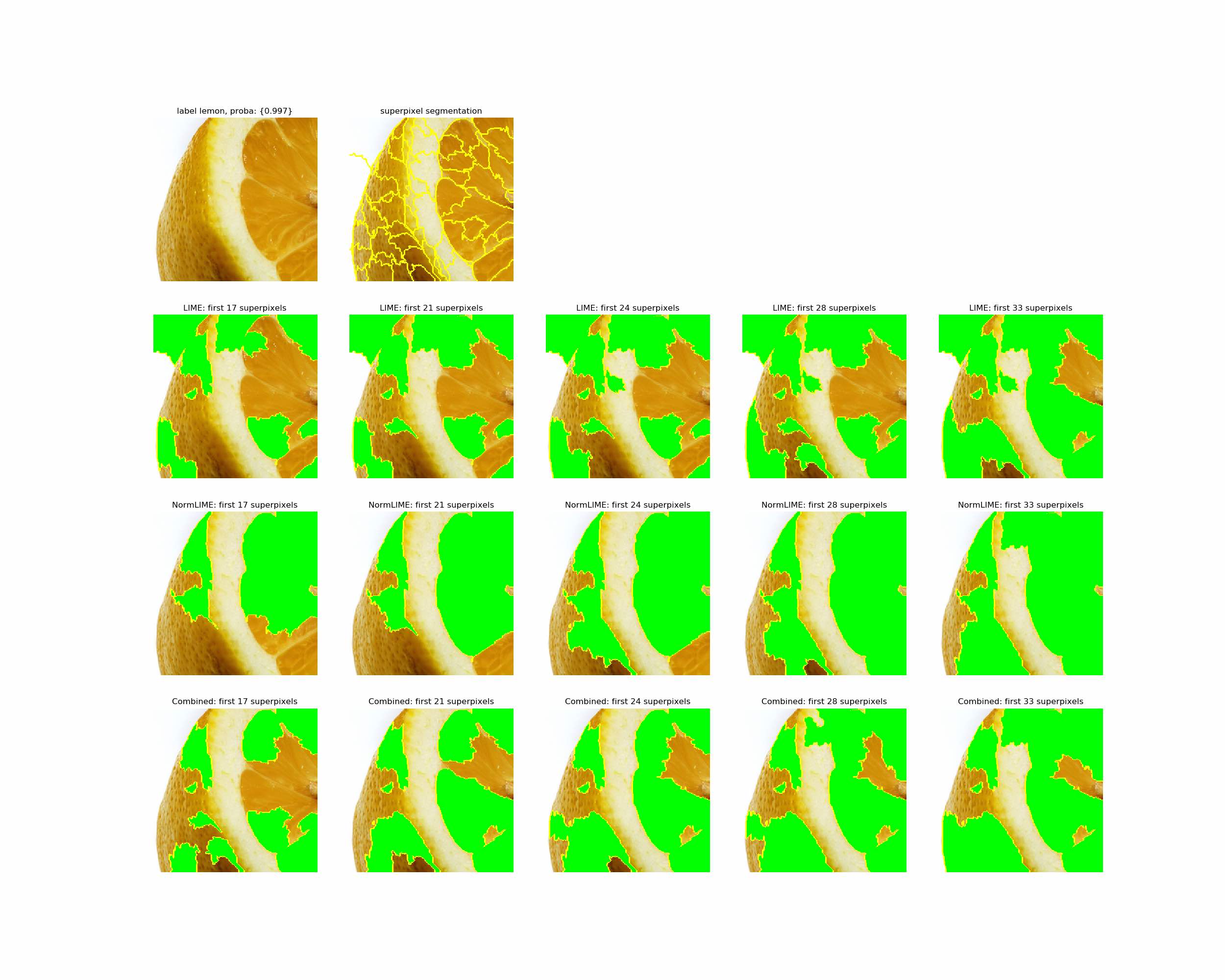

docs/appendix/images/lime.png

0 → 100644

423.0 KB

288.0 KB

197.1 KB

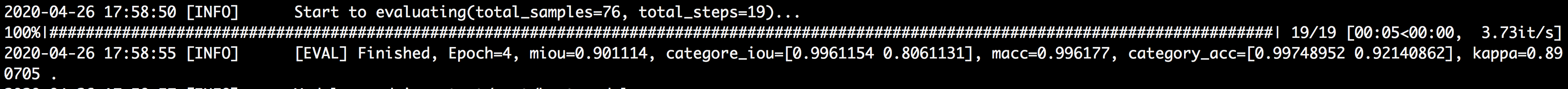

docs/appendix/images/normlime.png

0 → 100644

277.0 KB

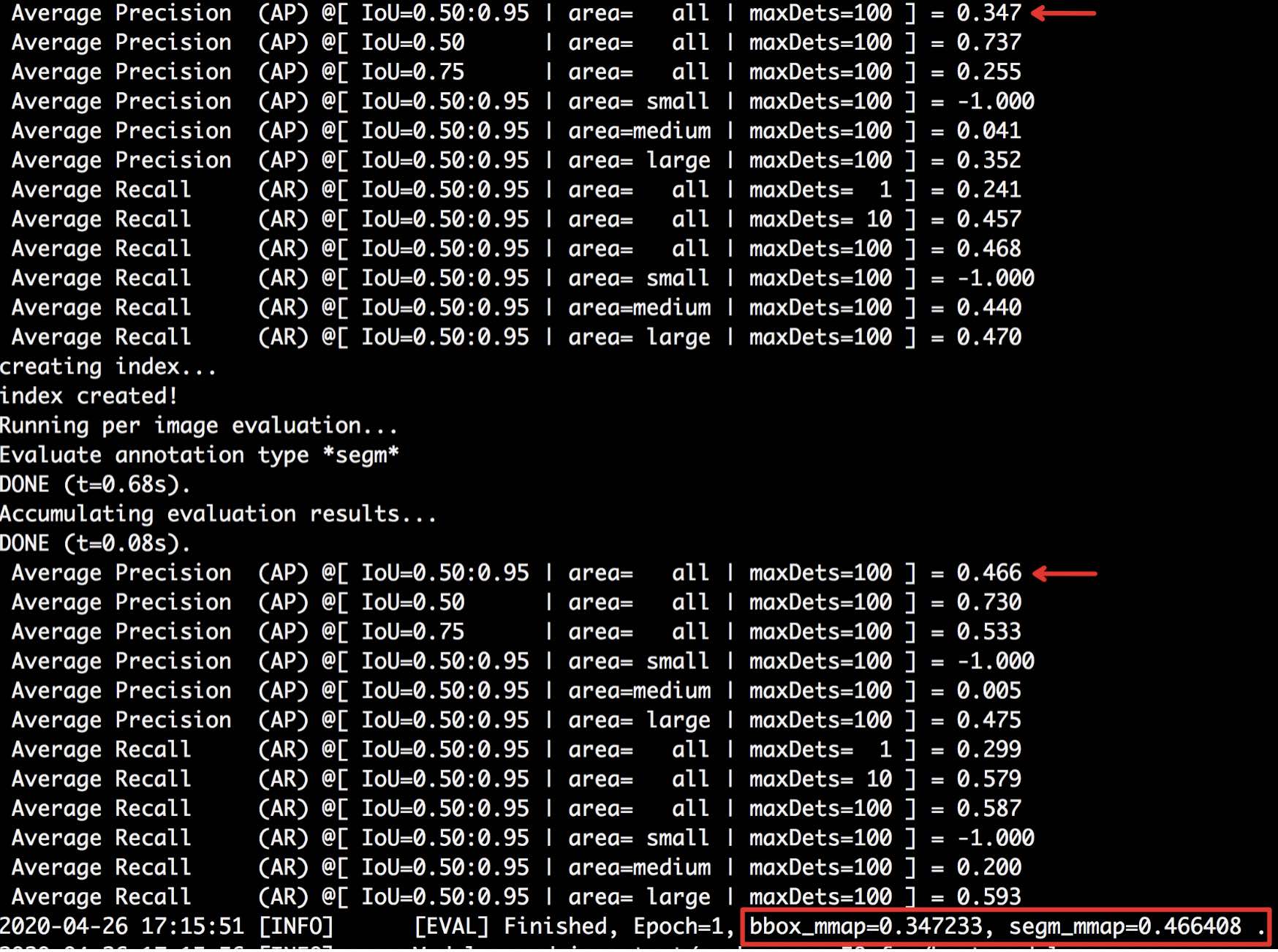

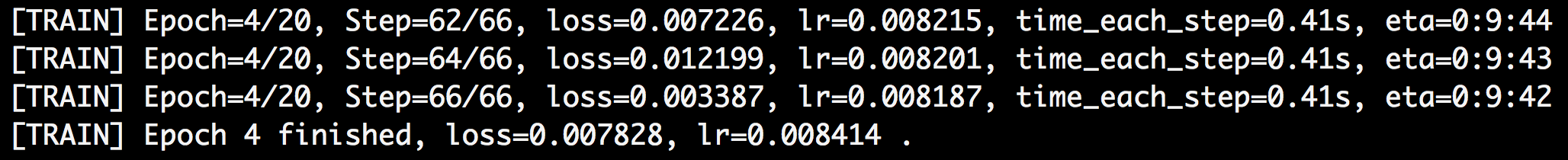

docs/appendix/images/seg_eval.png

0 → 100755

84.1 KB

85.5 KB

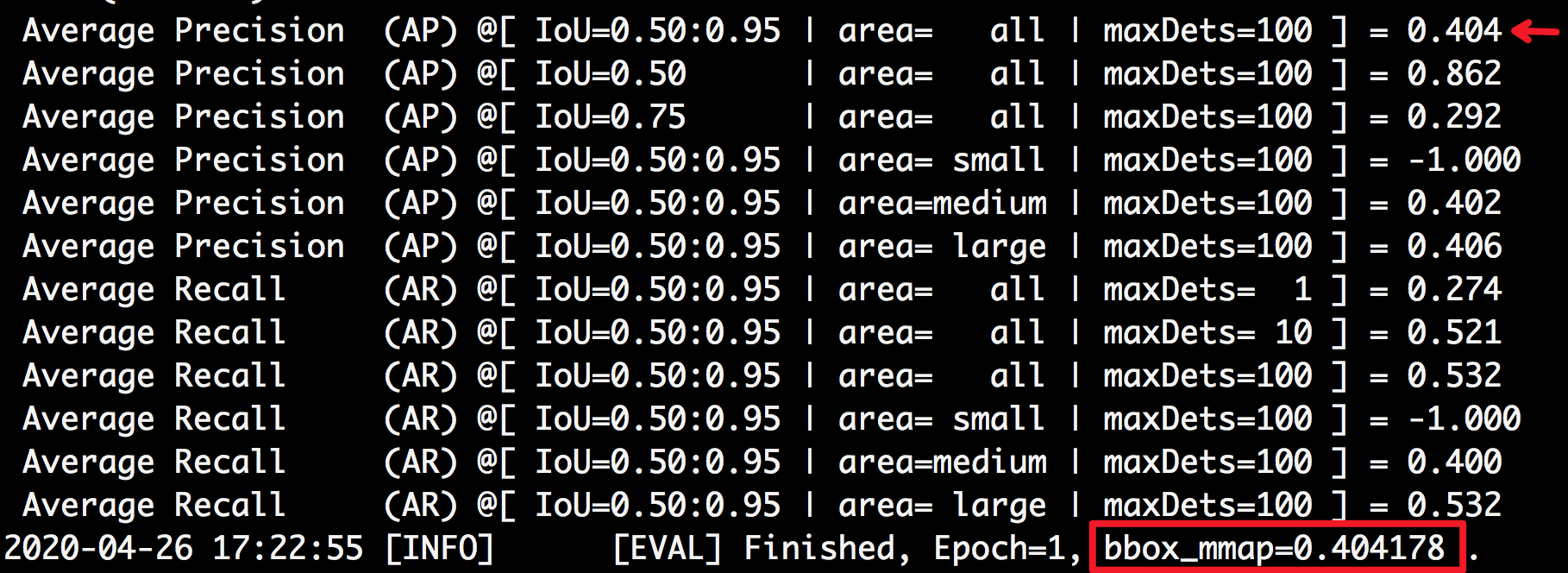

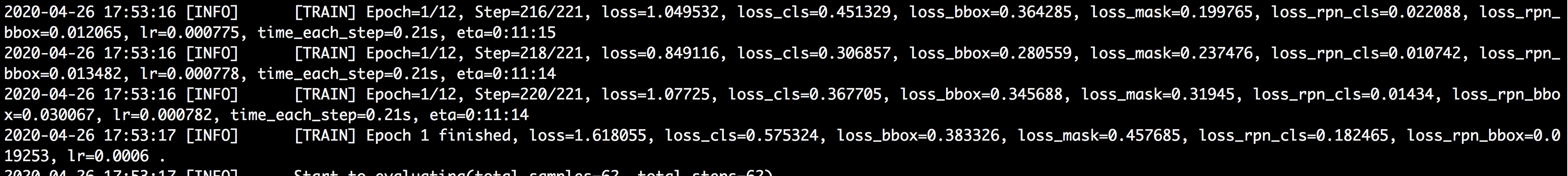

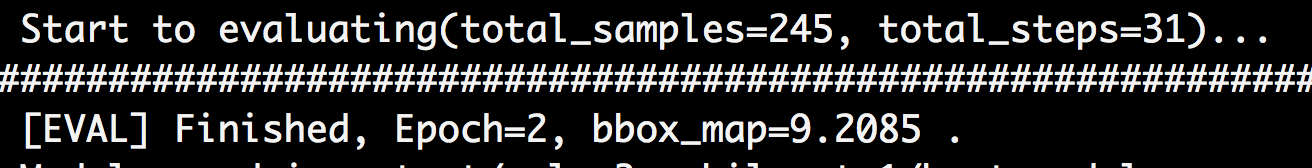

docs/appendix/images/voc_eval.png

0 → 100755

37.7 KB

111.4 KB

docs/paddlex.png

0 → 100644

4.9 KB