Refine index of docs (#658)

Showing

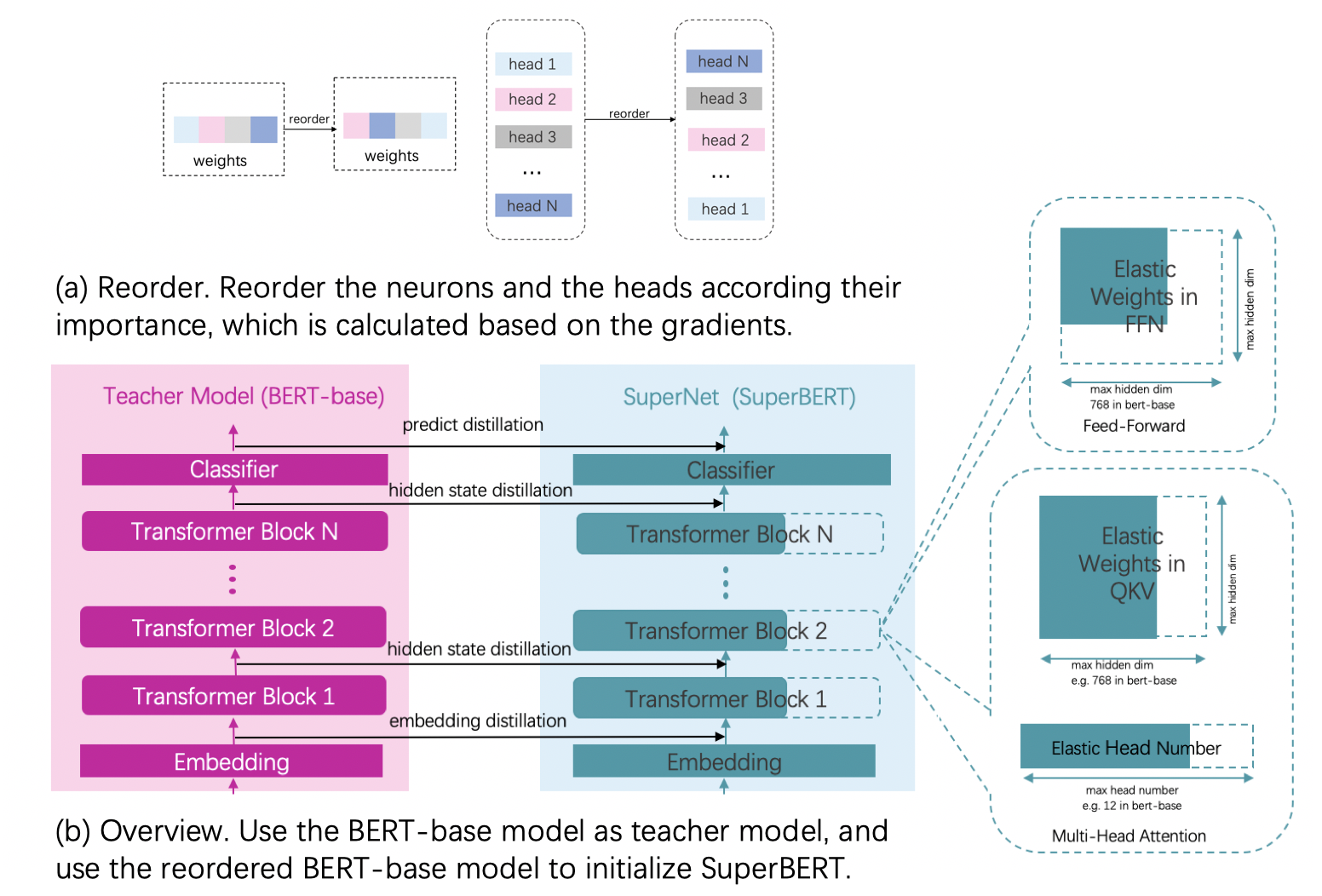

docs/images/algo/ofa_bert.jpg

已删除

100644 → 0

990.1 KB

docs/zh_cn/algo/algo.md

已删除

100644 → 0

docs/zh_cn/cv/detection/index.rst

0 → 100644

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

docs/zh_cn/cv/index.rst

0 → 100644

文件已移动

docs/zh_cn/deploy/index.rst

0 → 100644

docs/zh_cn/models/index.rst

0 → 100644

docs/zh_cn/models/slimfacenet.md

0 → 120000

332.5 KB

docs/zh_cn/nlp/index.rst

0 → 100644

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动