update auto compression docs (#1104)

* update auto compression docs * fix readme * fix title

Showing

文件已移动

文件已移动

文件已移动

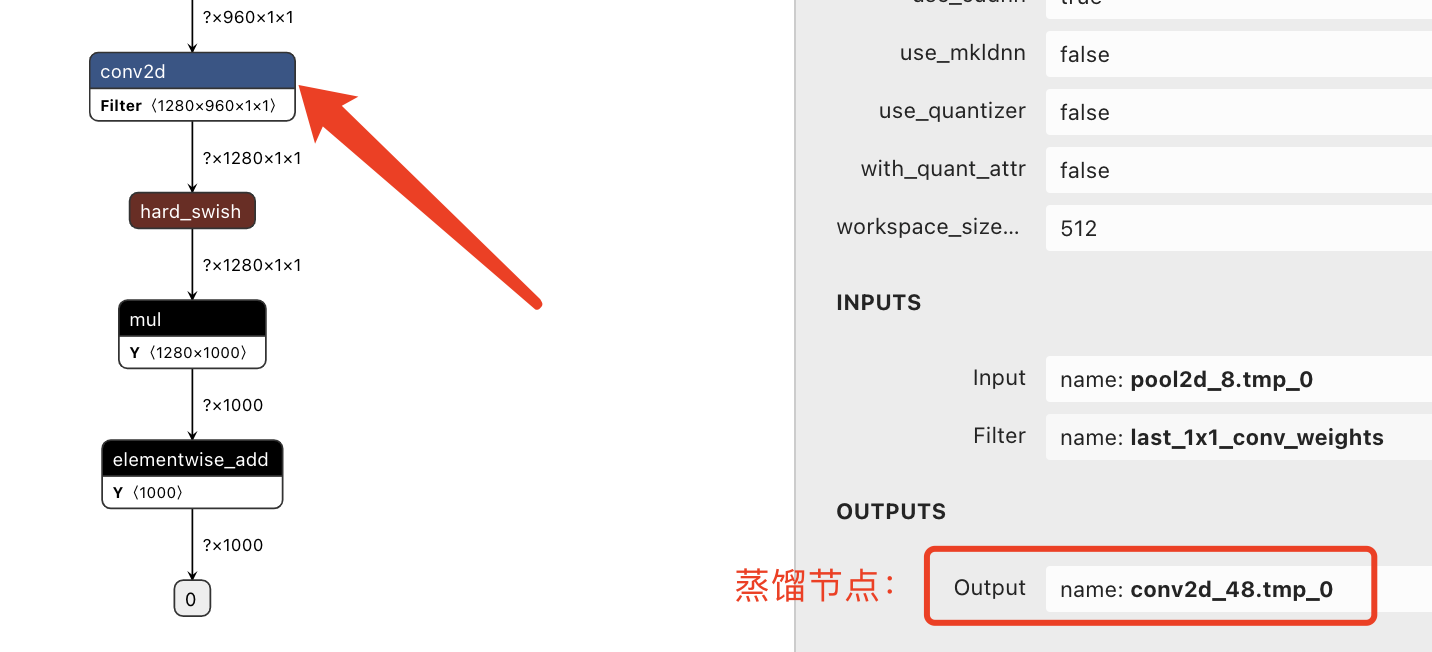

docs/images/dis_node.png

0 → 100644

98.3 KB

* update auto compression docs * fix readme * fix title

98.3 KB