Merge branch 'doc_update' into 'develop'

Doc update See merge request !23

Showing

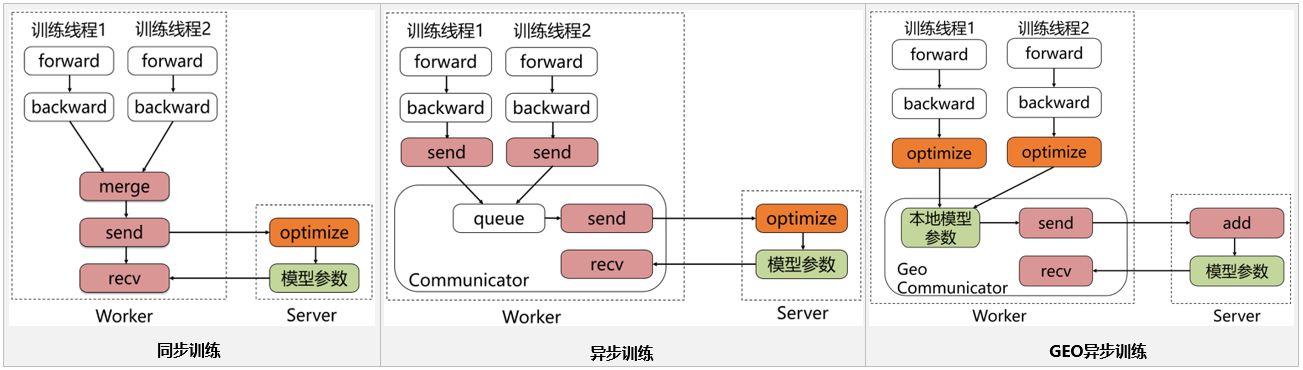

doc/imgs/fleet-ps.png

0 → 100644

173.5 KB

| W: | H:

| W: | H:

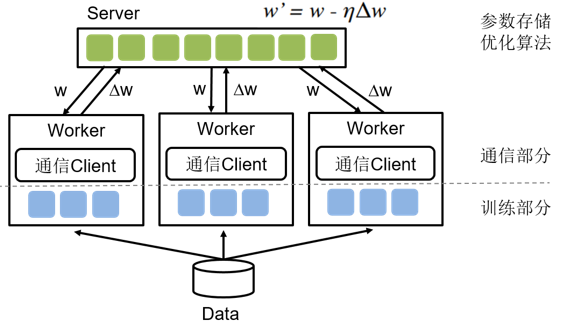

doc/imgs/ps-overview.png

0 → 100644

54.9 KB

doc/ps_background.md

0 → 100644

doc/rec_background.md

0 → 100644