Merge branch 'dygraph' of https://github.com/PaddlePaddle/PaddleOCR into table_pr

Showing

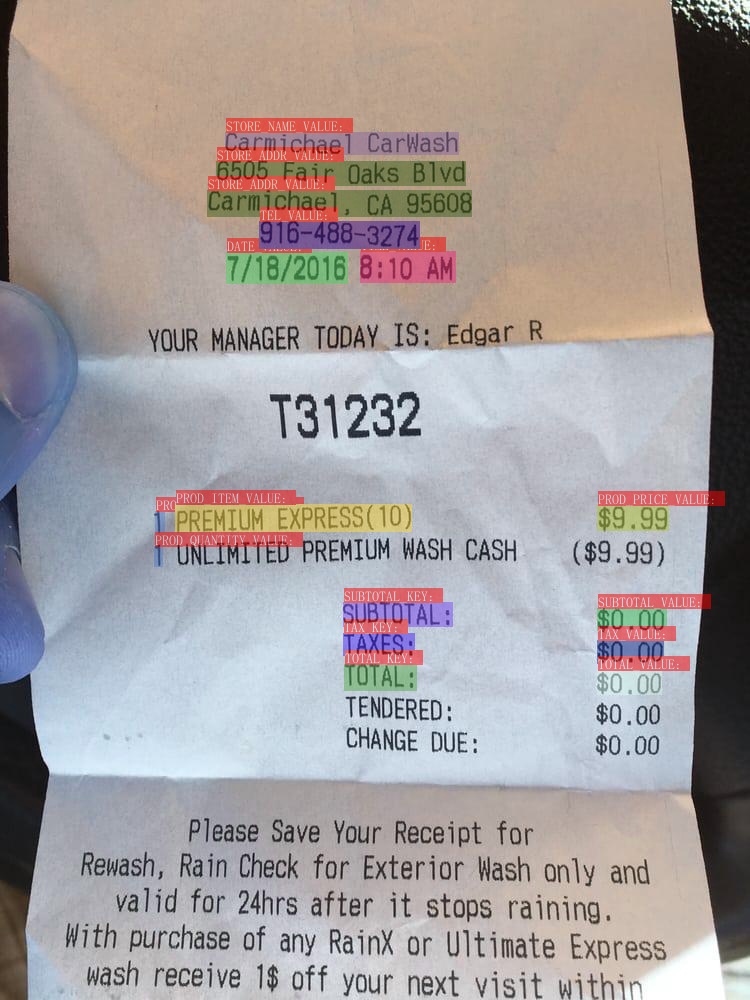

181.1 KB

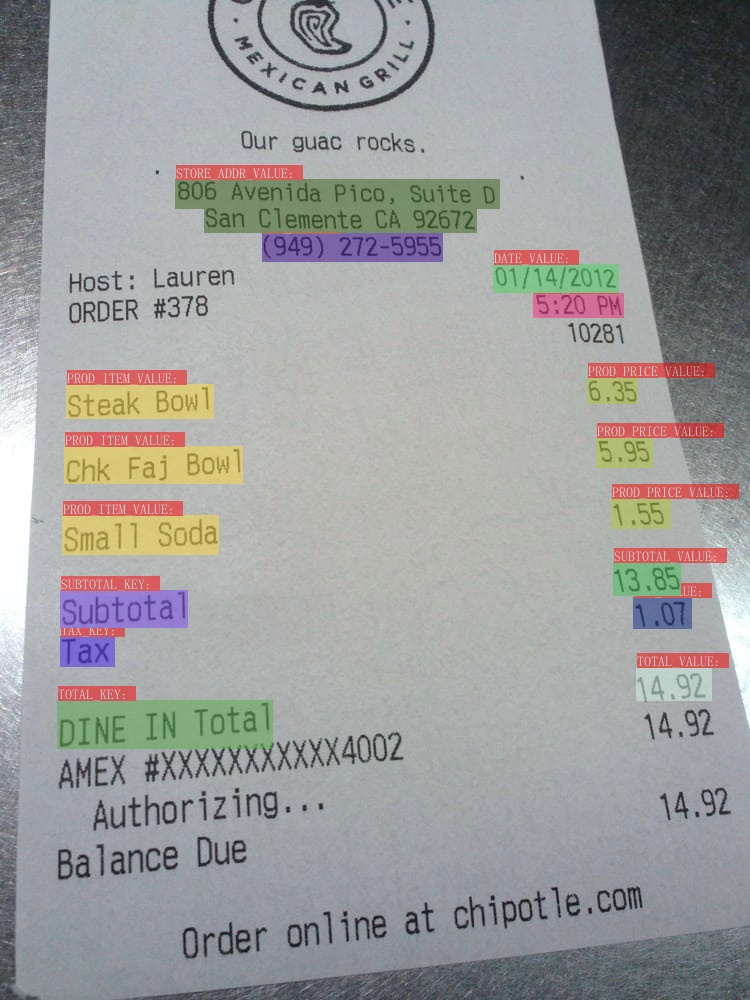

174.6 KB

doc/doc_ch/algorithm_kie_sdmgr.md

0 → 100644

doc/doc_ch/kie.md

0 → 100644

此差异已折叠。

ppstructure/docs/kie.md

已删除

100644 → 0

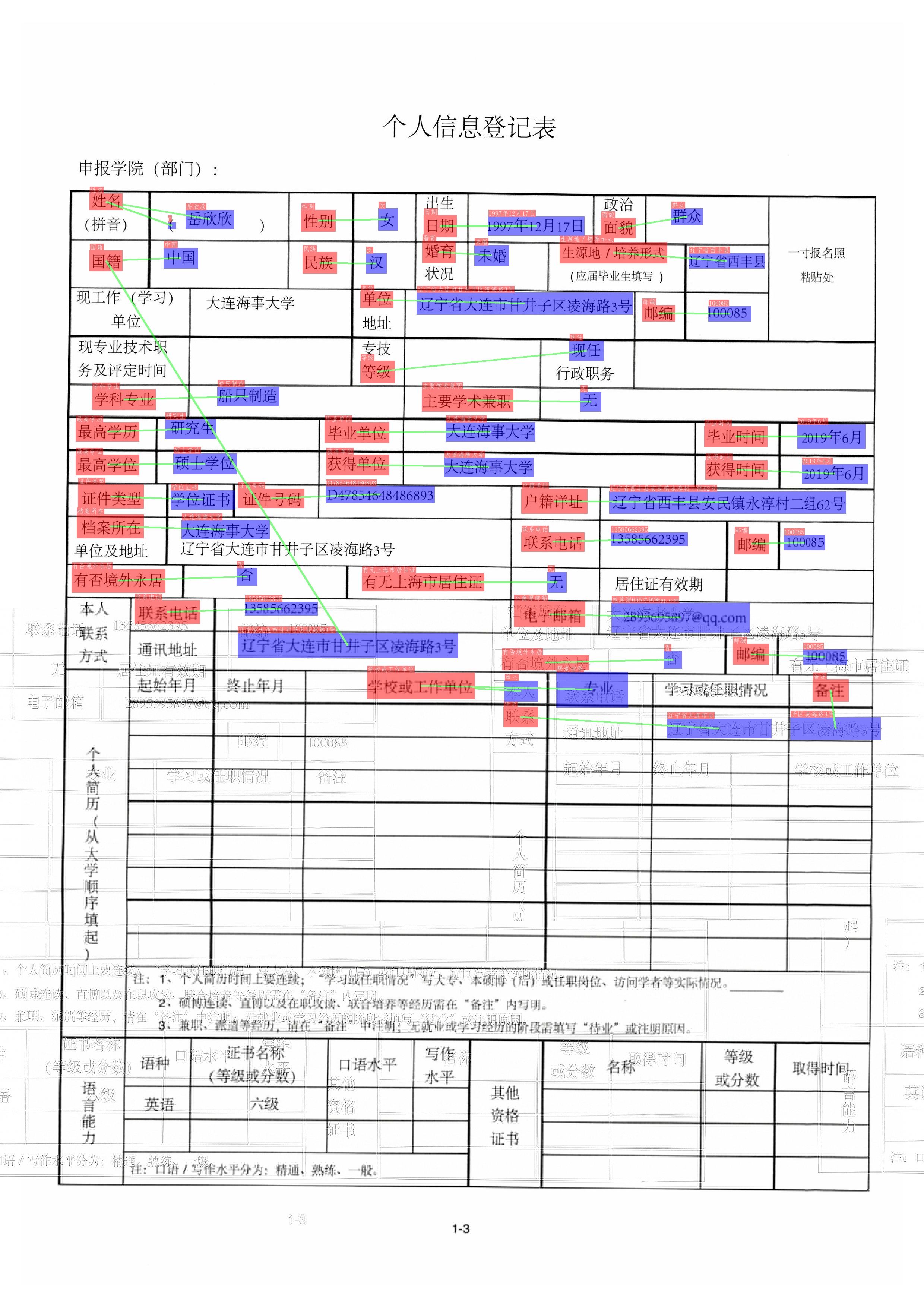

1.6 MB

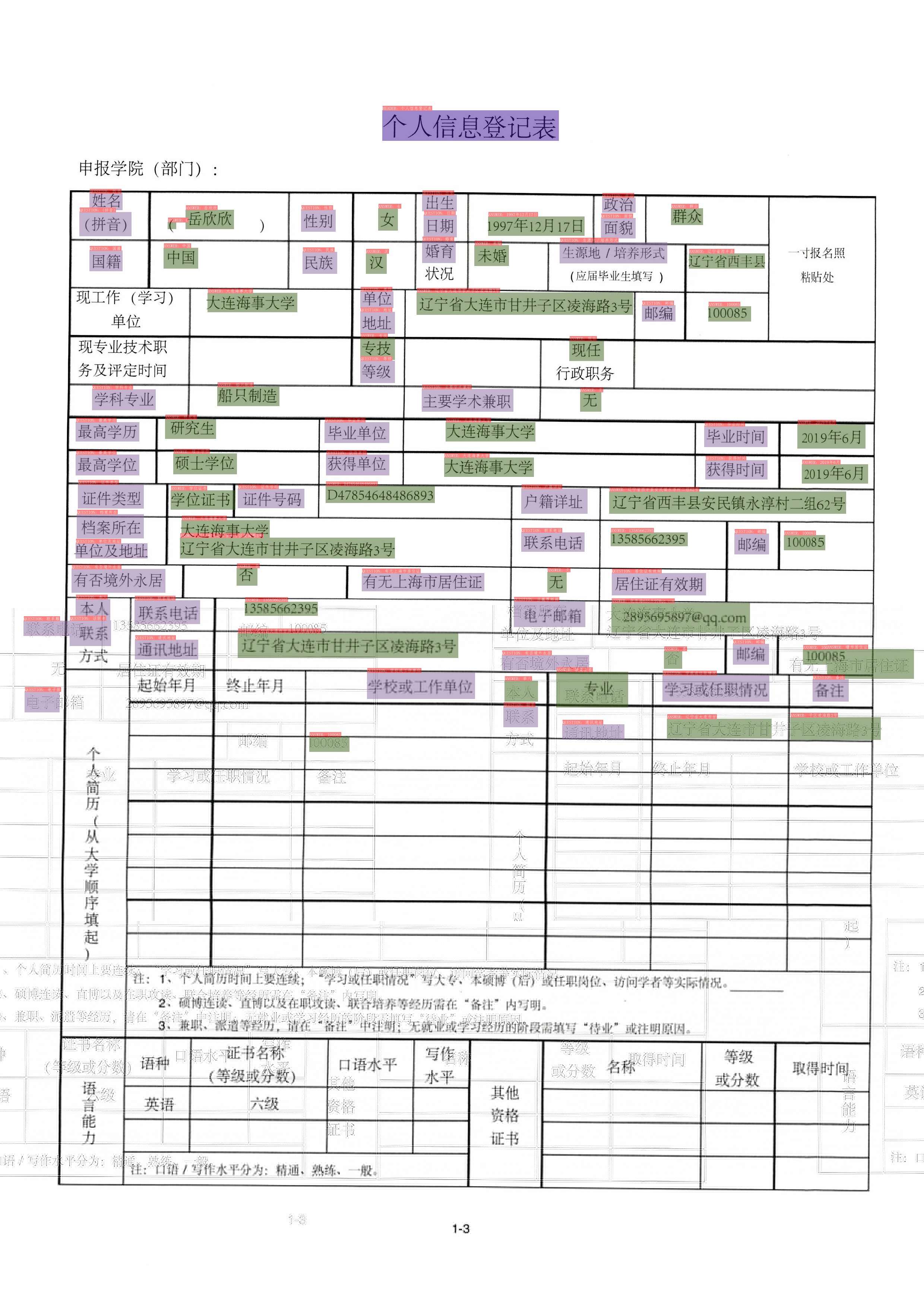

1.6 MB

| W: | H:

| W: | H:

1.5 MB

ppstructure/vqa/how_to_do_kie.md

0 → 100644