Merge branch 'develop' into add_stat

Showing

28.5 KB

文件已移动

文件已移动

125.2 KB

58.9 KB

文件已移动

304.2 KB

docs/imgs/man.png

0 → 100644

88.0 KB

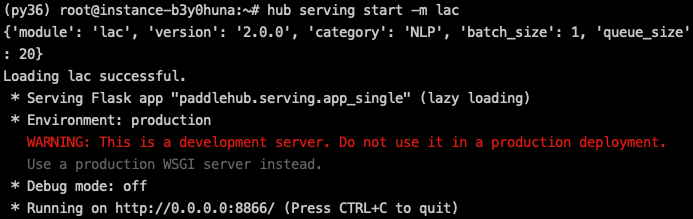

docs/imgs/start_serving_lac.png

0 → 100644

39.6 KB

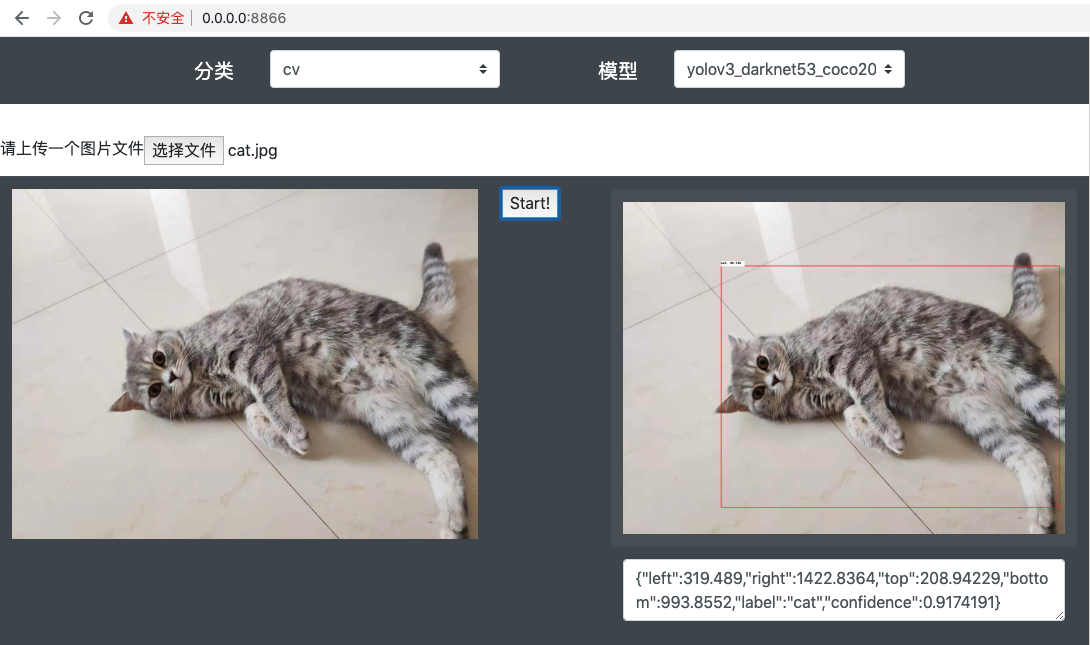

docs/imgs/web_demo.png

0 → 100644

366.7 KB

| ... | ... | @@ -25,4 +25,7 @@ pandas ; python_version >= "3" |

| pandas < 0.25.0 ; python_version < "3" | ||

| # gunicorn not support windows | ||

| gunicorn >= 19.10.0; sys_platform == "darwin" or sys_platform == "linux" | ||

| gunicorn >= 19.10.0; sys_platform != "win32" | ||

| # moviepy 1.0.1 not support imageio>2.5 | ||

| moviepy < 1.0.0 ; python_version < "3" |

tutorial/bert_service.md

0 → 100644

tutorial/serving.md

0 → 100644