Merge branch 'master' of https://github.com/PaddlePaddle/PaddleClas

Showing

configs/flower.yaml

0 → 100644

dataset/README.md

已删除

100644 → 0

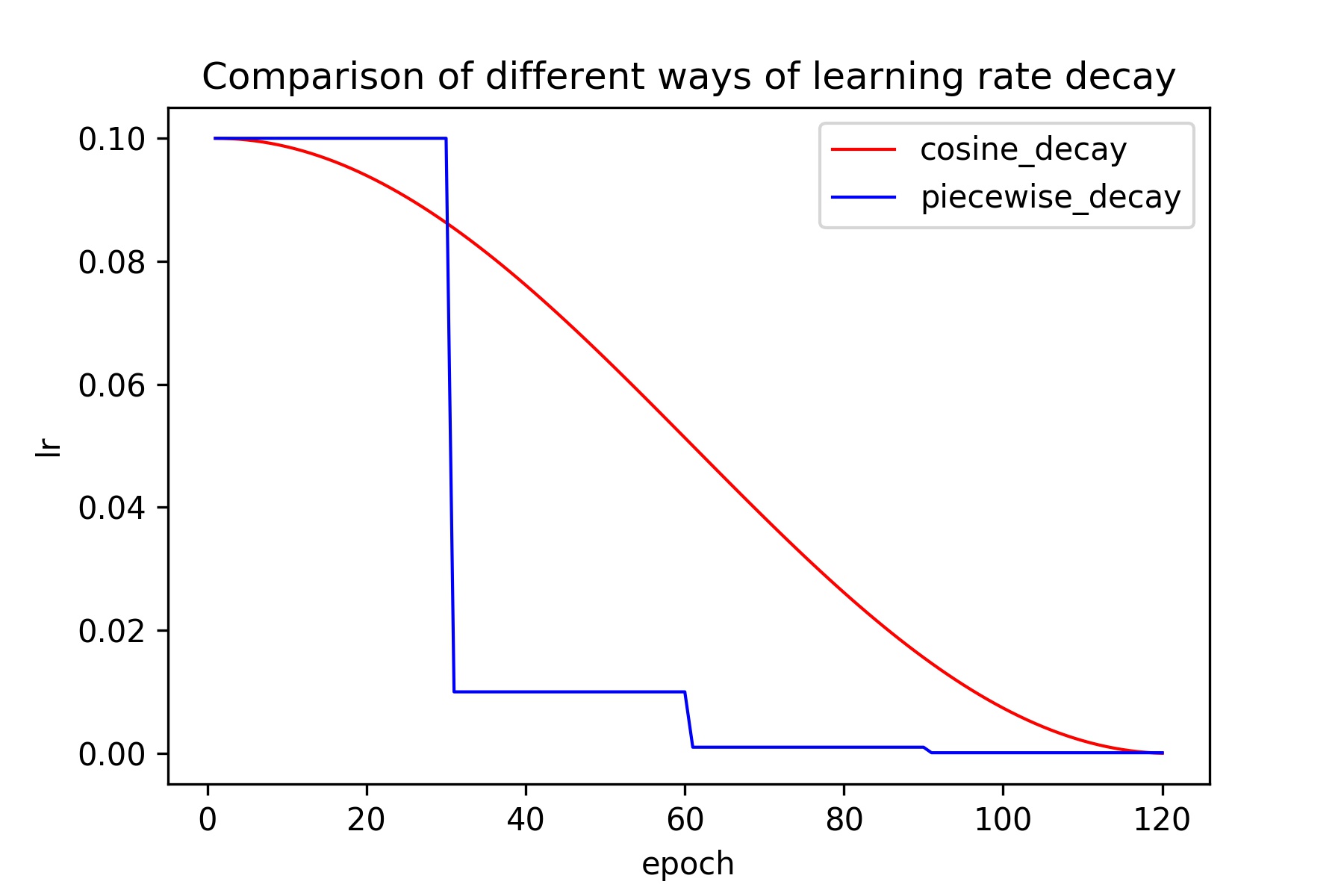

docs/images/models/lr_decay.jpeg

0 → 100644

164.7 KB

docs/zh_CN/tutorials/data.md

0 → 100644

tools/eval.sh

0 → 100644