x86预测API使用示例中,载入INT8模型的问题

Created by: Sunny-Cove

我的目的是,想在Intel Core i9-10900X(μCode: Cascade Lake)上测试VNNI指令集,验证VNNI指令集对INT8精度的模型的加速效果,但是没有成功,有些问题需要请教。我操作的步骤如下:

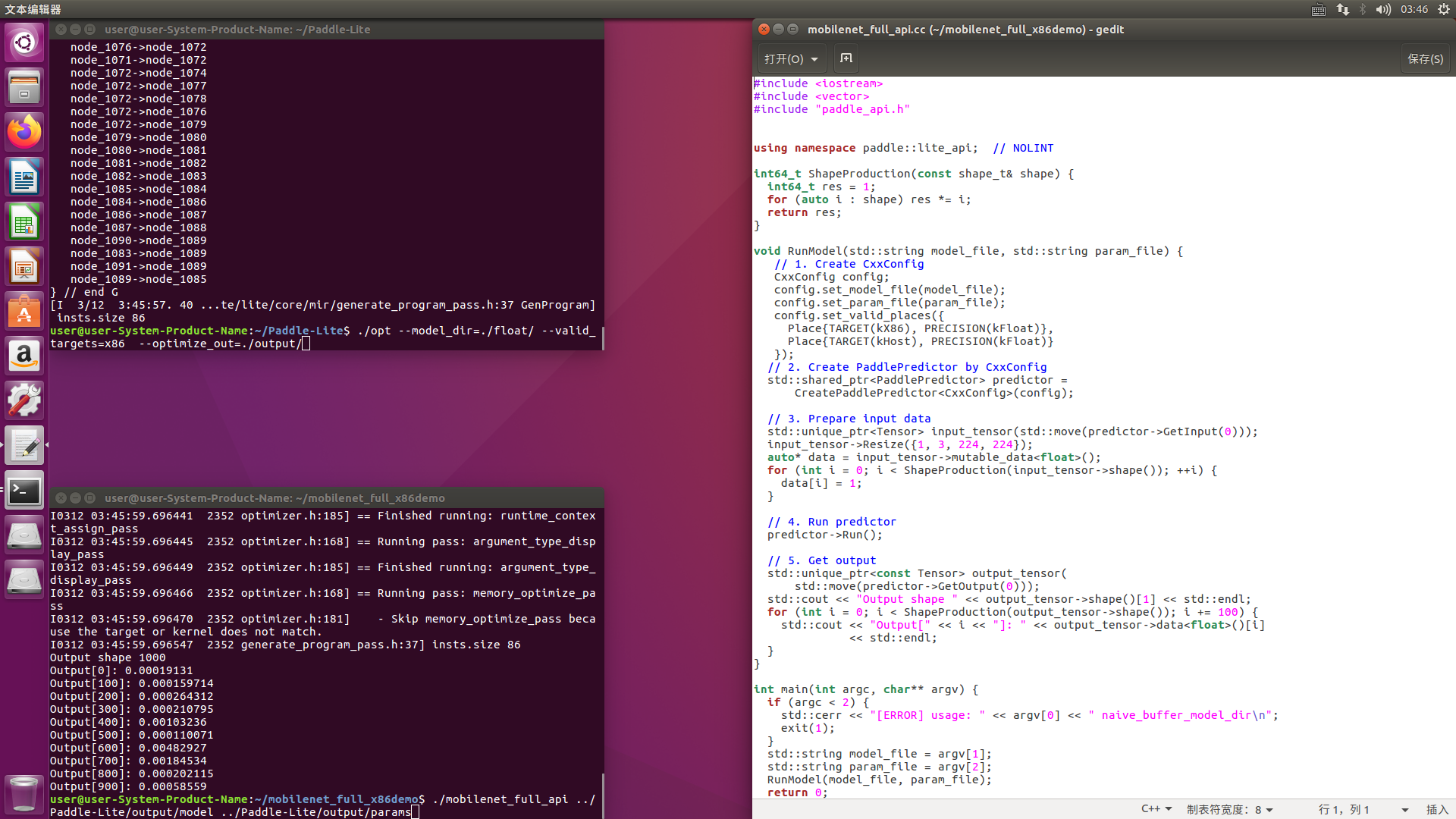

1、复现FP32模型的运行,将x86预测API使用示例中的demo附带的MobileNetV1模型使用OPT工具转化为combined形式,同时修改mobilenet_full_api.cc的输入,使其能够读取combined形式的模型,编译后成功读取转化后的模型并得出正确结果,如图所示

图中的终端的输入框展示了运行OPT工具时的命令以及运行demo时的命令,图中的gedit打开的cc文件展示了代码

2、复现FP32模型的运行,我从

http://paddle-inference-dist.bj.bcebos.com/resnet50.tar.gz

https://paddlepaddle.github.io/PaddleSlim/model_zoo.html

获取ResNet50的FP32模型,重复步骤1中的操作,也可以得到正确结果

3、尝试实现INT8模型的运行,我从

http://paddle-inference-dist.bj.bcebos.com/MobileNetV1_quant.tar.gz

https://paddlemodels.bj.bcebos.com/PaddleSlim/MobileNetV1_quant_post.tar

获取了MobileNetV1的INT8模型,使用OPT工具将其转化为combined形式,运行命令和结果如图所示

图中的终端的输入框展示了运行OPT工具时的命令以及运行demo时的命令,图中的gedit打开的cc文件展示了代码

2、复现FP32模型的运行,我从

http://paddle-inference-dist.bj.bcebos.com/resnet50.tar.gz

https://paddlepaddle.github.io/PaddleSlim/model_zoo.html

获取ResNet50的FP32模型,重复步骤1中的操作,也可以得到正确结果

3、尝试实现INT8模型的运行,我从

http://paddle-inference-dist.bj.bcebos.com/MobileNetV1_quant.tar.gz

https://paddlemodels.bj.bcebos.com/PaddleSlim/MobileNetV1_quant_post.tar

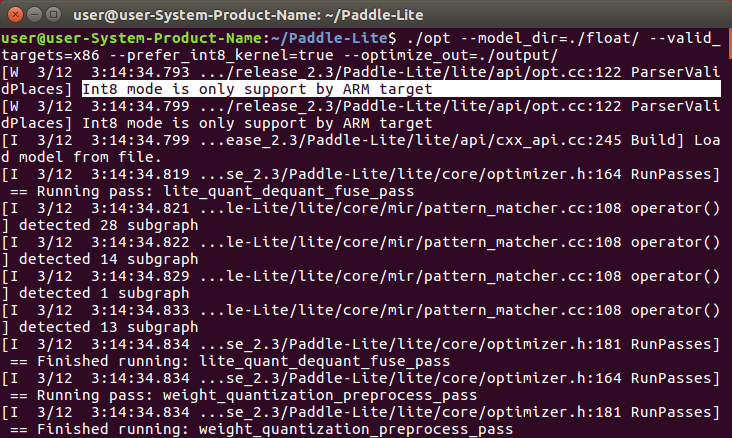

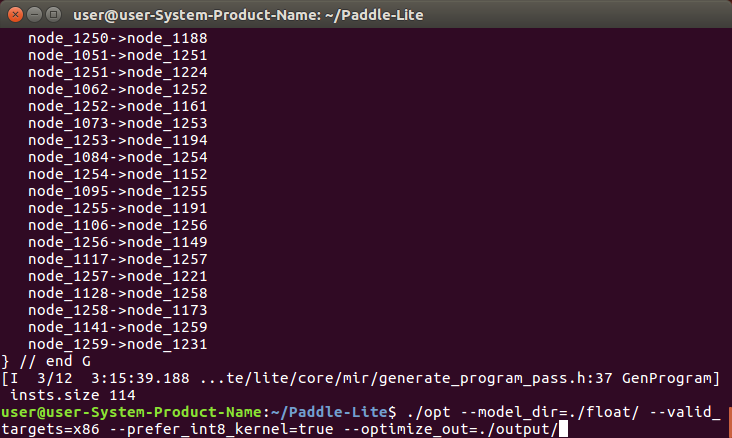

获取了MobileNetV1的INT8模型,使用OPT工具将其转化为combined形式,运行命令和结果如图所示

(终端里的展示的命令显示读取了/float/文件夹里的模型,这只是个名字,里面的文件是INT8的)可以正常生成模型,但是一开始会有警告,意思是INT8模型只支持ARM,【问题:难道不支持x86吗?】

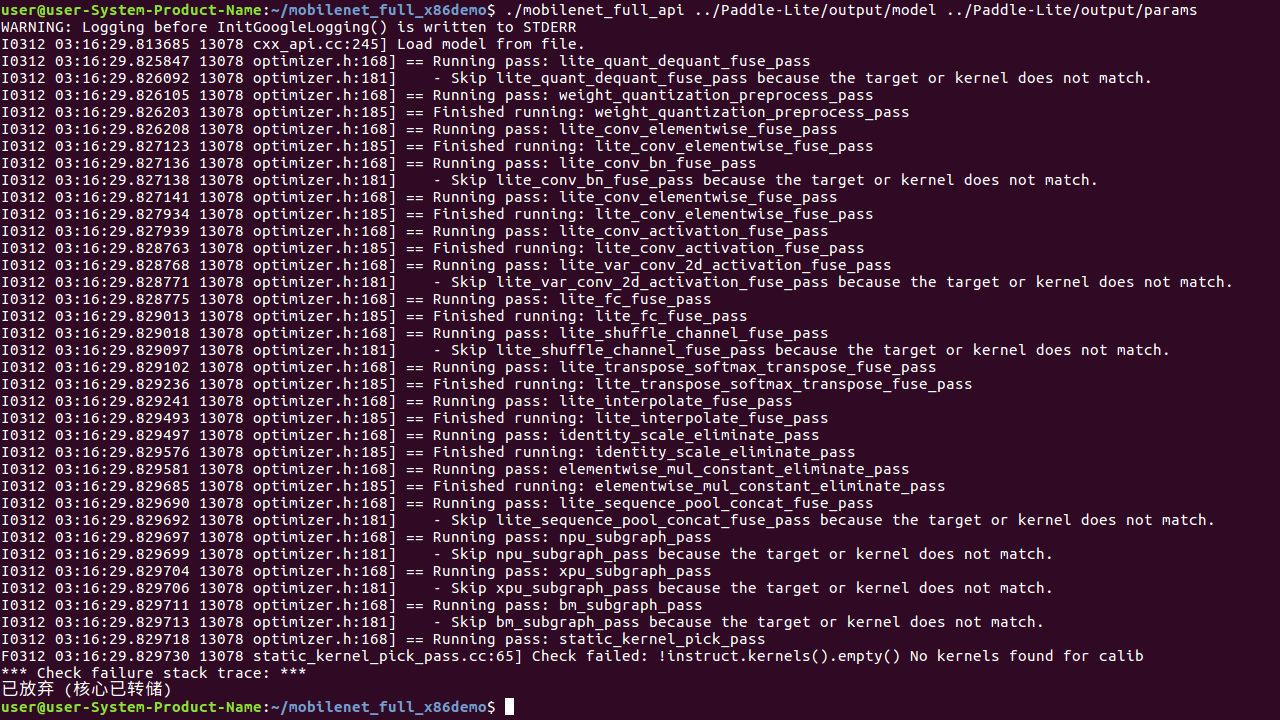

然后我把mobilenet_full_api.cc中的Place{TARGET(kX86), PRECISION(kFloat)}改成Place{TARGET(kX86), PRECISION(kInt8)},编译通过,加载转化后的模型,出现如下报错

(终端里的展示的命令显示读取了/float/文件夹里的模型,这只是个名字,里面的文件是INT8的)可以正常生成模型,但是一开始会有警告,意思是INT8模型只支持ARM,【问题:难道不支持x86吗?】

然后我把mobilenet_full_api.cc中的Place{TARGET(kX86), PRECISION(kFloat)}改成Place{TARGET(kX86), PRECISION(kInt8)},编译通过,加载转化后的模型,出现如下报错

【问题:请指出我的哪个步骤没有做对导致了这个结果】

谢谢!

【问题:请指出我的哪个步骤没有做对导致了这个结果】

谢谢!