[DOC][cherry-pick] update paddle lite docs (#4367)

* [DOC][cherry-pick] update paddle lite docs (#4347) * [DOC] update paddle lite docs (#4329) * [DOC] fix doc of support models tutorials and arch, test=develop, test=document_fix * [DOC] update architecture, test=develop, test=document_fix * [DOC] some updates based on v2.6, test=develop, test=document_fix * [DOC] update based on v2.7, test=document_fix

Showing

| W: | H:

| W: | H:

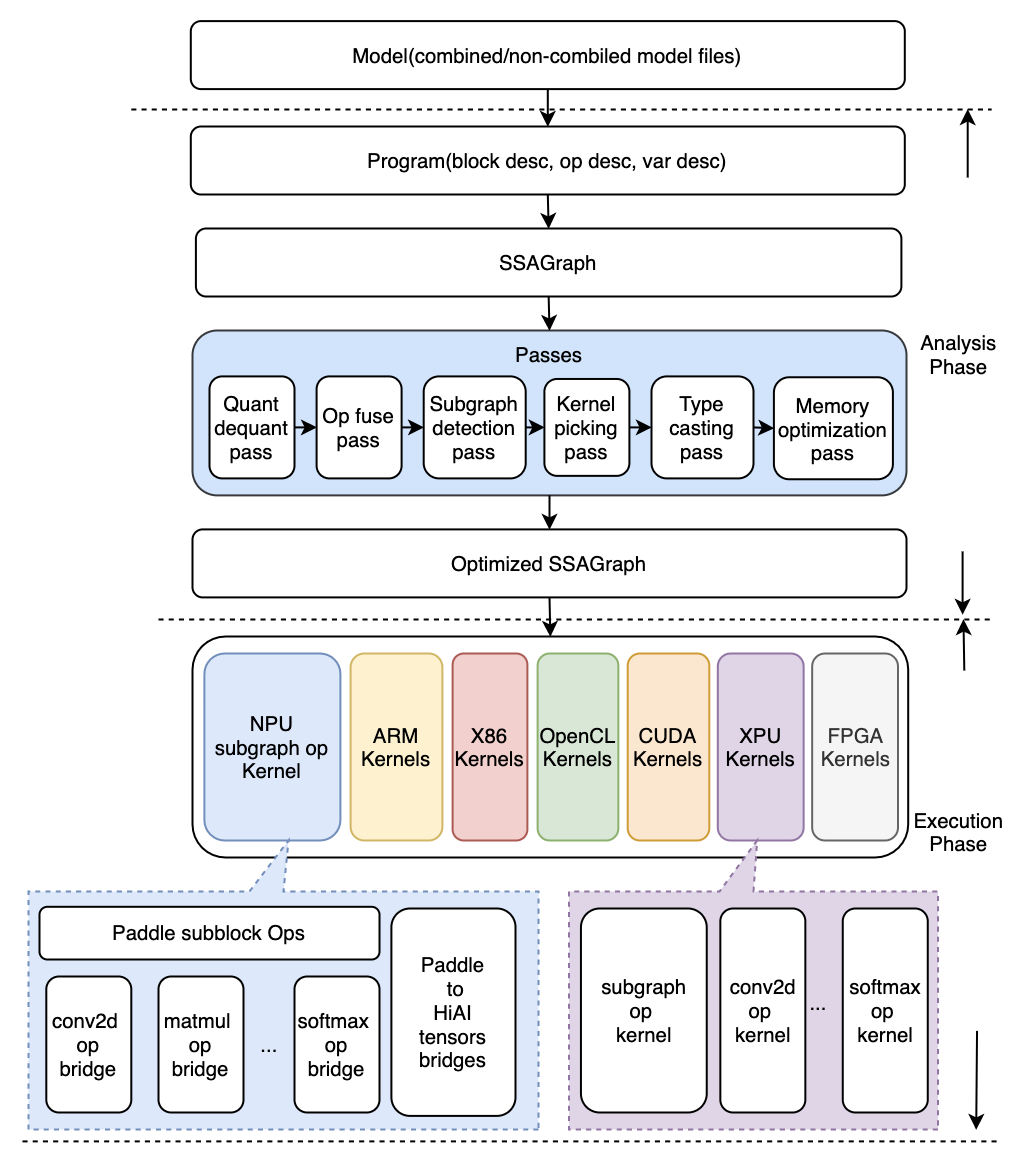

docs/images/workflow.png

0 → 100644

210.4 KB