Upgrade docs by Markdown+ GitHub + ReadtheDocs (#2820)

* add docs

Showing

docs/api_reference/index.rst

0 → 100644

docs/benchmark/benchmark.md

0 → 100644

docs/benchmark/benchmark_tools.md

0 → 100644

docs/benchmark/index.rst

0 → 100644

docs/conf.py

0 → 100644

docs/develop_guides/index.rst

0 → 100644

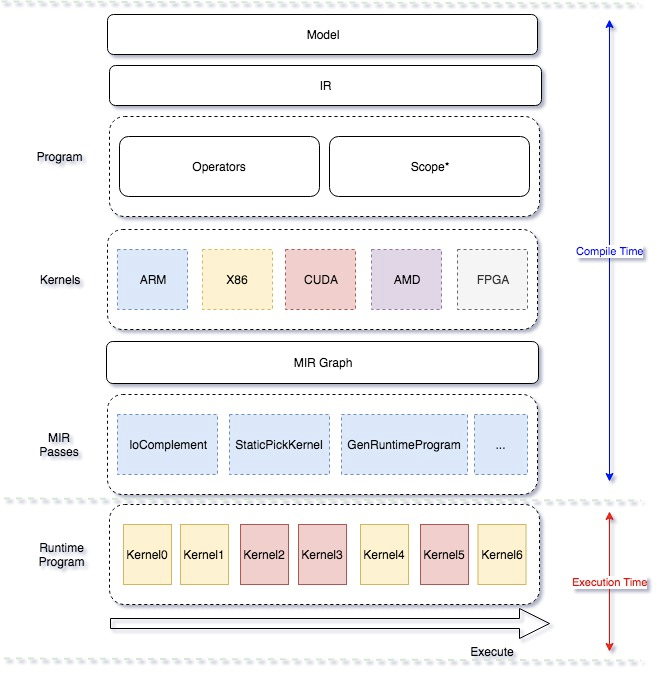

docs/images/architecture.png

0 → 100644

199.9 KB

docs/index.rst

0 → 100644

docs/introduction/architecture.md

0 → 100644

docs/make.bat

0 → 100644

docs/paddle_mobile/index.rst

0 → 100644

docs/requirements.txt

0 → 100644

docs/user_guides/index.rst

0 → 100644