fix wrong tag

Showing

img/ResNetFull.svg

已删除

100644 → 0

此差异已折叠。

img/cnn-rnn-self-attention.svg

0 → 100644

此差异已折叠。

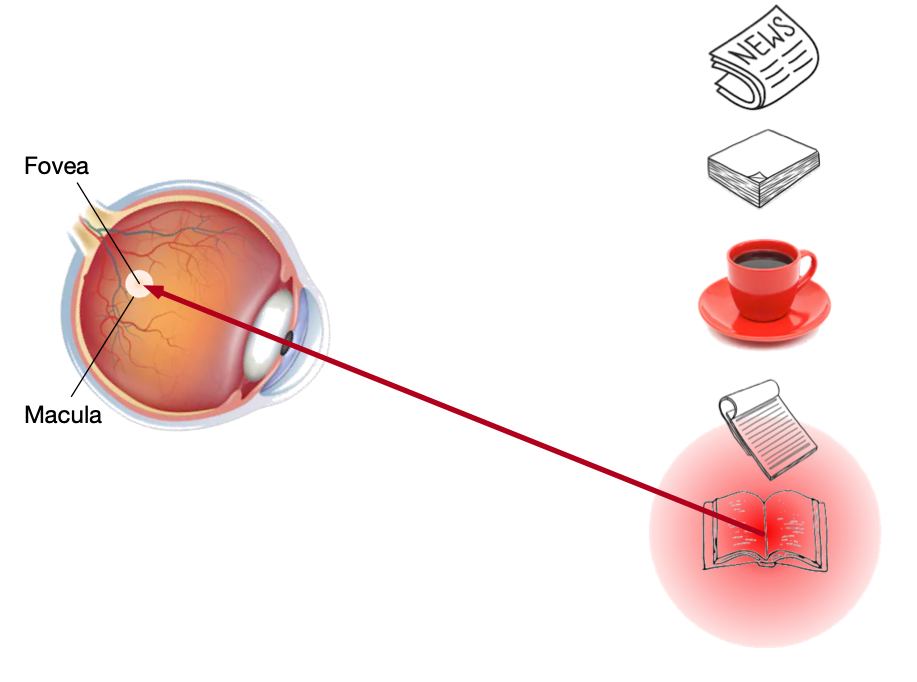

img/eye-book.png

0 → 100644

306.2 KB

img/eye-book.svg

0 → 100644

此差异已折叠。

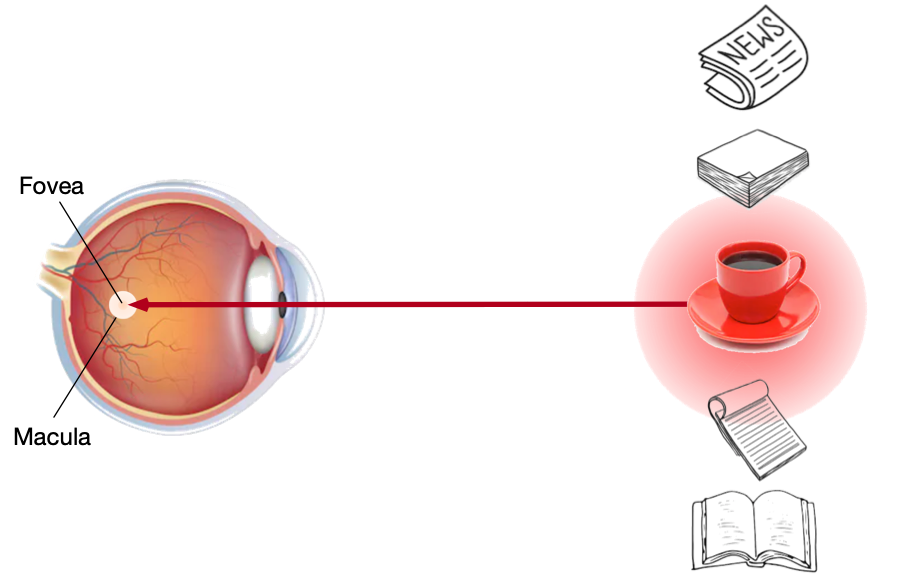

img/eye-coffee.png

0 → 100644

281.7 KB

img/eye-coffee.svg

0 → 100644

此差异已折叠。

img/positional-encoding.svg

已删除

100644 → 0

此差异已折叠。

img/qkv.svg

0 → 100644

此差异已折叠。

img/qr_seq2seq.svg

已删除

100644 → 0

此差异已折叠。

img/qr_similarity-analogy.svg

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

img/stackedanimals.jpg

已删除

100644 → 0

516.2 KB

img/stackedanimals.png

0 → 100644

775.1 KB

此差异已折叠。