更新了部分文档和代码

Showing

文件已移动

文件已移动

文件已移动

文件已移动

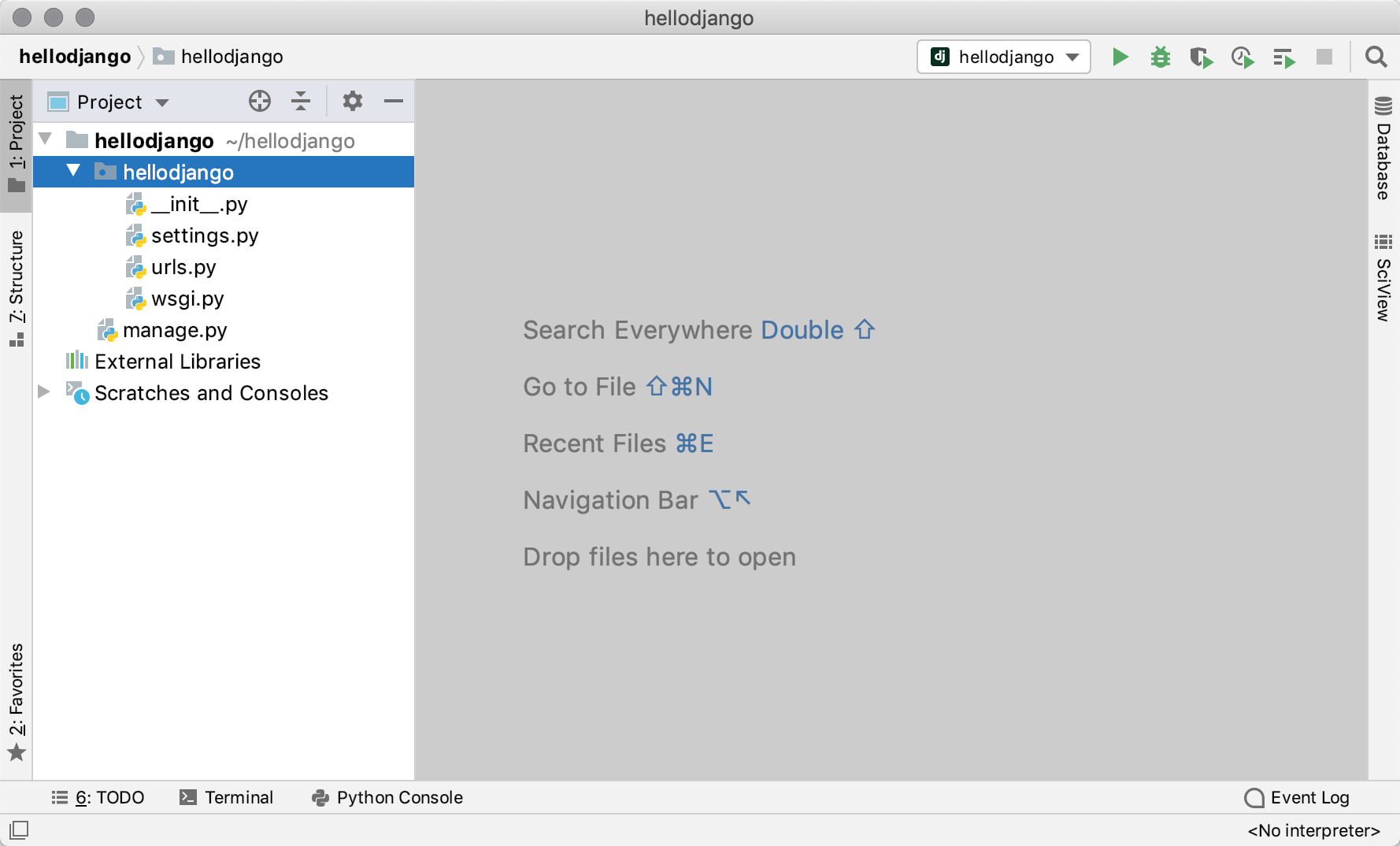

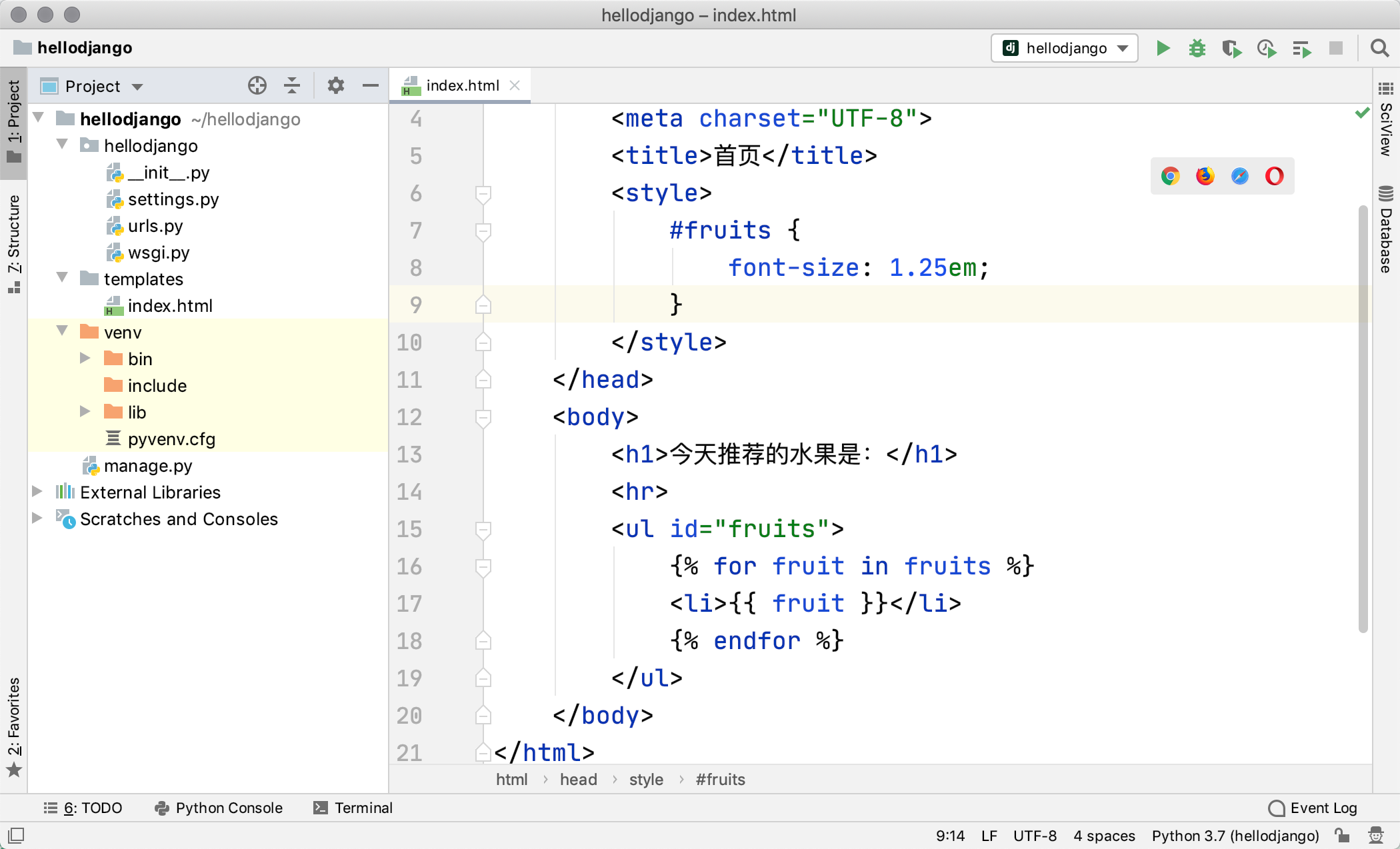

Day41-55/41.Django快速上手.md

0 → 100644

此差异已折叠。

Day41-55/41.快速上手.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

文件已移动

文件已移动

文件已移动

1.9 KB

1.4 KB

124.6 KB

110.0 KB

166.0 KB

106.3 KB

122.1 KB

130.8 KB

Day41-55/code/shop/manage.py

已删除

100644 → 0

46.4 KB

13.3 KB

22.8 KB

32.3 KB

32.4 KB

10.2 KB

46.4 KB

13.3 KB

22.8 KB

32.3 KB

32.4 KB

10.2 KB

Day41-55/res/admin-login.png

已删除

100644 → 0

12.2 KB

40.9 KB

44.9 KB

49.2 KB

73.1 KB

63.7 KB

43.5 KB

Day41-55/res/admin-model.png

已删除

100644 → 0

42.4 KB

34.2 KB

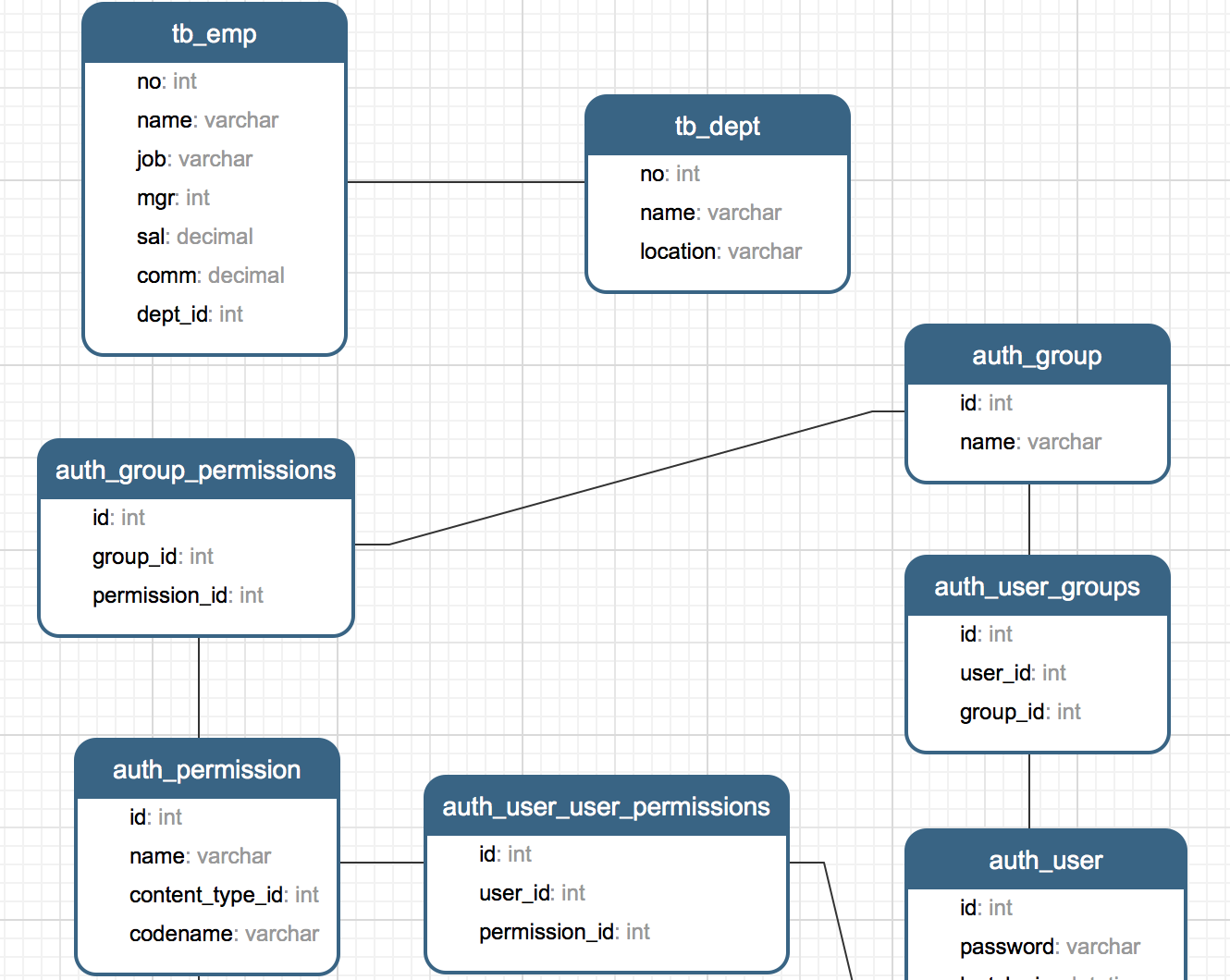

Day41-55/res/er-graph.png

已删除

100644 → 0

84.9 KB

163.4 KB

322.5 KB

294.1 KB

463.8 KB

698.0 KB

344.3 KB

243.7 KB

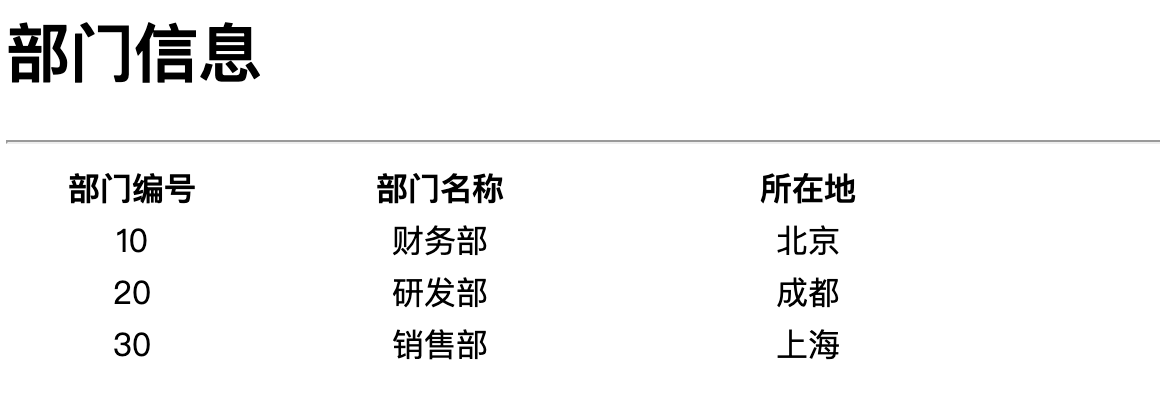

Day41-55/res/show-depts.png

已删除

100644 → 0

11.0 KB

124.6 KB

252.7 KB

Day66-75/75.爬虫项目实战.md

已删除

100644 → 0

此差异已折叠。