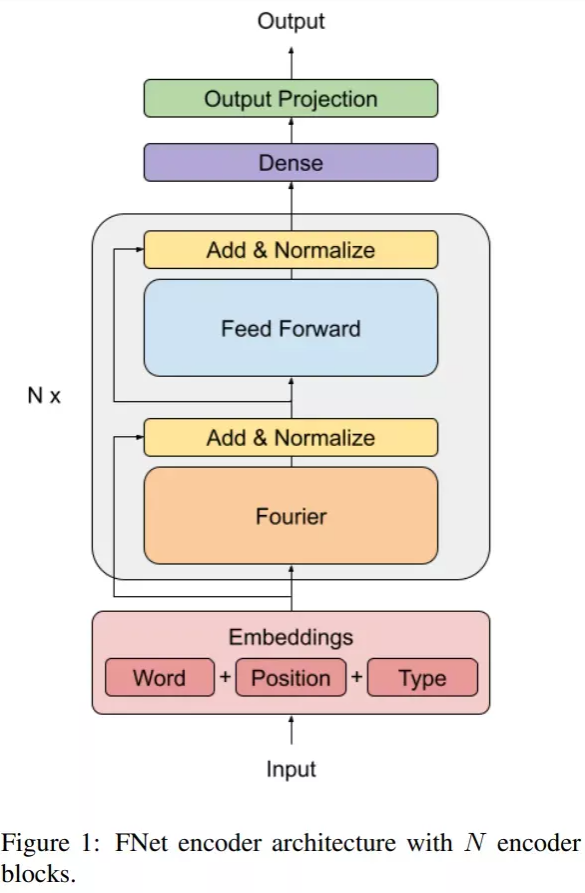

本周AI热点回顾:傅里叶变换取代Transformer,GPU上快7倍、TPU上快2倍;DeepMind新模型自动生成CAD草图

Showing

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

imgs/4.gif

0 → 100644

1.6 MB

imgs/4.png

已删除

100644 → 0

155.1 KB

| W: | H:

| W: | H:

| W: | H:

| W: | H: