Skip to content

体验新版

项目

组织

正在加载...

登录

切换导航

打开侧边栏

Phil_X

ml-nlp

提交

b244bb33

M

ml-nlp

项目概览

Phil_X

/

ml-nlp

与 Fork 源项目一致

从无法访问的项目Fork

通知

1

Star

0

Fork

0

代码

文件

提交

分支

Tags

贡献者

分支图

Diff

Issue

0

列表

看板

标记

里程碑

合并请求

0

Wiki

0

Wiki

分析

仓库

DevOps

项目成员

Pages

M

ml-nlp

项目概览

项目概览

详情

发布

仓库

仓库

文件

提交

分支

标签

贡献者

分支图

比较

Issue

0

Issue

0

列表

看板

标记

里程碑

合并请求

0

合并请求

0

Pages

分析

分析

仓库分析

DevOps

Wiki

0

Wiki

成员

成员

收起侧边栏

关闭侧边栏

动态

分支图

创建新Issue

提交

Issue看板

前往新版Gitcode,体验更适合开发者的 AI 搜索 >>

未验证

提交

b244bb33

编写于

7月 09, 2019

作者:

N

NLP-LOVE

提交者:

GitHub

7月 09, 2019

浏览文件

操作

浏览文件

下载

电子邮件补丁

差异文件

Update README.md

上级

69d89daa

变更

1

隐藏空白更改

内联

并排

Showing

1 changed file

with

16 addition

and

0 deletion

+16

-0

Machine Learning/3.Desition Tree/README.md

Machine Learning/3.Desition Tree/README.md

+16

-0

未找到文件。

Machine Learning/3.Desition Tree/README.md

浏览文件 @

b244bb33

...

...

@@ -140,6 +140,22 @@ Pk表示的是:当前样本集合D中第k类样本所占的比例为Pk。

Classification And Regression Tree(CART)是决策树的一种,CART算法既可以用于创建分类树(Classification Tree),也可以用于创建回归树(Regression Tree),两者在建树的过程稍有差异。

**回归树**

:

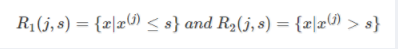

CART回归树是假设树为二叉树,通过不断将特征进行分裂。比如当前树结点是基于第j个特征值进行分裂的,设该特征值小于s的样本划分为左子树,大于s的样本划分为右子树。

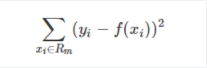

而CART回归树实质上就是在该特征维度对样本空间进行划分,而这种空间划分的优化是一种NP难问题,因此,在决策树模型中是使用启发式方法解决。典型CART回归树产生的目标函数为:

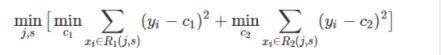

因此,当我们为了求解最优的切分特征j和最优的切分点s,就转化为求解这么一个目标函数:

所以我们只要遍历所有特征的的所有切分点,就能找到最优的切分特征和切分点。最终得到一棵回归树。

参考文章:

[

经典算法详解--CART分类决策树、回归树和模型树

](

https://blog.csdn.net/jiede1/article/details/76034328

)

## 4. 决策树如何剪枝

...

...

编辑

预览

Markdown

is supported

0%

请重试

或

添加新附件

.

添加附件

取消

You are about to add

0

people

to the discussion. Proceed with caution.

先完成此消息的编辑!

取消

想要评论请

注册

或

登录