test

Showing

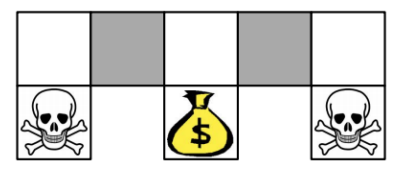

docs/img/fig8&9_1.png

0 → 100644

23.3 KB

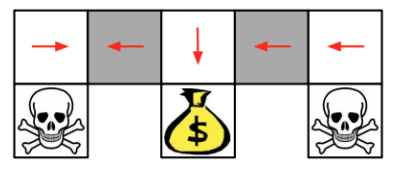

docs/img/fig8&9_2.png

0 → 100644

25.6 KB

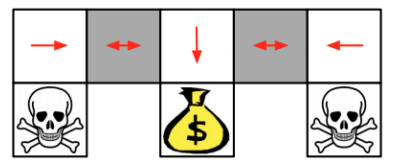

docs/img/fig8&9_3.png

0 → 100644

26.1 KB

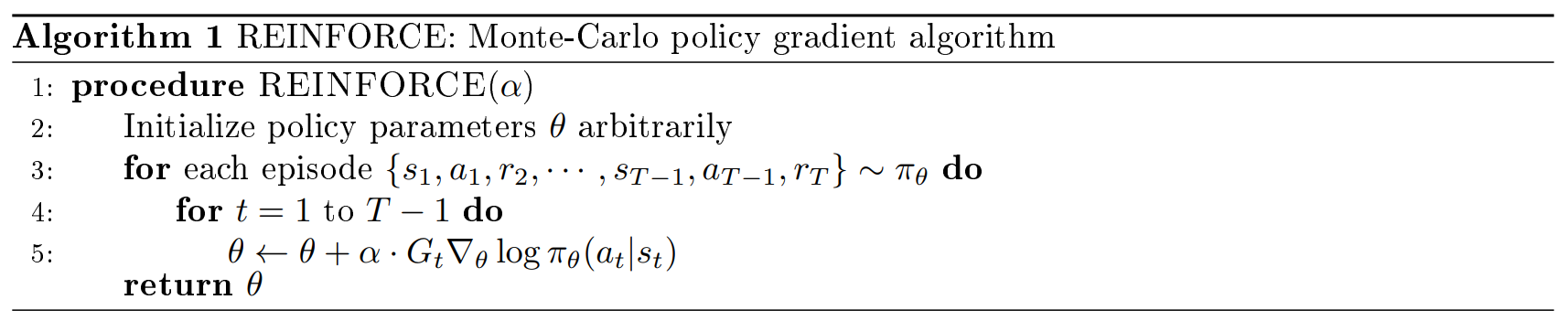

docs/img/fig8&9_alg_1.png

0 → 100644

62.1 KB

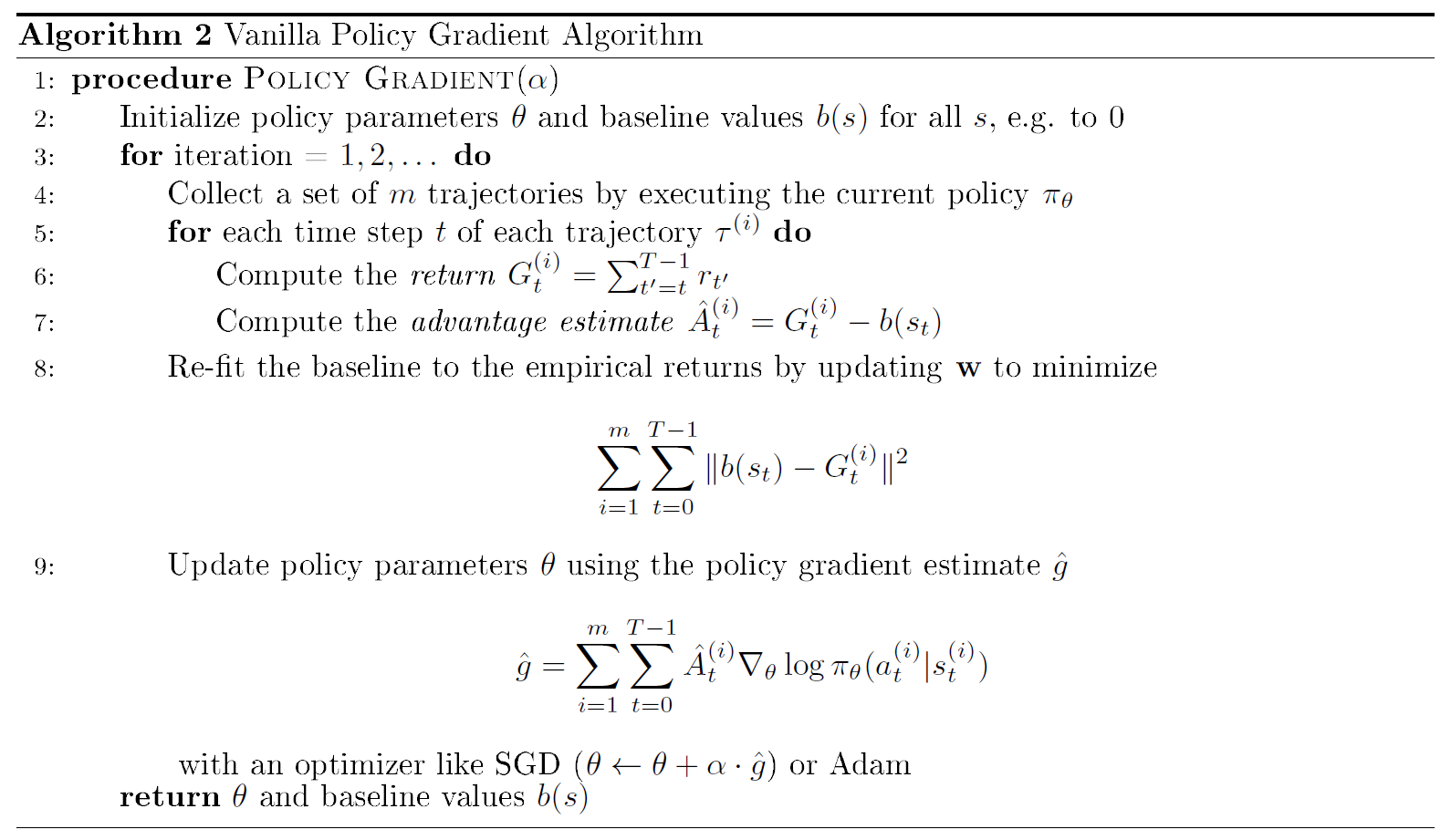

docs/img/fig8&9_alg_2.png

0 → 100644

108.3 KB