Merge pull request #348 from loopyme/master

更新调整1,2章

Showing

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

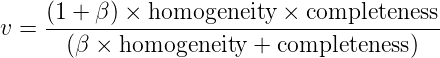

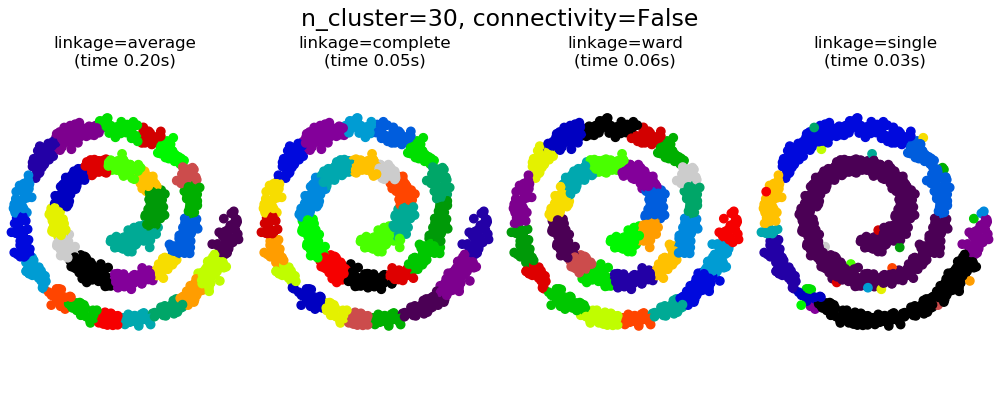

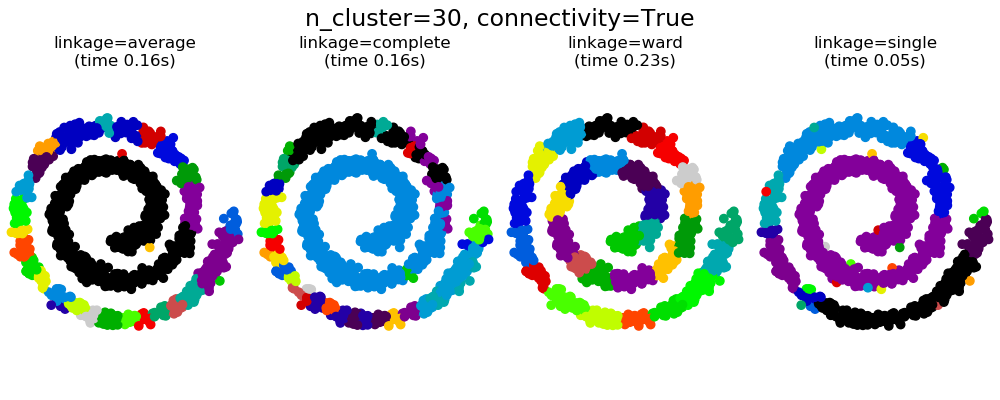

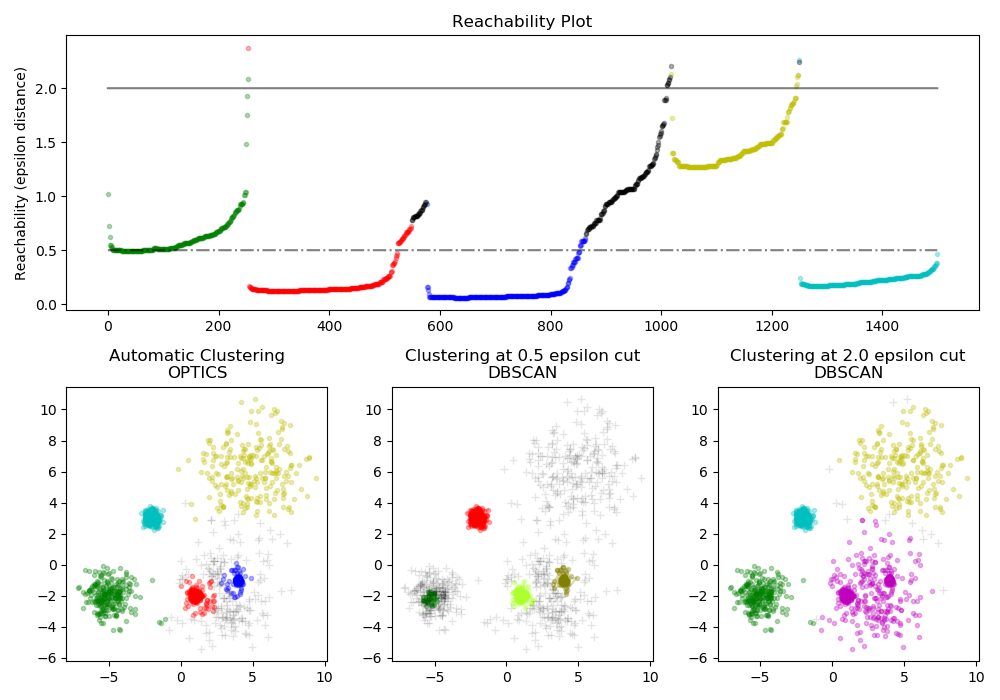

docs/img/cluster01.png

0 → 100644

2.7 KB

108.2 KB

75.8 KB

108.8 KB

71.9 KB

427.4 KB

640.6 KB

55.6 KB

46.9 KB

133.5 KB