更新第五六章

Showing

此差异已折叠。

docs/46.md

0 → 100644

docs/47.md

0 → 100644

此差异已折叠。

docs/65.md

已删除

100644 → 0

此差异已折叠。

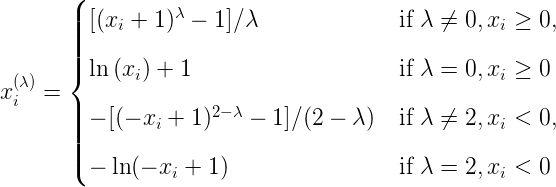

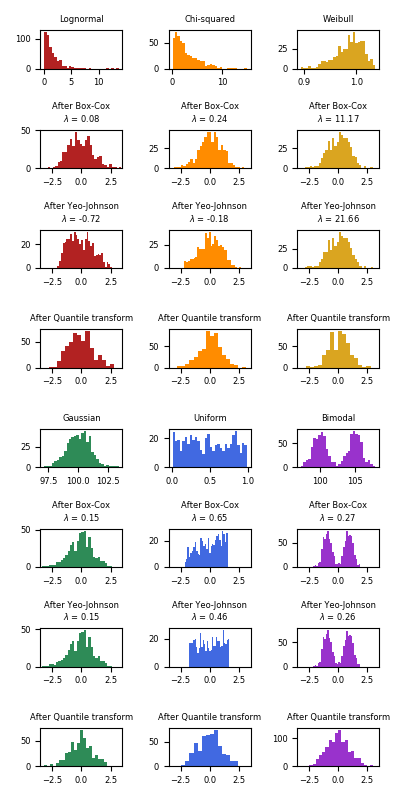

docs/img/preprocessing001.png

0 → 100644

6.0 KB

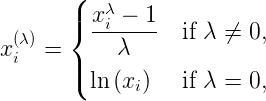

docs/img/preprocessing002.png

0 → 100644

2.2 KB

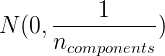

docs/img/projection001.png

0 → 100644

1023 字节

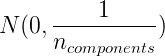

docs/img/projection002.png

0 → 100644

1023 字节

35.1 KB