更新第三章

Showing

docs/29.md

0 → 100644

docs/30.md

0 → 100644

此差异已折叠。

docs/31.md

0 → 100644

docs/32.md

0 → 100644

此差异已折叠。

此差异已折叠。

docs/37.md

已删除

100644 → 0

docs/38.md

已删除

100644 → 0

docs/img/3-5-001.png

0 → 100644

1.0 KB

44.1 KB

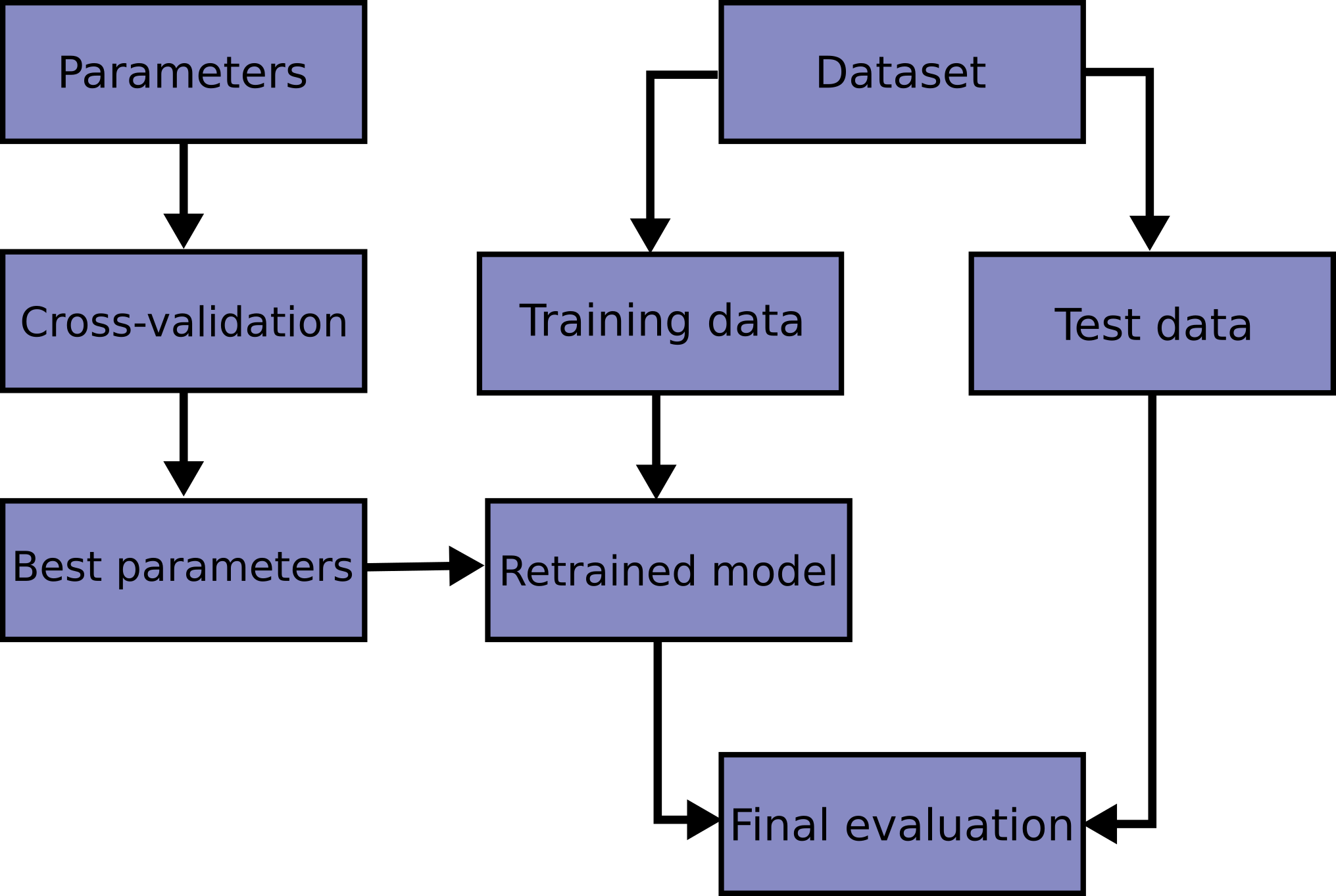

docs/img/grid_search_workflow.png

0 → 100644

98.1 KB

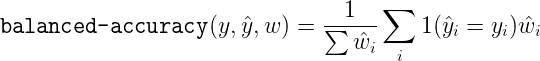

docs/img/score001.png

0 → 100644

645 字节

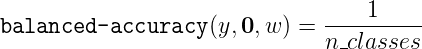

docs/img/score002.png

0 → 100644

671 字节

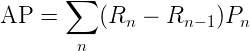

docs/img/score003.png

0 → 100644

1.1 KB

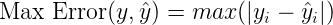

docs/img/score004.png

0 → 100644

304 字节

docs/img/score005.png

0 → 100644

2.6 KB

docs/img/score006.png

0 → 100644

2.1 KB

docs/img/score007.png

0 → 100644

1.2 KB

docs/img/score008.png

0 → 100644

1.5 KB

docs/img/score009.png

0 → 100644

2.2 KB

15.3 KB

16.7 KB

17.0 KB

17.4 KB

17.8 KB

18.7 KB

61.3 KB