Commits (22)

Showing

docs/0.2/README.md

已删除

100644 → 0

docs/0.2/SUMMARY.md

已删除

100644 → 0

docs/0.2/acknowledgement.md

已删除

100644 → 0

docs/0.2/notes/autograd.md

已删除

100644 → 0

docs/0.2/notes/cuda.md

已删除

100644 → 0

docs/0.2/notes/extending.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.3/README.md

已删除

100644 → 0

docs/0.3/SUMMARY.md

已删除

100644 → 0

docs/0.3/autograd.md

已删除

100644 → 0

docs/0.3/c_extension.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.3/cuda.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/data.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

docs/0.3/datasets.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/dist_tuto.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/distributed.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/distributions.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/doc.md

已删除

100644 → 0

docs/0.3/ffi.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

17.1 KB

6.2 KB

21.4 KB

317.1 KB

45.7 KB

43.7 KB

24.3 KB

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.3/legacy.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/model_zoo.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/models.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/multiprocessing.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.3/nn.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/notes.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/notes_autograd.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

docs/0.3/notes_cuda.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/notes_extending.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.3/onnx.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/optim.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/package_reference.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.3/sparse.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

docs/0.3/storage.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

docs/0.3/tensors.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/torch.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/torchvision.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.3/transforms.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/tut.md

已删除

100644 → 0

此差异已折叠。

docs/0.3/utils.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/0.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/1.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/10.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/11.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/12.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/13.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/14.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/15.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/16.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/17.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/18.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/19.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/2.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/20.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/21.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/22.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/23.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/24.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/25.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/26.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/27.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/28.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/29.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/3.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/30.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/31.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/32.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/33.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/34.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/35.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/36.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/37.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/4.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/5.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/6.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/7.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/8.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/9.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/README.md

已删除

100644 → 0

此差异已折叠。

docs/0.4/SUMMARY.md

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

docs/0.4/img/65ca6a0b.jpg

已删除

100644 → 0

此差异已折叠。

docs/0.4/img/73dd6bbb.png

已删除

100644 → 0

此差异已折叠。

docs/0.4/img/cover_image.jpg

已删除

100644 → 0

此差异已折叠。

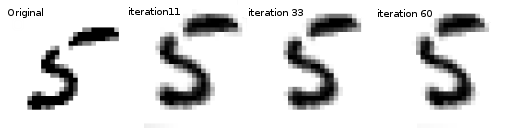

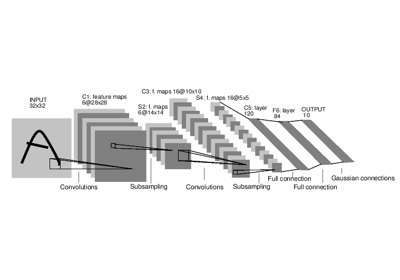

docs/2.0/img/mnist.png

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。