集群内部服务发现

Showing

dnsdemo/test-api.yaml

0 → 100644

dnsdemo/test-nginx.yaml

0 → 100644

docs/39. 服务发现.md

0 → 100644

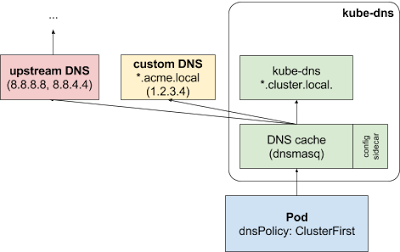

docs/images/dns.png

0 → 100644

28.1 KB

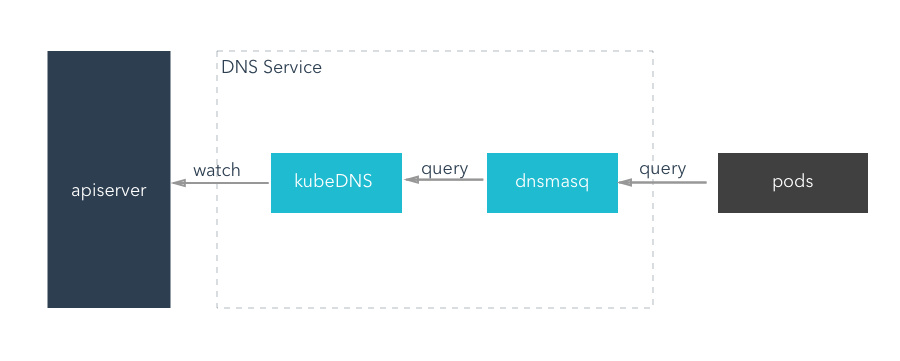

docs/images/kubedns.jpg

0 → 100644

30.2 KB