Add examples to README.md

Showing

examples/.DS_Store

0 → 100644

文件已添加

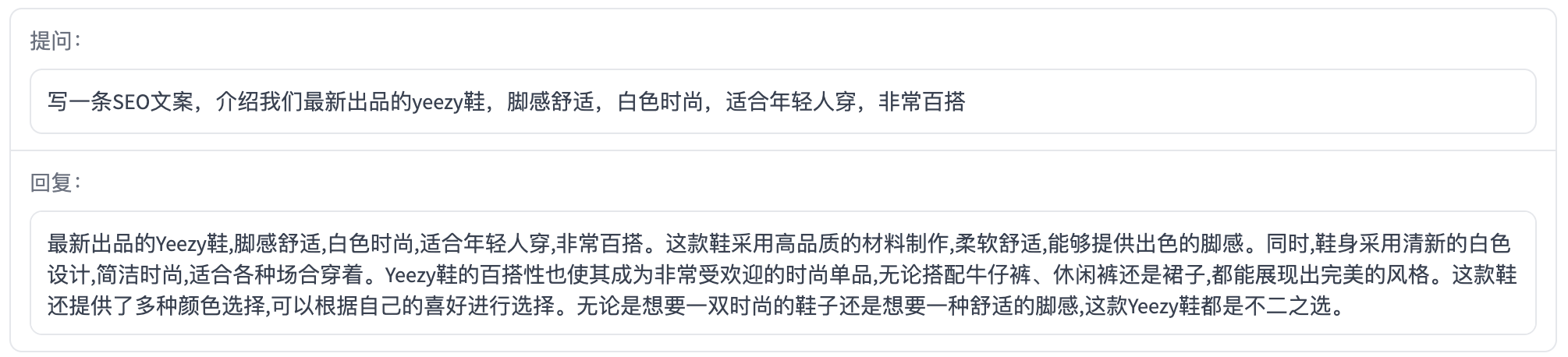

examples/ad-writing-2.png

0 → 100644

122.7 KB

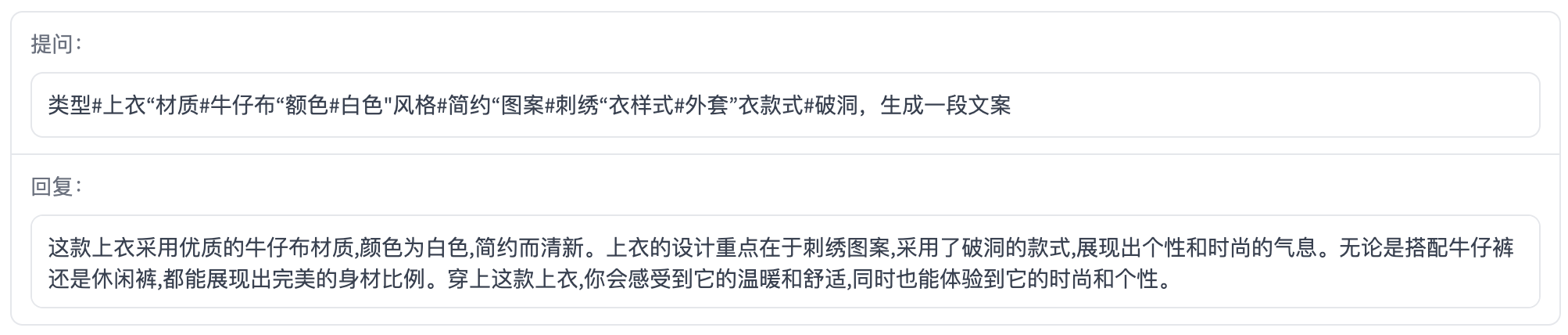

examples/ad-writing.png

0 → 100644

158.9 KB

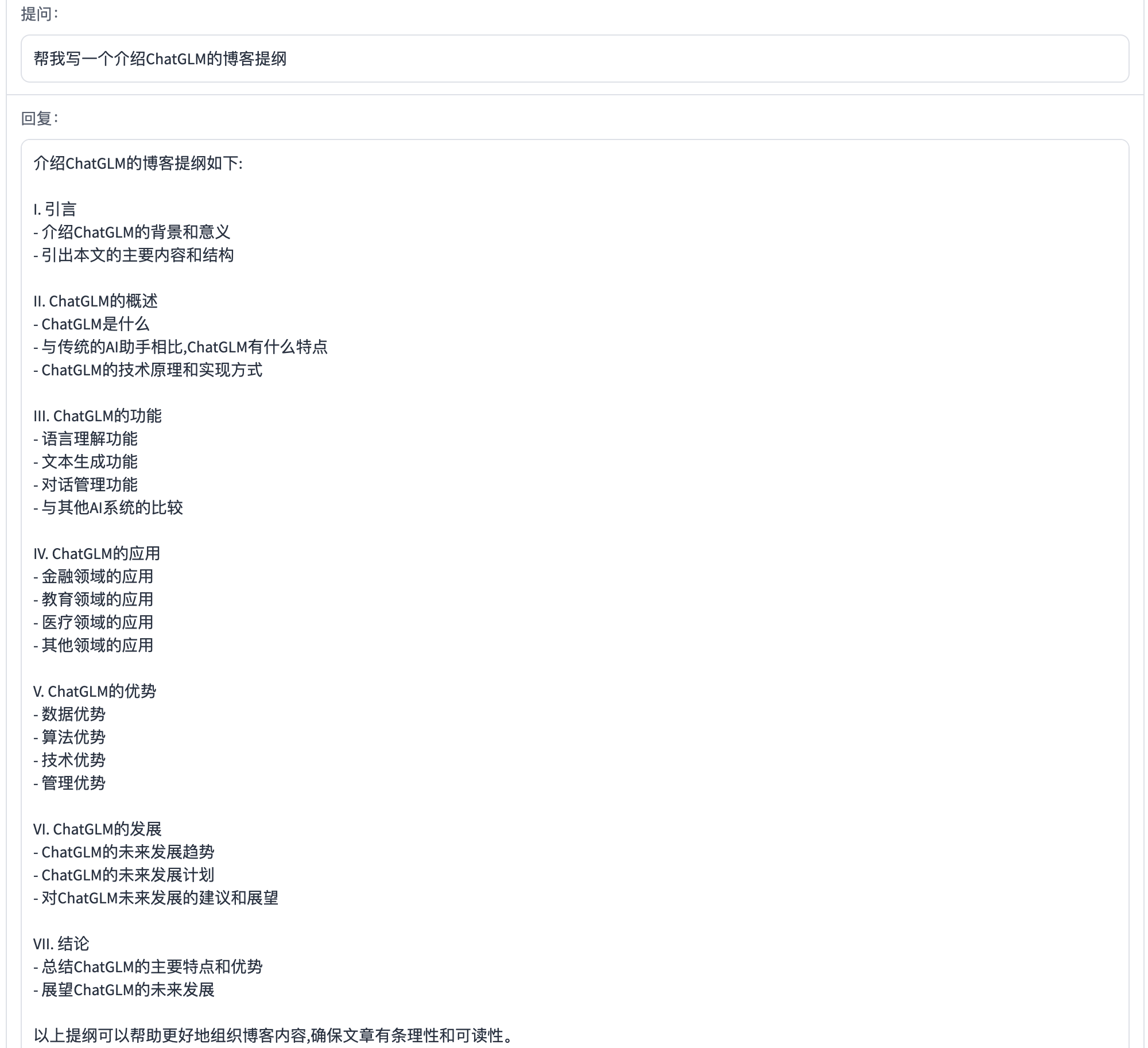

examples/blog-outline.png

0 → 100644

162.3 KB

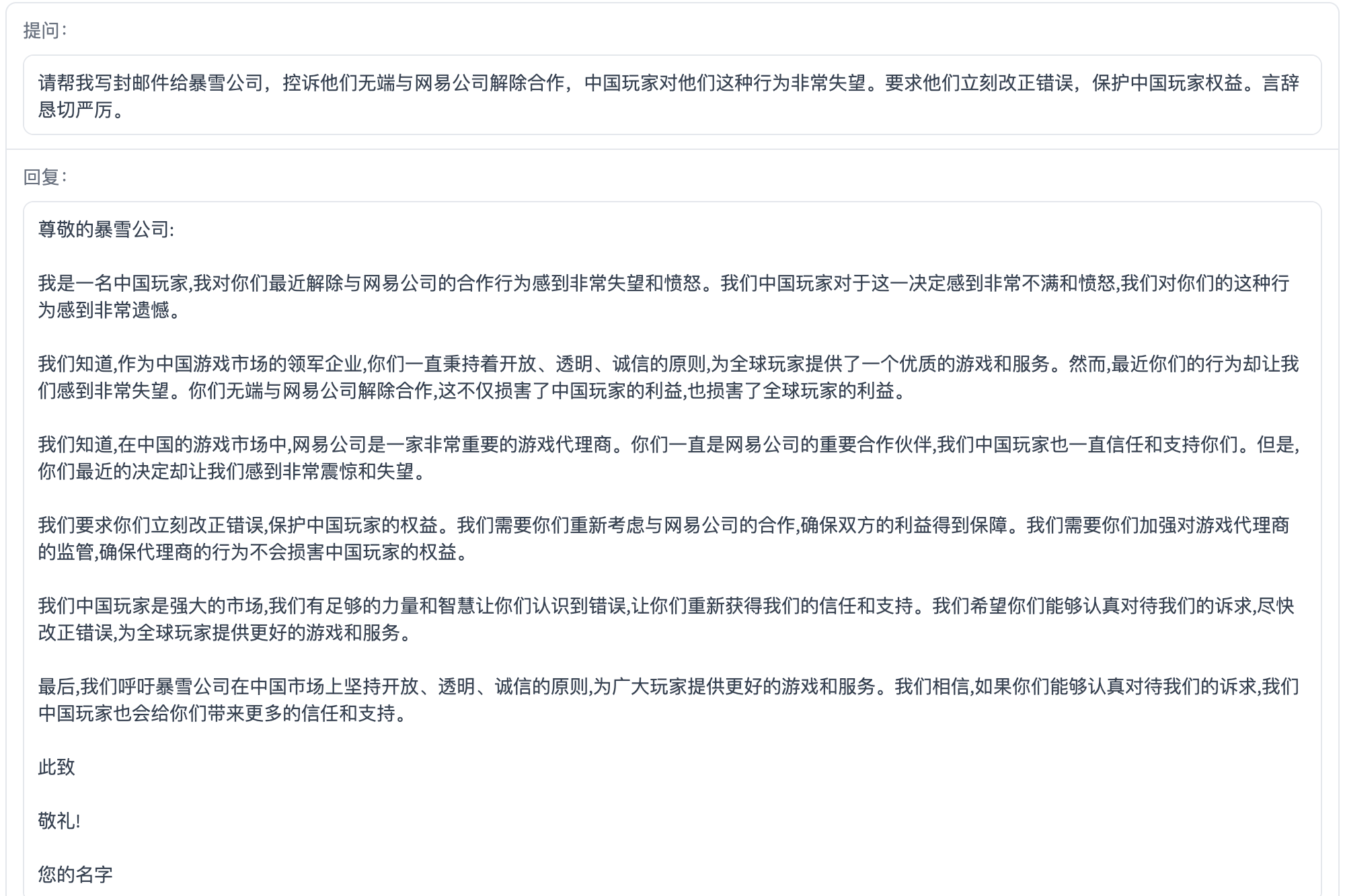

examples/comments-writing.png

0 → 100644

260.1 KB

examples/email-writing-1.png

0 → 100644

230.4 KB

examples/email-writing-2.png

0 → 100644

224.0 KB

130.9 KB

examples/role-play.png

0 → 100644

278.5 KB

examples/self-introduction.png

0 → 100644

231.2 KB

examples/sport.png

0 → 100644

291.5 KB

examples/tour-guide.png

0 → 100644

331.5 KB