Commits (5)

Showing

510.2 KB

510.2 KB

56.0 KB

471 字节

14.4 KB

1.6 KB

1.3 KB

2.6 KB

56.4 KB

16.0 KB

24.6 KB

2.4 KB

1021 字节

22.6 KB

23.4 KB

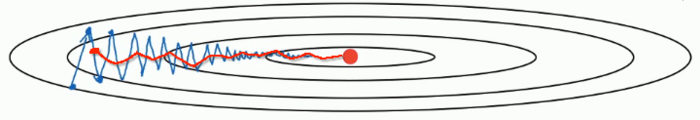

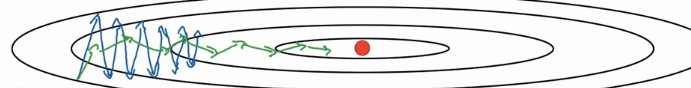

dl/Regularization.assets/640.png

0 → 100644

2.2 KB

49.7 KB

7.4 KB

22.7 KB

14.3 KB

5.5 KB

109.8 KB

12.4 KB

71.7 KB

73.0 KB

45.4 KB

714.0 KB

893.1 KB

dl/regularization.md

0 → 100644