调整目录结构+更新文档

Showing

Day66-70/66.数据分析概述.md

已删除

100644 → 0

Day66-70/68.Pandas的应用.md

已删除

100644 → 0

Day66-70/69.数据可视化.md

已删除

100644 → 0

Day66-70/70.数据分析项目实战.md

已删除

100644 → 0

Day66-70/code/Day69.ipynb

已删除

100644 → 0

Day66-70/code/Day70.ipynb

已删除

100644 → 0

Day66-80/66.数据分析概述.md

0 → 100644

Day66-80/67.环境准备.md

0 → 100644

Day66-80/69.NumPy的应用-2.md

0 → 100644

Day66-80/70.Pandas的应用-1.md

0 → 100644

Day66-80/71.Pandas的应用-2.md

0 → 100644

Day66-80/72.Pandas的应用-3.md

0 → 100644

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

Day71-85/81.Kaggle项目实战.md

已删除

100644 → 0

Day71-85/82.天池大数据项目实战.md

已删除

100644 → 0

Day71-85/84.推荐系统实战-2.md

已删除

100644 → 0

Day71-85/85.推荐系统实战-3.md

已删除

100644 → 0

Day86-90/86.大数据概述.md

已删除

100644 → 0

Day86-90/87.Hive简介.md

已删除

100644 → 0

Day86-90/88.PySpark和离线数据处理.md

已删除

100644 → 0

Day86-90/89.Flink和流式数据处理.md

已删除

100644 → 0

Day86-90/90.大数据分析项目实战.md

已删除

100644 → 0

66.7 KB

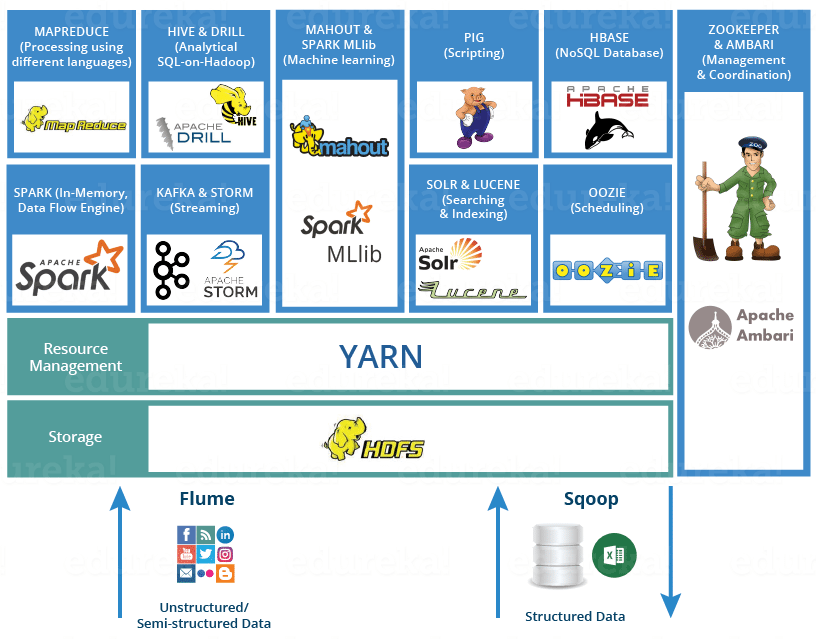

Day86-90/res/bigdata-env.png

已删除

100644 → 0

76.2 KB

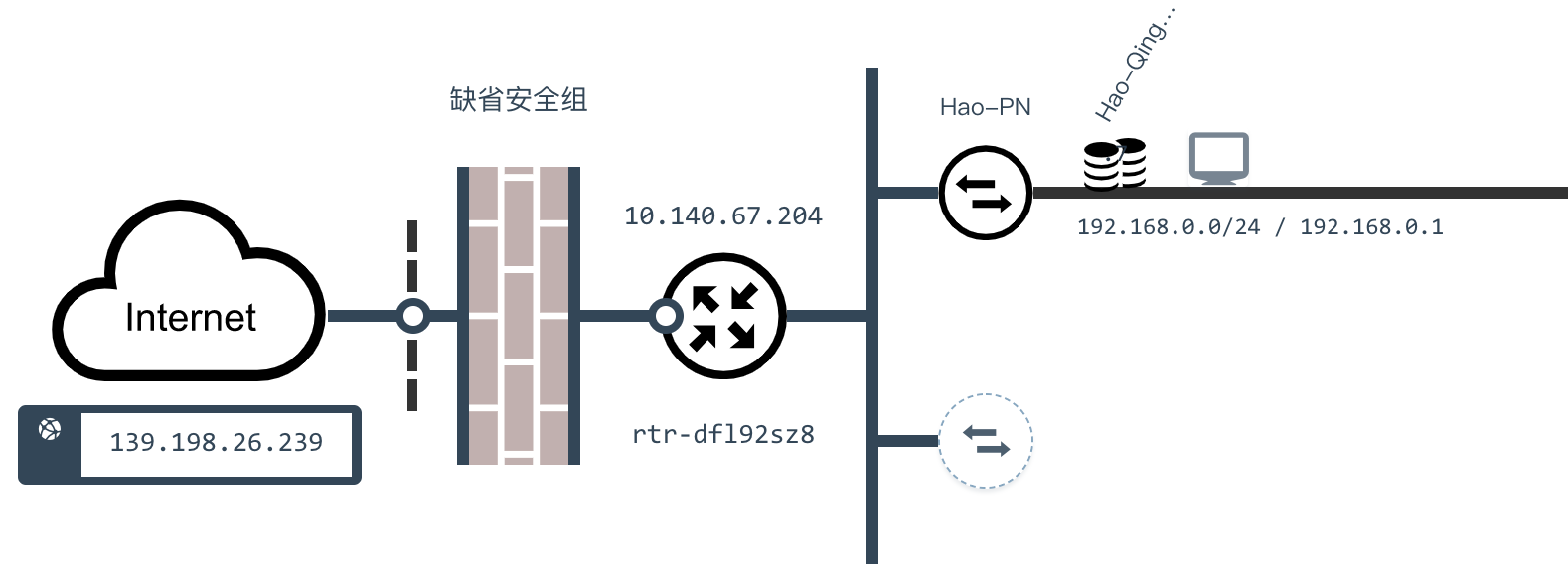

Day86-90/res/bigdata-vpc.png

已删除

100644 → 0

84.7 KB

58.3 KB