Fix gan readme (#2565)

* Update README.md

Showing

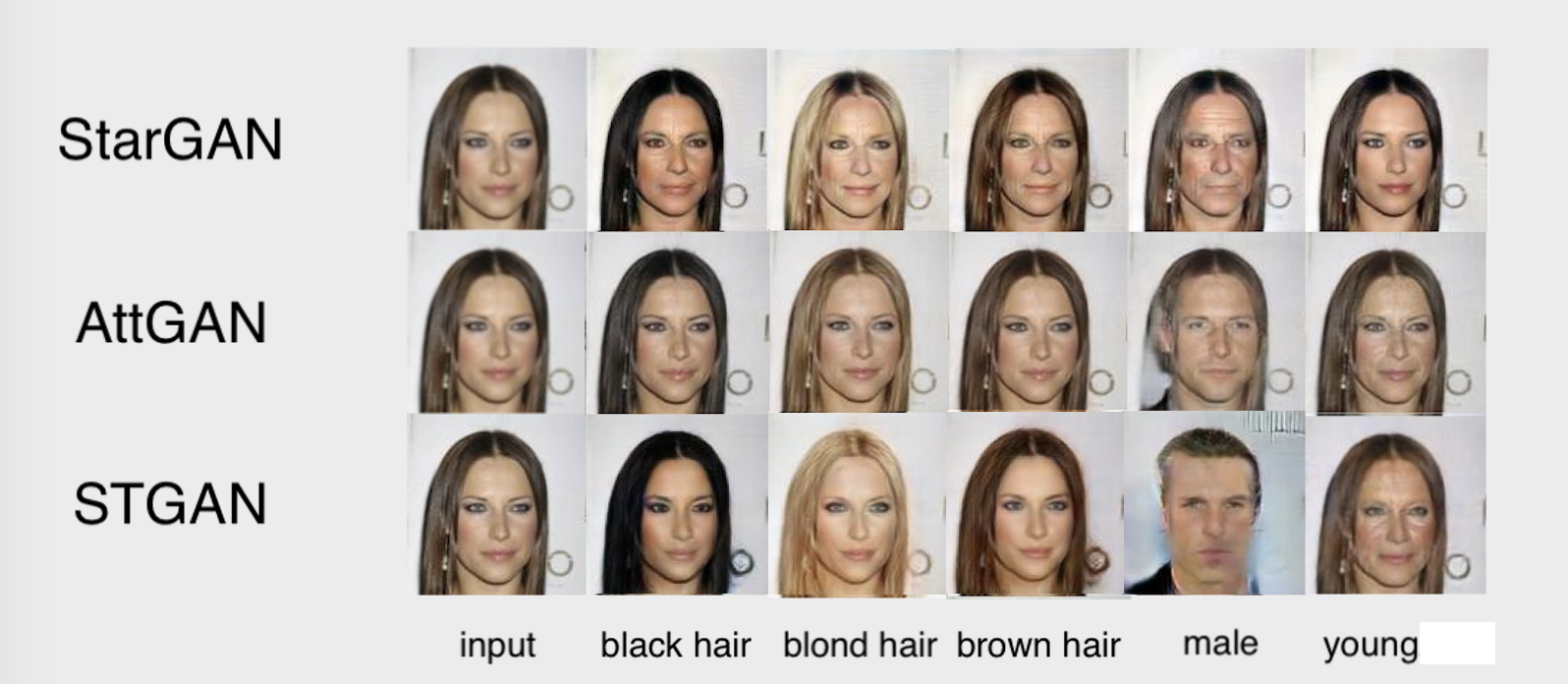

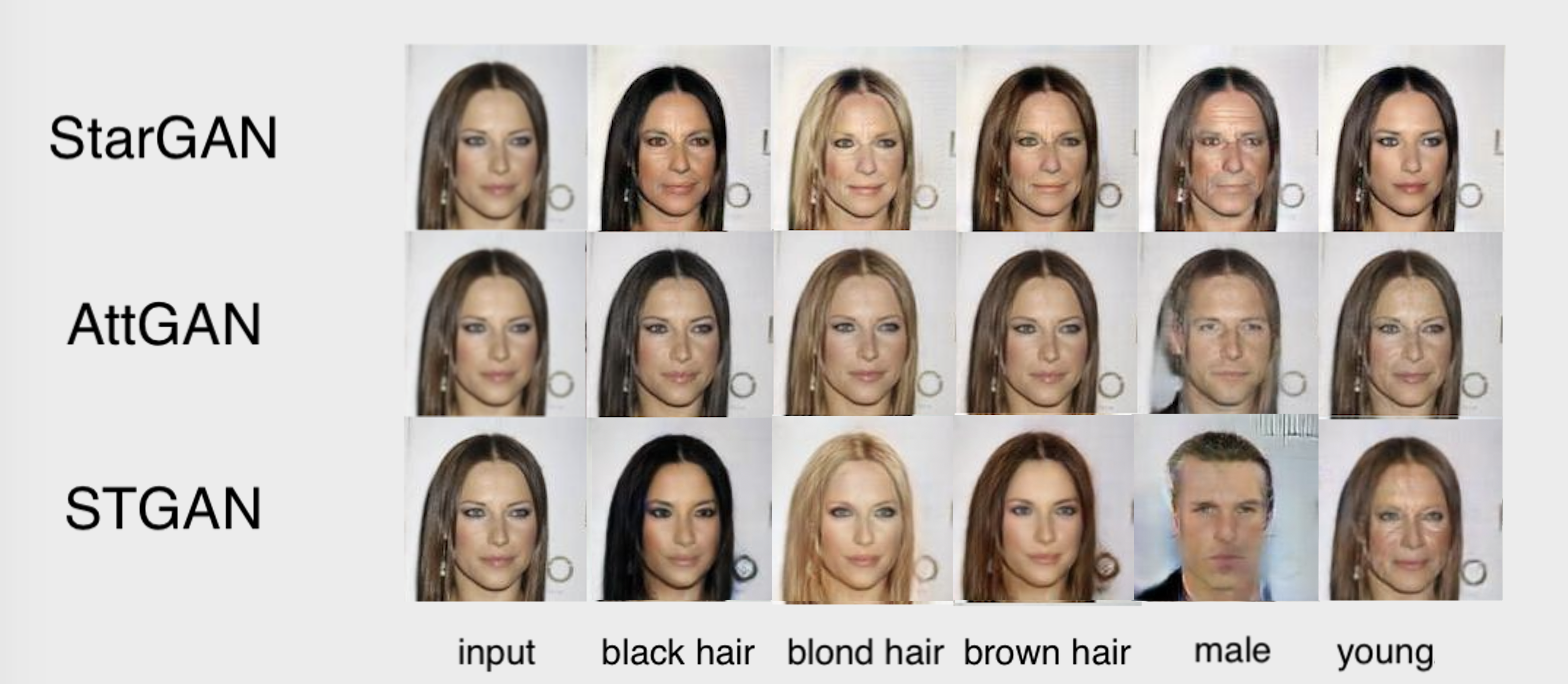

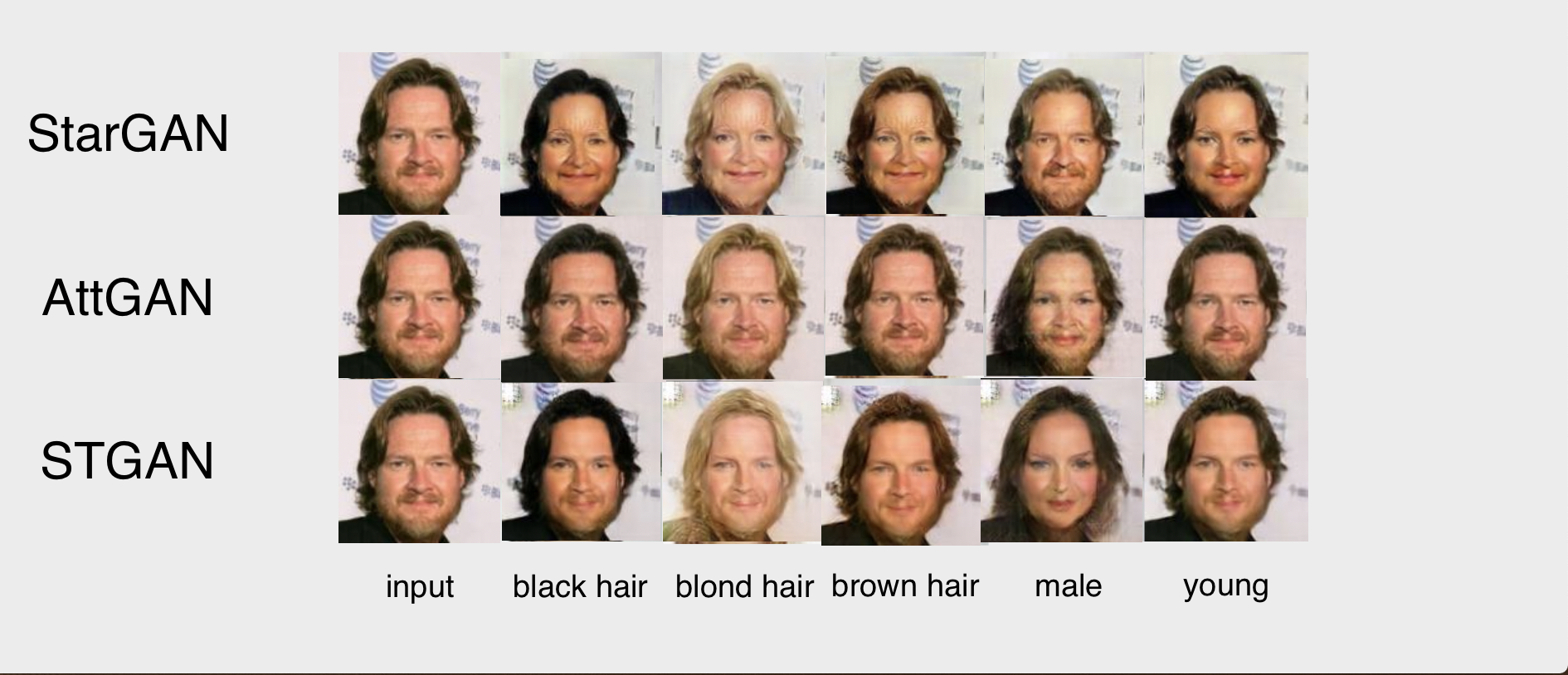

PaddleCV/gan/images/StarAttST.png

0 → 100644

1021.6 KB

117.0 KB

1.2 MB

1.4 MB

1.8 MB

31.8 KB

87.9 KB

150.1 KB

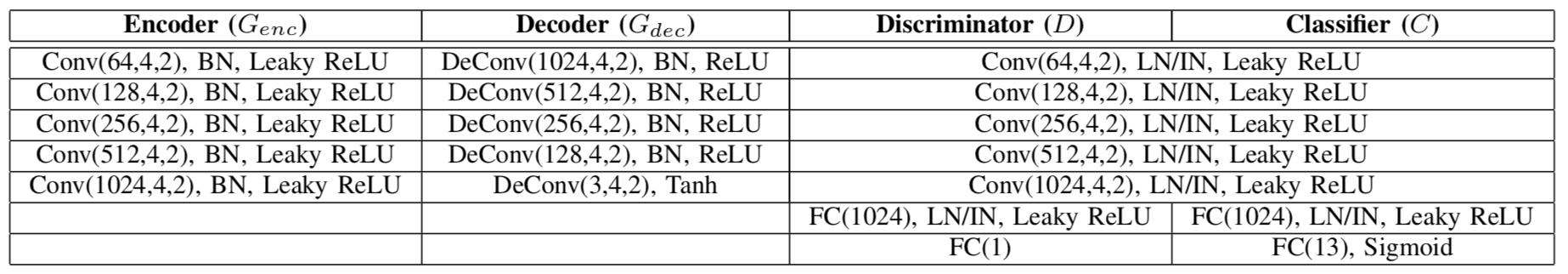

PaddleCV/gan/images/stgan_net.png

0 → 100644

481.8 KB