"update README, add more comment to code"

Showing

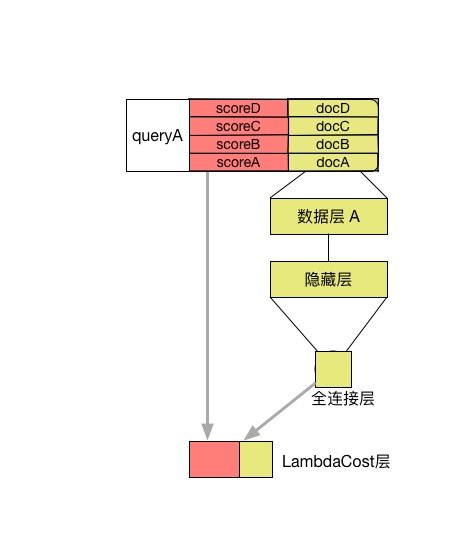

ltr/lambdarank.jpg

0 → 100644

26.0 KB

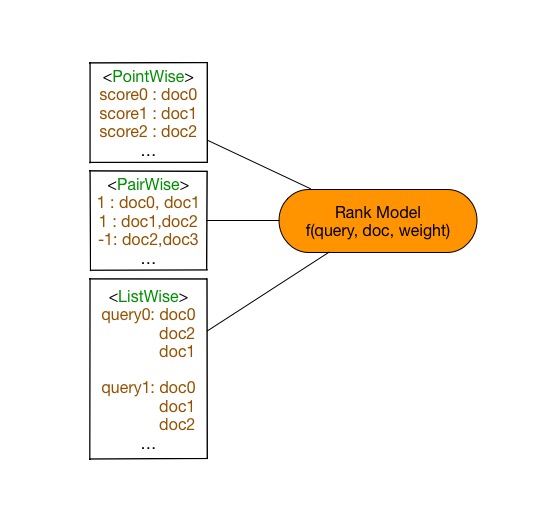

ltr/learningToRank.jpg

0 → 100644

35.6 KB

ltr/metrics.py

0 → 100644

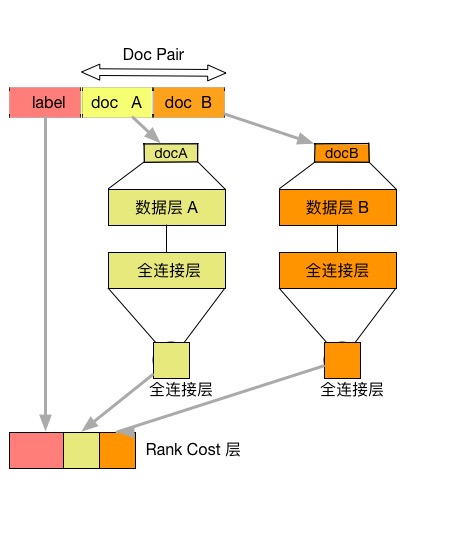

ltr/ranknet.jpg

0 → 100644

35.1 KB

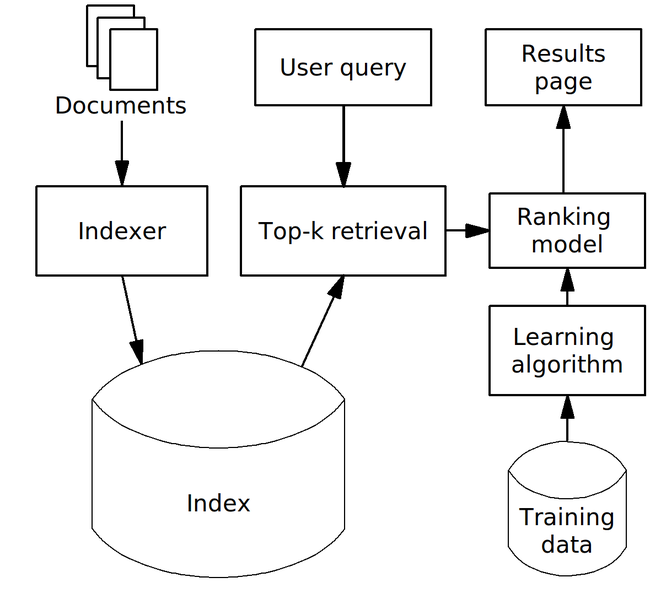

ltr/search-engine-example.png

0 → 100644

79.4 KB