-# 线性回归

-让我们从经典的线性回归(Linear Regression \[[1](#参考文献)\])模型开始这份教程。在这一章里,你将使用真实的数据集建立起一个房价预测模型,并且了解到机器学习中的若干重要概念。

-

-本教程源代码目录在[book/fit_a_line](https://github.com/PaddlePaddle/book/tree/develop/01.fit_a_line), 初次使用请参考PaddlePaddle[安装教程](https://github.com/PaddlePaddle/book/blob/develop/README.cn.md#运行这本书),更多内容请参考本教程的[视频课堂](http://bit.baidu.com/course/detail/id/137.html)。

-

-## 背景介绍

-给定一个大小为$n$的数据集 ${\{y_{i}, x_{i1}, ..., x_{id}\}}_{i=1}^{n}$,其中$x_{i1}, \ldots, x_{id}$是第$i$个样本$d$个属性上的取值,$y_i$是该样本待预测的目标。线性回归模型假设目标$y_i$可以被属性间的线性组合描述,即

-

-$$y_i = \omega_1x_{i1} + \omega_2x_{i2} + \ldots + \omega_dx_{id} + b, i=1,\ldots,n$$

-

-例如,在我们将要建模的房价预测问题里,$x_{ij}$是描述房子$i$的各种属性(比如房间的个数、周围学校和医院的个数、交通状况等),而 $y_i$是房屋的价格。

-

-初看起来,这个假设实在过于简单了,变量间的真实关系很难是线性的。但由于线性回归模型有形式简单和易于建模分析的优点,它在实际问题中得到了大量的应用。很多经典的统计学习、机器学习书籍\[[2,3,4](#参考文献)\]也选择对线性模型独立成章重点讲解。

-

-## 效果展示

-我们使用从[UCI Housing Data Set](https://archive.ics.uci.edu/ml/datasets/Housing)获得的波士顿房价数据集进行模型的训练和预测。下面的散点图展示了使用模型对部分房屋价格进行的预测。其中,每个点的横坐标表示同一类房屋真实价格的中位数,纵坐标表示线性回归模型根据特征预测的结果,当二者值完全相等的时候就会落在虚线上。所以模型预测得越准确,则点离虚线越近。

-

-

- 图1. 预测值 V.S. 真实值

-

-

-## 模型概览

-

-### 模型定义

-

-在波士顿房价数据集中,和房屋相关的值共有14个:前13个用来描述房屋相关的各种信息,即模型中的 $x_i$;最后一个值为我们要预测的该类房屋价格的中位数,即模型中的 $y_i$。因此,我们的模型就可以表示成:

-

-$$\hat{Y} = \omega_1X_{1} + \omega_2X_{2} + \ldots + \omega_{13}X_{13} + b$$

-

-$\hat{Y}$ 表示模型的预测结果,用来和真实值$Y$区分。模型要学习的参数即:$\omega_1, \ldots, \omega_{13}, b$。

-

-建立模型后,我们需要给模型一个优化目标,使得学到的参数能够让预测值$\hat{Y}$尽可能地接近真实值$Y$。这里我们引入损失函数([Loss Function](https://en.wikipedia.org/wiki/Loss_function),或Cost Function)这个概念。 输入任意一个数据样本的目标值$y_{i}$和模型给出的预测值$\hat{y_{i}}$,损失函数输出一个非负的实值。这个实值通常用来反映模型误差的大小。

-

-对于线性回归模型来讲,最常见的损失函数就是均方误差(Mean Squared Error, [MSE](https://en.wikipedia.org/wiki/Mean_squared_error))了,它的形式是:

-

-$$MSE=\frac{1}{n}\sum_{i=1}^{n}{(\hat{Y_i}-Y_i)}^2$$

-

-即对于一个大小为$n$的测试集,$MSE$是$n$个数据预测结果误差平方的均值。

-

-### 训练过程

-

-定义好模型结构之后,我们要通过以下几个步骤进行模型训练

- 1. 初始化参数,其中包括权重$\omega_i$和偏置$b$,对其进行初始化(如0均值,1方差)。

- 2. 网络正向传播计算网络输出和损失函数。

- 3. 根据损失函数进行反向误差传播 ([backpropagation](https://en.wikipedia.org/wiki/Backpropagation)),将网络误差从输出层依次向前传递, 并更新网络中的参数。

- 4. 重复2~3步骤,直至网络训练误差达到规定的程度或训练轮次达到设定值。

-

-## 数据集

-

-### 数据集介绍

-这份数据集共506行,每行包含了波士顿郊区的一类房屋的相关信息及该类房屋价格的中位数。其各维属性的意义如下:

-

-| 属性名 | 解释 | 类型 |

-| ------| ------ | ------ |

-| CRIM | 该镇的人均犯罪率 | 连续值 |

-| ZN | 占地面积超过25,000平方呎的住宅用地比例 | 连续值 |

-| INDUS | 非零售商业用地比例 | 连续值 |

-| CHAS | 是否邻近 Charles River | 离散值,1=邻近;0=不邻近 |

-| NOX | 一氧化氮浓度 | 连续值 |

-| RM | 每栋房屋的平均客房数 | 连续值 |

-| AGE | 1940年之前建成的自用单位比例 | 连续值 |

-| DIS | 到波士顿5个就业中心的加权距离 | 连续值 |

-| RAD | 到径向公路的可达性指数 | 连续值 |

-| TAX | 全值财产税率 | 连续值 |

-| PTRATIO | 学生与教师的比例 | 连续值 |

-| B | 1000(BK - 0.63)^2,其中BK为黑人占比 | 连续值 |

-| LSTAT | 低收入人群占比 | 连续值 |

-| MEDV | 同类房屋价格的中位数 | 连续值 |

-

-### 数据预处理

-#### 连续值与离散值

-观察一下数据,我们的第一个发现是:所有的13维属性中,有12维的连续值和1维的离散值(CHAS)。离散值虽然也常使用类似0、1、2这样的数字表示,但是其含义与连续值是不同的,因为这里的差值没有实际意义。例如,我们用0、1、2来分别表示红色、绿色和蓝色的话,我们并不能因此说“蓝色和红色”比“绿色和红色”的距离更远。所以通常对一个有$d$个可能取值的离散属性,我们会将它们转为$d$个取值为0或1的二值属性或者将每个可能取值映射为一个多维向量。不过就这里而言,因为CHAS本身就是一个二值属性,就省去了这个麻烦。

-

-#### 属性的归一化

-另外一个稍加观察即可发现的事实是,各维属性的取值范围差别很大(如图2所示)。例如,属性B的取值范围是[0.32, 396.90],而属性NOX的取值范围是[0.3850, 0.8170]。这里就要用到一个常见的操作-归一化(normalization)了。归一化的目标是把各位属性的取值范围放缩到差不多的区间,例如[-0.5,0.5]。这里我们使用一种很常见的操作方法:减掉均值,然后除以原取值范围。

-

-做归一化(或 [Feature scaling](https://en.wikipedia.org/wiki/Feature_scaling))至少有以下3个理由:

-- 过大或过小的数值范围会导致计算时的浮点上溢或下溢。

-- 不同的数值范围会导致不同属性对模型的重要性不同(至少在训练的初始阶段如此),而这个隐含的假设常常是不合理的。这会对优化的过程造成困难,使训练时间大大的加长。

-- 很多的机器学习技巧/模型(例如L1,L2正则项,向量空间模型-Vector Space Model)都基于这样的假设:所有的属性取值都差不多是以0为均值且取值范围相近的。

-

-

-

- 图2. 各维属性的取值范围

-

-

-#### 整理训练集与测试集

-我们将数据集分割为两份:一份用于调整模型的参数,即进行模型的训练,模型在这份数据集上的误差被称为**训练误差**;另外一份被用来测试,模型在这份数据集上的误差被称为**测试误差**。我们训练模型的目的是为了通过从训练数据中找到规律来预测未知的新数据,所以测试误差是更能反映模型表现的指标。分割数据的比例要考虑到两个因素:更多的训练数据会降低参数估计的方差,从而得到更可信的模型;而更多的测试数据会降低测试误差的方差,从而得到更可信的测试误差。我们这个例子中设置的分割比例为$8:2$

-

-

-在更复杂的模型训练过程中,我们往往还会多使用一种数据集:验证集。因为复杂的模型中常常还有一些超参数([Hyperparameter](https://en.wikipedia.org/wiki/Hyperparameter_optimization))需要调节,所以我们会尝试多种超参数的组合来分别训练多个模型,然后对比它们在验证集上的表现选择相对最好的一组超参数,最后才使用这组参数下训练的模型在测试集上评估测试误差。由于本章训练的模型比较简单,我们暂且忽略掉这个过程。

-

-## 训练

-

-`fit_a_line/trainer.py`演示了训练的整体过程。

-

-### 配置数据提供器(Datafeeder)

-首先我们引入必要的库:

-```python

-import paddle

-import paddle.fluid as fluid

-import numpy

-from __future__ import print_function

-```

-

-我们通过uci_housing模块引入了数据集合[UCI Housing Data Set](https://archive.ics.uci.edu/ml/datasets/Housing)

-

-其中,在uci_housing模块中封装了:

-

-1. 数据下载的过程。下载数据保存在~/.cache/paddle/dataset/uci_housing/housing.data。

-2. [数据预处理](#数据预处理)的过程。

-

-接下来我们定义了用于训练和测试的数据提供器。提供器每次读入一个大小为`BATCH_SIZE`的数据批次。如果用户希望加一些随机性,她可以同时定义一个批次大小和一个缓存大小。这样的话,每次数据提供器会从缓存中随机读取批次大小那么多的数据。

-

-```python

-BATCH_SIZE = 20

-

-train_reader = paddle.batch(

- paddle.reader.shuffle(

- paddle.dataset.uci_housing.train(), buf_size=500),

- batch_size=BATCH_SIZE)

-

-test_reader = paddle.batch(

- paddle.reader.shuffle(

- paddle.dataset.uci_housing.test(), buf_size=500),

- batch_size=BATCH_SIZE)

-```

-

-### 配置训练程序

-训练程序的目的是定义一个训练模型的网络结构。对于线性回归来讲,它就是一个从输入到输出的简单的全连接层。更加复杂的结果,比如卷积神经网络,递归神经网络等会在随后的章节中介绍。训练程序必须返回`平均损失`作为第一个返回值,因为它会被后面反向传播算法所用到。

-

-```python

-def train_program():

- y = fluid.layers.data(name='y', shape=[1], dtype='float32')

-

- # feature vector of length 13

- x = fluid.layers.data(name='x', shape=[13], dtype='float32')

- y_predict = fluid.layers.fc(input=x, size=1, act=None)

-

- loss = fluid.layers.square_error_cost(input=y_predict, label=y)

- avg_loss = fluid.layers.mean(loss)

-

- return avg_loss

-```

-

-### Optimizer Function 配置

-

-在下面的 `SGD optimizer`,`learning_rate` 是训练的速度,与网络的训练收敛速度有关系。

-

-```python

-def optimizer_program():

- return fluid.optimizer.SGD(learning_rate=0.001)

-```

-

-### 定义运算场所

-我们可以定义运算是发生在CPU还是GPU

-

-```python

-use_cuda = False

-place = fluid.CUDAPlace(0) if use_cuda else fluid.CPUPlace()

-```

-

-### 创建训练器

-训练器会读入一个训练程序和一些必要的其他参数:

-

-```python

-trainer = fluid.Trainer(

- train_func=train_program,

- place=place,

- optimizer_func=optimizer_program)

-```

-

-### 开始提供数据

-PaddlePaddle提供了读取数据者发生器机制来读取训练数据。读取数据者会一次提供多列数据,因此我们需要一个Python的list来定义读取顺序。

-

-```python

-feed_order=['x', 'y']

-```

-

-除此之外,可以定义一个事件相应器来处理类似`打印训练进程`的事件:

-

-```python

-# Specify the directory to save the parameters

-params_dirname = "fit_a_line.inference.model"

-

-# Plot data

-from paddle.v2.plot import Ploter

-train_title = "Train cost"

-test_title = "Test cost"

-plot_cost = Ploter(train_title, test_title)

-

-step = 0

-

-# event_handler prints training and testing info

-def event_handler_plot(event):

- global step

- if isinstance(event, fluid.EndStepEvent):

- if step % 10 == 0: # record a train cost every 10 batches

- plot_cost.append(train_title, step, event.metrics[0])

-

- if step % 100 == 0: # record a test cost every 100 batches

- test_metrics = trainer.test(

- reader=test_reader, feed_order=feed_order)

- plot_cost.append(test_title, step, test_metrics[0])

- plot_cost.plot()

-

- if test_metrics[0] < 10.0:

- # If the accuracy is good enough, we can stop the training.

- print('loss is less than 10.0, stop')

- trainer.stop()

- step += 1

-

- if isinstance(event, fluid.EndEpochEvent):

- if event.epoch % 10 == 0:

- # We can save the trained parameters for the inferences later

- if params_dirname is not None:

- trainer.save_params(params_dirname)

-```

-

-### 开始训练

-我们现在可以通过调用`trainer.train()`来开始训练

-

-```python

-%matplotlib inline

-

-# The training could take up to a few minutes.

-trainer.train(

- reader=train_reader,

- num_epochs=100,

- event_handler=event_handler_plot,

- feed_order=feed_order)

-```

-

-

-

-## 预测

-提供一个`inference_program`和一个`params_dirname`来初始化预测器。`params_dirname`用来存储我们的参数。

-

-### 设定预测程序

-类似于`trainer.train`,预测器需要一个预测程序来做预测。我们可以稍加修改我们的训练程序来把预测值包含进来。

-

-

-```python

-def inference_program():

- x = fluid.layers.data(name='x', shape=[13], dtype='float32')

- y_predict = fluid.layers.fc(input=x, size=1, act=None)

- return y_predict

-```

-

-### 预测

-预测器会从`params_dirname`中读取已经训练好的模型,来对从未遇见过的数据进行预测。

-

-```python

-inferencer = fluid.Inferencer(

- infer_func=inference_program, param_path=params_dirname, place=place)

-

-batch_size = 10

-test_reader = paddle.batch(paddle.dataset.uci_housing.test(),batch_size=batch_size)

-test_data = test_reader().next()

-test_x = numpy.array([data[0] for data in test_data]).astype("float32")

-test_y = numpy.array([data[1] for data in test_data]).astype("float32")

-

-results = inferencer.infer({'x': test_x})

-

-print("infer results: (House Price)")

-for idx, val in enumerate(results[0]):

- print("%d: %.2f" % (idx, val))

-

-print("\nground truth:")

-for idx, val in enumerate(test_y):

- print("%d: %.2f" % (idx, val))

-```

-

-## 总结

-在这章里,我们借助波士顿房价这一数据集,介绍了线性回归模型的基本概念,以及如何使用PaddlePaddle实现训练和测试的过程。很多的模型和技巧都是从简单的线性回归模型演化而来,因此弄清楚线性模型的原理和局限非常重要。

-

-

-## 参考文献

-1. https://en.wikipedia.org/wiki/Linear_regression

-2. Friedman J, Hastie T, Tibshirani R. The elements of statistical learning[M]. Springer, Berlin: Springer series in statistics, 2001.

-3. Murphy K P. Machine learning: a probabilistic perspective[M]. MIT press, 2012.

-4. Bishop C M. Pattern recognition[J]. Machine Learning, 2006, 128.

-

-

-

本教程

本教程 由

PaddlePaddle 创作,采用

知识共享 署名-相同方式共享 4.0 国际 许可协议进行许可。

+# 线性回归

+让我们从经典的线性回归(Linear Regression \[[1](#参考文献)\])模型开始这份教程。在这一章里,你将使用真实的数据集建立起一个房价预测模型,并且了解到机器学习中的若干重要概念。

+

+本教程源代码目录在[book/fit_a_line](https://github.com/PaddlePaddle/book/tree/develop/01.fit_a_line), 初次使用请参考PaddlePaddle[安装教程](https://github.com/PaddlePaddle/book/blob/develop/README.cn.md#运行这本书),更多内容请参考本教程的[视频课堂](http://bit.baidu.com/course/detail/id/137.html)。

+

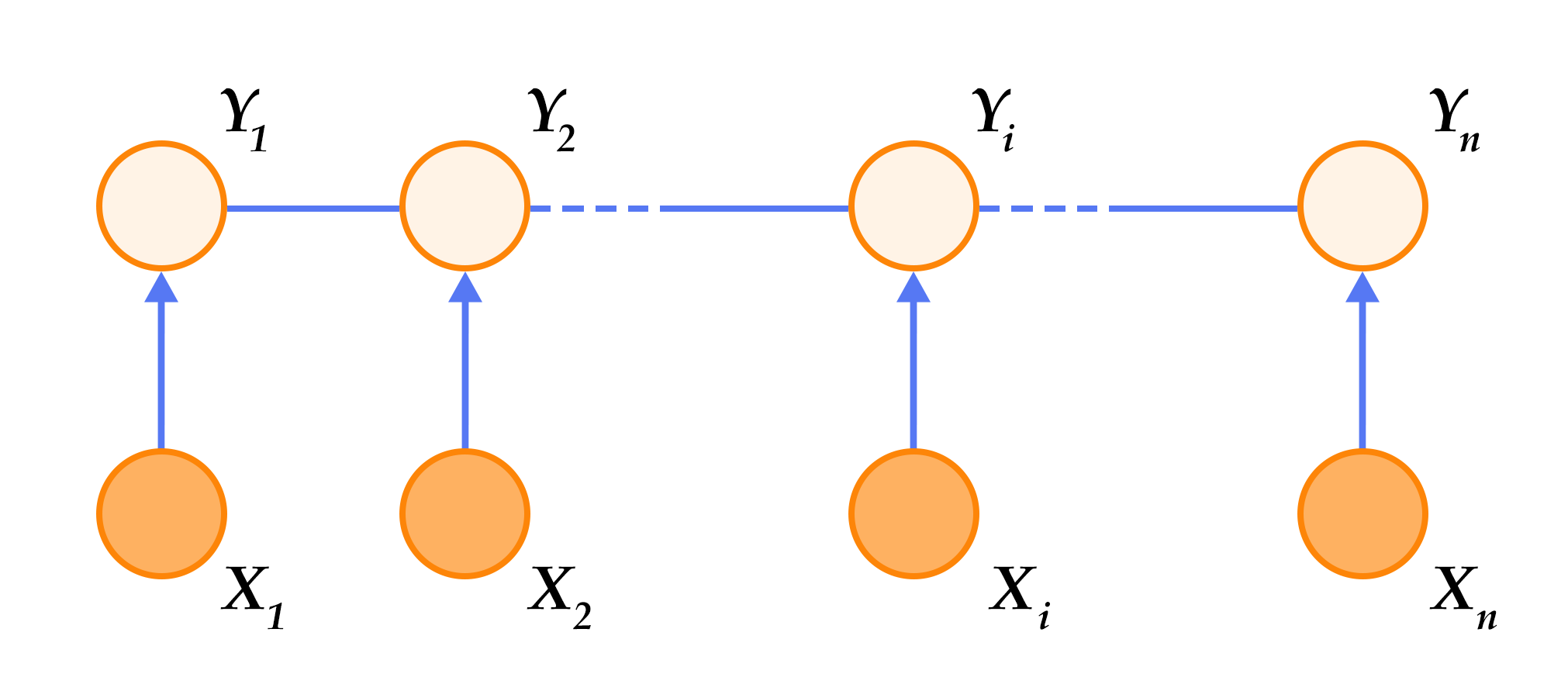

+## 背景介绍

+给定一个大小为$n$的数据集 ${\{y_{i}, x_{i1}, ..., x_{id}\}}_{i=1}^{n}$,其中$x_{i1}, \ldots, x_{id}$是第$i$个样本$d$个属性上的取值,$y_i$是该样本待预测的目标。线性回归模型假设目标$y_i$可以被属性间的线性组合描述,即

+

+$$y_i = \omega_1x_{i1} + \omega_2x_{i2} + \ldots + \omega_dx_{id} + b, i=1,\ldots,n$$

+

+例如,在我们将要建模的房价预测问题里,$x_{ij}$是描述房子$i$的各种属性(比如房间的个数、周围学校和医院的个数、交通状况等),而 $y_i$是房屋的价格。

+

+初看起来,这个假设实在过于简单了,变量间的真实关系很难是线性的。但由于线性回归模型有形式简单和易于建模分析的优点,它在实际问题中得到了大量的应用。很多经典的统计学习、机器学习书籍\[[2,3,4](#参考文献)\]也选择对线性模型独立成章重点讲解。

+

+## 效果展示

+我们使用从[UCI Housing Data Set](https://archive.ics.uci.edu/ml/datasets/Housing)获得的波士顿房价数据集进行模型的训练和预测。下面的散点图展示了使用模型对部分房屋价格进行的预测。其中,每个点的横坐标表示同一类房屋真实价格的中位数,纵坐标表示线性回归模型根据特征预测的结果,当二者值完全相等的时候就会落在虚线上。所以模型预测得越准确,则点离虚线越近。

+

+

+ 图1. 预测值 V.S. 真实值

+

+

+## 模型概览

+

+### 模型定义

+

+在波士顿房价数据集中,和房屋相关的值共有14个:前13个用来描述房屋相关的各种信息,即模型中的 $x_i$;最后一个值为我们要预测的该类房屋价格的中位数,即模型中的 $y_i$。因此,我们的模型就可以表示成:

+

+$$\hat{Y} = \omega_1X_{1} + \omega_2X_{2} + \ldots + \omega_{13}X_{13} + b$$

+

+$\hat{Y}$ 表示模型的预测结果,用来和真实值$Y$区分。模型要学习的参数即:$\omega_1, \ldots, \omega_{13}, b$。

+

+建立模型后,我们需要给模型一个优化目标,使得学到的参数能够让预测值$\hat{Y}$尽可能地接近真实值$Y$。这里我们引入损失函数([Loss Function](https://en.wikipedia.org/wiki/Loss_function),或Cost Function)这个概念。 输入任意一个数据样本的目标值$y_{i}$和模型给出的预测值$\hat{y_{i}}$,损失函数输出一个非负的实值。这个实值通常用来反映模型误差的大小。

+

+对于线性回归模型来讲,最常见的损失函数就是均方误差(Mean Squared Error, [MSE](https://en.wikipedia.org/wiki/Mean_squared_error))了,它的形式是:

+

+$$MSE=\frac{1}{n}\sum_{i=1}^{n}{(\hat{Y_i}-Y_i)}^2$$

+

+即对于一个大小为$n$的测试集,$MSE$是$n$个数据预测结果误差平方的均值。

+

+### 训练过程

+

+定义好模型结构之后,我们要通过以下几个步骤进行模型训练

+ 1. 初始化参数,其中包括权重$\omega_i$和偏置$b$,对其进行初始化(如0均值,1方差)。

+ 2. 网络正向传播计算网络输出和损失函数。

+ 3. 根据损失函数进行反向误差传播 ([backpropagation](https://en.wikipedia.org/wiki/Backpropagation)),将网络误差从输出层依次向前传递, 并更新网络中的参数。

+ 4. 重复2~3步骤,直至网络训练误差达到规定的程度或训练轮次达到设定值。

+

+## 数据集

+

+### 数据集介绍

+这份数据集共506行,每行包含了波士顿郊区的一类房屋的相关信息及该类房屋价格的中位数。其各维属性的意义如下:

+

+| 属性名 | 解释 | 类型 |

+| ------| ------ | ------ |

+| CRIM | 该镇的人均犯罪率 | 连续值 |

+| ZN | 占地面积超过25,000平方呎的住宅用地比例 | 连续值 |

+| INDUS | 非零售商业用地比例 | 连续值 |

+| CHAS | 是否邻近 Charles River | 离散值,1=邻近;0=不邻近 |

+| NOX | 一氧化氮浓度 | 连续值 |

+| RM | 每栋房屋的平均客房数 | 连续值 |

+| AGE | 1940年之前建成的自用单位比例 | 连续值 |

+| DIS | 到波士顿5个就业中心的加权距离 | 连续值 |

+| RAD | 到径向公路的可达性指数 | 连续值 |

+| TAX | 全值财产税率 | 连续值 |

+| PTRATIO | 学生与教师的比例 | 连续值 |

+| B | 1000(BK - 0.63)^2,其中BK为黑人占比 | 连续值 |

+| LSTAT | 低收入人群占比 | 连续值 |

+| MEDV | 同类房屋价格的中位数 | 连续值 |

+

+### 数据预处理

+#### 连续值与离散值

+观察一下数据,我们的第一个发现是:所有的13维属性中,有12维的连续值和1维的离散值(CHAS)。离散值虽然也常使用类似0、1、2这样的数字表示,但是其含义与连续值是不同的,因为这里的差值没有实际意义。例如,我们用0、1、2来分别表示红色、绿色和蓝色的话,我们并不能因此说“蓝色和红色”比“绿色和红色”的距离更远。所以通常对一个有$d$个可能取值的离散属性,我们会将它们转为$d$个取值为0或1的二值属性或者将每个可能取值映射为一个多维向量。不过就这里而言,因为CHAS本身就是一个二值属性,就省去了这个麻烦。

+

+#### 属性的归一化

+另外一个稍加观察即可发现的事实是,各维属性的取值范围差别很大(如图2所示)。例如,属性B的取值范围是[0.32, 396.90],而属性NOX的取值范围是[0.3850, 0.8170]。这里就要用到一个常见的操作-归一化(normalization)了。归一化的目标是把各位属性的取值范围放缩到差不多的区间,例如[-0.5,0.5]。这里我们使用一种很常见的操作方法:减掉均值,然后除以原取值范围。

+

+做归一化(或 [Feature scaling](https://en.wikipedia.org/wiki/Feature_scaling))至少有以下3个理由:

+- 过大或过小的数值范围会导致计算时的浮点上溢或下溢。

+- 不同的数值范围会导致不同属性对模型的重要性不同(至少在训练的初始阶段如此),而这个隐含的假设常常是不合理的。这会对优化的过程造成困难,使训练时间大大的加长。

+- 很多的机器学习技巧/模型(例如L1,L2正则项,向量空间模型-Vector Space Model)都基于这样的假设:所有的属性取值都差不多是以0为均值且取值范围相近的。

+

+

+

+ 图2. 各维属性的取值范围

+

+

+#### 整理训练集与测试集

+我们将数据集分割为两份:一份用于调整模型的参数,即进行模型的训练,模型在这份数据集上的误差被称为**训练误差**;另外一份被用来测试,模型在这份数据集上的误差被称为**测试误差**。我们训练模型的目的是为了通过从训练数据中找到规律来预测未知的新数据,所以测试误差是更能反映模型表现的指标。分割数据的比例要考虑到两个因素:更多的训练数据会降低参数估计的方差,从而得到更可信的模型;而更多的测试数据会降低测试误差的方差,从而得到更可信的测试误差。我们这个例子中设置的分割比例为$8:2$

+

+

+在更复杂的模型训练过程中,我们往往还会多使用一种数据集:验证集。因为复杂的模型中常常还有一些超参数([Hyperparameter](https://en.wikipedia.org/wiki/Hyperparameter_optimization))需要调节,所以我们会尝试多种超参数的组合来分别训练多个模型,然后对比它们在验证集上的表现选择相对最好的一组超参数,最后才使用这组参数下训练的模型在测试集上评估测试误差。由于本章训练的模型比较简单,我们暂且忽略掉这个过程。

+

+## 训练

+

+`fit_a_line/trainer.py`演示了训练的整体过程。

+

+### 配置数据提供器(Datafeeder)

+首先我们引入必要的库:

+```python

+import paddle

+import paddle.fluid as fluid

+import numpy

+from __future__ import print_function

+```

+

+我们通过uci_housing模块引入了数据集合[UCI Housing Data Set](https://archive.ics.uci.edu/ml/datasets/Housing)

+

+其中,在uci_housing模块中封装了:

+

+1. 数据下载的过程。下载数据保存在~/.cache/paddle/dataset/uci_housing/housing.data。

+2. [数据预处理](#数据预处理)的过程。

+

+接下来我们定义了用于训练和测试的数据提供器。提供器每次读入一个大小为`BATCH_SIZE`的数据批次。如果用户希望加一些随机性,她可以同时定义一个批次大小和一个缓存大小。这样的话,每次数据提供器会从缓存中随机读取批次大小那么多的数据。

+

+```python

+BATCH_SIZE = 20

+

+train_reader = paddle.batch(

+ paddle.reader.shuffle(

+ paddle.dataset.uci_housing.train(), buf_size=500),

+ batch_size=BATCH_SIZE)

+

+test_reader = paddle.batch(

+ paddle.reader.shuffle(

+ paddle.dataset.uci_housing.test(), buf_size=500),

+ batch_size=BATCH_SIZE)

+```

+

+### 配置训练程序

+训练程序的目的是定义一个训练模型的网络结构。对于线性回归来讲,它就是一个从输入到输出的简单的全连接层。更加复杂的结果,比如卷积神经网络,递归神经网络等会在随后的章节中介绍。训练程序必须返回`平均损失`作为第一个返回值,因为它会被后面反向传播算法所用到。

+

+```python

+def train_program():

+ y = fluid.layers.data(name='y', shape=[1], dtype='float32')

+

+ # feature vector of length 13

+ x = fluid.layers.data(name='x', shape=[13], dtype='float32')

+ y_predict = fluid.layers.fc(input=x, size=1, act=None)

+

+ loss = fluid.layers.square_error_cost(input=y_predict, label=y)

+ avg_loss = fluid.layers.mean(loss)

+

+ return avg_loss

+```

+

+### Optimizer Function 配置

+

+在下面的 `SGD optimizer`,`learning_rate` 是训练的速度,与网络的训练收敛速度有关系。

+

+```python

+def optimizer_program():

+ return fluid.optimizer.SGD(learning_rate=0.001)

+```

+

+### 定义运算场所

+我们可以定义运算是发生在CPU还是GPU

+

+```python

+use_cuda = False

+place = fluid.CUDAPlace(0) if use_cuda else fluid.CPUPlace()

+```

+

+### 创建训练器

+训练器会读入一个训练程序和一些必要的其他参数:

+

+```python

+trainer = fluid.Trainer(

+ train_func=train_program,

+ place=place,

+ optimizer_func=optimizer_program)

+```

+

+### 开始提供数据

+PaddlePaddle提供了读取数据者发生器机制来读取训练数据。读取数据者会一次提供多列数据,因此我们需要一个Python的list来定义读取顺序。

+

+```python

+feed_order=['x', 'y']

+```

+

+除此之外,可以定义一个事件相应器来处理类似`打印训练进程`的事件:

+

+```python

+# Specify the directory to save the parameters

+params_dirname = "fit_a_line.inference.model"

+

+# Plot data

+from paddle.v2.plot import Ploter

+train_title = "Train cost"

+test_title = "Test cost"

+plot_cost = Ploter(train_title, test_title)

+

+step = 0

+

+# event_handler prints training and testing info

+def event_handler_plot(event):

+ global step

+ if isinstance(event, fluid.EndStepEvent):

+ if step % 10 == 0: # record a train cost every 10 batches

+ plot_cost.append(train_title, step, event.metrics[0])

+

+ if step % 100 == 0: # record a test cost every 100 batches

+ test_metrics = trainer.test(

+ reader=test_reader, feed_order=feed_order)

+ plot_cost.append(test_title, step, test_metrics[0])

+ plot_cost.plot()

+

+ if test_metrics[0] < 10.0:

+ # If the accuracy is good enough, we can stop the training.

+ print('loss is less than 10.0, stop')

+ trainer.stop()

+ step += 1

+

+ if isinstance(event, fluid.EndEpochEvent):

+ if event.epoch % 10 == 0:

+ # We can save the trained parameters for the inferences later

+ if params_dirname is not None:

+ trainer.save_params(params_dirname)

+```

+

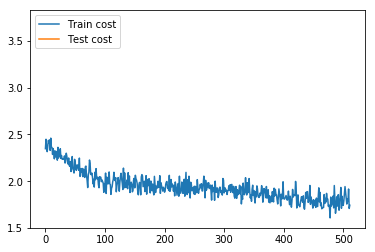

+### 开始训练

+我们现在可以通过调用`trainer.train()`来开始训练

+

+```python

+%matplotlib inline

+

+# The training could take up to a few minutes.

+trainer.train(

+ reader=train_reader,

+ num_epochs=100,

+ event_handler=event_handler_plot,

+ feed_order=feed_order)

+```

+

+

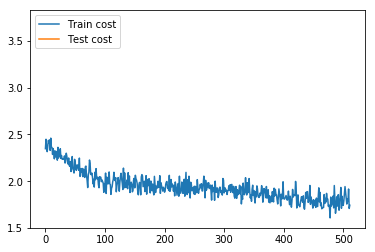

+图3 训练结果

+

+

+

+## 预测

+提供一个`inference_program`和一个`params_dirname`来初始化预测器。`params_dirname`用来存储我们的参数。

+

+### 设定预测程序

+类似于`trainer.train`,预测器需要一个预测程序来做预测。我们可以稍加修改我们的训练程序来把预测值包含进来。

+

+

+```python

+def inference_program():

+ x = fluid.layers.data(name='x', shape=[13], dtype='float32')

+ y_predict = fluid.layers.fc(input=x, size=1, act=None)

+ return y_predict

+```

+

+### 预测

+预测器会从`params_dirname`中读取已经训练好的模型,来对从未遇见过的数据进行预测。

+

+```python

+inferencer = fluid.Inferencer(

+ infer_func=inference_program, param_path=params_dirname, place=place)

+

+batch_size = 10

+test_reader = paddle.batch(paddle.dataset.uci_housing.test(),batch_size=batch_size)

+test_data = test_reader().next()

+test_x = numpy.array([data[0] for data in test_data]).astype("float32")

+test_y = numpy.array([data[1] for data in test_data]).astype("float32")

+

+results = inferencer.infer({'x': test_x})

+

+print("infer results: (House Price)")

+for idx, val in enumerate(results[0]):

+ print("%d: %.2f" % (idx, val))

+

+print("\nground truth:")

+for idx, val in enumerate(test_y):

+ print("%d: %.2f" % (idx, val))

+```

+

+## 总结

+在这章里,我们借助波士顿房价这一数据集,介绍了线性回归模型的基本概念,以及如何使用PaddlePaddle实现训练和测试的过程。很多的模型和技巧都是从简单的线性回归模型演化而来,因此弄清楚线性模型的原理和局限非常重要。

+

+

+## 参考文献

+1. https://en.wikipedia.org/wiki/Linear_regression

+2. Friedman J, Hastie T, Tibshirani R. The elements of statistical learning[M]. Springer, Berlin: Springer series in statistics, 2001.

+3. Murphy K P. Machine learning: a probabilistic perspective[M]. MIT press, 2012.

+4. Bishop C M. Pattern recognition[J]. Machine Learning, 2006, 128.

+

+

+

本教程

本教程 由

PaddlePaddle 创作,采用

知识共享 署名-相同方式共享 4.0 国际 许可协议进行许可。

-# 识别数字

-

-本教程源代码目录在[book/recognize_digits](https://github.com/PaddlePaddle/book/tree/develop/02.recognize_digits), 初次使用请参考PaddlePaddle[安装教程](https://github.com/PaddlePaddle/book/blob/develop/README.cn.md#运行这本书),更多内容请参考本教程的[视频课堂](http://bit.baidu.com/course/detail/id/167.html)。

-

-## 背景介绍

-当我们学习编程的时候,编写的第一个程序一般是实现打印"Hello World"。而机器学习(或深度学习)的入门教程,一般都是 [MNIST](http://yann.lecun.com/exdb/mnist/) 数据库上的手写识别问题。原因是手写识别属于典型的图像分类问题,比较简单,同时MNIST数据集也很完备。MNIST数据集作为一个简单的计算机视觉数据集,包含一系列如图1所示的手写数字图片和对应的标签。图片是28x28的像素矩阵,标签则对应着0~9的10个数字。每张图片都经过了大小归一化和居中处理。

-

-

-

-图1. MNIST图片示例

-

-

-MNIST数据集是从 [NIST](https://www.nist.gov/srd/nist-special-database-19) 的Special Database 3(SD-3)和Special Database 1(SD-1)构建而来。由于SD-3是由美国人口调查局的员工进行标注,SD-1是由美国高中生进行标注,因此SD-3比SD-1更干净也更容易识别。Yann LeCun等人从SD-1和SD-3中各取一半作为MNIST的训练集(60000条数据)和测试集(10000条数据),其中训练集来自250位不同的标注员,此外还保证了训练集和测试集的标注员是不完全相同的。

-

-Yann LeCun早先在手写字符识别上做了很多研究,并在研究过程中提出了卷积神经网络(Convolutional Neural Network),大幅度地提高了手写字符的识别能力,也因此成为了深度学习领域的奠基人之一。如今的深度学习领域,卷积神经网络占据了至关重要的地位,从最早Yann LeCun提出的简单LeNet,到如今ImageNet大赛上的优胜模型VGGNet、GoogLeNet、ResNet等(请参见[图像分类](https://github.com/PaddlePaddle/book/tree/develop/03.image_classification) 教程),人们在图像分类领域,利用卷积神经网络得到了一系列惊人的结果。

-

-有很多算法在MNIST上进行实验。1998年,LeCun分别用单层线性分类器、多层感知器(Multilayer Perceptron, MLP)和多层卷积神经网络LeNet进行实验,使得测试集上的误差不断下降(从12%下降到0.7%)\[[1](#参考文献)\]。此后,科学家们又基于K近邻(K-Nearest Neighbors)算法\[[2](#参考文献)\]、支持向量机(SVM)\[[3](#参考文献)\]、神经网络\[[4-7](#参考文献)\]和Boosting方法\[[8](#参考文献)\]等做了大量实验,并采用多种预处理方法(如去除歪曲、去噪、模糊等)来提高识别的准确率。

-

-本教程中,我们从简单的模型Softmax回归开始,带大家入门手写字符识别,并逐步进行模型优化。

-

-

-## 模型概览

-

-基于MNIST数据训练一个分类器,在介绍本教程使用的三个基本图像分类网络前,我们先给出一些定义:

-- $X$是输入:MNIST图片是$28\times28$ 的二维图像,为了进行计算,我们将其转化为$784$维向量,即$X=\left ( x_0, x_1, \dots, x_{783} \right )$。

-- $Y$是输出:分类器的输出是10类数字(0-9),即$Y=\left ( y_0, y_1, \dots, y_9 \right )$,每一维$y_i$代表图片分类为第$i$类数字的概率。

-- $L$是图片的真实标签:$L=\left ( l_0, l_1, \dots, l_9 \right )$也是10维,但只有一维为1,其他都为0。

-

-### Softmax回归(Softmax Regression)

-

-最简单的Softmax回归模型是先将输入层经过一个全连接层得到的特征,然后直接通过softmax 函数进行多分类\[[9](#参考文献)\]。

-

-输入层的数据$X$传到输出层,在激活操作之前,会乘以相应的权重 $W$ ,并加上偏置变量 $b$ ,具体如下:

-

-$$ y_i = \text{softmax}(\sum_j W_{i,j}x_j + b_i) $$

-

-其中 $ \text{softmax}(x_i) = \frac{e^{x_i}}{\sum_j e^{x_j}} $

-

-对于有 $N$ 个类别的多分类问题,指定 $N$ 个输出节点,$N$ 维结果向量经过softmax将归一化为 $N$ 个[0,1]范围内的实数值,分别表示该样本属于这 $N$ 个类别的概率。此处的 $y_i$ 即对应该图片为数字 $i$ 的预测概率。

-

-在分类问题中,我们一般采用交叉熵代价损失函数(cross entropy loss),公式如下:

-

-$$ \text{_L_

cross-entropy}(label, y) = -\sum_i label_ilog(y_i) $$

-

-图2为softmax回归的网络图,图中权重用蓝线表示、偏置用红线表示、+1代表偏置参数的系数为1。

-

-

-

-图2. softmax回归网络结构图

-

-

-### 多层感知器(Multilayer Perceptron, MLP)

-

-Softmax回归模型采用了最简单的两层神经网络,即只有输入层和输出层,因此其拟合能力有限。为了达到更好的识别效果,我们考虑在输入层和输出层中间加上若干个隐藏层\[[10](#参考文献)\]。

-

-1. 经过第一个隐藏层,可以得到 $ H_1 = \phi(W_1X + b_1) $,其中$\phi$代表激活函数,常见的有sigmoid、tanh或ReLU等函数。

-2. 经过第二个隐藏层,可以得到 $ H_2 = \phi(W_2H_1 + b_2) $。

-3. 最后,再经过输出层,得到的$Y=\text{softmax}(W_3H_2 + b_3)$,即为最后的分类结果向量。

-

-

-图3为多层感知器的网络结构图,图中权重用蓝线表示、偏置用红线表示、+1代表偏置参数的系数为1。

-

-

-

-图3. 多层感知器网络结构图

-

-

-### 卷积神经网络(Convolutional Neural Network, CNN)

-

-在多层感知器模型中,将图像展开成一维向量输入到网络中,忽略了图像的位置和结构信息,而卷积神经网络能够更好的利用图像的结构信息。[LeNet-5](http://yann.lecun.com/exdb/lenet/)是一个较简单的卷积神经网络。图4显示了其结构:输入的二维图像,先经过两次卷积层到池化层,再经过全连接层,最后使用softmax分类作为输出层。下面我们主要介绍卷积层和池化层。

-

-

-

-图4. LeNet-5卷积神经网络结构

-

-

-#### 卷积层

-

-卷积层是卷积神经网络的核心基石。在图像识别里我们提到的卷积是二维卷积,即离散二维滤波器(也称作卷积核)与二维图像做卷积操作,简单的讲是二维滤波器滑动到二维图像上所有位置,并在每个位置上与该像素点及其领域像素点做内积。卷积操作被广泛应用与图像处理领域,不同卷积核可以提取不同的特征,例如边沿、线性、角等特征。在深层卷积神经网络中,通过卷积操作可以提取出图像低级到复杂的特征。

-

-

-

-图5. 卷积层图片

-

-

-图5给出一个卷积计算过程的示例图,输入图像大小为$H=5,W=5,D=3$,即$5 \times 5$大小的3通道(RGB,也称作深度)彩色图像。这个示例图中包含两(用$K$表示)组卷积核,即图中滤波器$W_0$和$W_1$。在卷积计算中,通常对不同的输入通道采用不同的卷积核,如图示例中每组卷积核包含($D=3)$个$3 \times 3$(用$F \times F$表示)大小的卷积核。另外,这个示例中卷积核在图像的水平方向($W$方向)和垂直方向($H$方向)的滑动步长为2(用$S$表示);对输入图像周围各填充1(用$P$表示)个0,即图中输入层原始数据为蓝色部分,灰色部分是进行了大小为1的扩展,用0来进行扩展。经过卷积操作得到输出为$3 \times 3 \times 2$(用$H_{o} \times W_{o} \times K$表示)大小的特征图,即$3 \times 3$大小的2通道特征图,其中$H_o$计算公式为:$H_o = (H - F + 2 \times P)/S + 1$,$W_o$同理。 而输出特征图中的每个像素,是每组滤波器与输入图像每个特征图的内积再求和,再加上偏置$b_o$,偏置通常对于每个输出特征图是共享的。输出特征图$o[:,:,0]$中的最后一个$-2$计算如图5右下角公式所示。

-

-在卷积操作中卷积核是可学习的参数,经过上面示例介绍,每层卷积的参数大小为$D \times F \times F \times K$。在多层感知器模型中,神经元通常是全部连接,参数较多。而卷积层的参数较少,这也是由卷积层的主要特性即局部连接和共享权重所决定。

-

-- 局部连接:每个神经元仅与输入神经元的一块区域连接,这块局部区域称作感受野(receptive field)。在图像卷积操作中,即神经元在空间维度(spatial dimension,即上图示例H和W所在的平面)是局部连接,但在深度上是全部连接。对于二维图像本身而言,也是局部像素关联较强。这种局部连接保证了学习后的过滤器能够对于局部的输入特征有最强的响应。局部连接的思想,也是受启发于生物学里面的视觉系统结构,视觉皮层的神经元就是局部接受信息的。

-

-- 权重共享:计算同一个深度切片的神经元时采用的滤波器是共享的。例如图4中计算$o[:,:,0]$的每个每个神经元的滤波器均相同,都为$W_0$,这样可以很大程度上减少参数。共享权重在一定程度上讲是有意义的,例如图片的底层边缘特征与特征在图中的具体位置无关。但是在一些场景中是无意的,比如输入的图片是人脸,眼睛和头发位于不同的位置,希望在不同的位置学到不同的特征 (参考[斯坦福大学公开课]( http://cs231n.github.io/convolutional-networks/))。请注意权重只是对于同一深度切片的神经元是共享的,在卷积层,通常采用多组卷积核提取不同特征,即对应不同深度切片的特征,不同深度切片的神经元权重是不共享。另外,偏重对同一深度切片的所有神经元都是共享的。

-

-通过介绍卷积计算过程及其特性,可以看出卷积是线性操作,并具有平移不变性(shift-invariant),平移不变性即在图像每个位置执行相同的操作。卷积层的局部连接和权重共享使得需要学习的参数大大减小,这样也有利于训练较大卷积神经网络。

-

-#### 池化层

-

-

-

-图6. 池化层图片

-

-

-池化是非线性下采样的一种形式,主要作用是通过减少网络的参数来减小计算量,并且能够在一定程度上控制过拟合。通常在卷积层的后面会加上一个池化层。池化包括最大池化、平均池化等。其中最大池化是用不重叠的矩形框将输入层分成不同的区域,对于每个矩形框的数取最大值作为输出层,如图6所示。

-

-更详细的关于卷积神经网络的具体知识可以参考[斯坦福大学公开课]( http://cs231n.github.io/convolutional-networks/ )和[图像分类](https://github.com/PaddlePaddle/book/blob/develop/image_classification/README.md)教程。

-

-### 常见激活函数介绍

-- sigmoid激活函数: $ f(x) = sigmoid(x) = \frac{1}{1+e^{-x}} $

-

-- tanh激活函数: $ f(x) = tanh(x) = \frac{e^x-e^{-x}}{e^x+e^{-x}} $

-

- 实际上,tanh函数只是规模变化的sigmoid函数,将sigmoid函数值放大2倍之后再向下平移1个单位:tanh(x) = 2sigmoid(2x) - 1 。

-

-- ReLU激活函数: $ f(x) = max(0, x) $

-

-更详细的介绍请参考[维基百科激活函数](https://en.wikipedia.org/wiki/Activation_function)。

-

-## 数据介绍

-

-PaddlePaddle在API中提供了自动加载[MNIST](http://yann.lecun.com/exdb/mnist/)数据的模块`paddle.dataset.mnist`。加载后的数据位于`/home/username/.cache/paddle/dataset/mnist`下:

-

-

-| 文件名称 | 说明 |

-|----------------------|-------------------------|

-|train-images-idx3-ubyte| 训练数据图片,60,000条数据 |

-|train-labels-idx1-ubyte| 训练数据标签,60,000条数据 |

-|t10k-images-idx3-ubyte | 测试数据图片,10,000条数据 |

-|t10k-labels-idx1-ubyte | 测试数据标签,10,000条数据 |

-

-## Fluid API 概述

-

-演示将使用最新的 `Fluid API`。Fluid API是最新的 PaddlePaddle API。它在不牺牲性能的情况下简化了模型配置。

-我们建议使用 Fluid API,因为它更容易学起来。

-

-下面是快速的 Fluid API 概述。

-1. `inference_program`:指定如何从数据输入中获得预测的函数。

-这是指定网络流的地方。

-

-1. `train_program`:指定如何从 `inference_program` 和`标签值`中获取 `loss` 的函数。

-这是指定损失计算的地方。

-

-1. `optimizer_func`: “指定优化器配置的函数。优化器负责减少损失并驱动培训。Paddle 支持多种不同的优化器。

-

-1. `Trainer`:PaddlePaddle Trainer 管理由 `train_program` 和 `optimizer` 指定的训练过程。

-通过 `event_handler` 回调函数,用户可以监控培训的进展。

-

-1. `Inferencer`:Fluid inferencer 加载 `inference_program` 和由 Trainer 训练的参数。

-然后,它可以推断数据和返回预测。

-

-在这个演示中,我们将深入了解它们。

-

-## 配置说明

-加载 PaddlePaddle 的 Fluid API 包。

-

-```python

-import paddle

-import paddle.fluid as fluid

-from __future__ import print_function

-```

-

-### Program Functions 配置

-

-我们需要设置“推理程序”函数。我们想用这个程序来演示三个不同的分类器,每个分类器都定义为 Python 函数。

-我们需要将图像数据馈送到分类器。Paddle 为读取数据提供了一个特殊的层 `layer.data` 层。

-让我们创建一个数据层来读取图像并将其连接到分类网络。

-

-- Softmax回归:只通过一层简单的以softmax为激活函数的全连接层,就可以得到分类的结果。

-

-```python

-def softmax_regression():

- img = fluid.layers.data(name='img', shape=[1, 28, 28], dtype='float32')

- predict = fluid.layers.fc(

- input=img, size=10, act='softmax')

- return predict

-```

-

-- 多层感知器:下面代码实现了一个含有两个隐藏层(即全连接层)的多层感知器。其中两个隐藏层的激活函数均采用ReLU,输出层的激活函数用Softmax。

-

-```python

-def multilayer_perceptron():

- img = fluid.layers.data(name='img', shape=[1, 28, 28], dtype='float32')

- # 第一个全连接层,激活函数为ReLU

- hidden = fluid.layers.fc(input=img, size=200, act='relu')

- # 第二个全连接层,激活函数为ReLU

- hidden = fluid.layers.fc(input=hidden, size=200, act='relu')

- # 以softmax为激活函数的全连接输出层,输出层的大小必须为数字的个数10

- prediction = fluid.layers.fc(input=hidden, size=10, act='softmax')

- return prediction

-```

-

-- 卷积神经网络LeNet-5: 输入的二维图像,首先经过两次卷积层到池化层,再经过全连接层,最后使用以softmax为激活函数的全连接层作为输出层。

-

-```python

-def convolutional_neural_network():

- img = fluid.layers.data(name='img', shape=[1, 28, 28], dtype='float32')

- # 第一个卷积-池化层

- conv_pool_1 = fluid.nets.simple_img_conv_pool(

- input=img,

- filter_size=5,

- num_filters=20,

- pool_size=2,

- pool_stride=2,

- act="relu")

- conv_pool_1 = fluid.layers.batch_norm(conv_pool_1)

- # 第二个卷积-池化层

- conv_pool_2 = fluid.nets.simple_img_conv_pool(

- input=conv_pool_1,

- filter_size=5,

- num_filters=50,

- pool_size=2,

- pool_stride=2,

- act="relu")

- # 以softmax为激活函数的全连接输出层,输出层的大小必须为数字的个数10

- prediction = fluid.layers.fc(input=conv_pool_2, size=10, act='softmax')

- return prediction

-```

-

-#### Train Program 配置

-然后我们需要设置训练程序 `train_program`。它首先从分类器中进行预测。

-在训练期间,它将从预测中计算 `avg_cost`。

-

-**注意:** 训练程序应该返回一个数组,第一个返回参数必须是 `avg_cost`。训练器使用它来计算梯度。

-

-请随意修改代码,测试 Softmax 回归 `softmax_regression`, `MLP` 和 卷积神经网络 `convolutional neural network` 分类器之间的不同结果。

-

-```python

-def train_program():

- label = fluid.layers.data(name='label', shape=[1], dtype='int64')

-

- # predict = softmax_regression() # uncomment for Softmax回归

- # predict = multilayer_perceptron() # uncomment for 多层感知器

- predict = convolutional_neural_network() # uncomment for LeNet5卷积神经网络

- cost = fluid.layers.cross_entropy(input=predict, label=label)

- avg_cost = fluid.layers.mean(cost)

- acc = fluid.layers.accuracy(input=predict, label=label)

- return [avg_cost, acc]

-

-

-# 该模型运行在单个CPU上

-```

-

-#### Optimizer Function 配置

-

-在下面的 `Adam optimizer`,`learning_rate` 是训练的速度,与网络的训练收敛速度有关系。

-

-```python

-def optimizer_program():

- return fluid.optimizer.Adam(learning_rate=0.001)

-```

-

-### 数据集 Feeders 配置

-

-下一步,我们开始训练过程。`paddle.dataset.movielens.train()`和`paddle.dataset.movielens.test()`分别做训练和测试数据集。这两个函数各自返回一个reader——PaddlePaddle中的reader是一个Python函数,每次调用的时候返回一个Python yield generator。

-

-下面`shuffle`是一个reader decorator,它接受一个reader A,返回另一个reader B —— reader B 每次读入`buffer_size`条训练数据到一个buffer里,然后随机打乱其顺序,并且逐条输出。

-

-`batch`是一个特殊的decorator,它的输入是一个reader,输出是一个batched reader —— 在PaddlePaddle里,一个reader每次yield一条训练数据,而一个batched reader每次yield一个minibatch。

-

-```python

-train_reader = paddle.batch(

- paddle.reader.shuffle(

- paddle.dataset.mnist.train(), buf_size=500),

- batch_size=64)

-

-test_reader = paddle.batch(

- paddle.dataset.mnist.test(), batch_size=64)

-```

-

-### Trainer 配置

-

-现在,我们需要配置 `Trainer`。`Trainer` 需要接受训练程序 `train_program`, `place` 和优化器 `optimizer`。

-

-```python

-# 该模型运行在单个CPU上

-use_cuda = False # set to True if training with GPU

-place = fluid.CUDAPlace(0) if use_cuda else fluid.CPUPlace()

-

-trainer = fluid.Trainer(

- train_func=train_program, place=place, optimizer_func=optimizer_program)

- ```

-

-#### Event Handler 配置

-

-Fluid API 在训练期间为回调函数提供了一个钩子。用户能够通过机制监控培训进度。

-我们将在这里演示两个 `event_handler` 程序。请随意修改 Jupyter 笔记本 ,看看有什么不同。

-

-`event_handler` 用来在训练过程中输出训练结果

-

-```python

-# Save the parameter into a directory. The Inferencer can load the parameters from it to do infer

-params_dirname = "recognize_digits_network.inference.model"

-lists = []

-def event_handler(event):

- if isinstance(event, fluid.EndStepEvent):

- if event.step % 100 == 0:

- # event.metrics maps with train program return arguments.

- # event.metrics[0] will yeild avg_cost and event.metrics[1] will yeild acc in this example.

- print("Pass %d, Batch %d, Cost %f" % (

- event.step, event.epoch, event.metrics[0]))

-

- if isinstance(event, fluid.EndEpochEvent):

- avg_cost, acc = trainer.test(

- reader=test_reader, feed_order=['img', 'label'])

-

- print("Test with Epoch %d, avg_cost: %s, acc: %s" % (event.epoch, avg_cost, acc))

-

- # save parameters

- trainer.save_params(params_dirname)

- lists.append((event.epoch, avg_cost, acc))

-```

-

-`event_handler_plot` 可以用来在训练过程中画图如下:

-

-

-

-```python

-from paddle.v2.plot import Ploter

-

-train_title = "Train cost"

-test_title = "Test cost"

-cost_ploter = Ploter(train_title, test_title)

-step = 0

-lists = []

-

-# event_handler to plot a figure

-def event_handler_plot(event):

- global step

- if isinstance(event, fluid.EndStepEvent):

- if step % 100 == 0:

- # event.metrics maps with train program return arguments.

- # event.metrics[0] will yeild avg_cost and event.metrics[1] will yeild acc in this example.

- cost_ploter.append(train_title, step, event.metrics[0])

- cost_ploter.plot()

- step += 1

- if isinstance(event, fluid.EndEpochEvent):

- # save parameters

- trainer.save_params(params_dirname)

-

- avg_cost, acc = trainer.test(

- reader=test_reader, feed_order=['img', 'label'])

- cost_ploter.append(test_title, step, avg_cost)

- lists.append((event.epoch, avg_cost, acc))

-```

-

-#### 开始训练

-

-既然我们设置了 `event_handler` 和 `data reader`,我们就可以开始训练模型了。

-

-`feed_order` 用于将数据目录映射到 `train_program`

-

-```python

-trainer.train(

- num_epochs=5,

- event_handler=event_handler,

- reader=train_reader,

- feed_order=['img', 'label'])

-```

-

-训练过程是完全自动的,event_handler里打印的日志类似如下所示:

-

-```

-Pass 0, Batch 0, Cost 0.125650

-Pass 100, Batch 0, Cost 0.161387

-Pass 200, Batch 0, Cost 0.040036

-Pass 300, Batch 0, Cost 0.023391

-Pass 400, Batch 0, Cost 0.005856

-Pass 500, Batch 0, Cost 0.003315

-Pass 600, Batch 0, Cost 0.009977

-Pass 700, Batch 0, Cost 0.020959

-Pass 800, Batch 0, Cost 0.105560

-Pass 900, Batch 0, Cost 0.239809

-Test with Epoch 0, avg_cost: 0.053097883707459624, acc: 0.9822850318471338

-```

-

-训练之后,检查模型的预测准确度。用 MNIST 训练的时候,一般 softmax回归模型的分类准确率为约为 92.34%,多层感知器为97.66%,卷积神经网络可以达到 99.20%。

-

-

-## 应用模型

-

-可以使用训练好的模型对手写体数字图片进行分类,下面程序展示了如何使用 `fluid.Inferencer` 接口进行推断。

-

-### Inference 配置

-

-`Inference` 需要一个 `infer_func` 和 `param_path` 来设置网络和经过训练的参数。

-我们可以简单地插入在此之前定义的分类器。

-

-```python

-inferencer = fluid.Inferencer(

- # infer_func=softmax_regression, # uncomment for softmax regression

- # infer_func=multilayer_perceptron, # uncomment for MLP

- infer_func=convolutional_neural_network, # uncomment for LeNet5

- param_path=params_dirname,

- place=place)

-```

-

-### 生成预测输入数据

-

-`infer_3.png` 是数字 3 的一个示例图像。把它变成一个 numpy 数组以匹配数据馈送格式。

-

-```python

-# Prepare the test image

-import os

-import numpy as np

-from PIL import Image

-def load_image(file):

- im = Image.open(file).convert('L')

- im = im.resize((28, 28), Image.ANTIALIAS)

- im = np.array(im).reshape(1, 1, 28, 28).astype(np.float32)

- im = im / 255.0 * 2.0 - 1.0

- return im

-

-cur_dir = cur_dir = os.getcwd()

-img = load_image(cur_dir + '/image/infer_3.png')

-```

-

-### 预测

-

-现在我们准备做预测。

-

-```python

-results = inferencer.infer({'img': img})

-lab = np.argsort(results) # probs and lab are the results of one batch data

-print ("Inference result of image/infer_3.png is: %d" % lab[0][0][-1])

-```

-

-## 总结

-

-本教程的softmax回归、多层感知器和卷积神经网络是最基础的深度学习模型,后续章节中复杂的神经网络都是从它们衍生出来的,因此这几个模型对之后的学习大有裨益。同时,我们也观察到从最简单的softmax回归变换到稍复杂的卷积神经网络的时候,MNIST数据集上的识别准确率有了大幅度的提升,原因是卷积层具有局部连接和共享权重的特性。在之后学习新模型的时候,希望大家也要深入到新模型相比原模型带来效果提升的关键之处。此外,本教程还介绍了PaddlePaddle模型搭建的基本流程,从dataprovider的编写、网络层的构建,到最后的训练和预测。对这个流程熟悉以后,大家就可以用自己的数据,定义自己的网络模型,并完成自己的训练和预测任务了。

-

-## 参考文献

-

-1. LeCun, Yann, Léon Bottou, Yoshua Bengio, and Patrick Haffner. ["Gradient-based learning applied to document recognition."](http://ieeexplore.ieee.org/abstract/document/726791/) Proceedings of the IEEE 86, no. 11 (1998): 2278-2324.

-2. Wejéus, Samuel. ["A Neural Network Approach to Arbitrary SymbolRecognition on Modern Smartphones."](http://www.diva-portal.org/smash/record.jsf?pid=diva2%3A753279&dswid=-434) (2014).

-3. Decoste, Dennis, and Bernhard Schölkopf. ["Training invariant support vector machines."](http://link.springer.com/article/10.1023/A:1012454411458) Machine learning 46, no. 1-3 (2002): 161-190.

-4. Simard, Patrice Y., David Steinkraus, and John C. Platt. ["Best Practices for Convolutional Neural Networks Applied to Visual Document Analysis."](http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.160.8494&rep=rep1&type=pdf) In ICDAR, vol. 3, pp. 958-962. 2003.

-5. Salakhutdinov, Ruslan, and Geoffrey E. Hinton. ["Learning a Nonlinear Embedding by Preserving Class Neighbourhood Structure."](http://www.jmlr.org/proceedings/papers/v2/salakhutdinov07a/salakhutdinov07a.pdf) In AISTATS, vol. 11. 2007.

-6. Cireşan, Dan Claudiu, Ueli Meier, Luca Maria Gambardella, and Jürgen Schmidhuber. ["Deep, big, simple neural nets for handwritten digit recognition."](http://www.mitpressjournals.org/doi/abs/10.1162/NECO_a_00052) Neural computation 22, no. 12 (2010): 3207-3220.

-7. Deng, Li, Michael L. Seltzer, Dong Yu, Alex Acero, Abdel-rahman Mohamed, and Geoffrey E. Hinton. ["Binary coding of speech spectrograms using a deep auto-encoder."](http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.185.1908&rep=rep1&type=pdf) In Interspeech, pp. 1692-1695. 2010.

-8. Kégl, Balázs, and Róbert Busa-Fekete. ["Boosting products of base classifiers."](http://dl.acm.org/citation.cfm?id=1553439) In Proceedings of the 26th Annual International Conference on Machine Learning, pp. 497-504. ACM, 2009.

-9. Rosenblatt, Frank. ["The perceptron: A probabilistic model for information storage and organization in the brain."](http://psycnet.apa.org/journals/rev/65/6/386/) Psychological review 65, no. 6 (1958): 386.

-10. Bishop, Christopher M. ["Pattern recognition."](http://users.isr.ist.utl.pt/~wurmd/Livros/school/Bishop%20-%20Pattern%20Recognition%20And%20Machine%20Learning%20-%20Springer%20%202006.pdf) Machine Learning 128 (2006): 1-58.

-

-

-

本教程

本教程 由

PaddlePaddle 创作,采用

知识共享 署名-相同方式共享 4.0 国际 许可协议进行许可。

+# 识别数字

+

+本教程源代码目录在[book/recognize_digits](https://github.com/PaddlePaddle/book/tree/develop/02.recognize_digits), 初次使用请参考PaddlePaddle[安装教程](https://github.com/PaddlePaddle/book/blob/develop/README.cn.md#运行这本书),更多内容请参考本教程的[视频课堂](http://bit.baidu.com/course/detail/id/167.html)。

+

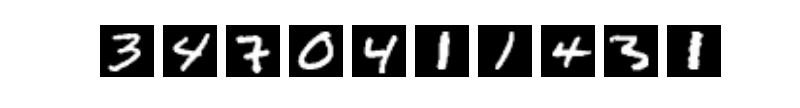

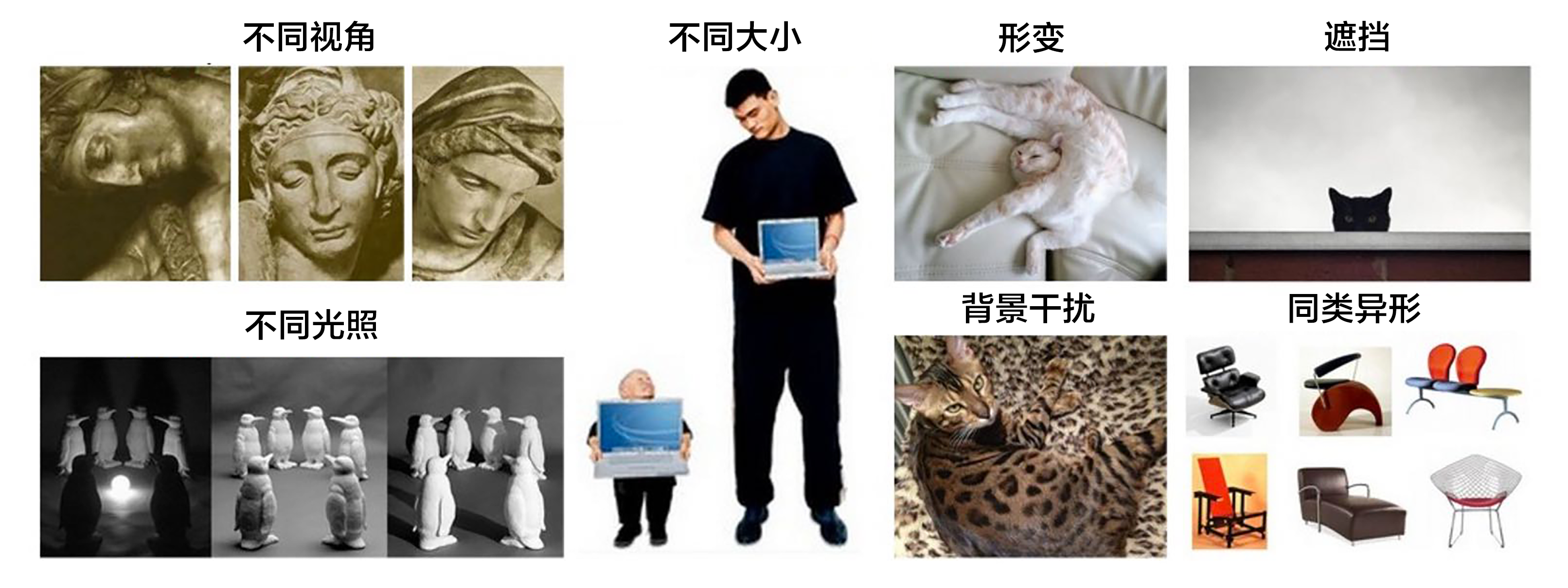

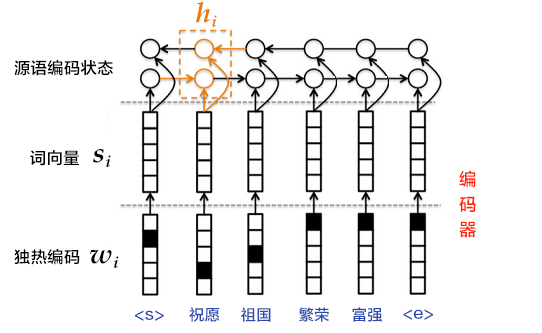

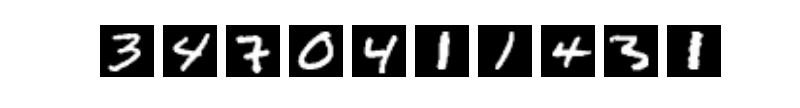

+## 背景介绍

+当我们学习编程的时候,编写的第一个程序一般是实现打印"Hello World"。而机器学习(或深度学习)的入门教程,一般都是 [MNIST](http://yann.lecun.com/exdb/mnist/) 数据库上的手写识别问题。原因是手写识别属于典型的图像分类问题,比较简单,同时MNIST数据集也很完备。MNIST数据集作为一个简单的计算机视觉数据集,包含一系列如图1所示的手写数字图片和对应的标签。图片是28x28的像素矩阵,标签则对应着0~9的10个数字。每张图片都经过了大小归一化和居中处理。

+

+

+

+图1. MNIST图片示例

+

+

+MNIST数据集是从 [NIST](https://www.nist.gov/srd/nist-special-database-19) 的Special Database 3(SD-3)和Special Database 1(SD-1)构建而来。由于SD-3是由美国人口调查局的员工进行标注,SD-1是由美国高中生进行标注,因此SD-3比SD-1更干净也更容易识别。Yann LeCun等人从SD-1和SD-3中各取一半作为MNIST的训练集(60000条数据)和测试集(10000条数据),其中训练集来自250位不同的标注员,此外还保证了训练集和测试集的标注员是不完全相同的。

+

+Yann LeCun早先在手写字符识别上做了很多研究,并在研究过程中提出了卷积神经网络(Convolutional Neural Network),大幅度地提高了手写字符的识别能力,也因此成为了深度学习领域的奠基人之一。如今的深度学习领域,卷积神经网络占据了至关重要的地位,从最早Yann LeCun提出的简单LeNet,到如今ImageNet大赛上的优胜模型VGGNet、GoogLeNet、ResNet等(请参见[图像分类](https://github.com/PaddlePaddle/book/tree/develop/03.image_classification) 教程),人们在图像分类领域,利用卷积神经网络得到了一系列惊人的结果。

+

+有很多算法在MNIST上进行实验。1998年,LeCun分别用单层线性分类器、多层感知器(Multilayer Perceptron, MLP)和多层卷积神经网络LeNet进行实验,使得测试集上的误差不断下降(从12%下降到0.7%)\[[1](#参考文献)\]。此后,科学家们又基于K近邻(K-Nearest Neighbors)算法\[[2](#参考文献)\]、支持向量机(SVM)\[[3](#参考文献)\]、神经网络\[[4-7](#参考文献)\]和Boosting方法\[[8](#参考文献)\]等做了大量实验,并采用多种预处理方法(如去除歪曲、去噪、模糊等)来提高识别的准确率。

+

+本教程中,我们从简单的模型Softmax回归开始,带大家入门手写字符识别,并逐步进行模型优化。

+

+

+## 模型概览

+

+基于MNIST数据训练一个分类器,在介绍本教程使用的三个基本图像分类网络前,我们先给出一些定义:

+- $X$是输入:MNIST图片是$28\times28$ 的二维图像,为了进行计算,我们将其转化为$784$维向量,即$X=\left ( x_0, x_1, \dots, x_{783} \right )$。

+- $Y$是输出:分类器的输出是10类数字(0-9),即$Y=\left ( y_0, y_1, \dots, y_9 \right )$,每一维$y_i$代表图片分类为第$i$类数字的概率。

+- $L$是图片的真实标签:$L=\left ( l_0, l_1, \dots, l_9 \right )$也是10维,但只有一维为1,其他都为0。

+

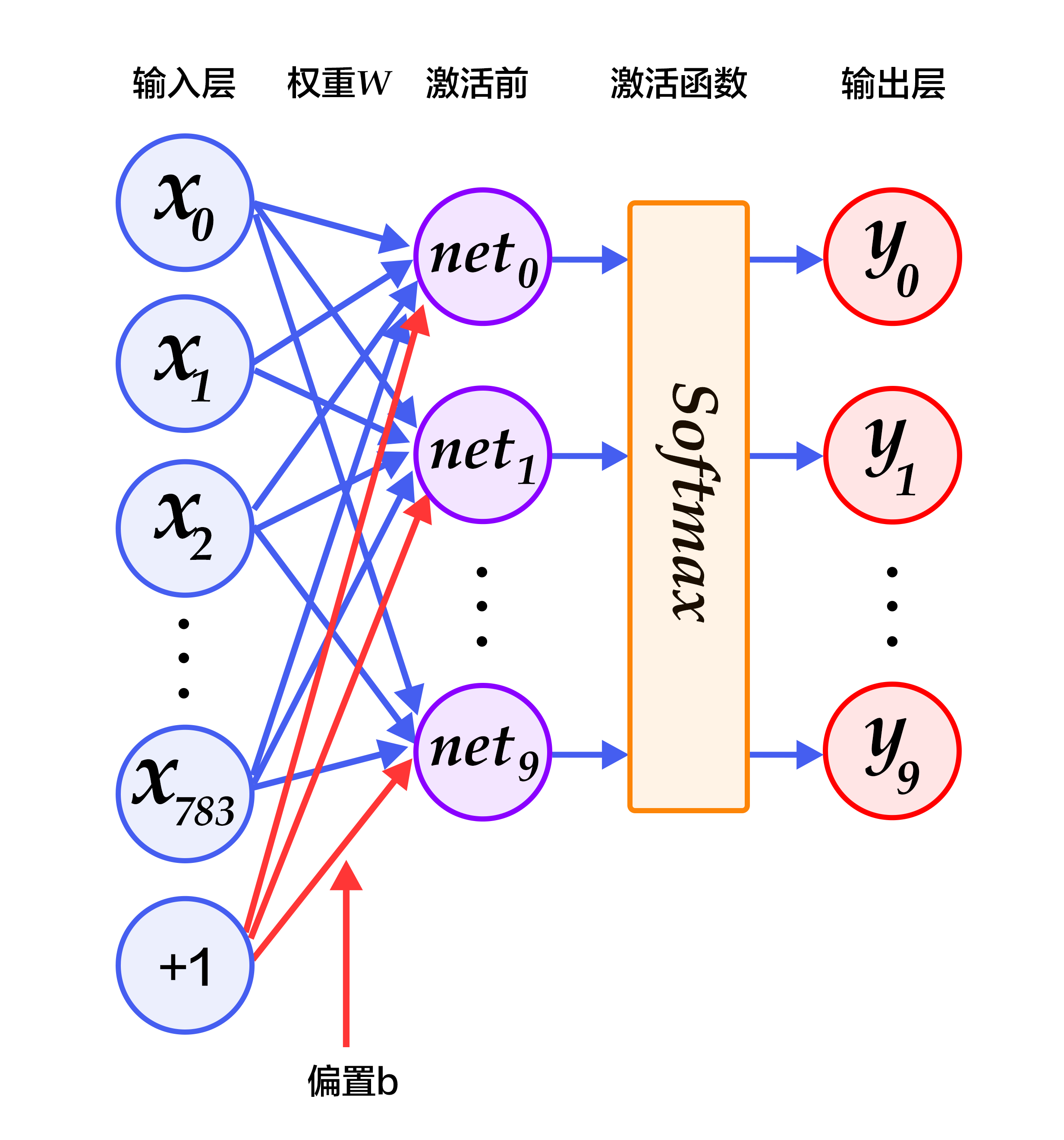

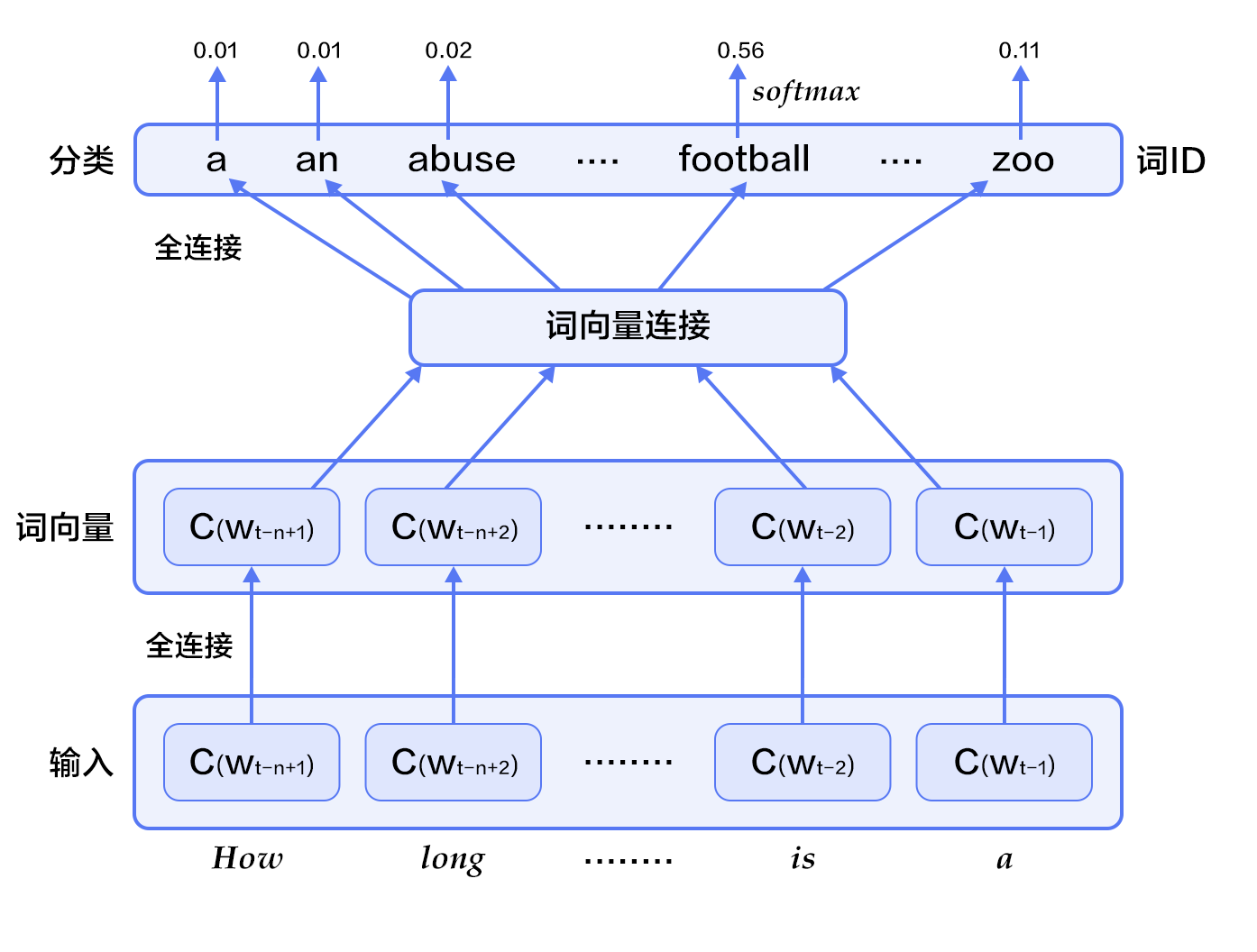

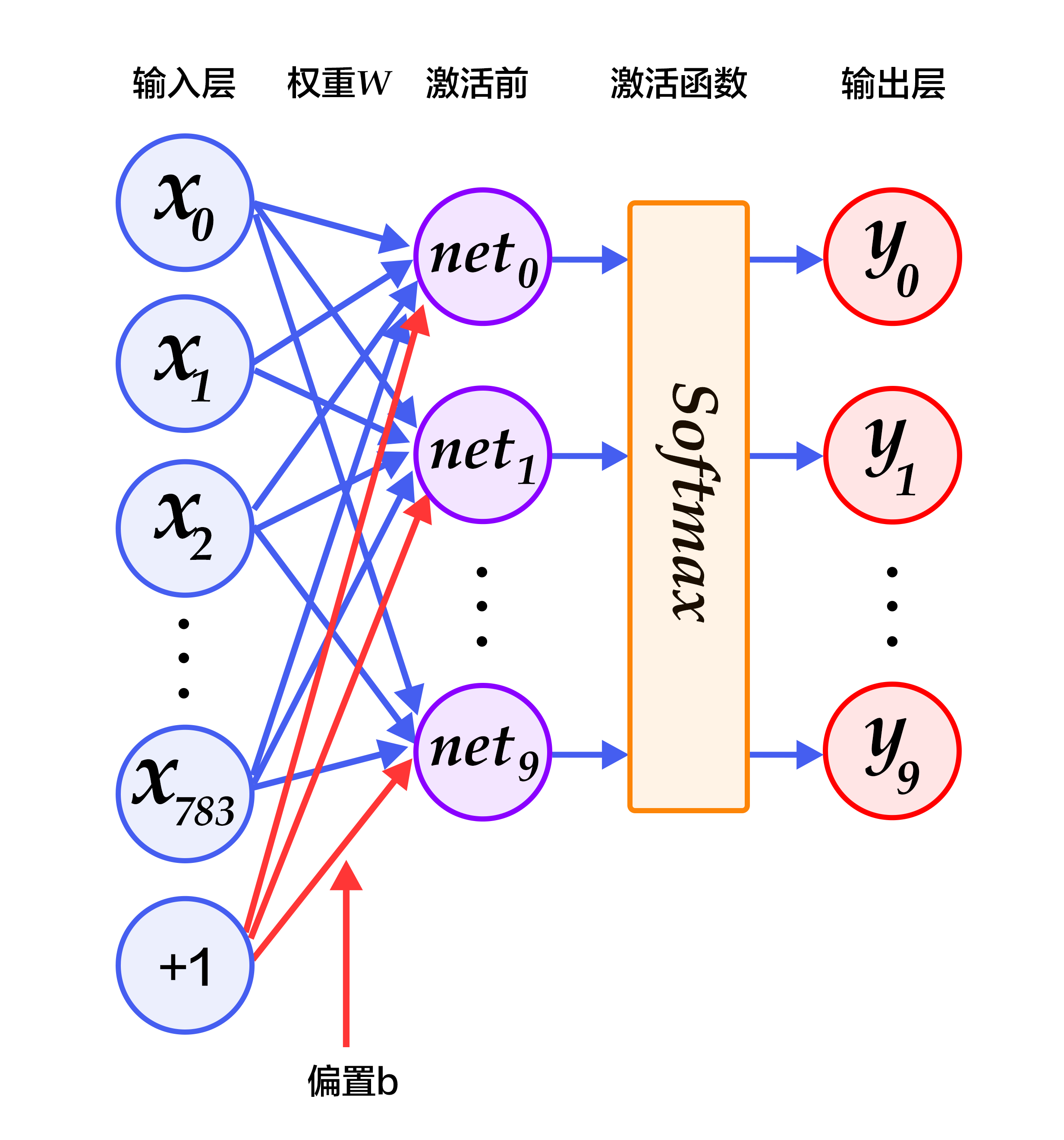

+### Softmax回归(Softmax Regression)

+

+最简单的Softmax回归模型是先将输入层经过一个全连接层得到的特征,然后直接通过softmax 函数进行多分类\[[9](#参考文献)\]。

+

+输入层的数据$X$传到输出层,在激活操作之前,会乘以相应的权重 $W$ ,并加上偏置变量 $b$ ,具体如下:

+

+$$ y_i = \text{softmax}(\sum_j W_{i,j}x_j + b_i) $$

+

+其中 $ \text{softmax}(x_i) = \frac{e^{x_i}}{\sum_j e^{x_j}} $

+

+对于有 $N$ 个类别的多分类问题,指定 $N$ 个输出节点,$N$ 维结果向量经过softmax将归一化为 $N$ 个[0,1]范围内的实数值,分别表示该样本属于这 $N$ 个类别的概率。此处的 $y_i$ 即对应该图片为数字 $i$ 的预测概率。

+

+在分类问题中,我们一般采用交叉熵代价损失函数(cross entropy loss),公式如下:

+

+$$ L_{cross-entropy}(label, y) = -\sum_i label_ilog(y_i) $$

+

+图2为softmax回归的网络图,图中权重用蓝线表示、偏置用红线表示、+1代表偏置参数的系数为1。

+

+

+

+图2. softmax回归网络结构图

+

+

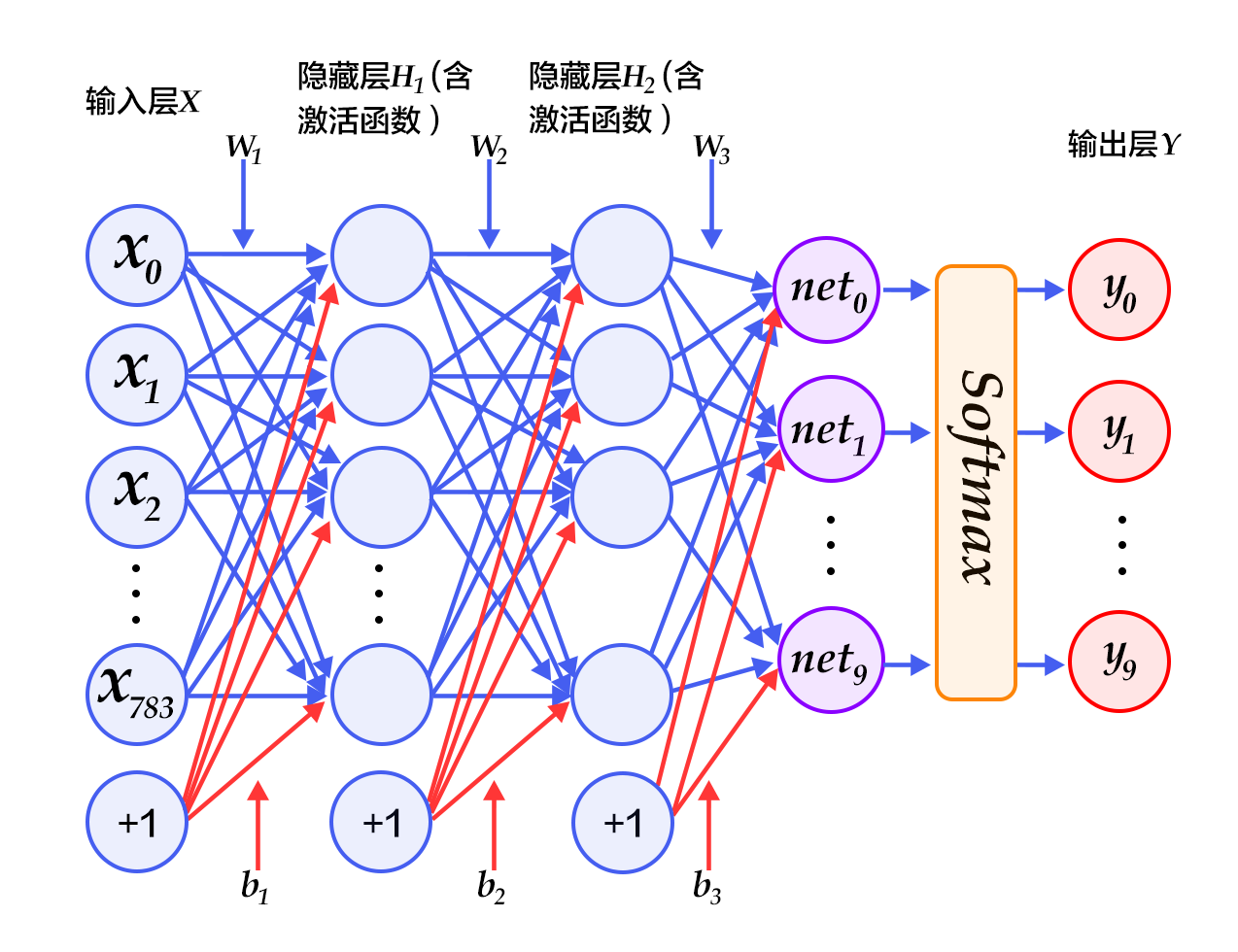

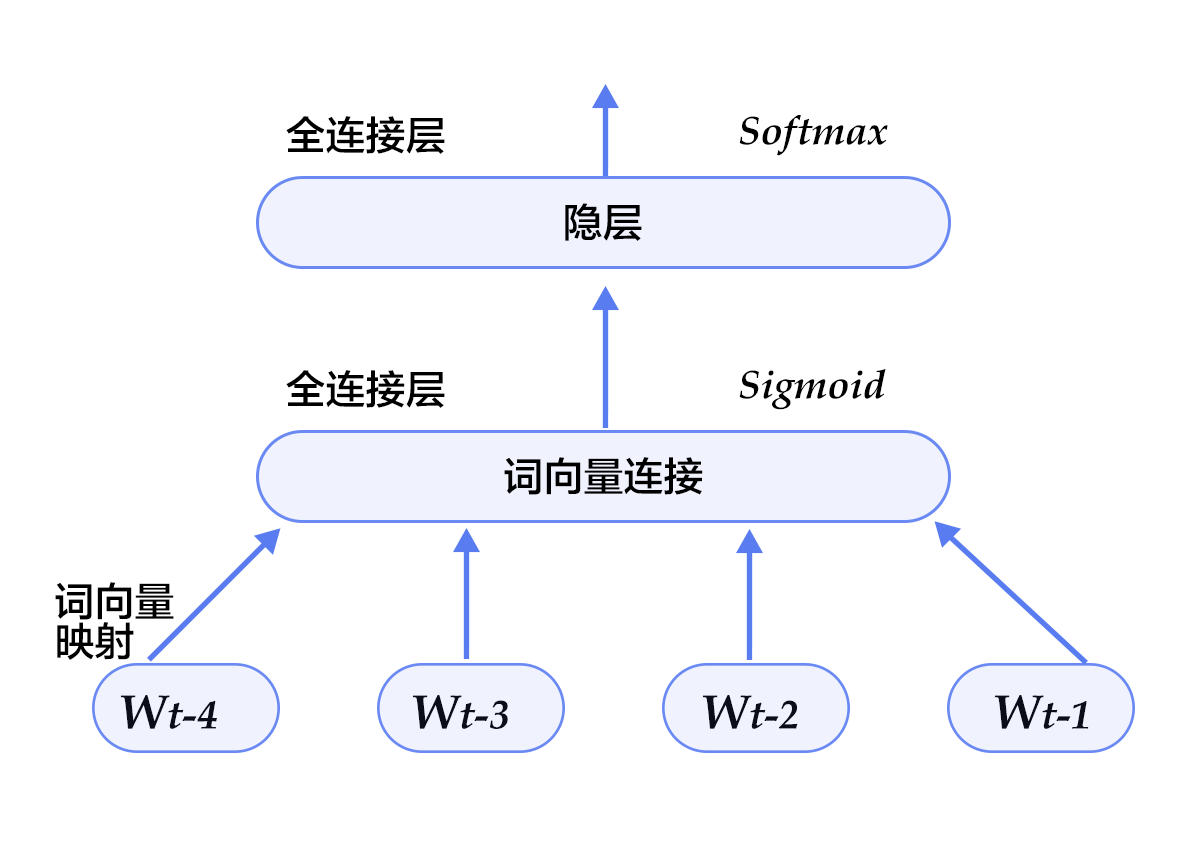

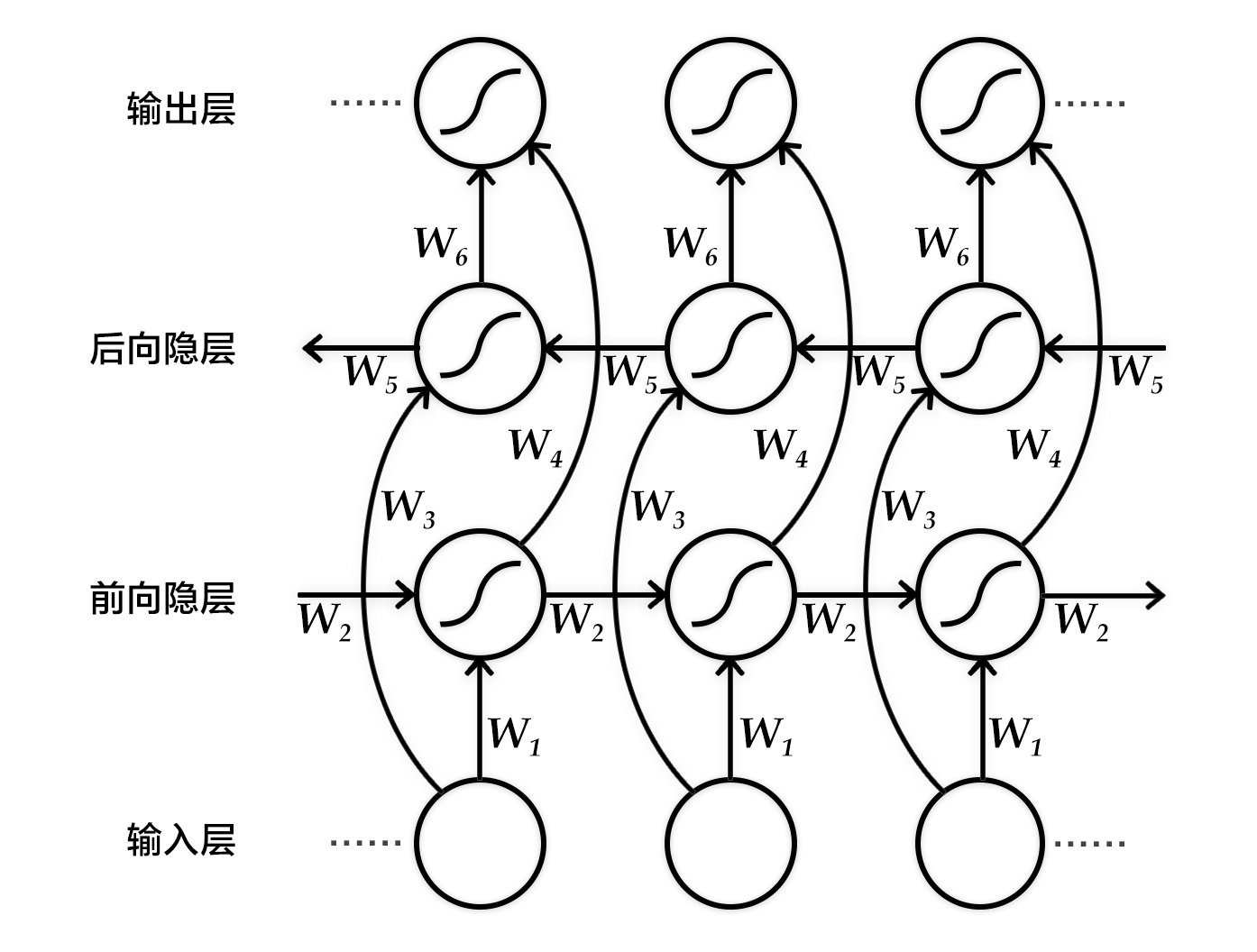

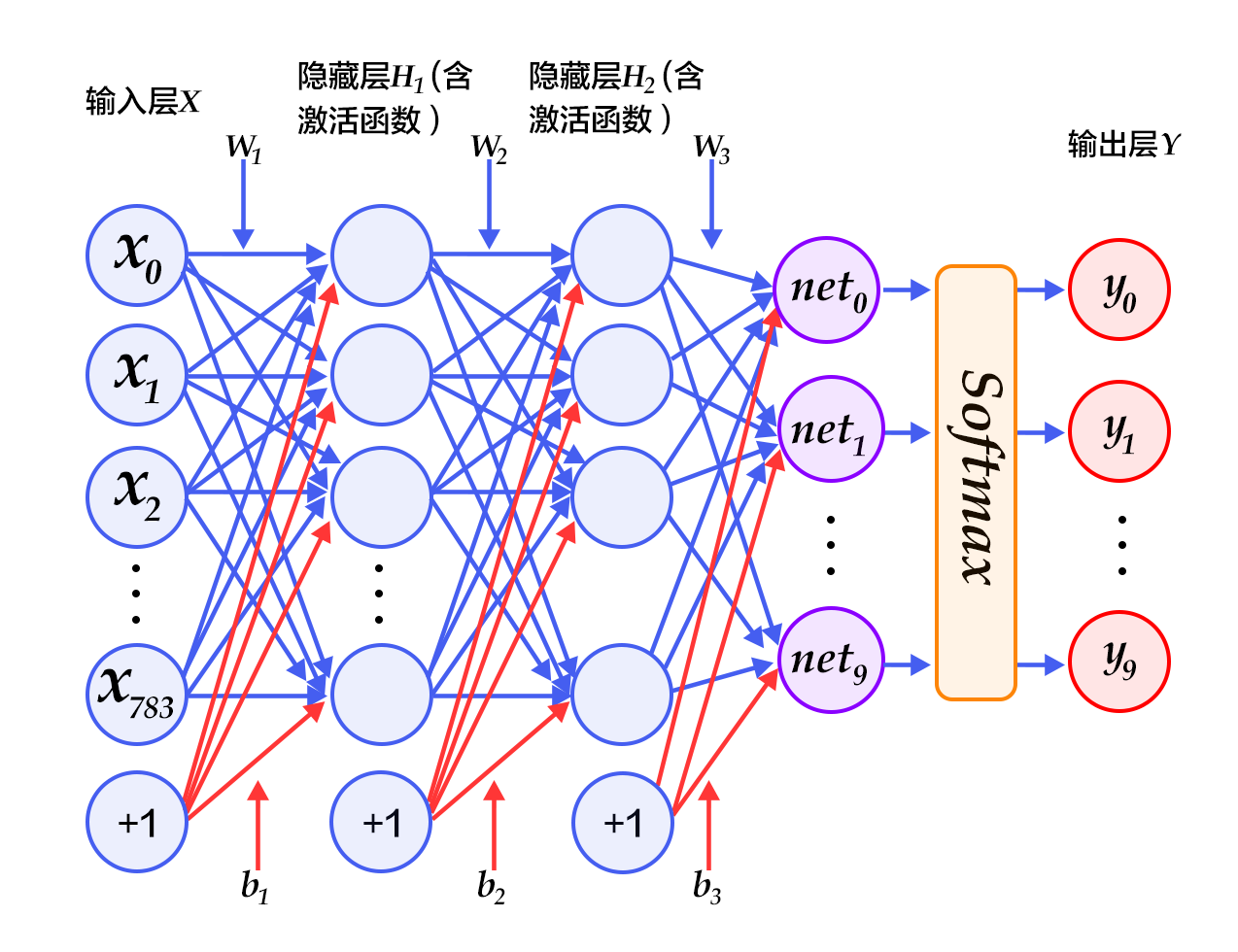

+### 多层感知器(Multilayer Perceptron, MLP)

+

+Softmax回归模型采用了最简单的两层神经网络,即只有输入层和输出层,因此其拟合能力有限。为了达到更好的识别效果,我们考虑在输入层和输出层中间加上若干个隐藏层\[[10](#参考文献)\]。

+

+1. 经过第一个隐藏层,可以得到 $ H_1 = \phi(W_1X + b_1) $,其中$\phi$代表激活函数,常见的有sigmoid、tanh或ReLU等函数。

+2. 经过第二个隐藏层,可以得到 $ H_2 = \phi(W_2H_1 + b_2) $。

+3. 最后,再经过输出层,得到的$Y=\text{softmax}(W_3H_2 + b_3)$,即为最后的分类结果向量。

+

+

+图3为多层感知器的网络结构图,图中权重用蓝线表示、偏置用红线表示、+1代表偏置参数的系数为1。

+

+

+

+图3. 多层感知器网络结构图

+

+

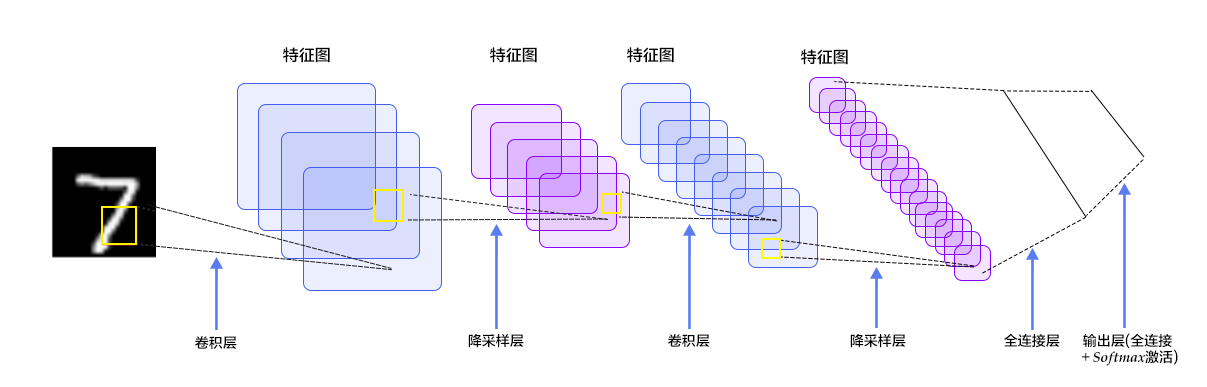

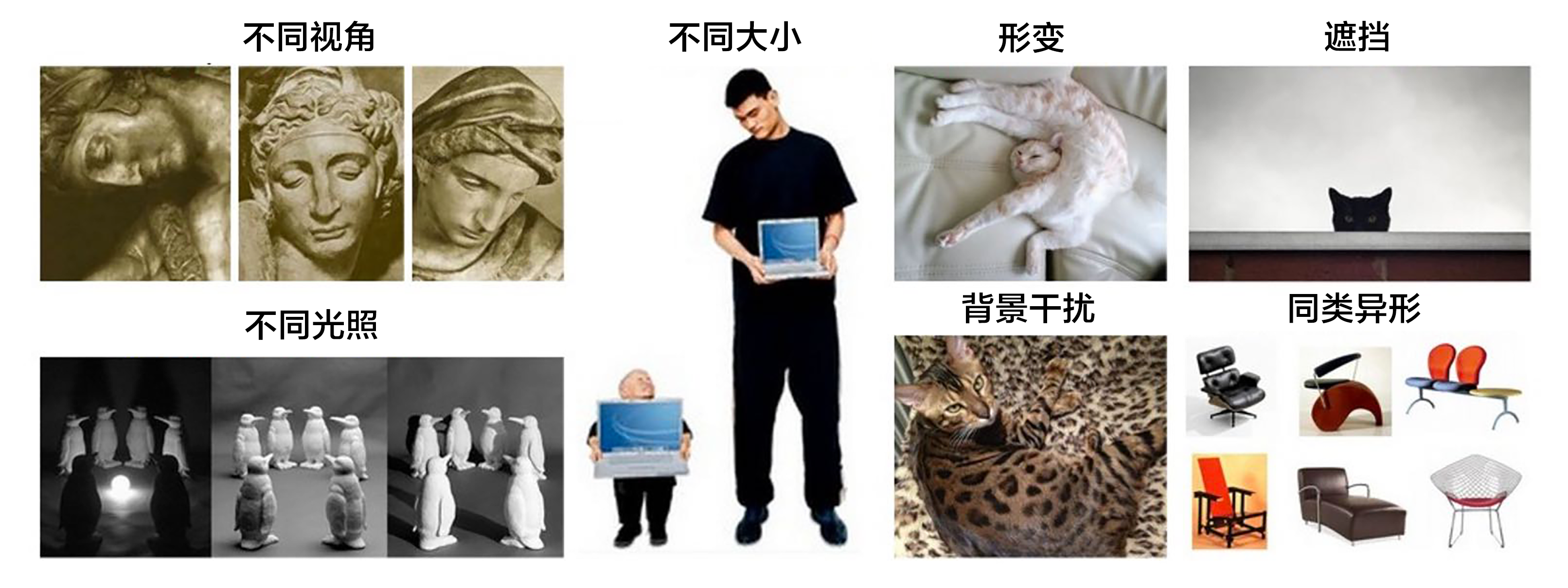

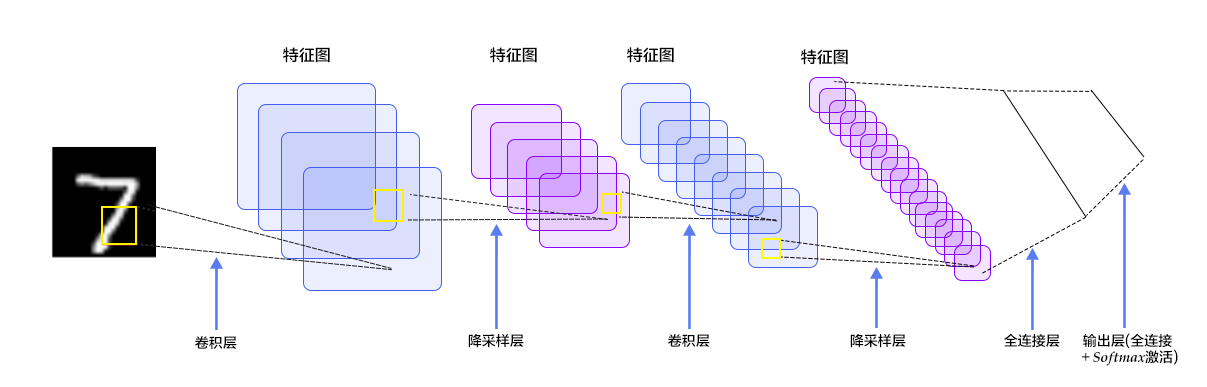

+### 卷积神经网络(Convolutional Neural Network, CNN)

+

+在多层感知器模型中,将图像展开成一维向量输入到网络中,忽略了图像的位置和结构信息,而卷积神经网络能够更好的利用图像的结构信息。[LeNet-5](http://yann.lecun.com/exdb/lenet/)是一个较简单的卷积神经网络。图4显示了其结构:输入的二维图像,先经过两次卷积层到池化层,再经过全连接层,最后使用softmax分类作为输出层。下面我们主要介绍卷积层和池化层。

+

+

+

+图4. LeNet-5卷积神经网络结构

+

+

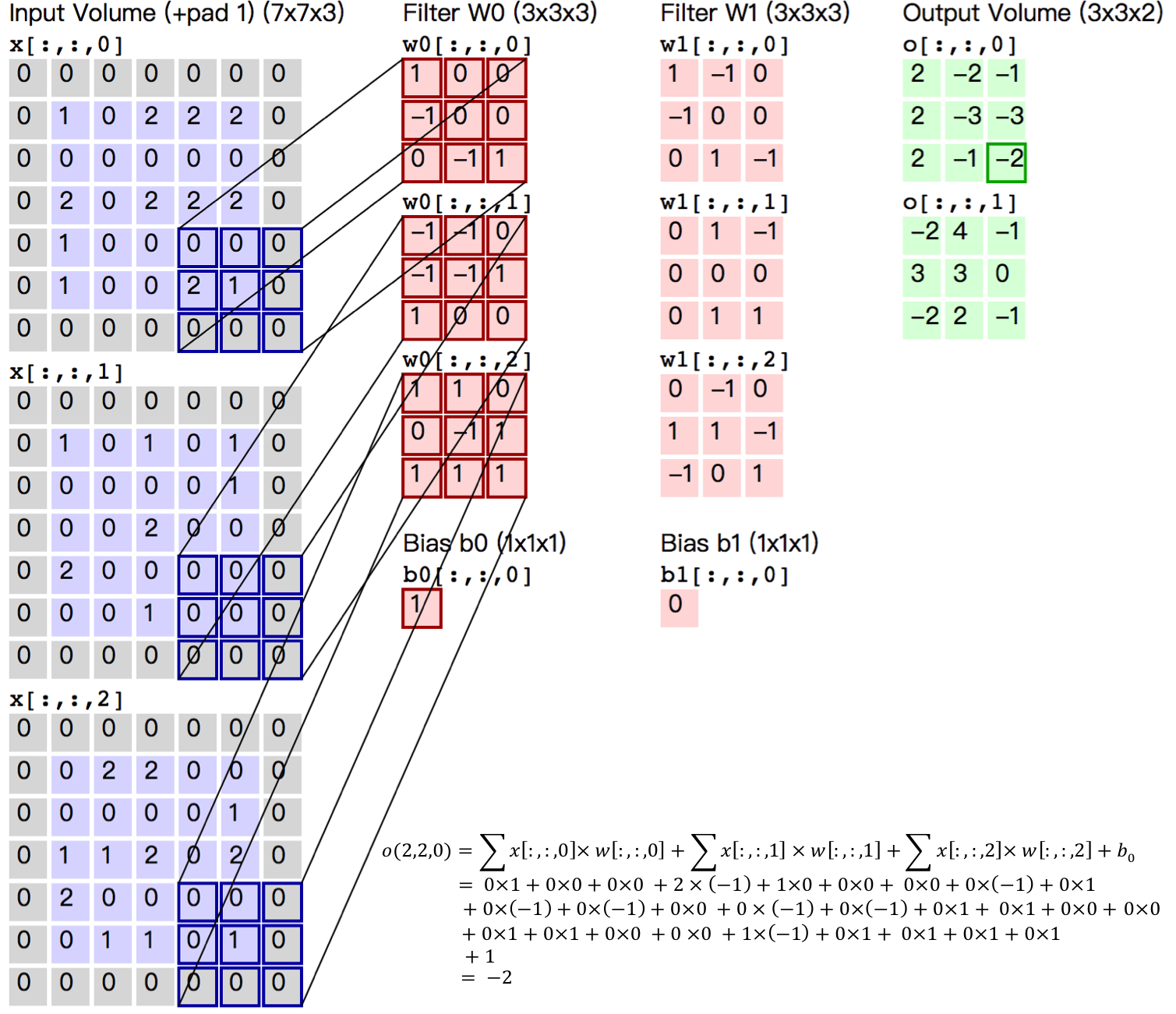

+#### 卷积层

+

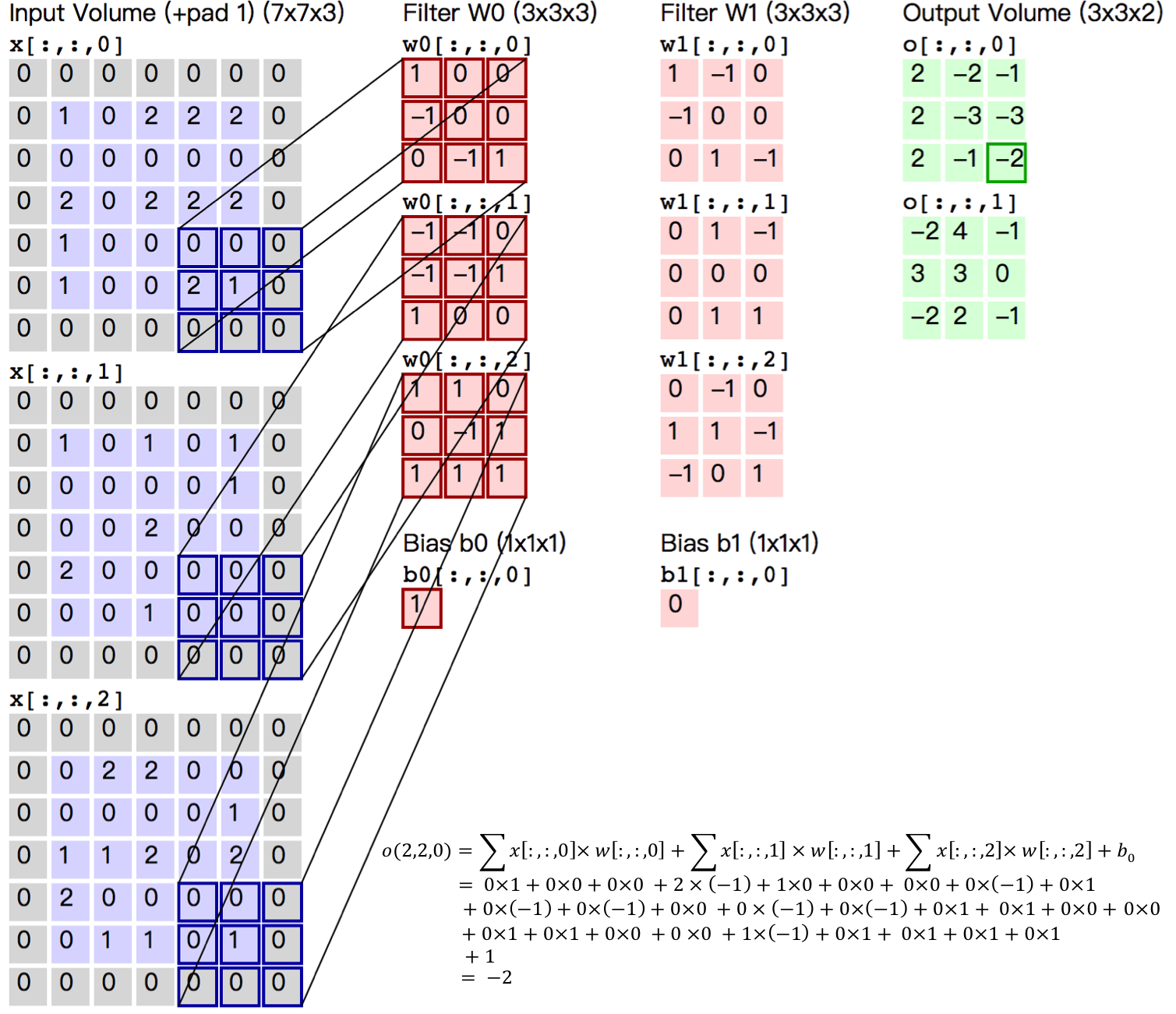

+卷积层是卷积神经网络的核心基石。在图像识别里我们提到的卷积是二维卷积,即离散二维滤波器(也称作卷积核)与二维图像做卷积操作,简单的讲是二维滤波器滑动到二维图像上所有位置,并在每个位置上与该像素点及其领域像素点做内积。卷积操作被广泛应用与图像处理领域,不同卷积核可以提取不同的特征,例如边沿、线性、角等特征。在深层卷积神经网络中,通过卷积操作可以提取出图像低级到复杂的特征。

+

+

+

+图5. 卷积层图片

+

+

+图5给出一个卷积计算过程的示例图,输入图像大小为$H=5,W=5,D=3$,即$5 \times 5$大小的3通道(RGB,也称作深度)彩色图像。这个示例图中包含两(用$K$表示)组卷积核,即图中滤波器$W_0$和$W_1$。在卷积计算中,通常对不同的输入通道采用不同的卷积核,如图示例中每组卷积核包含($D=3)$个$3 \times 3$(用$F \times F$表示)大小的卷积核。另外,这个示例中卷积核在图像的水平方向($W$方向)和垂直方向($H$方向)的滑动步长为2(用$S$表示);对输入图像周围各填充1(用$P$表示)个0,即图中输入层原始数据为蓝色部分,灰色部分是进行了大小为1的扩展,用0来进行扩展。经过卷积操作得到输出为$3 \times 3 \times 2$(用$H_{o} \times W_{o} \times K$表示)大小的特征图,即$3 \times 3$大小的2通道特征图,其中$H_o$计算公式为:$H_o = (H - F + 2 \times P)/S + 1$,$W_o$同理。 而输出特征图中的每个像素,是每组滤波器与输入图像每个特征图的内积再求和,再加上偏置$b_o$,偏置通常对于每个输出特征图是共享的。输出特征图$o[:,:,0]$中的最后一个$-2$计算如图5右下角公式所示。

+

+在卷积操作中卷积核是可学习的参数,经过上面示例介绍,每层卷积的参数大小为$D \times F \times F \times K$。在多层感知器模型中,神经元通常是全部连接,参数较多。而卷积层的参数较少,这也是由卷积层的主要特性即局部连接和共享权重所决定。

+

+- 局部连接:每个神经元仅与输入神经元的一块区域连接,这块局部区域称作感受野(receptive field)。在图像卷积操作中,即神经元在空间维度(spatial dimension,即上图示例H和W所在的平面)是局部连接,但在深度上是全部连接。对于二维图像本身而言,也是局部像素关联较强。这种局部连接保证了学习后的过滤器能够对于局部的输入特征有最强的响应。局部连接的思想,也是受启发于生物学里面的视觉系统结构,视觉皮层的神经元就是局部接受信息的。

+

+- 权重共享:计算同一个深度切片的神经元时采用的滤波器是共享的。例如图4中计算$o[:,:,0]$的每个每个神经元的滤波器均相同,都为$W_0$,这样可以很大程度上减少参数。共享权重在一定程度上讲是有意义的,例如图片的底层边缘特征与特征在图中的具体位置无关。但是在一些场景中是无意的,比如输入的图片是人脸,眼睛和头发位于不同的位置,希望在不同的位置学到不同的特征 (参考[斯坦福大学公开课]( http://cs231n.github.io/convolutional-networks/))。请注意权重只是对于同一深度切片的神经元是共享的,在卷积层,通常采用多组卷积核提取不同特征,即对应不同深度切片的特征,不同深度切片的神经元权重是不共享。另外,偏重对同一深度切片的所有神经元都是共享的。

+

+通过介绍卷积计算过程及其特性,可以看出卷积是线性操作,并具有平移不变性(shift-invariant),平移不变性即在图像每个位置执行相同的操作。卷积层的局部连接和权重共享使得需要学习的参数大大减小,这样也有利于训练较大卷积神经网络。

+

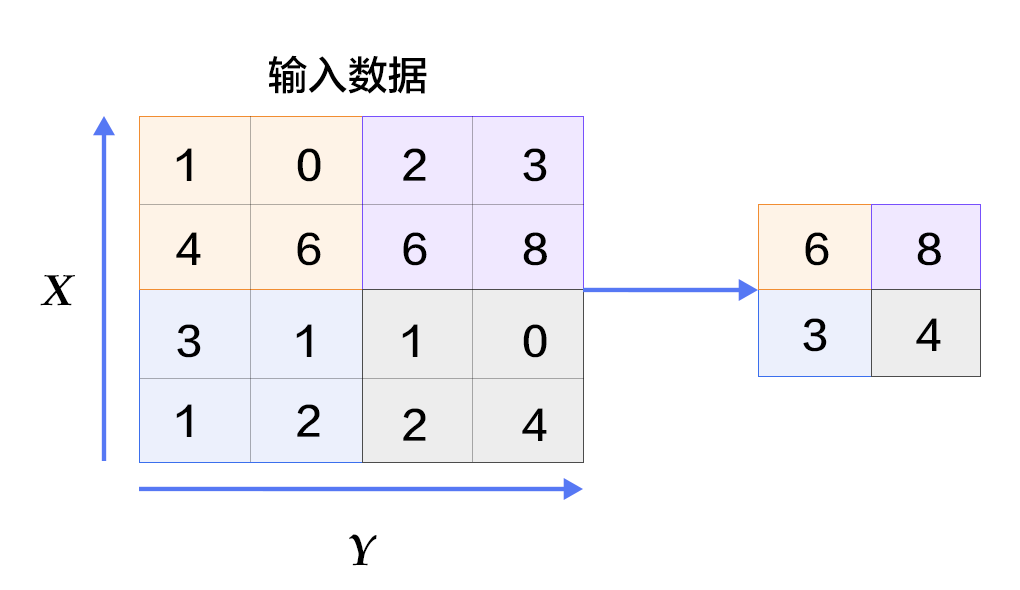

+#### 池化层

+

+

+

+图6. 池化层图片

+

+

+池化是非线性下采样的一种形式,主要作用是通过减少网络的参数来减小计算量,并且能够在一定程度上控制过拟合。通常在卷积层的后面会加上一个池化层。池化包括最大池化、平均池化等。其中最大池化是用不重叠的矩形框将输入层分成不同的区域,对于每个矩形框的数取最大值作为输出层,如图6所示。

+

+更详细的关于卷积神经网络的具体知识可以参考[斯坦福大学公开课]( http://cs231n.github.io/convolutional-networks/ )和[图像分类]( https://github.com/PaddlePaddle/book/tree/develop/03.image_classification )教程。

+

+### 常见激活函数介绍

+- sigmoid激活函数: $ f(x) = sigmoid(x) = \frac{1}{1+e^{-x}} $

+

+- tanh激活函数: $ f(x) = tanh(x) = \frac{e^x-e^{-x}}{e^x+e^{-x}} $

+

+ 实际上,tanh函数只是规模变化的sigmoid函数,将sigmoid函数值放大2倍之后再向下平移1个单位:tanh(x) = 2sigmoid(2x) - 1 。

+

+- ReLU激活函数: $ f(x) = max(0, x) $

+

+更详细的介绍请参考[维基百科激活函数](https://en.wikipedia.org/wiki/Activation_function)。

+

+## 数据介绍

+

+PaddlePaddle在API中提供了自动加载[MNIST](http://yann.lecun.com/exdb/mnist/)数据的模块`paddle.dataset.mnist`。加载后的数据位于`/home/username/.cache/paddle/dataset/mnist`下:

+

+

+| 文件名称 | 说明 |

+|----------------------|-------------------------|

+|train-images-idx3-ubyte| 训练数据图片,60,000条数据 |

+|train-labels-idx1-ubyte| 训练数据标签,60,000条数据 |

+|t10k-images-idx3-ubyte | 测试数据图片,10,000条数据 |

+|t10k-labels-idx1-ubyte | 测试数据标签,10,000条数据 |

+

+## Fluid API 概述

+

+演示将使用最新的 `Fluid API`。Fluid API是最新的 PaddlePaddle API。它在不牺牲性能的情况下简化了模型配置。

+我们建议使用 Fluid API,因为它更容易学起来。

+

+下面是快速的 Fluid API 概述。

+1. `inference_program`:指定如何从数据输入中获得预测的函数。

+这是指定网络流的地方。

+

+1. `train_program`:指定如何从 `inference_program` 和`标签值`中获取 `loss` 的函数。

+这是指定损失计算的地方。

+

+1. `optimizer_func`: “指定优化器配置的函数。优化器负责减少损失并驱动培训。Paddle 支持多种不同的优化器。

+

+1. `Trainer`:PaddlePaddle Trainer 管理由 `train_program` 和 `optimizer` 指定的训练过程。

+通过 `event_handler` 回调函数,用户可以监控培训的进展。

+

+1. `Inferencer`:Fluid inferencer 加载 `inference_program` 和由 Trainer 训练的参数。

+然后,它可以推断数据和返回预测。

+

+在这个演示中,我们将深入了解它们。

+

+## 配置说明

+加载 PaddlePaddle 的 Fluid API 包。

+

+```python

+import paddle

+import paddle.fluid as fluid

+from __future__ import print_function

+```

+

+### Program Functions 配置

+

+我们需要设置“推理程序”函数。我们想用这个程序来演示三个不同的分类器,每个分类器都定义为 Python 函数。

+我们需要将图像数据馈送到分类器。Paddle 为读取数据提供了一个特殊的层 `layer.data` 层。

+让我们创建一个数据层来读取图像并将其连接到分类网络。

+

+- Softmax回归:只通过一层简单的以softmax为激活函数的全连接层,就可以得到分类的结果。

+

+```python

+def softmax_regression():

+ img = fluid.layers.data(name='img', shape=[1, 28, 28], dtype='float32')

+ predict = fluid.layers.fc(

+ input=img, size=10, act='softmax')

+ return predict

+```

+

+- 多层感知器:下面代码实现了一个含有两个隐藏层(即全连接层)的多层感知器。其中两个隐藏层的激活函数均采用ReLU,输出层的激活函数用Softmax。

+

+```python

+def multilayer_perceptron():

+ img = fluid.layers.data(name='img', shape=[1, 28, 28], dtype='float32')

+ # 第一个全连接层,激活函数为ReLU

+ hidden = fluid.layers.fc(input=img, size=200, act='relu')

+ # 第二个全连接层,激活函数为ReLU

+ hidden = fluid.layers.fc(input=hidden, size=200, act='relu')

+ # 以softmax为激活函数的全连接输出层,输出层的大小必须为数字的个数10

+ prediction = fluid.layers.fc(input=hidden, size=10, act='softmax')

+ return prediction

+```

+

+- 卷积神经网络LeNet-5: 输入的二维图像,首先经过两次卷积层到池化层,再经过全连接层,最后使用以softmax为激活函数的全连接层作为输出层。

+

+```python

+def convolutional_neural_network():

+ img = fluid.layers.data(name='img', shape=[1, 28, 28], dtype='float32')

+ # 第一个卷积-池化层

+ conv_pool_1 = fluid.nets.simple_img_conv_pool(

+ input=img,

+ filter_size=5,

+ num_filters=20,

+ pool_size=2,

+ pool_stride=2,

+ act="relu")

+ conv_pool_1 = fluid.layers.batch_norm(conv_pool_1)

+ # 第二个卷积-池化层

+ conv_pool_2 = fluid.nets.simple_img_conv_pool(

+ input=conv_pool_1,

+ filter_size=5,

+ num_filters=50,

+ pool_size=2,

+ pool_stride=2,

+ act="relu")

+ # 以softmax为激活函数的全连接输出层,输出层的大小必须为数字的个数10

+ prediction = fluid.layers.fc(input=conv_pool_2, size=10, act='softmax')

+ return prediction

+```

+

+#### Train Program 配置

+然后我们需要设置训练程序 `train_program`。它首先从分类器中进行预测。

+在训练期间,它将从预测中计算 `avg_cost`。

+

+**注意:** 训练程序应该返回一个数组,第一个返回参数必须是 `avg_cost`。训练器使用它来计算梯度。

+

+请随意修改代码,测试 Softmax 回归 `softmax_regression`, `MLP` 和 卷积神经网络 `convolutional neural network` 分类器之间的不同结果。

+

+```python

+def train_program():

+ label = fluid.layers.data(name='label', shape=[1], dtype='int64')

+

+ # predict = softmax_regression() # uncomment for Softmax回归

+ # predict = multilayer_perceptron() # uncomment for 多层感知器

+ predict = convolutional_neural_network() # uncomment for LeNet5卷积神经网络

+ cost = fluid.layers.cross_entropy(input=predict, label=label)

+ avg_cost = fluid.layers.mean(cost)

+ acc = fluid.layers.accuracy(input=predict, label=label)

+ return [avg_cost, acc]

+

+

+```

+

+#### Optimizer Function 配置

+

+在下面的 `Adam optimizer`,`learning_rate` 是训练的速度,与网络的训练收敛速度有关系。

+

+```python

+def optimizer_program():

+ return fluid.optimizer.Adam(learning_rate=0.001)

+```

+

+### 数据集 Feeders 配置

+

+下一步,我们开始训练过程。`paddle.dataset.movielens.train()`和`paddle.dataset.movielens.test()`分别做训练和测试数据集。这两个函数各自返回一个reader——PaddlePaddle中的reader是一个Python函数,每次调用的时候返回一个Python yield generator。

+

+下面`shuffle`是一个reader decorator,它接受一个reader A,返回另一个reader B。reader B 每次读入`buffer_size`条训练数据到一个buffer里,然后随机打乱其顺序,并且逐条输出。

+

+`batch`是一个特殊的decorator,它的输入是一个reader,输出是一个batched reader。在PaddlePaddle里,一个reader每次yield一条训练数据,而一个batched reader每次yield一个minibatch。

+

+```python

+train_reader = paddle.batch(

+ paddle.reader.shuffle(

+ paddle.dataset.mnist.train(), buf_size=500),

+ batch_size=64)

+

+test_reader = paddle.batch(

+ paddle.dataset.mnist.test(), batch_size=64)

+```

+

+### Trainer 配置

+

+现在,我们需要配置 `Trainer`。`Trainer` 需要接受训练程序 `train_program`, `place` 和优化器 `optimizer`。

+

+```python

+# 该模型运行在单个CPU上

+use_cuda = False # set to True if training with GPU

+place = fluid.CUDAPlace(0) if use_cuda else fluid.CPUPlace()

+

+trainer = fluid.Trainer(

+ train_func=train_program, place=place, optimizer_func=optimizer_program)

+```

+

+#### Event Handler 配置

+

+Fluid API 在训练期间为回调函数提供了一个钩子。用户能够通过机制监控培训进度。

+我们将在这里演示两个 `event_handler` 程序。请随意修改 Jupyter 笔记本 ,看看有什么不同。

+

+`event_handler` 用来在训练过程中输出训练结果

+

+```python

+# Save the parameter into a directory. The Inferencer can load the parameters from it to do infer

+params_dirname = "recognize_digits_network.inference.model"

+lists = []

+def event_handler(event):

+ if isinstance(event, fluid.EndStepEvent):

+ if event.step % 100 == 0:

+ # event.metrics maps with train program return arguments.

+ # event.metrics[0] will yeild avg_cost and event.metrics[1] will yeild acc in this example.

+ print("Pass %d, Batch %d, Cost %f" % (

+ event.step, event.epoch, event.metrics[0]))

+

+ if isinstance(event, fluid.EndEpochEvent):

+ avg_cost, acc = trainer.test(

+ reader=test_reader, feed_order=['img', 'label'])

+

+ print("Test with Epoch %d, avg_cost: %s, acc: %s" % (event.epoch, avg_cost, acc))

+

+ # save parameters

+ trainer.save_params(params_dirname)

+ lists.append((event.epoch, avg_cost, acc))

+```

+

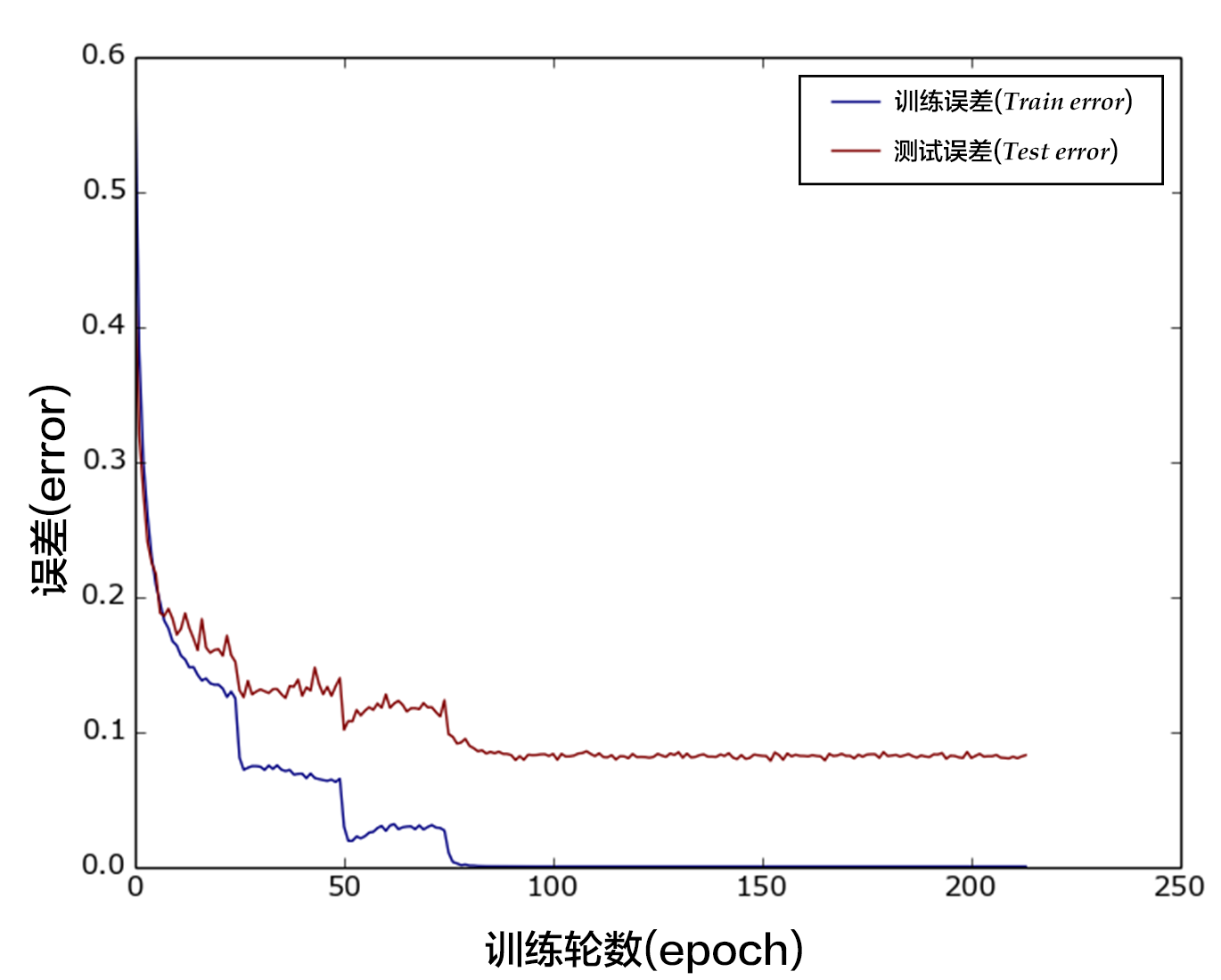

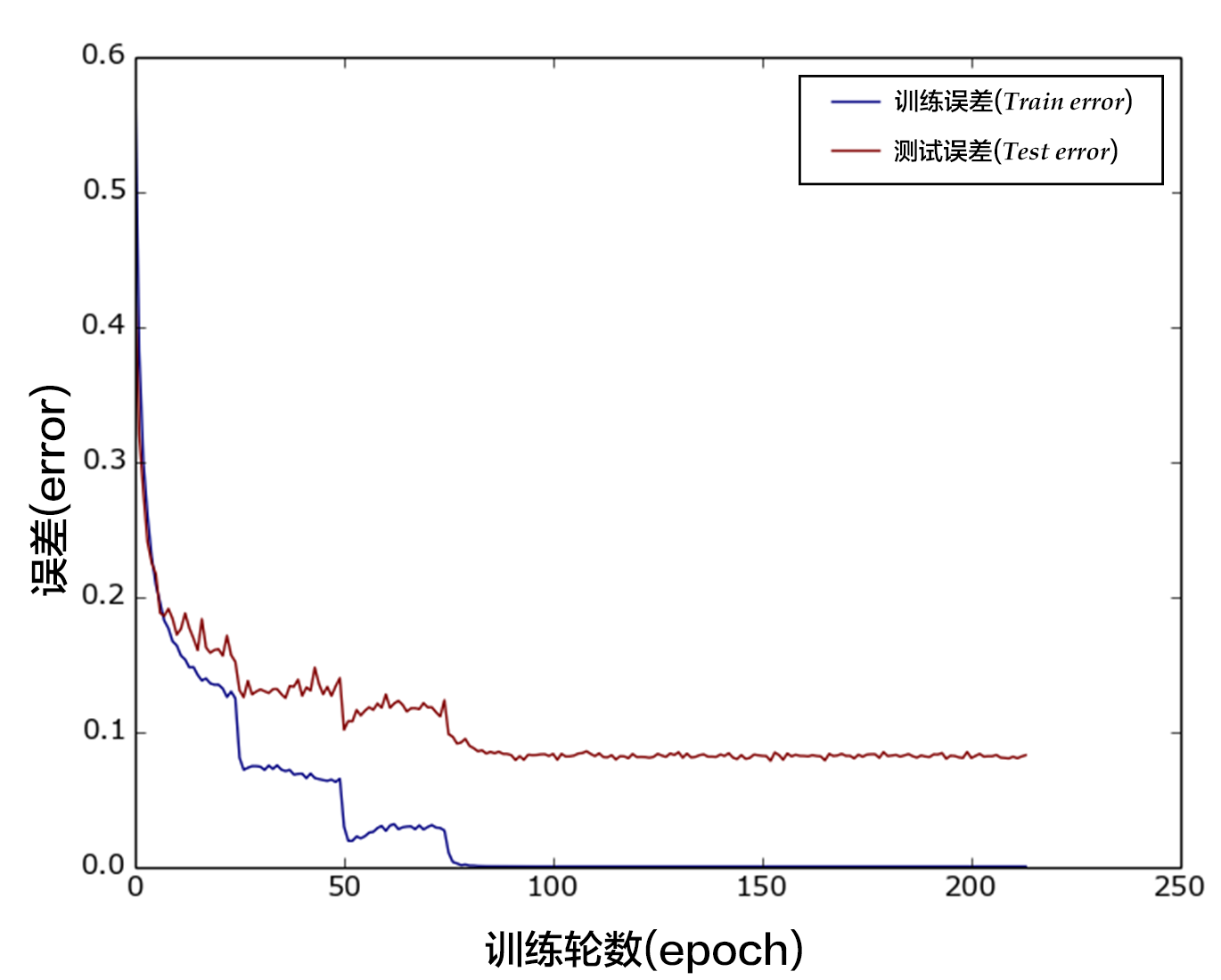

+`event_handler_plot` 可以用来在训练过程中画图如下:

+

+

+

+图7 训练结果

+

+

+

+```python

+from paddle.v2.plot import Ploter

+

+train_title = "Train cost"

+test_title = "Test cost"

+cost_ploter = Ploter(train_title, test_title)

+step = 0

+lists = []

+

+# event_handler to plot a figure

+def event_handler_plot(event):

+ global step

+ if isinstance(event, fluid.EndStepEvent):

+ if step % 100 == 0:

+ # event.metrics maps with train program return arguments.

+ # event.metrics[0] will yeild avg_cost and event.metrics[1] will yeild acc in this example.

+ cost_ploter.append(train_title, step, event.metrics[0])

+ cost_ploter.plot()

+ step += 1

+ if isinstance(event, fluid.EndEpochEvent):

+ # save parameters

+ trainer.save_params(params_dirname)

+

+ avg_cost, acc = trainer.test(

+ reader=test_reader, feed_order=['img', 'label'])

+ cost_ploter.append(test_title, step, avg_cost)

+ lists.append((event.epoch, avg_cost, acc))

+```

+

+#### 开始训练

+

+既然我们设置了 `event_handler` 和 `data reader`,我们就可以开始训练模型了。

+

+`feed_order` 用于将数据目录映射到 `train_program`

+

+```python

+trainer.train(

+ num_epochs=5,

+ event_handler=event_handler,

+ reader=train_reader,

+ feed_order=['img', 'label'])

+```

+

+训练过程是完全自动的,event_handler里打印的日志类似如下所示:

+

+```

+Pass 0, Batch 0, Cost 0.125650

+Pass 100, Batch 0, Cost 0.161387

+Pass 200, Batch 0, Cost 0.040036

+Pass 300, Batch 0, Cost 0.023391

+Pass 400, Batch 0, Cost 0.005856

+Pass 500, Batch 0, Cost 0.003315

+Pass 600, Batch 0, Cost 0.009977

+Pass 700, Batch 0, Cost 0.020959

+Pass 800, Batch 0, Cost 0.105560

+Pass 900, Batch 0, Cost 0.239809

+Test with Epoch 0, avg_cost: 0.053097883707459624, acc: 0.9822850318471338

+```

+

+训练之后,检查模型的预测准确度。用 MNIST 训练的时候,一般 softmax回归模型的分类准确率为约为 92.34%,多层感知器为97.66%,卷积神经网络可以达到 99.20%。

+

+

+## 应用模型

+

+可以使用训练好的模型对手写体数字图片进行分类,下面程序展示了如何使用 `fluid.Inferencer` 接口进行推断。

+

+### Inference 配置

+

+`Inference` 需要一个 `infer_func` 和 `param_path` 来设置网络和经过训练的参数。

+我们可以简单地插入在此之前定义的分类器。

+

+```python

+inferencer = fluid.Inferencer(

+ # infer_func=softmax_regression, # uncomment for softmax regression

+ # infer_func=multilayer_perceptron, # uncomment for MLP

+ infer_func=convolutional_neural_network, # uncomment for LeNet5

+ param_path=params_dirname,

+ place=place)

+```

+

+### 生成预测输入数据

+

+`infer_3.png` 是数字 3 的一个示例图像。把它变成一个 numpy 数组以匹配数据馈送格式。

+

+```python

+# Prepare the test image

+import os

+import numpy as np

+from PIL import Image

+def load_image(file):

+ im = Image.open(file).convert('L')

+ im = im.resize((28, 28), Image.ANTIALIAS)

+ im = np.array(im).reshape(1, 1, 28, 28).astype(np.float32)

+ im = im / 255.0 * 2.0 - 1.0

+ return im

+

+cur_dir = cur_dir = os.getcwd()

+img = load_image(cur_dir + '/image/infer_3.png')

+```

+

+### 预测

+

+现在我们准备做预测。

+

+```python

+results = inferencer.infer({'img': img})

+lab = np.argsort(results) # probs and lab are the results of one batch data

+print ("Inference result of image/infer_3.png is: %d" % lab[0][0][-1])

+```

+

+## 总结

+

+本教程的softmax回归、多层感知器和卷积神经网络是最基础的深度学习模型,后续章节中复杂的神经网络都是从它们衍生出来的,因此这几个模型对之后的学习大有裨益。同时,我们也观察到从最简单的softmax回归变换到稍复杂的卷积神经网络的时候,MNIST数据集上的识别准确率有了大幅度的提升,原因是卷积层具有局部连接和共享权重的特性。在之后学习新模型的时候,希望大家也要深入到新模型相比原模型带来效果提升的关键之处。此外,本教程还介绍了PaddlePaddle模型搭建的基本流程,从dataprovider的编写、网络层的构建,到最后的训练和预测。对这个流程熟悉以后,大家就可以用自己的数据,定义自己的网络模型,并完成自己的训练和预测任务了。

+

+## 参考文献

+

+1. LeCun, Yann, Léon Bottou, Yoshua Bengio, and Patrick Haffner. ["Gradient-based learning applied to document recognition."](http://ieeexplore.ieee.org/abstract/document/726791/) Proceedings of the IEEE 86, no. 11 (1998): 2278-2324.

+2. Wejéus, Samuel. ["A Neural Network Approach to Arbitrary SymbolRecognition on Modern Smartphones."](http://www.diva-portal.org/smash/record.jsf?pid=diva2%3A753279&dswid=-434) (2014).

+3. Decoste, Dennis, and Bernhard Schölkopf. ["Training invariant support vector machines."](http://link.springer.com/article/10.1023/A:1012454411458) Machine learning 46, no. 1-3 (2002): 161-190.

+4. Simard, Patrice Y., David Steinkraus, and John C. Platt. ["Best Practices for Convolutional Neural Networks Applied to Visual Document Analysis."](http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.160.8494&rep=rep1&type=pdf) In ICDAR, vol. 3, pp. 958-962. 2003.

+5. Salakhutdinov, Ruslan, and Geoffrey E. Hinton. ["Learning a Nonlinear Embedding by Preserving Class Neighbourhood Structure."](http://www.jmlr.org/proceedings/papers/v2/salakhutdinov07a/salakhutdinov07a.pdf) In AISTATS, vol. 11. 2007.

+6. Cireşan, Dan Claudiu, Ueli Meier, Luca Maria Gambardella, and Jürgen Schmidhuber. ["Deep, big, simple neural nets for handwritten digit recognition."](http://www.mitpressjournals.org/doi/abs/10.1162/NECO_a_00052) Neural computation 22, no. 12 (2010): 3207-3220.

+7. Deng, Li, Michael L. Seltzer, Dong Yu, Alex Acero, Abdel-rahman Mohamed, and Geoffrey E. Hinton. ["Binary coding of speech spectrograms using a deep auto-encoder."](http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.185.1908&rep=rep1&type=pdf) In Interspeech, pp. 1692-1695. 2010.

+8. Kégl, Balázs, and Róbert Busa-Fekete. ["Boosting products of base classifiers."](http://dl.acm.org/citation.cfm?id=1553439) In Proceedings of the 26th Annual International Conference on Machine Learning, pp. 497-504. ACM, 2009.

+9. Rosenblatt, Frank. ["The perceptron: A probabilistic model for information storage and organization in the brain."](http://psycnet.apa.org/journals/rev/65/6/386/) Psychological review 65, no. 6 (1958): 386.

+10. Bishop, Christopher M. ["Pattern recognition."](http://users.isr.ist.utl.pt/~wurmd/Livros/school/Bishop%20-%20Pattern%20Recognition%20And%20Machine%20Learning%20-%20Springer%20%202006.pdf) Machine Learning 128 (2006): 1-58.

+

+

+

本教程

本教程 由

PaddlePaddle 创作,采用

知识共享 署名-相同方式共享 4.0 国际 许可协议进行许可。