“2eae3616006ef1e1ff440211c5bb8c4399089318”上不存在“develop/api_doc/v2/fluid.html”

Polish documents (#143)

* update all docs involving color label * modify usage.md * usage.md * Update data_prepare.md * Update jingling2seg.md * Update jingling2seg.md * Update labelme2seg.md * Update jingling2seg.md * a * Update config.md * Update config.md * Update config.py * Update config.py * Update config.py * Update config.md * Update basic_group.md * Update basic_group.md * Update data_aug.md * Update config.md * Update finetune_pspnet.md * Update finetune_pspnet.md * Update finetune_unet.md * Update finetune_unet.md * Update finetune_icnet.md * Update finetune_pspnet.md * Update finetune_hrnet.md * Update README.md * Update finetune_deeplabv3plus.md * Update finetune_deeplabv3plus.md * Update README.md * Update config.md * Update train_group.md * Update models.md * Update model_group.md * Update model_group.md * Update train_group.md * Update train_group.md * Update model_group.md * Update model_group.md * Update README.md * Update README.md * Update models.md * Add files via upload * Add files via upload * Update models.md * Update models.md * Add files via upload * Update README.md * Update models.md * Update models.md * Update models.md * Update models.md * Update models.md * Update models.md * Update models.md * Update models.md * Update models.md * Add files via upload * Update models.md * Update models.md * Update loss_select.md * Update README.md * Update loss_select.md * Add files via upload * Update loss_select.md * Add files via upload * Update loss_select.md * Update README.md * Add files via upload * Update models.md * Add files via upload * Update models.md * Update models.md * Create 1 * Delete 1 * Create 1 * Add files via upload * Delete 1 * Add files via upload * Add files via upload * Update README.md * Add files via upload * Update finetune_deeplabv3plus.md * Update finetune_icnet.md * Update finetune_pspnet.md * Update finetune_hrnet.md * Update finetune_unet.md * Update config.md * Update config.md * Update usage.md * Update usage.md * Update usage.md * Update usage.md * Update usage.md * Update usage.md * Update usage.md * Update usage.md * Create download_optic.py * Add files via upload * Add files via upload * Update usage.md * Update README.md * Update usage.md * Update usage.md * Update usage.md * Add files via upload * Delete deeplabv3p_xception65_pet.yaml * Delete hrnet_w18_pet.yaml * Delete icnet_pet.yaml * Delete pspnet.yaml * Delete unet_pet.yaml

Showing

configs/hrnet_optic.yaml

0 → 100644

configs/hrnet_w18_pet.yaml

已删除

100644 → 0

configs/icnet_optic.yaml

0 → 100644

configs/icnet_pet.yaml

已删除

100644 → 0

configs/pspnet.yaml

已删除

100644 → 0

configs/pspnet_optic.yaml

0 → 100644

configs/unet_optic.yaml

0 → 100644

configs/unet_pet.yaml

已删除

100644 → 0

dataset/download_optic.py

0 → 100644

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

| W: | H:

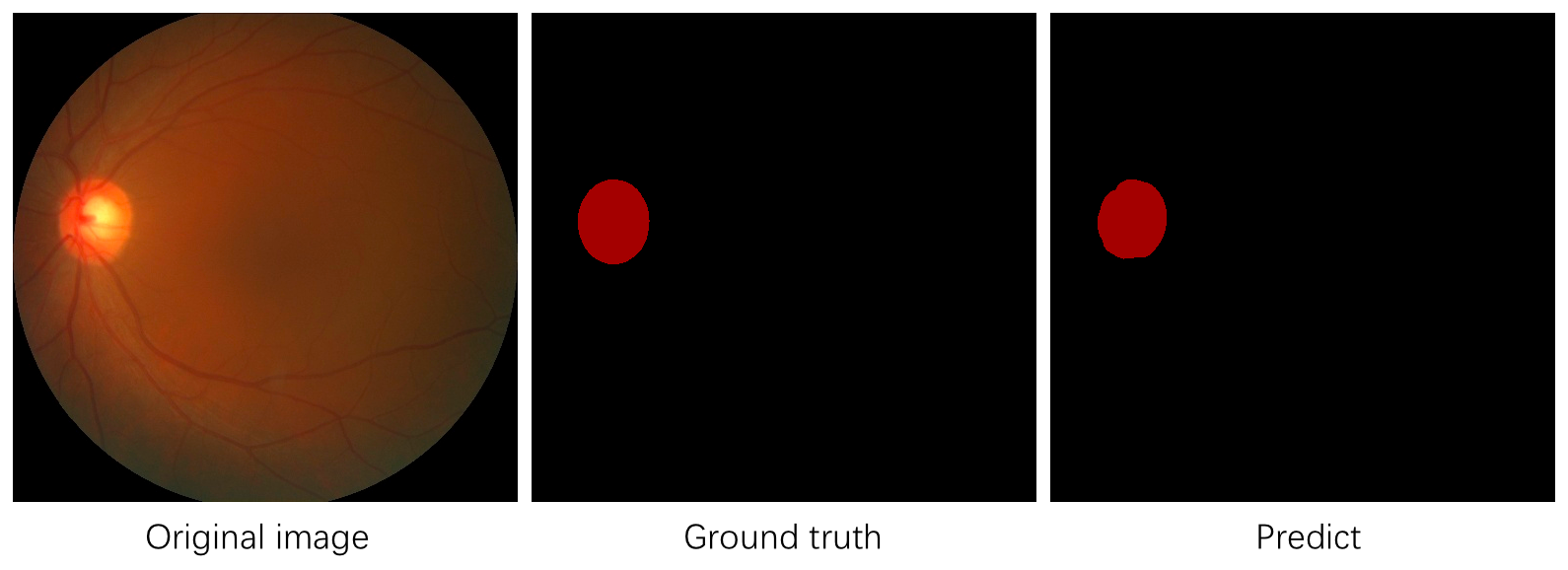

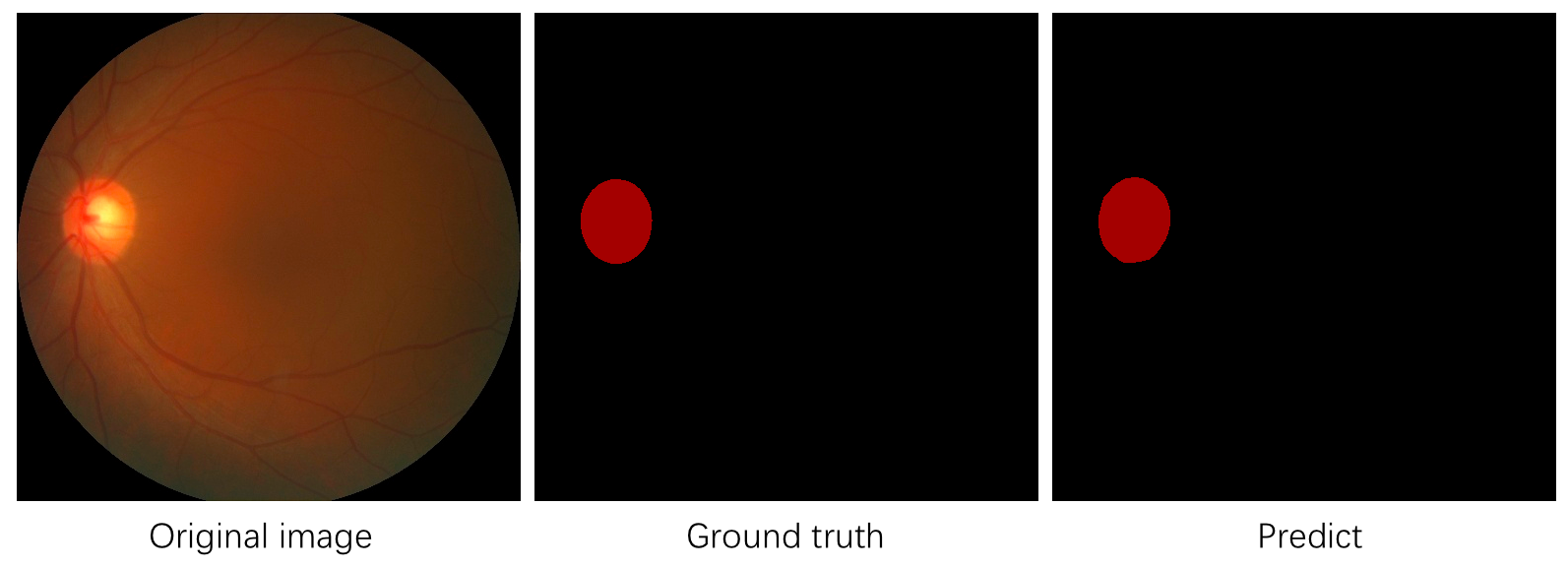

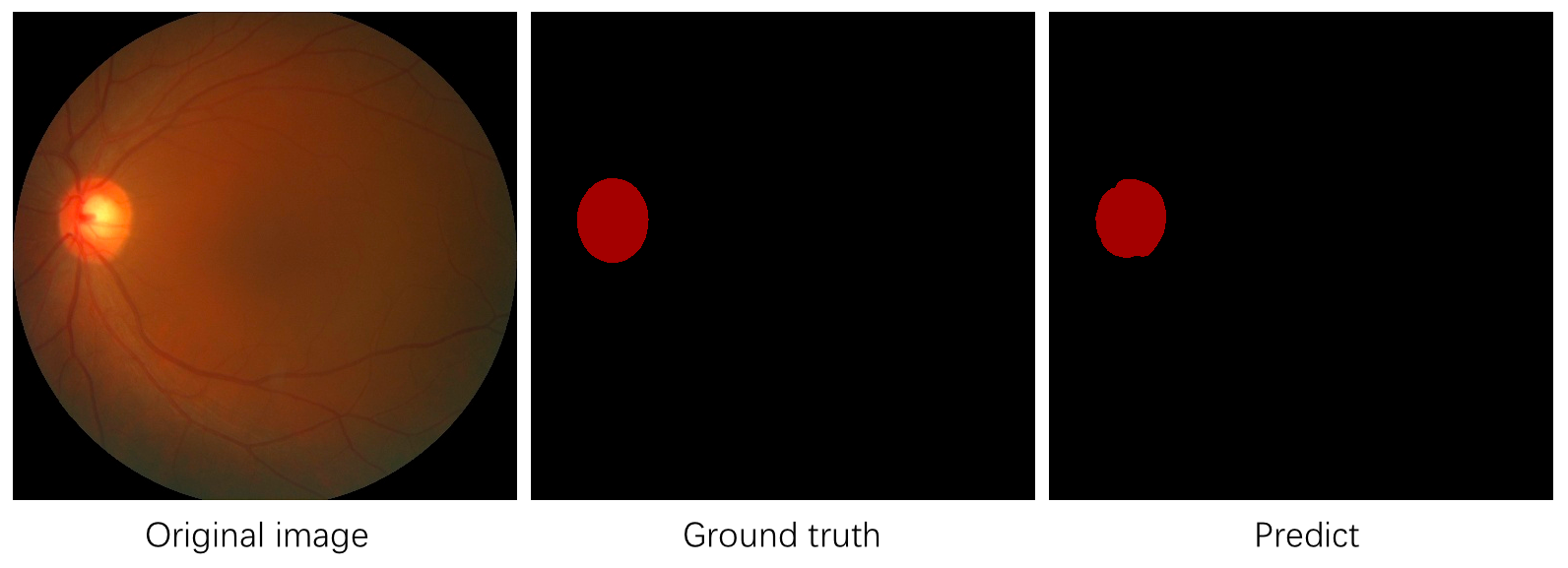

turtorial/imgs/optic.png

0 → 100644

380.6 KB

turtorial/imgs/optic_deeplab.png

0 → 100644

325.8 KB

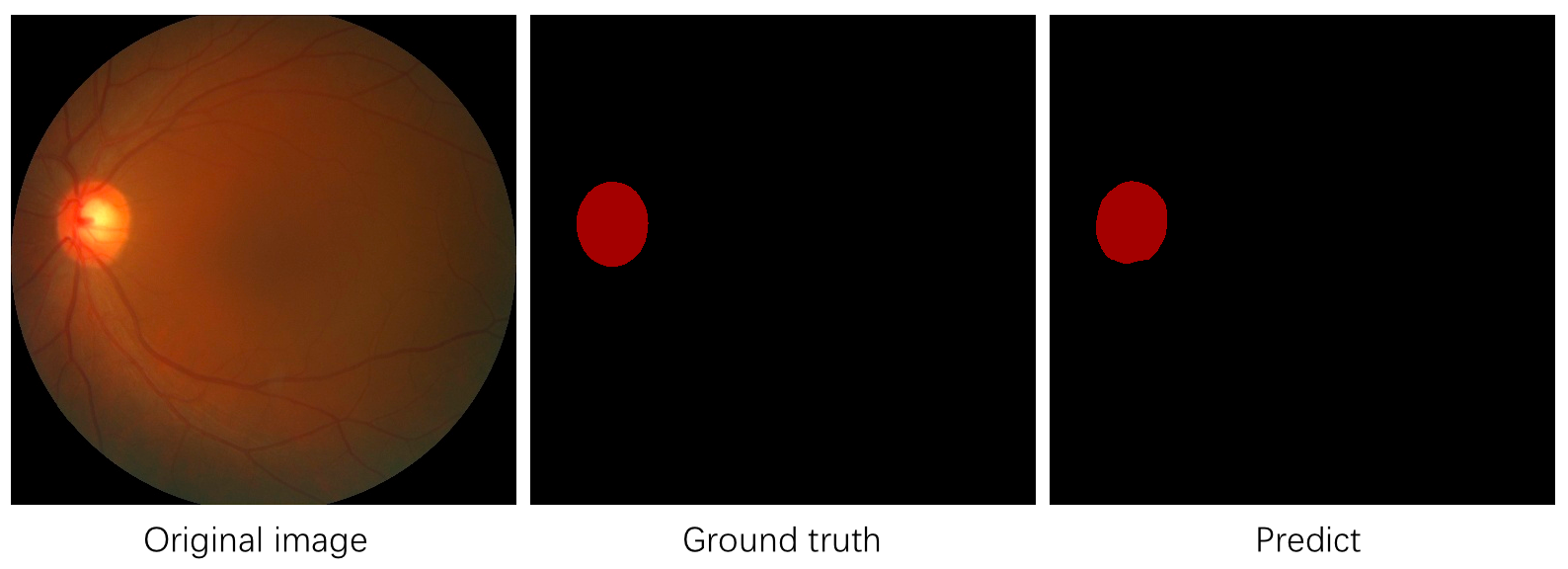

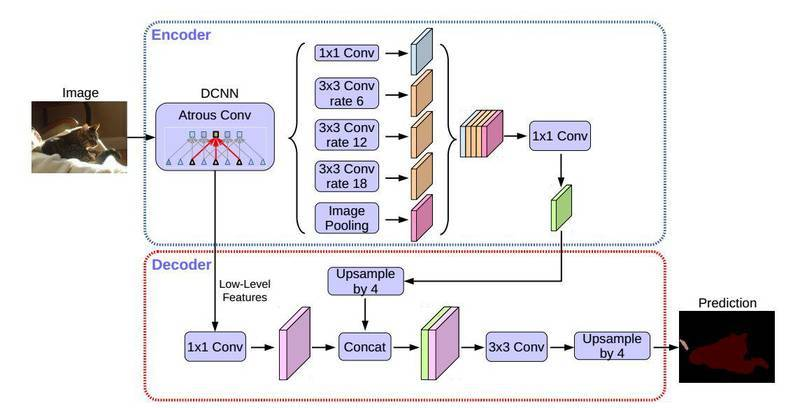

turtorial/imgs/optic_hrnet.png

0 → 100644

325.7 KB

turtorial/imgs/optic_icnet.png

0 → 100644

326.0 KB

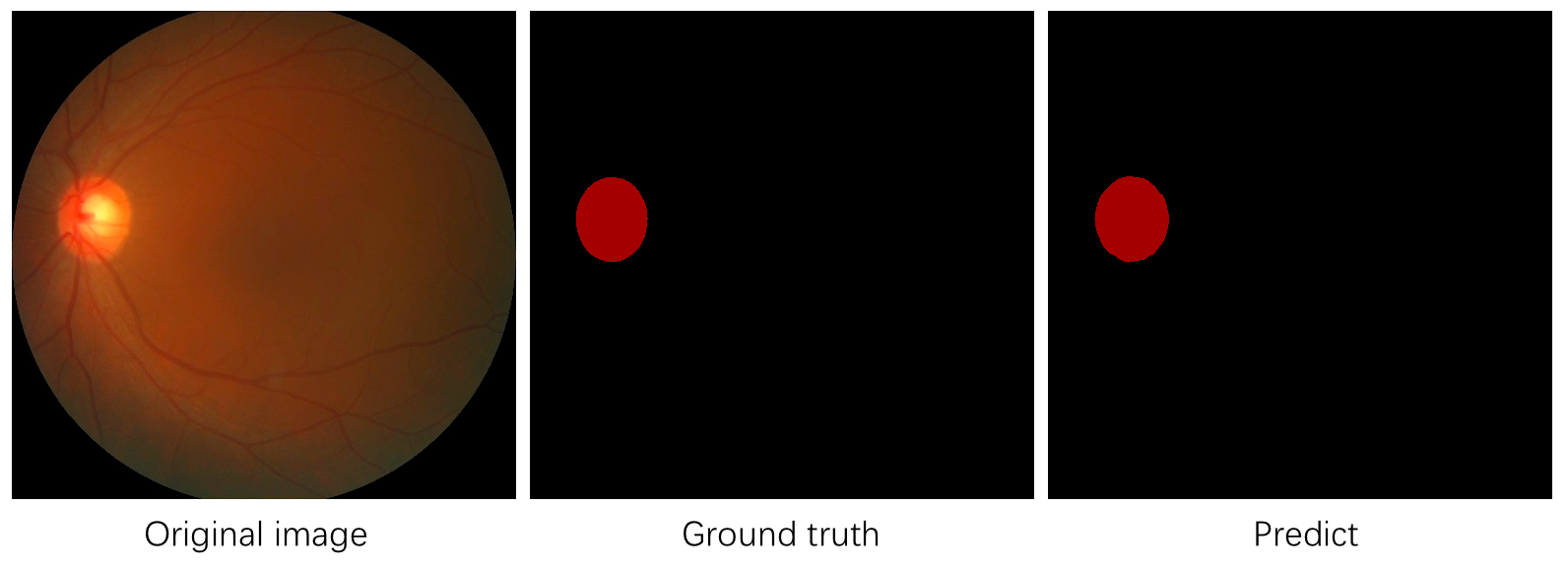

turtorial/imgs/optic_pspnet.png

0 → 100644

325.6 KB

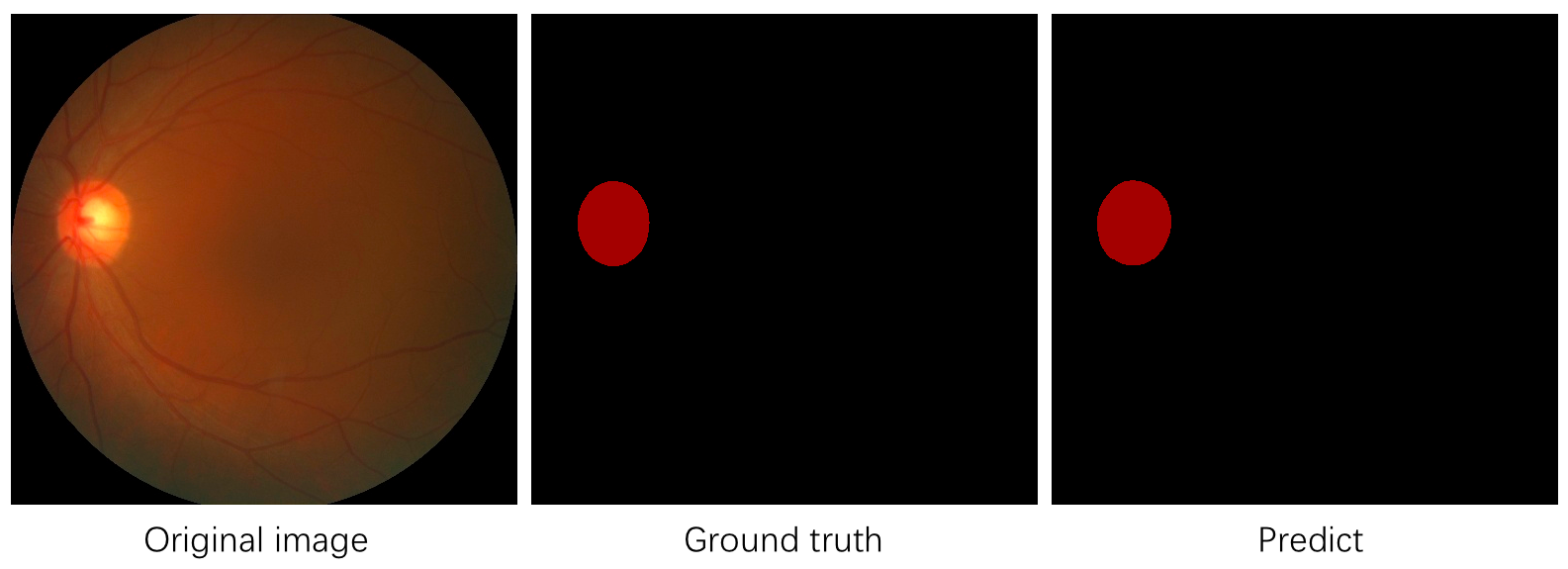

turtorial/imgs/optic_unet.png

0 → 100644

325.8 KB