Merge branch 'release/v0.1.0'

Showing

docs/imgs/annotation/image-10.jpg

0 → 100644

820.0 KB

inference/docs/demo.jpg

0 → 100644

2.2 MB

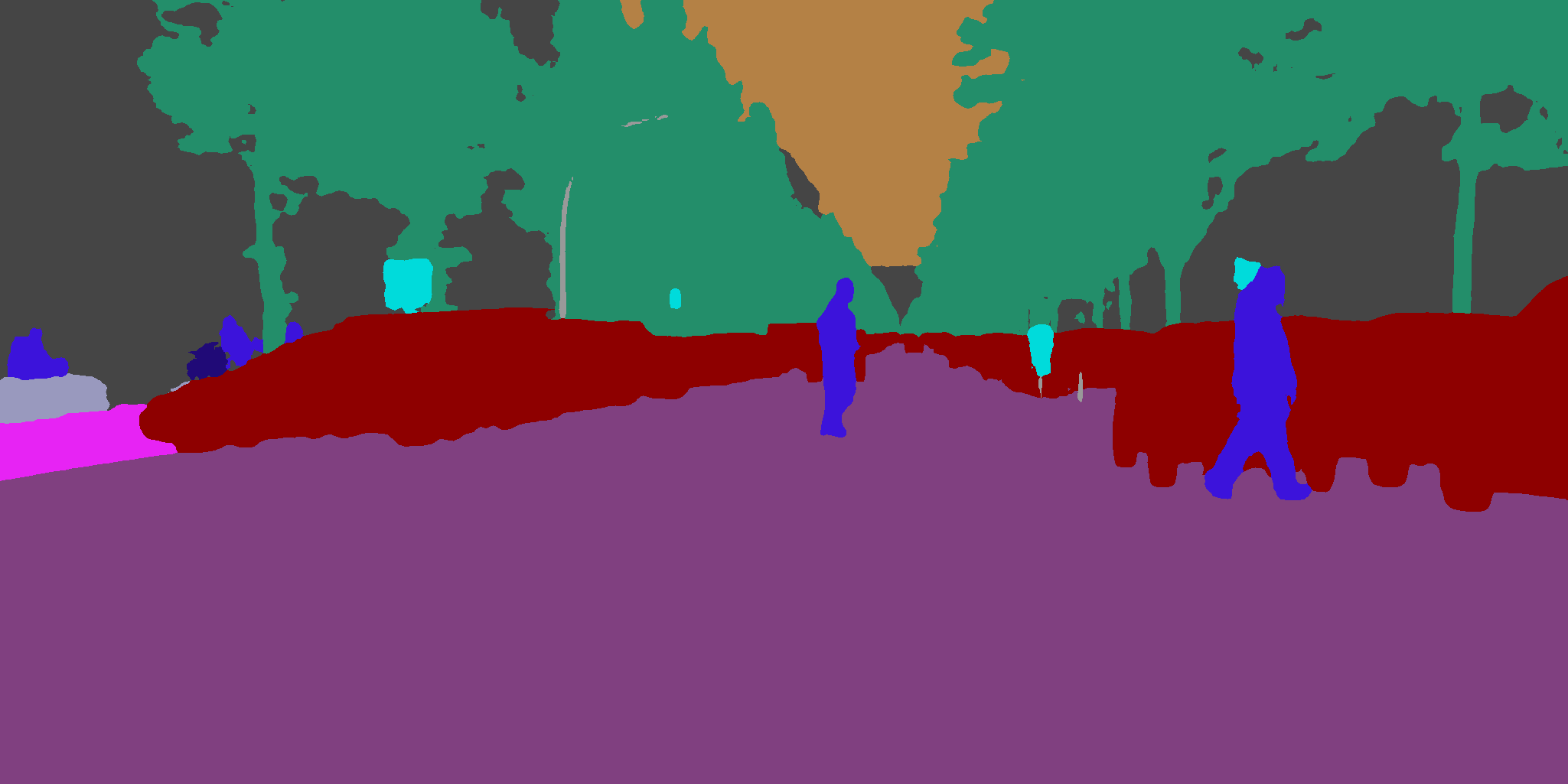

inference/docs/demo_jpg.png

0 → 100644

23.3 KB

inference/docs/vis.md

0 → 100644

inference/docs/vis_result.png

0 → 100644

50.5 KB