diff --git a/README_ch.md b/README_ch.md

index 2ca73fdc5b2c1b1e504cf4ec8eef2d0dcb13deb4..8797222703b0651e9ed7a38609a4f60f1e7442d4 100644

--- a/README_ch.md

+++ b/README_ch.md

@@ -4,38 +4,29 @@

## 简介

-飞桨图像识别套件PaddleClas是飞桨为工业界和学术界所准备的一个图像识别和图像分类任务的工具集,助力使用者训练出更好的视觉模型和应用落地。

-

-

-

-

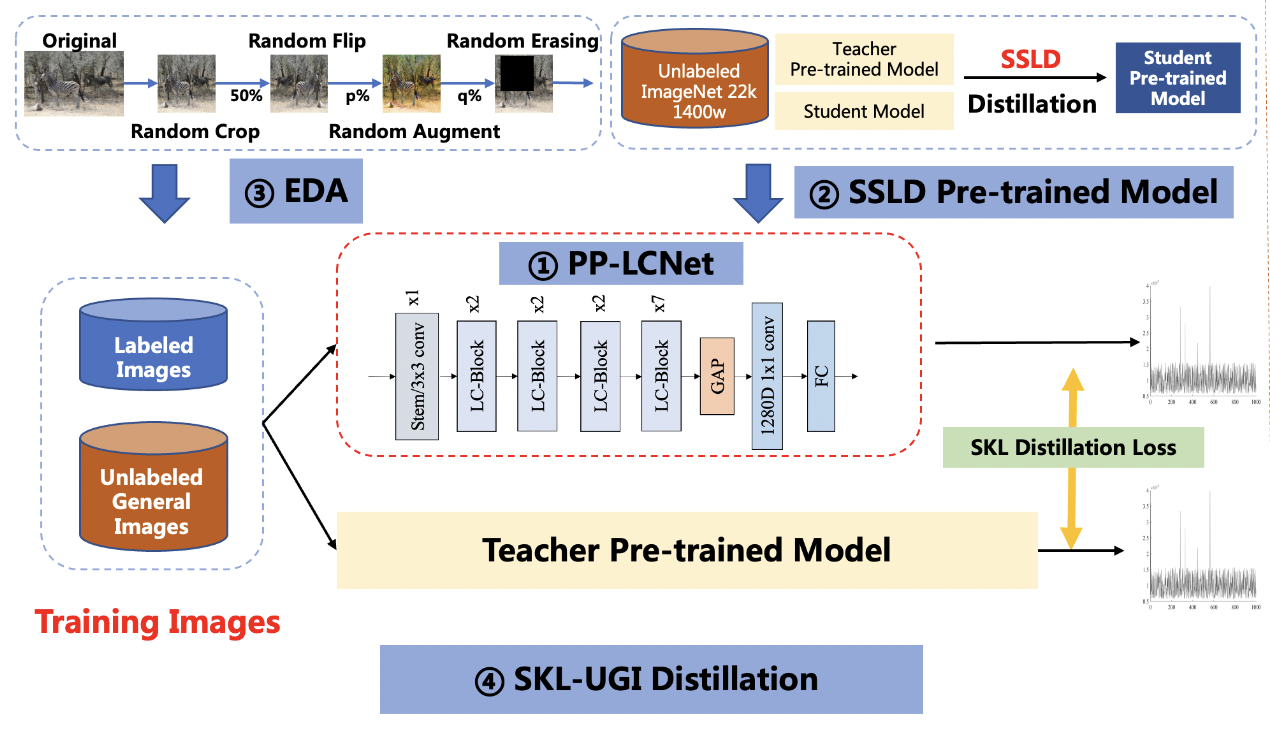

PULC实用图像分类模型效果展示

-

-

PP-ShiTu图像识别系统效果展示

+

PP-ShiTuV2图像识别系统效果展示

-## 近期更新

-- 📢将于**6月15-6月17日晚20:30** 进行为期三天的课程直播,详细介绍超轻量图像分类方案,对各场景模型优化原理及使用方式进行拆解,之后还有产业案例全流程实操,对各类痛难点解决方案进行手把手教学,加上现场互动答疑,抓紧扫码上车吧!

-

+

+

PULC实用图像分类模型效果展示

+

+

PP-ShiTuV2 Android Demo

+

-

-

-

-

+

+

+

+

+

+

界面按钮展示

+

+

+

新建库

+

+

+

打开库

+

+

+

图像操作

+

-

- -

- -

- +

+ +

+ -

- +

+

+

+ -

-

-

-

+

+ +

+ +

+ +

+ +

+ +

+