update docs

Showing

6.1 KB

22.6 KB

| W: | H:

| W: | H:

191.3 KB

| W: | H:

| W: | H:

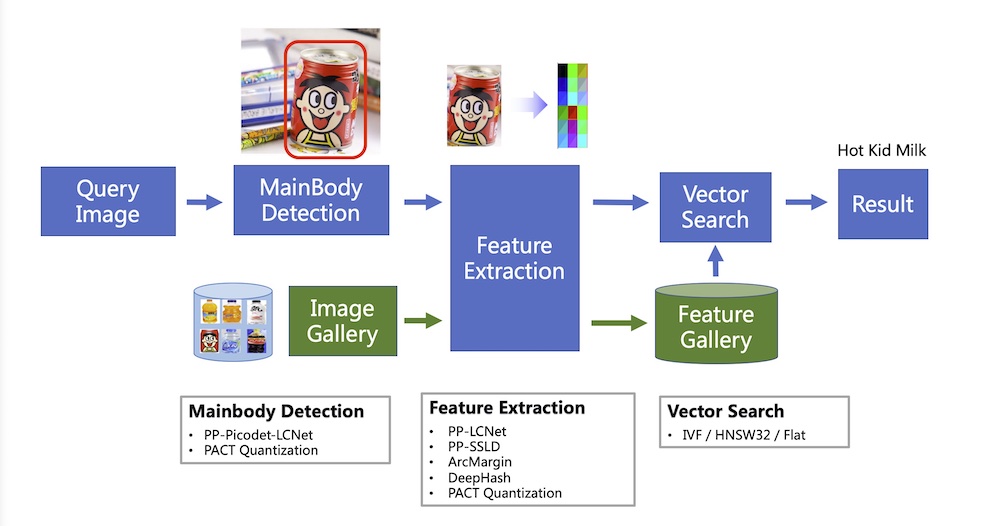

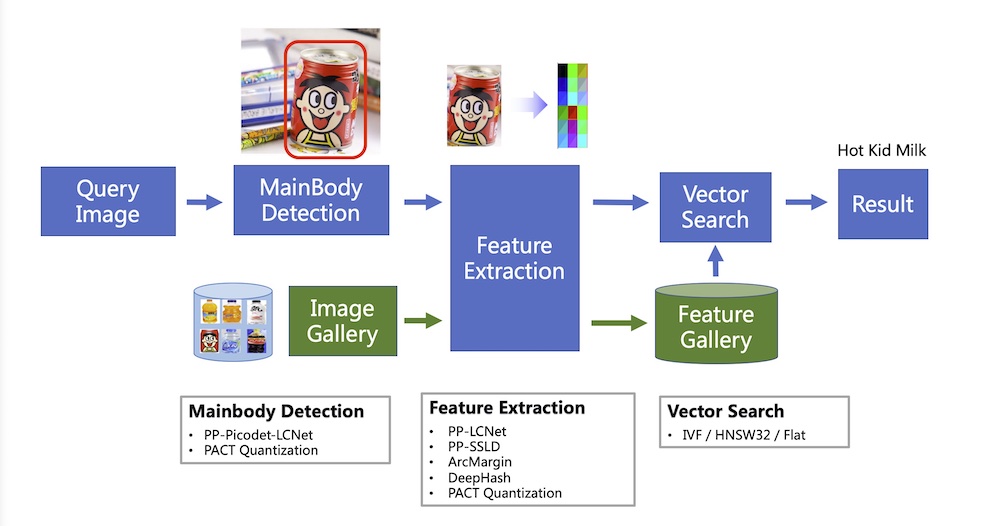

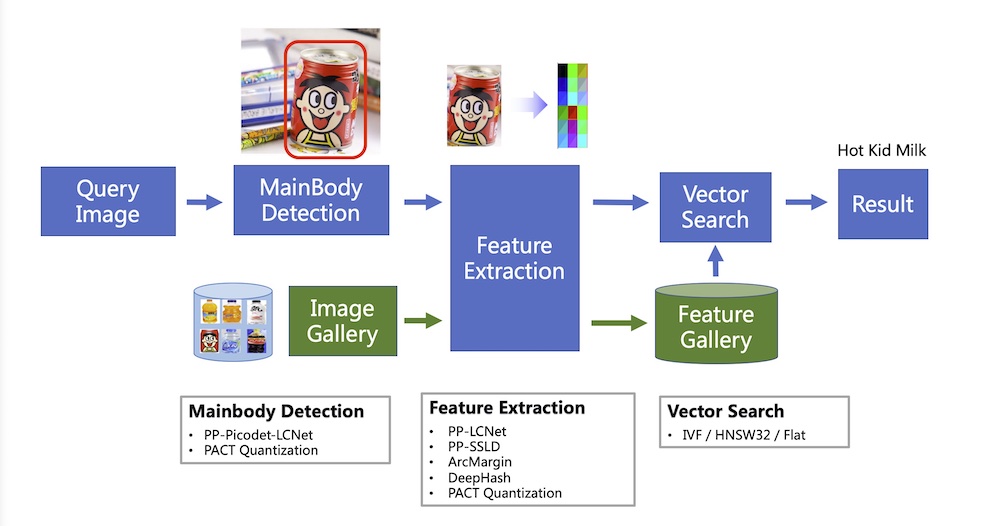

docs/images/structure.png

已删除

100644 → 0

1.8 MB

6.1 KB

22.6 KB

135.3 KB | W: | H:

135.0 KB | W: | H:

191.3 KB

98.7 KB | W: | H:

1.8 MB | W: | H:

1.8 MB