backup

Showing

Notes/Sublime-settings.md

已删除

100644 → 0

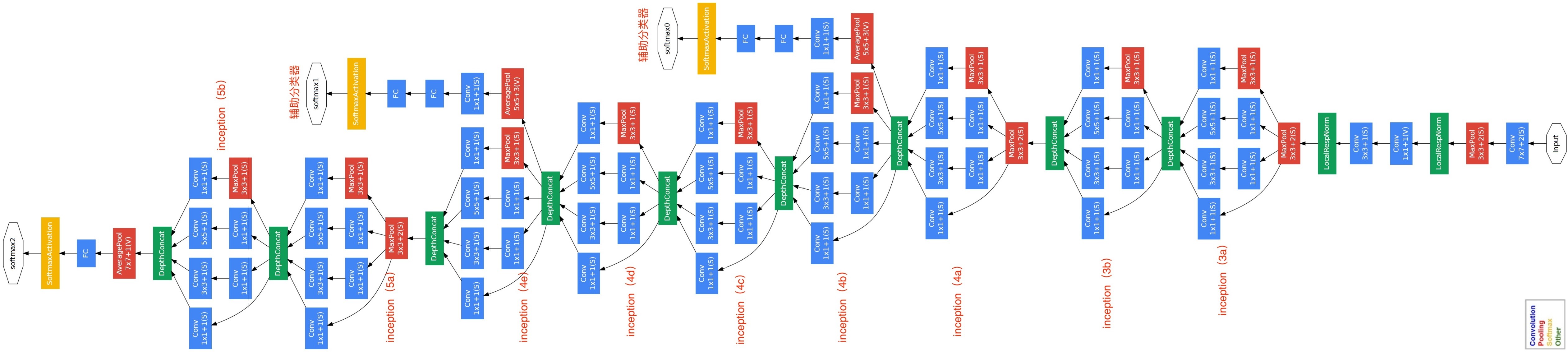

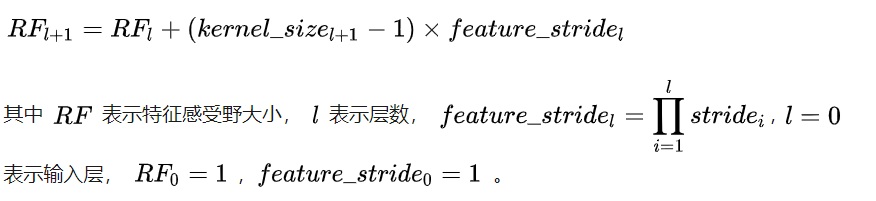

Notes/dl/CNN.md

0 → 100644

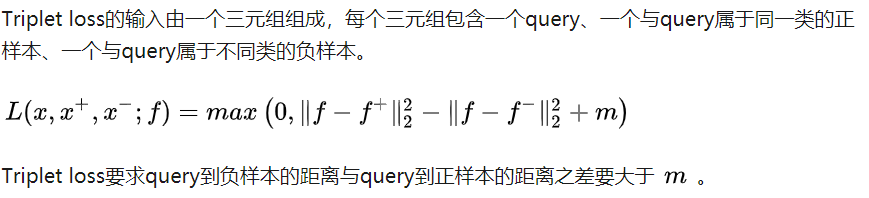

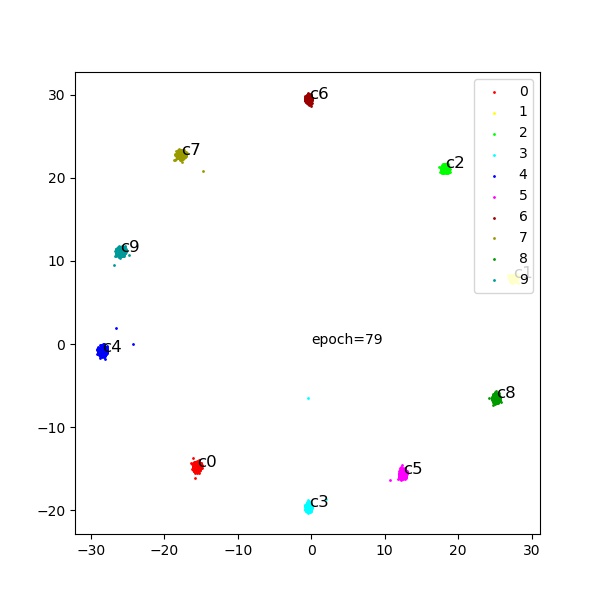

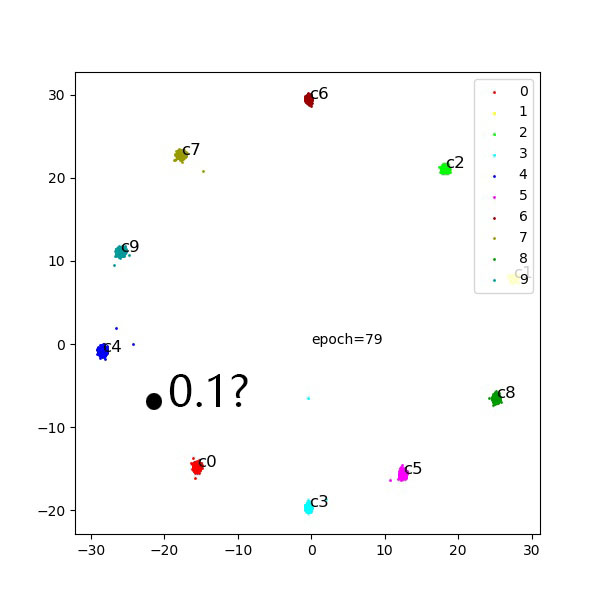

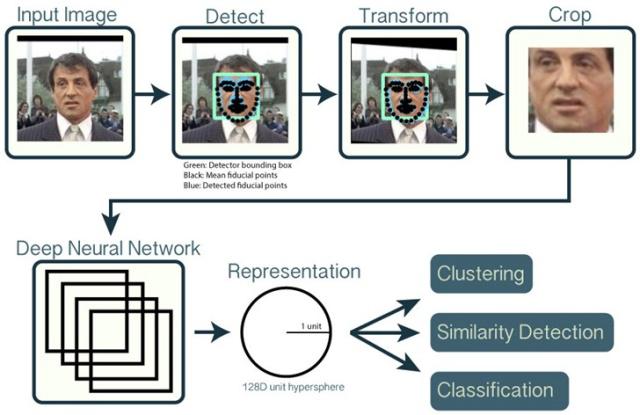

Notes/dl/DML.md

0 → 100644

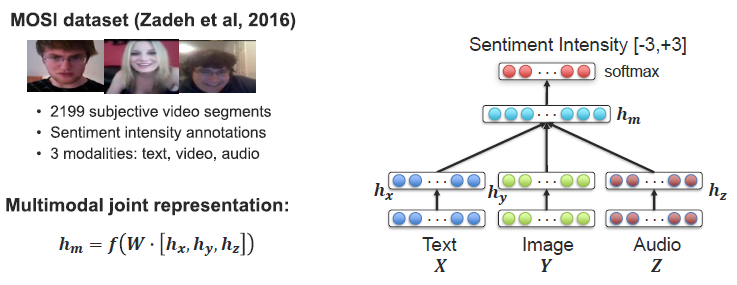

Notes/dl/MMML.md

0 → 100644

Notes/dl/md_imgs/CNN/CNN.gif

0 → 100644

984.3 KB

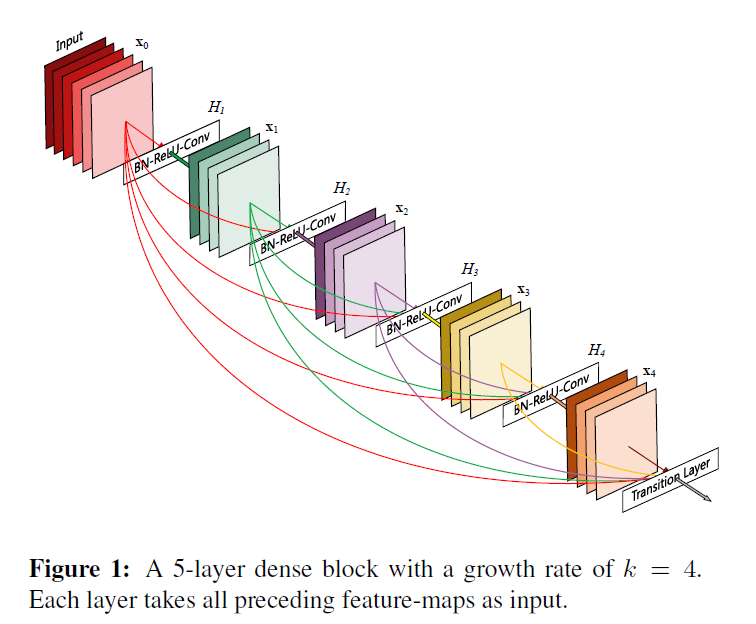

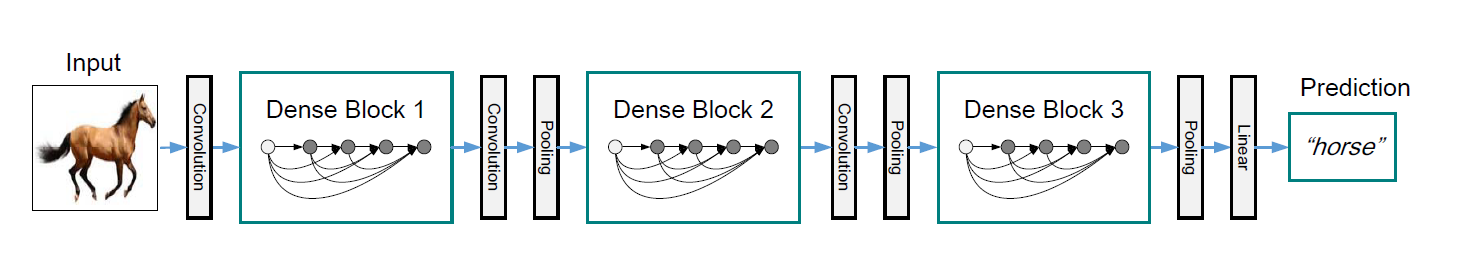

Notes/dl/md_imgs/CNN/DenseNet.jpg

0 → 100644

65.2 KB

64.5 KB

576.9 KB

Notes/dl/md_imgs/CNN/RF.jpg

0 → 100644

24.7 KB

Notes/dl/md_imgs/CNN/geili.jpg

0 → 100644

7.0 KB

Notes/dl/md_imgs/CNN/niubi.jpg

0 → 100644

8.0 KB

Notes/dl/md_imgs/CNN/nobug.jpg

0 → 100644

65.3 KB

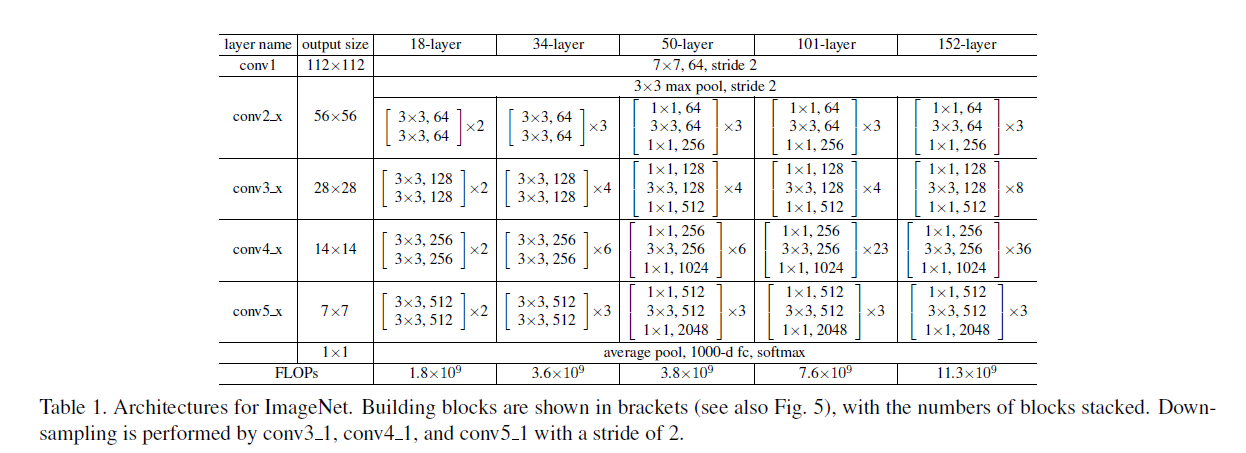

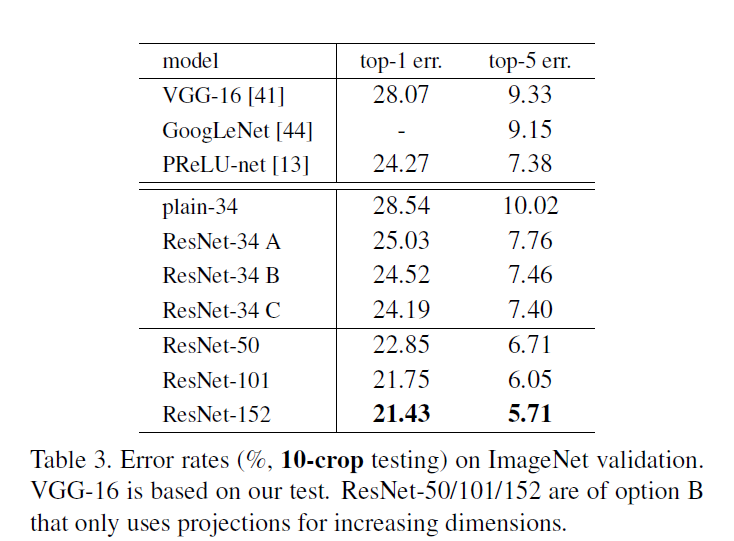

Notes/dl/md_imgs/CNN/resnet.jpg

0 → 100644

85.6 KB

Notes/dl/md_imgs/CNN/resnet_1.jpg

0 → 100644

123.0 KB

66.8 KB

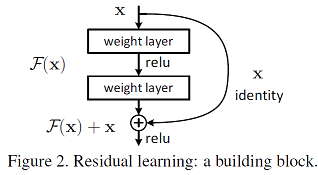

Notes/dl/md_imgs/CNN/shortcut.jpg

0 → 100644

18.5 KB

Notes/dl/md_imgs/CNN/whatfack.jpg

0 → 100644

5.4 KB

Notes/dl/md_imgs/CNN/退化.jpg

0 → 100644

103.1 KB

33.7 KB

27.3 KB

Notes/dl/md_imgs/DML/ImageNet.jpg

0 → 100644

264.7 KB

21.8 KB

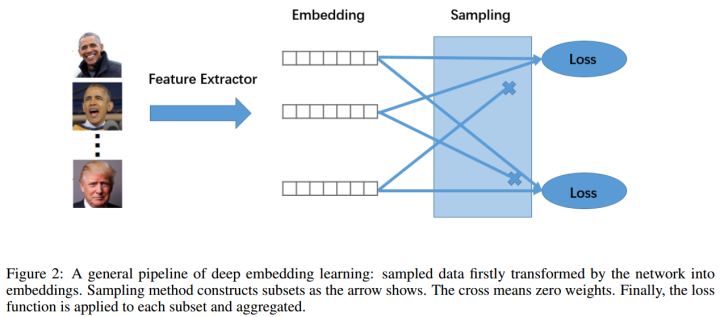

Notes/dl/md_imgs/DML/dml_eg.jpg

0 → 100644

28.4 KB

Notes/dl/md_imgs/DML/dml_eg_1.jpg

0 → 100644

41.4 KB

Notes/dl/md_imgs/DML/fecere.jpg

0 → 100644

40.9 KB

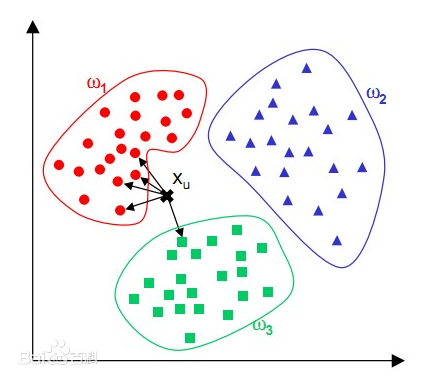

Notes/dl/md_imgs/DML/knn.png

0 → 100644

105.3 KB

Notes/dl/md_imgs/DML/mnist.png

0 → 100644

6.6 KB

78.3 KB

167.5 KB

20.5 KB

107.4 KB

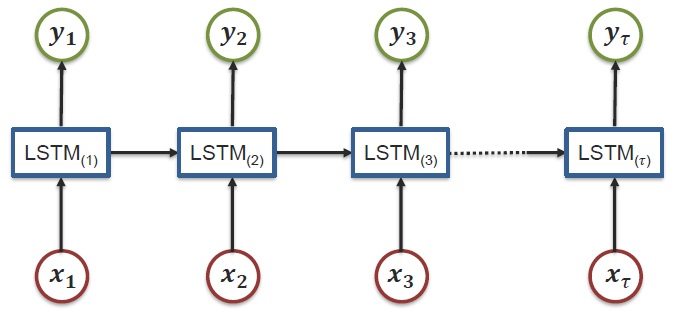

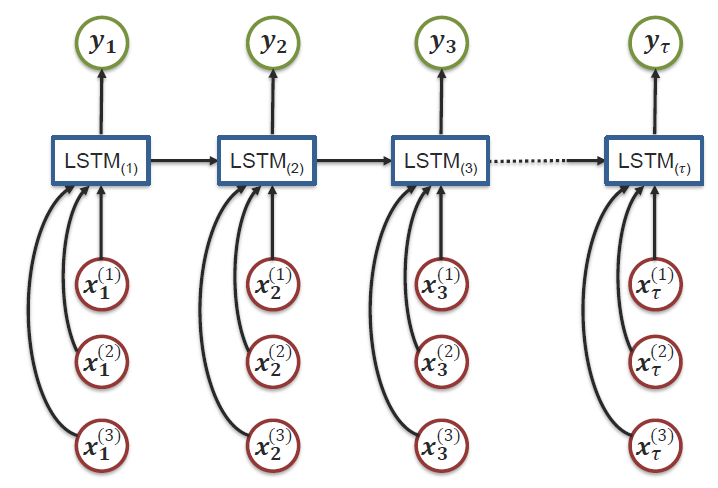

Notes/dl/md_imgs/MMML/LSTM_1.jpg

0 → 100644

30.3 KB

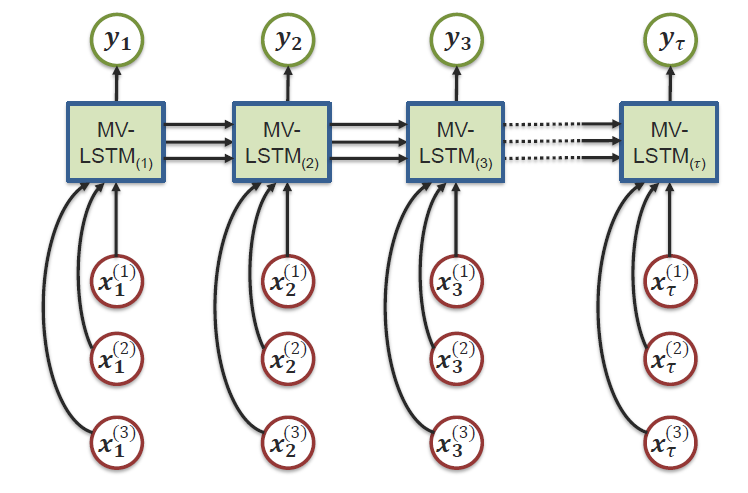

Notes/dl/md_imgs/MMML/LSTM_2.jpg

0 → 100644

74.7 KB

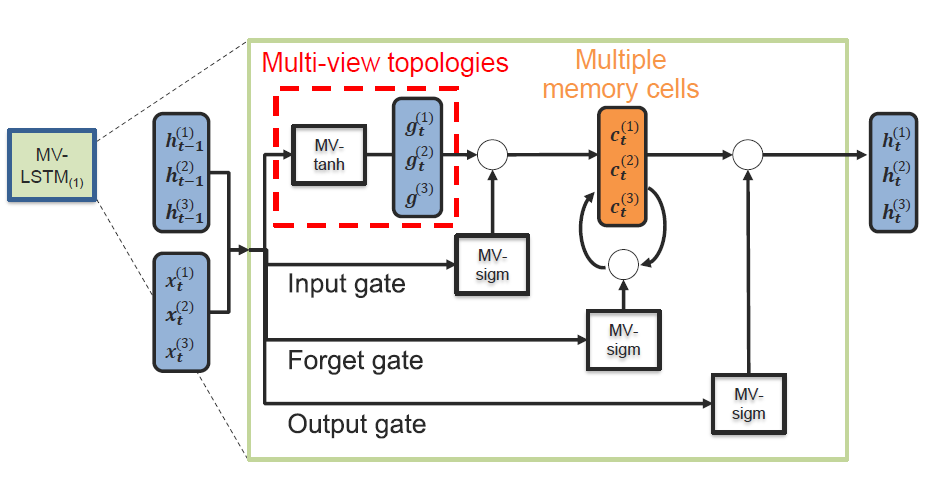

Notes/dl/md_imgs/MMML/LSTM_3.jpg

0 → 100644

80.9 KB

Notes/dl/md_imgs/MMML/LSTM_4.jpg

0 → 100644

52.8 KB

23.2 KB

26.6 KB

33.1 KB

48.7 KB

System/monitor_linux.py

已删除

100644 → 0