“本课内容就这么多,”咖哥说,“最重点的内容,是要记住逻辑回归只不过是在线性回归的基础上增加了一个Sigmoid逻辑函数,把目标值的输出限制在[0,1]区间而已。除此之外,整个流程即细节都和线性回归非常相似。当然其假设函数和损失函数和线性回归是不同的。”

逻辑回归的假设函数如下:

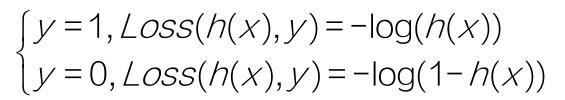

逻辑回归的损失函数如下:

另外需要牢记的是,这两种基本的机器学习算法中,线性回归多用于解决回归问题(可简单理解为数值预测型问题),而逻辑回归多用于解决分类问题。

大家不要以为线性回归和逻辑回归在深度学习时代过时了。2017年Kaggle的调查问卷显示(如下图所示),在目前数据科学家的工作中,线性回归和逻辑回归的使用率仍然高居榜首,因为这两种算法可以快速应用,作为其他解决方案的基准模型。

别小看线性回归和逻辑回归

咖哥正说着,突然问:“小冰,超参数的调试是否让你觉得有些麻烦,一个小小的C参数怎么花那么大力气画各种各样的图来观察?”

小冰说:“就是啊,怎么这么麻烦?”

咖哥说:“其实也是有自动调参的方法。”

小冰说:“快说说。”

咖哥说:“这个以后再讲吧。先记住已经学的基础知识。”

机器学习解决现实问题的超强能力让小冰新奇而又兴奋,她真的觉得过瘾极了。机器学习的两个模型已经解决了困扰着她的两个非常实际的业务问题,那么下一课,咖哥又将介绍一些什么新的模型呢?她迫不及待地想要知道。