咖哥发言

咖哥发言在课程的最后,我想和同学们谈一谈机器的自我学习以及知识的积累,也就是如何让机器在尽可能少的人工干预下,完成持续性的学习。这个议题很大,我只是抛砖引玉。

+所谓机器的自我学习,也是一个模糊的概念,我们讲过的无监督学习、半监督学习、自监督学习、强化学习等都可以算作机器的自我学习。这是一个非主流却很重要的领域。为什么这么说呢?因为人类和动物的学习模式绝大多数情况下都是自我学习模式,其中的自我探索的价值要远超过监督和指导。从知识积累的角度来说,自我学习所能够积累的知识也远超监督学习。通过自我学习可以学习更多关于世界结构的知识:数据是无限的,每个例子提供的反馈量都很大。

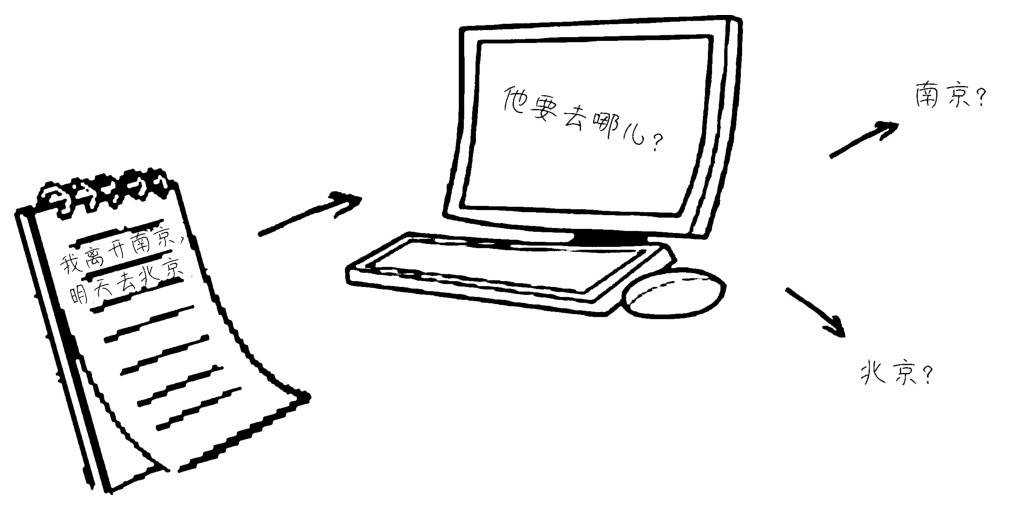

+这种学习模式在自然语言处理方面取得了巨大成功。例如,通过BERT(一种双向训练的语言模型)这样的半监督式的NLP模型,机器能预测文本中缺失的单词、自动补全程序代码,甚至生成新的代码,这都是近期机器学习领域的新趋势。

+可以说,机器的自我学习能力越强,我们离强AI就越近。

+在线学习

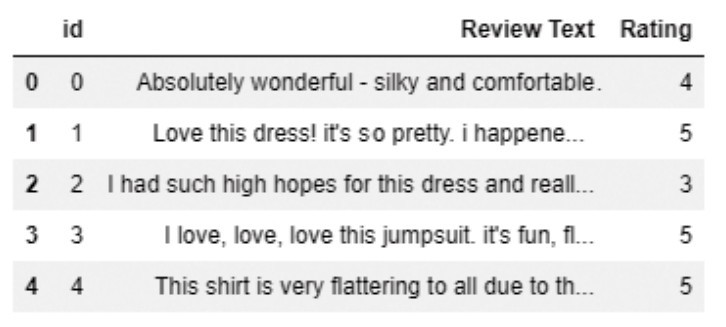

+比如在线学习,一个典型例子是通过对用户购物篮的分析,推荐相关的商品,这就是一种典型的监督学习和机器的自我学习的结合。

+ 咖哥发言

咖哥发言

推荐算法的实现方式,一是基于商品内容的推荐,把用户所购的近似商品推荐给用户,前提是每个商品都得有若干个标签,才可以知道其近似度。二是基于用户相似度的推荐,就是根据不同用户的购买历史,将与目标用户兴趣相同的其他用户购买的商品推荐给目标用户。例如,小冰买过物品A、B和C,我买过了商品A、B和D,于是将商品C推荐给我,同时将商品D推荐给小冰。

+传统的训练方法基于固定的训练集,模型上线后,一般是静态的,不会与线上的数据流有任何互动。假设预测错了,或者推荐得不合适,只能等待进一步积累聚集,并在下次系统更新的时候完成修正。

+在线学习要求系统能够更加及时地反映线上变化,它是机器学习领域中常用的技术,也就是一边学着,一边让新数据进来。大型电商网站的机器学习都是在线学习。例如,在亚马逊上购书之后,马上就会有相关新书推荐给我们。这种学习的训练集是动态的、不断变化的,呈现出一种数据流的性质。因此,算法也需要动态适应数据中的新模式,在每个步骤中更新对未来数据的最佳预测,实时快速地进行模型调整,提高线上预测的准确率。尤其是与用户交互这一块,在将模型的预测结果展现给用户的同时收集用户的反馈数据,再用来继续训练模型,及时做出修正。

+例如某网上书店的推荐系统的实现,首先通过普通的机器学习模型,根据系统已有数据(如图书的特征信息)和用户的历史行为,向用户推荐其可能感兴趣的书,然后通过在线排序模型对书进行交互式排序。考虑到用户往往是使用移动端设备,每次看到的推荐条目很少,因此前面几个排序项的作用更突出。系统会在线监控用户的选择。假设用户单击了第n个条目,系统将只保留第n个条目前后几条数据作为训练数据,其他的就丢弃,以确保训练集中的数据是用户已经看到的。而且系统还将实时增加用户刚刚选择的书的权重。

+迁移学习

+另一个需要思索的机器学习发展方向是如何在机器学习过程中进行知识的积累。

+机器学习的经典模式是:在给定一个数据集上,运行一个机器学习算法,构建一个模型,然后将这个模型应用在实际的任务上。这种学习模式被称为孤立学习,因为它并未考虑任意其他相关的信息和过去学习的知识。孤立学习的缺点在于没有记忆,即它没有保留学到的知识,并应用于未来的学习。因此它需要大量的训练样例。

+然而,纵观人类发展的历史,之所以人类能够发展出如此辉煌的文化,筑成如此复杂的科学宫殿,其中语言和文字对于知识的保存和传续功不可没。人类是以完全不同的方式进行学习的。我们从不孤立地学习,而是不断地积累过去学习的知识,并无缝地利用它们学习更多的知识。随着时间的增长,人类将会学习越来越多的知识,而且越来越善于学习。

+机器学习中的迁移学习,意味着知识的积累,它存储已有问题的解决模型,并将其利用在其他不同但相关的问题上。这是一个很有意思的思路,因为这意味着我们将站在“巨人”肩上去学习。

+一个最典型的迁移学习的例子就是利用已经训练好的大型卷积网络,进行微调之后来实现自己的机器学习任务。

+这个知识迁移过程并没有我们想象的那么困难。现在就来试着运行一个实例。请看下面的代码:

+from keras.applications import VGG19 # 基网络是VGG19

+from keras import models # 导入模块

+from keras import layers # 导入层

+from keras import optimizers # 导入优化器

+# 预训练的卷积基

+conv_base = VGG19(weights='imagenet', include_top=False,

+input_shape=(150, 150, 3))

+conv_base.trainable = True # 解冻卷积基

+# 冻结其他卷积层, 仅设置block5_conv1可训练

+set_trainable = False

+for layer in conv_base.layers:

+if layer.name == 'block5_conv1':

+set_trainable = True

+if set_trainable:

+layer.trainable = True

+else:

+layer.trainable = False

+model = models.Sequential()

+model.add(conv_base) # 基网络的迁移

+model.add(layers.Flatten()) # 展平层

+model.add(layers.Dense(128, activation='relu')) # 微调全连接层

+model.add(layers.Dense(10, activation='sigmoid')) # 微调分类输出层

+model.compile(loss='binary_crossentropy', # 交叉熵损失函数

+# 为优化器设置小的学习速率, 就是在微调第5卷积层的权重

+optimizer=optimizers.adam(lr=1e-4),

+metrics=['acc']) # 评估指标为准确率

+model.fit(X_train, y_train, epochs=2, validation_split=0.2) # 训练网络

+model.add(layers.Dense(10, activation='softmax'))

+这段简单的代码就实现了在有名的大型卷积网络VGG19基础之上的微调。我们可以拿这个新模型来训练我们的任何图像集。

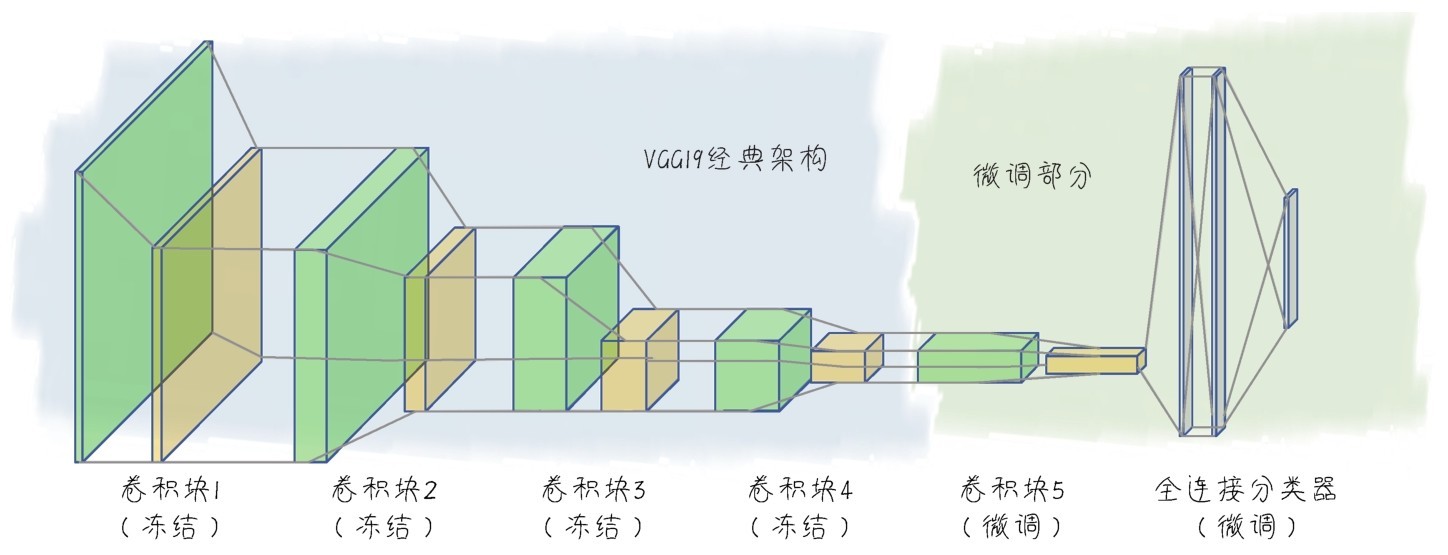

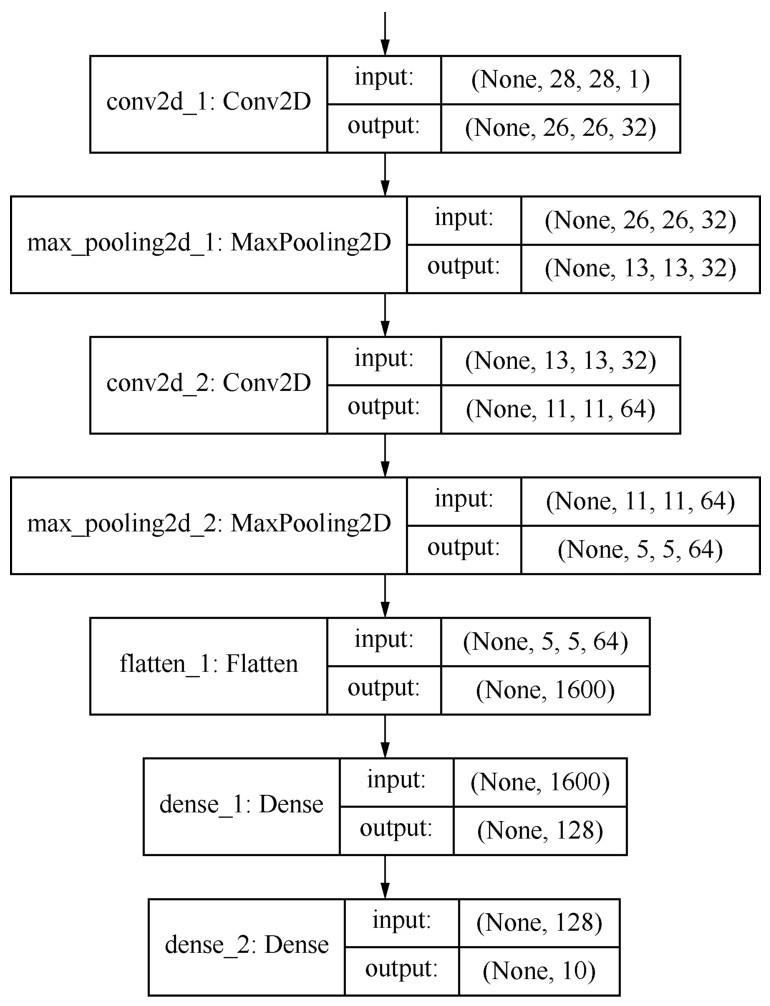

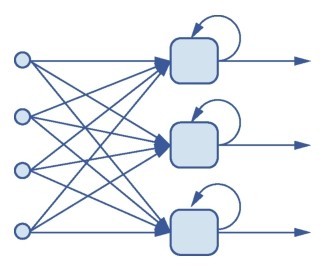

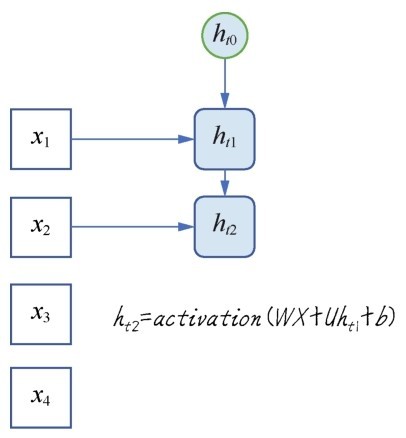

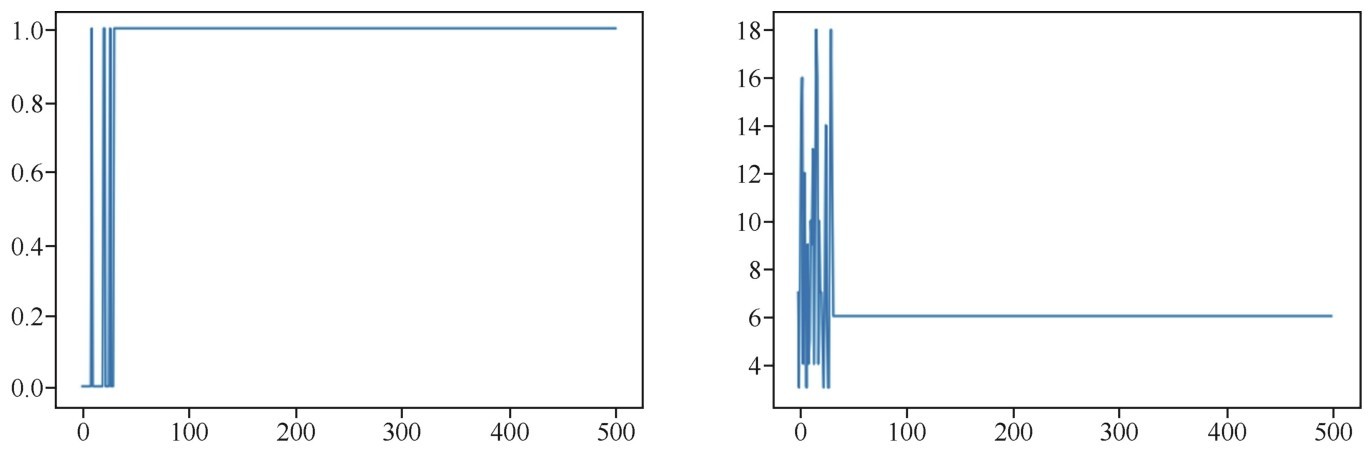

+微调之后的属于我们的新模型如下图所示。

+ +

+ 基于VGG19网络的迁移学习模型

+新模型结构如下图所示。

+ +

+ 程序编译出来的基于VGG19迁移形成的新模型结构

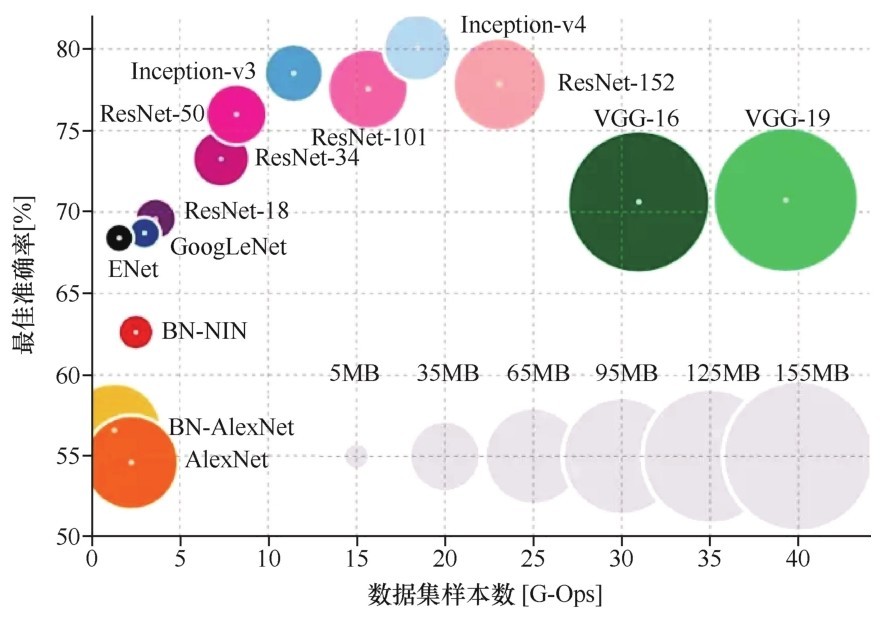

+Keras中预置的成熟模型有很多,除了VGG外,你们也可以试试Res Net、Inception、Inception-ResNet、Xception等,这些已经在大型图像库如Image Net中“千锤百炼”过的大型卷积网络,都可以直接迁移至你们自己的机器学习模型。

+下面代码中给出了多种Keras提供的可迁移的基网络:

+from keras.applications import ResNet50

+from keras.applications import Inception V3

+from keras.applications import Mobile Net V2

+from keras.applications import Xception

+from keras.applications import VGG16

+from keras.applications import VGG19

+迁移学习,不仅限于卷积网络,像BERT这样的NLP模型,也可以下载下来,进行微调后复用。

+终身学习

+通过迁移学习,我们在知识积累的路上迈出了一大步。迁移学习假设源领域有大量已经标注的训练数据,目标领域有很少或者根本没有标注的训练数据,但是有很多未标注的训练数据。迁移学习利用源领域已经标注的数据来帮助目标领域完成学习任务。

+然而,迁移学习还不能算是持续性地学习,它仅仅是利用源领域来帮助目标领域的单向学习过程。迁移学习在知识积累方面是有局限性的,因为迁移学习假设源领域与目标领域是很相似的。

+而终身学习(lifelong learning)没有这么强的假设,使用者通常也不参与决定任务的相似性。

+对于监督学习而言,大量的训练数据通常是手工标注得到的,这样既费时又费力。但是现实世界中存在很多的学习任务,为了学习一个机器学习模型,对每个任务都手工标注大量的训练数据是不可能的。

+而且,事情总是处在不断变化中的,因而需要不停地标注训练数据,这显然是无法完成的任务。对建立真正的智能系统而言,当前的孤立学习是不合适的,其仅可被用于解决具体领域的任务。

+机器的终身学习就是模仿人类的这种学习过程和能力。由于我们周围的事物都是紧密相关和相互联系的,因此这种学习方式更为自然。

+因为过去学习的概念和关系可以帮助我们更好地理解和学习一个新的任务,所以终身学习是一个持续学习过程,模型应该可以利用其知识库中的先验知识来帮助学习新任务。知识库中存储和维护过去的任务中学习和积累的知识。知识库也会根据新任务中学习的中间或最终结果进行更新。

+终身学习包括以下主要特征。

+■持续学习。

+■知识被积累到知识库。

+■利用过去学习的知识,来帮助解决未来的学习问题。

+当然,这里进行的只是理念上的探讨,对于自我学习、迁移学习、终身学习这些比较接近“强人工智能”领域的主题,目前仍处在刚刚起步探索的阶段,技术和实践上远远没有监督学习那么成熟。

+-----------------------------------------------------------------

+不知不觉间,到了真要说再见的时候。咖哥说会送给每位同学一本书,作为纪念。

+小冰看到,这是本非常有名的书—《高效能人士的七个习惯》。

+咖哥说:“这本书,是我很喜欢的一本书,也可以说陪伴了我的生活、工作和学习。我时常会把它赠送给同事和朋友们。不过,我肯定是没有时间给大家介绍每一个习惯了。但是,允许我说一下这七个习惯里面的最后一个习惯:不断更新。不断更新,其实也就是终身学习。说的是如何在四个生活面向(生理、社会、情感、心智)中,不断更新自己。这个习惯好比梯度提升机一样推着人持续成长。只有不断更新、不断完善自我,人才不致老化及呈现疲态,才总是能踏上新的路径,迎接新的天地。”

+“同学们,在AI来临的时代,机器尚且能够自我更新、自我学习,我们人类更应时时刻刻记住持续学习、不断成长的重要性。”

+“成长,不是负担,而是一种常态、一种快乐。”

+“再见喽,同学们。”

+小冰和其他同学有些恋恋不舍地往课堂外面走去。

+“哎,小冰,等一等!还有一件事!”咖哥叫住小冰,“你的新项目几个月做完?3个月?好!3个月之后,你回来给我上上课,分享经验。”

+小冰说:“啊?!不可能吧。”

+咖哥说:“怎么不可能,完全有可能。两千多年前的孔子都认为‘三人行,必有我师焉’,在现在这个时代,更是任何人都有可能成为我的老师。好了,再见!”

+-----------------------------------------------------------------

\ No newline at end of file diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\345\274\225\345\255\220 AI\350\217\234\351\270\237\347\232\204\346\214\221\346\210\230\342\200\224\342\200\224100\345\244\251\344\270\212\347\272\277\346\231\272\350\203\275\351\242\204\350\255\246\347\263\273\347\273\237/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\345\274\225\345\255\220 AI\350\217\234\351\270\237\347\232\204\346\214\221\346\210\230\342\200\224\342\200\224100\345\244\251\344\270\212\347\272\277\346\231\272\350\203\275\351\242\204\350\255\246\347\263\273\347\273\237/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..b109c76c83b738648e2d343f4a0679abf153031f --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\345\274\225\345\255\220 AI\350\217\234\351\270\237\347\232\204\346\214\221\346\210\230\342\200\224\342\200\224100\345\244\251\344\270\212\347\272\277\346\231\272\350\203\275\351\242\204\350\255\246\347\263\273\347\273\237/text.html" @@ -0,0 +1,25 @@ +小冰,“90后”,研究生毕业,非资深程序员,目前在一家软件公司工作。工作虽忙但尚能应付,还和朋友合伙开了一个网店。她的生活风平浪静。

+故事从大老板今天早晨踏进她们项目组这一刻开始。

+她到公司比别人早,刚刚收拾了一下混乱的房间,正要打开电脑,大老板进来了。

+“小冰,你们经理呢?还没来吗?这都10点了!”老板似乎生气了。

+小冰说:“昨天经理带着我们赶进度,到晚上12点多才走,可能今天要晚到一会儿。”

+“唉,算了。不等他了。就你吧,你跟我过来一下。还有你们两个,”老板指着其他项目组的另外两个同事说,“也来一下。”

+到了会议室,老板开口了:“我这边有一个很紧急、也很重要的项目哈。合作方是老客户了,因为信任咱们,才直接交给咱们。但是时间非常非常紧,100天内必须上线。我琢磨着你们手头上的几个项目都在收尾阶段了,本来是准备跟你们经理商量,抽调一两个人做这个新项目。但是他们又都迟到,我这儿又着急。算了,我也不和他们商量了,就定你们几个吧!”说完,又补了一句:“叫他们带头迟到!”

+小冰和其他几位同事面面相觑。

+过了3秒,小冰弱弱地问:“请问是什么方面的项目?”

+老板答:“人工智能!”

+小冰他们吓了一跳。

+老板接着说:“不是让你们去研发一个会端茶倒水的机器人。具体讲,是机器学习方面的项目。机器学习,听说过吗?属于人工智能的一个分支领域,最近是热得很呢。这是一个银行客户,他们的信用卡申请系统是我们前年做的,现在也开始做大数据和机器学习的项目了。这次是请我们给他们做一个诈骗行为预警的应用,根据现有的数据智能化地判断哪些客户可能存在欺诈性的刷卡行为。这个项目如果完成得好,他们还会继续开发一个人脸识别应用,加入信用卡的申请验证过程,那就需要深度学习的技术了。深度学习也算是机器学习的分支吧。”

+ +

+ 小冰被新项目吓了一跳

+老板一谈起项目,那是滔滔不绝啊!停都停不下来。但是几个听众有点觉得云山雾罩的。

+“可是……这些技术我们都不懂啊……”几人在同一时间表达了同一个意思。

+“学啊!”老板说。

+“有那么容易吗?”一个比较大胆的同事问,“我看过一些机器学习的文档,也买过几本书,里面的数学公式、算法,难度可不低啊,我一个专业程序员都感觉看不大懂。”

+“嗯,这样啊……” 老板思索了一下,“我倒觉得这机器学习项目,门槛没有你们想象的那么高。以你们目前的编程背景和数学知识,如果学习路线正确,应该可以快速上手。不过,我其实也考虑到这点了,如果没有一个适当的培训来引导你们,完全自学的话应该还是挺艰苦的。我安排了一个短期培训,找的是专家,一个在大厂任资深数据科学家的朋友。让他带一带你们,先入门。据他说,他的第一个机器学习项目也是临危受命,同样是半年之内从不懂到懂,‘摸爬滚打’几个月之后,最终完成了。因此,几个月搞定这个项目不算是开玩笑。我们做IT的,哪个项目不是这样边学边做拼出来的?”

+紧接着老板大手一挥,斩钉截铁地说:“好,这事儿就这么定了!这是好事,别人想要做这机器学习项目还没机会呢。”

+“明天开始机器学习培训!”

+这样,小冰似乎不是很情愿,而又幸运地开启了她的机器学习之旅。

\ No newline at end of file diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\345\275\251\346\217\222/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\345\275\251\346\217\222/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..0f54c00623293b51b731eba9f99345075f3292fa --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\345\275\251\346\217\222/text.html" @@ -0,0 +1,10 @@ + +

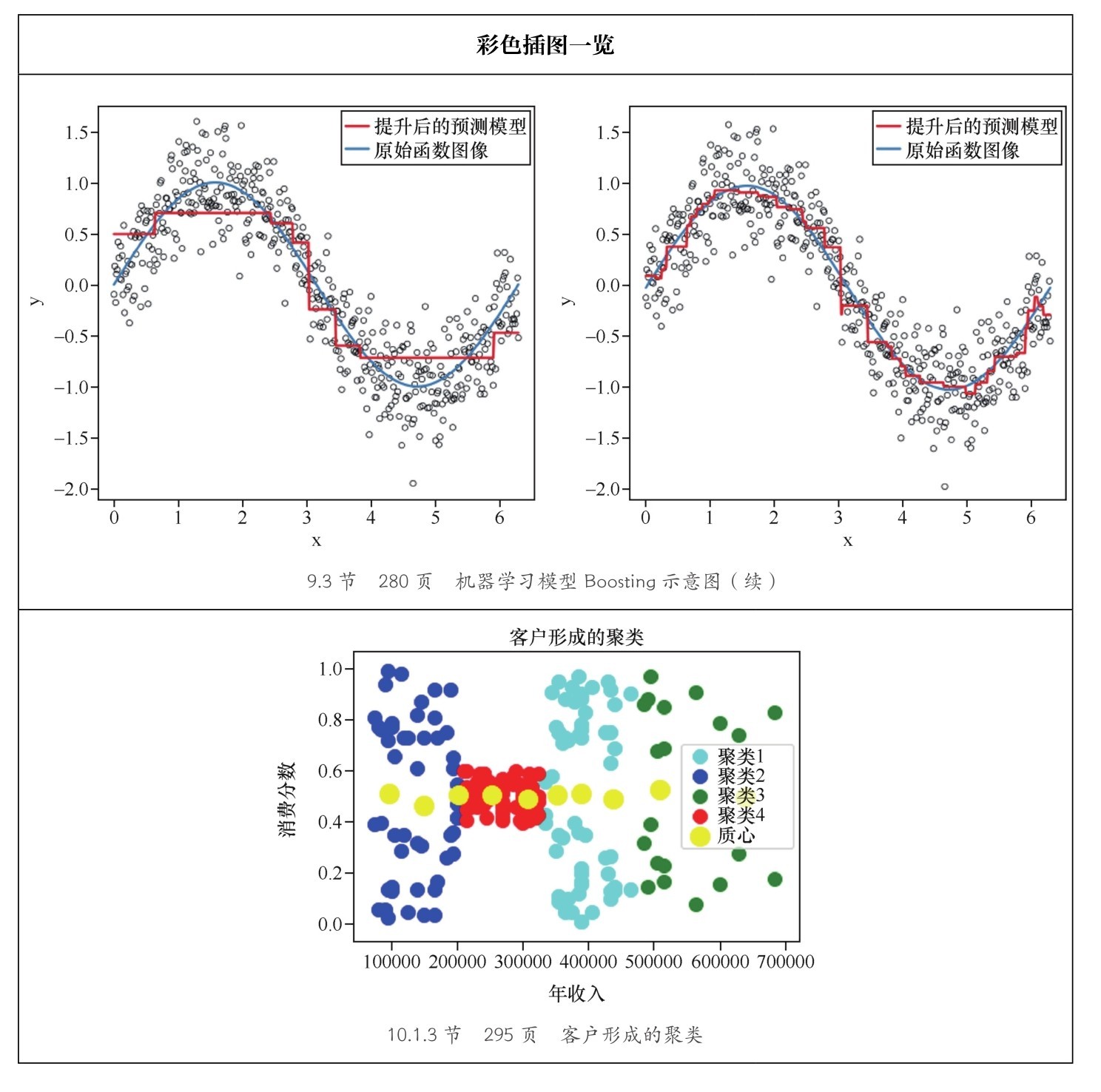

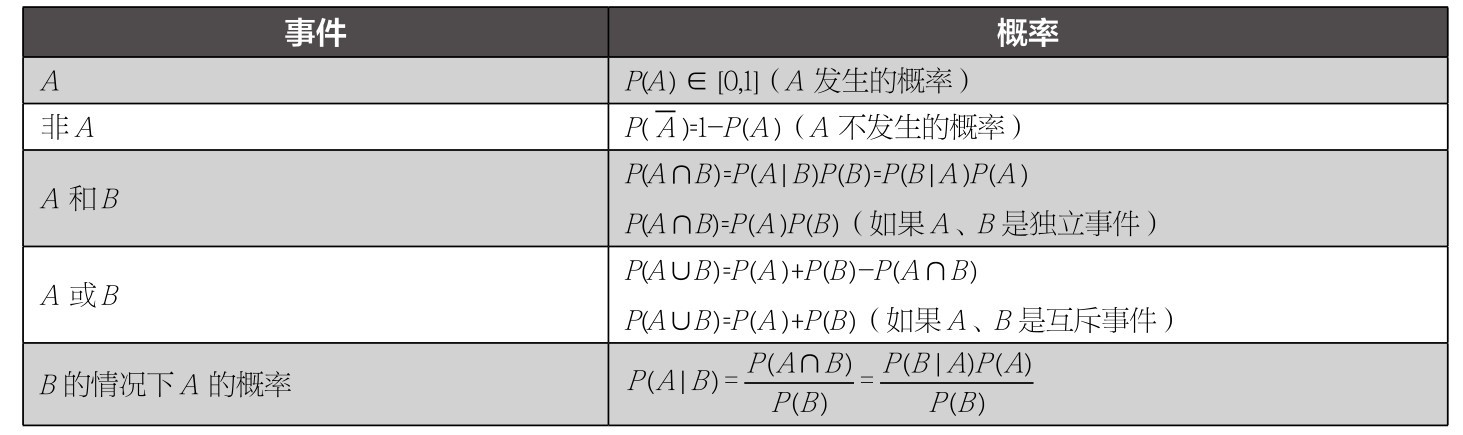

+ +

+ +

+人工智能,也就是我们每天挂在嘴边的AI,可以被简单地定义为努力将通常由人类完成的智力任务自动化[1]。这个定义内涵模糊而外延广阔,因而这个领域可谓异彩纷呈:手机里的Siri、围棋场上的Alpha Go、购物时出现的推荐商品、无人驾驶的汽车,它们无不与人工智能有关。为了后面方便讲述,我们[2]就用其英文缩写“AI”来代替。

+1950年,图灵发表了一篇划时代的论文《计算机器与智能》,文中预言了创造出“有智慧的机器”的可能性。当时他已经注意到“智能”这一概念难以确切定义,因而提出了著名的图灵测试:如果一台计算机可以模仿特定条件下的人类反应,回答出特定领域的问题,而提问者又无法正确判断回答者是人类还是机器,就可以说它拥有人工智能。后来,1956年,众多的学者和学科奠基人在达特茅斯学院举行了一次大会,现代AI学科从此正式成立。

+ +

+ 老板通知咖哥:咖哥本人的图灵测试未通过

+这之后大概每隔一二十年,就会出现一波AI热潮,热潮达到顶点后又会逐渐“冷却”,进入低谷期。这形成了周而复始的AI效应,该效应包括以下两个阶段。

+(1)AI将新技术、新体验带进人类的生活,完成了一些原本需要人类智慧才能完成的工作,此时舆论会对AI期待极高,形成一种让人觉得“真正的”AI时代马上就要到来的氛围。人们兴奋不已,大量资金涌入AI研发领域。

+(2)然而一旦大家开始习惯这些新技术,就又开始认为这些技术没什么了不起,根本代表不了真正的人类智慧,此时又形成一种对AI的现状十分失望的氛围,资金也就纷纷“离场”。

+小冰插嘴:“这也太悲催了!”

+咖哥说:“但是AI的定义和应用的领域正是在上述循环的推动下不断地被升级、重构,向前发展的。”

+ +

+ 一旦大家习惯新技术,就觉得没什么了不起

+目前第三波AI热潮正火热兴起。AI是当前整个IT业界的热点,而AI领域内的热点,就是这里要讲的两个技术重点—机器学习和深度学习。机器学习是AI的分支技术,而深度学习是机器学习的技术之一。从人工智能到机器学习,再到深度学习,它们之间是一种包含和被包含的关系,如下图所示。

+ +

+ 人工智能、机器学习和深度学习的关系

+这种热点的形成有多方面的原因。

+首先,是数据。在大数据时代,我们终于拥有了算法所需要的海量数据。如果把机器学习比作工业革命时的蒸汽机,那么数据就是燃料。有了燃料,机器才能够运转。

+其次,在硬件方面,随着存储能力、计算能力的增强,以及云服务、GPU(专为执行复杂的数学和几何计算而设计的处理器)等的出现,我们几乎能够随意构建任何深度模型(model)。

+最重要的是,两种技术都有特别良好的可达性,几乎能够触达任何一个特定行业的具体场景。简单地说就是实用、“接地气”,大大拓展了AI的应用领域。小到为客户推荐商品、识别语音图像,大到预测天气,甚至探索宇宙星系,只要你有数据,AI几乎可以在任何行业落地。这种可达性和实用性,才是机器学习和深度学习的真正价值所在。

+说到这次课程的具体目的,那就是快速入门机器学习。不得不说,媒体把机器学习、深度学习“渲染”得太夸张了。它们其实没那么神奇,门槛也没有大家想象得那么高。业界的共识是:机器学习技术不能是曲高和寡的“阳春白雪”,应该让它走出象牙塔,“下凡到人间”。既然这两种技术的实用性强,那么当务之急就是将其部署到一个个应用场景,也就是需要让尽可能多的人接触这门技术,尤其是非专家、非研究人员。未来,非IT专业背景的人群也应该了解、学习AI技术。只有推广给大众,才能充分发挥技术的全部潜能。

+在这一理念的驱动之下,简单实用的机器学习和深度学习框架、库函数不断涌现,可重用的代码和技术层出不穷。分享与合作也成了AI业界的精神内核之一。这对于初学者来说,无疑是天大的好事。而像我们这样的普通软件工程师,在AI落地的过程中肯定是要起到重要作用的。

+此时咖哥用期待的眼光向同学们望去,好像在说:“天将降大任于我们啊,同学们!”

+然而同学们仍然略有困惑。“真的不难吗?”小冰开口问道,“听说机器学习对数学要求高啊。数学从来都不是我的强项,高中之后的数学知识都还给老师了。”

+咖哥笑着回答:“以你们现在的基础,肯定没问题。而且关于机器学习新手入门,我总结出来了3个好消息。先给你们背首“诗”吧。”

+ +小冰说:“嘿,咖哥,我这儿都急得睡不好觉了,你还在这儿乱侃!”

+咖哥道:“这首‘诗’,隐喻的是目前最流行的机器学习语言Python。它是一种非常容易上手的编程语言,很多小孩子都在学。你作为一个研究生,还写过Java代码,学Python会有什么问题呢?而且Python功能性超强,很实用,自带很多强大的框架和库函数,你说这有多方便!这就是第一个好消息。”

+“我再给你们背首‘诗’吧。”咖哥接着说。

+“不用了,”小冰说,“请直接说第二个好消息的要点。”

+第二个好消息是,机器学习的确需要一些数学基础,但是就入门阶段来说,要求并不高,也就是函数、概率统计,再加上线性代数和微积分最基础的内容。而且,机器学习中的数学内容重在理解,不重在公式的推演。

+最后,也是最给力的好消息就是刚才提过的AI业界的分享精神了。我们学机器学习,学的是各种模型(也就是算法),并用它们进行实战。这比的不是多高的编程水平和数学水平,而是模型的选择、整合、参数的调试。这要求的主要是逻辑分析与判断能力,再加上点直觉和运气。有人甚至把搭建机器学习模型的过程形容为“搭积木”。因此,说以“游戏的态度”学机器学习、做机器学习项目也不算是不负责任的说法。

+所以,机器学习没什么可怕的,我自己的项目团队里面文科生都有好几个呢。不过学习路线图很重要,因为机器学习领域的覆盖面非常的庞杂,初学者很容易“找不着北”。所以如果在学习过程中能有正确的引导,可以省下很多力气,那么入门就更顺利了。

+ +

+ 有人甚至把搭建机器学习模型的过程形容为“搭积木”

+同学们此时都以十分期待的眼光看着咖哥。

+咖哥微笑着点头说道:“你们猜对了,这门课程,正是要为你们梳理出一条清晰而顺畅的入门脉络,我本人有信心让你们在较短的时间内把握机器学习的本质,领略机器学习的威力,并顺利进入机器学习的殿堂!”

+那么何为机器学习?其实机器学习(maching learning)这个概念和AI一样难以定义。因为其涵盖的内容太多了。美国作家Peter Harrington在他的《机器学习实战》一书中说“机器学习就是把无序的数据转换成有用的信息”[4]。英国作家Peter Flach在他的《机器学习》一书中,将机器学习概括为“使用正确的特征来构建正确的模型,以完成既定的任务”[5]。这里面的特征,其实也是数据的意思。

+既然学者们的定义并不统一,那么我也来说说自己的看法—机器学习的关键内涵之一在于利用计算机的运算能力从大量的数据中发现一个“函数”或“模型”,并通过它来模拟现实世界事物间的关系,从而实现预测或判断的功能。

+这个过程的关键是建立一个正确的模型,因此这个建模的过程就是机器的“学习”。

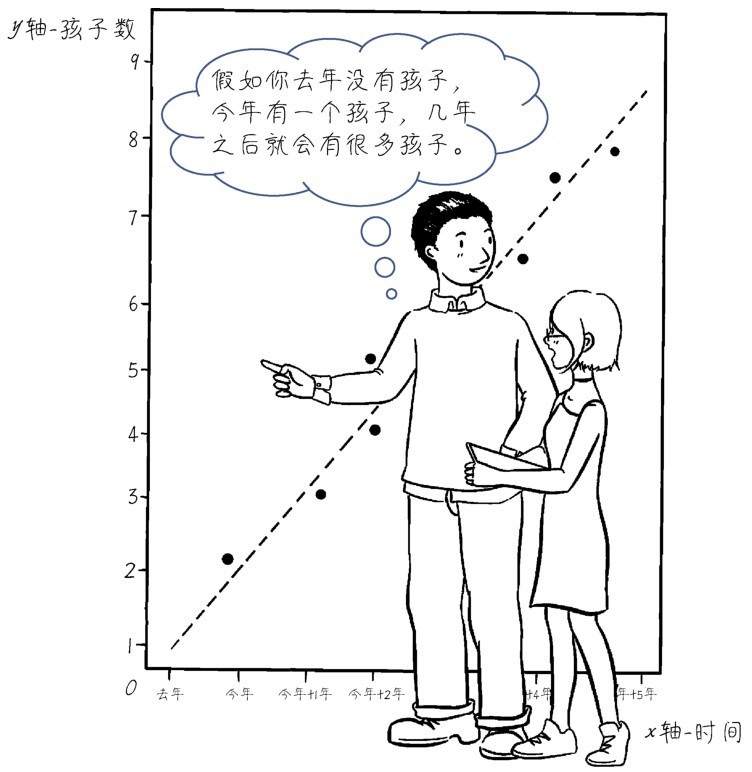

+小冰打断咖哥:“你能不能讲大家能听懂的话?什么是现实世界事物间的关系的模拟,说清楚一点。”

+咖哥回答:“现实世界中,很多东西是彼此相关的。”

+比如,爸爸(自变量x1)高,妈妈(自变量x2)也高,他们的孩子(因变量y)有可能就高;如果父母中有一个人高,一个矮,那么孩子高的概率就小一些;当然如果父母都矮,孩子高的概率就非常小。当然,孩子的身高不仅取决于遗传,还有营养(自变量x3)、锻炼(自变量x4)等其他环境因素,可能还有一些不可控的或未知的因素(自变量xn)。

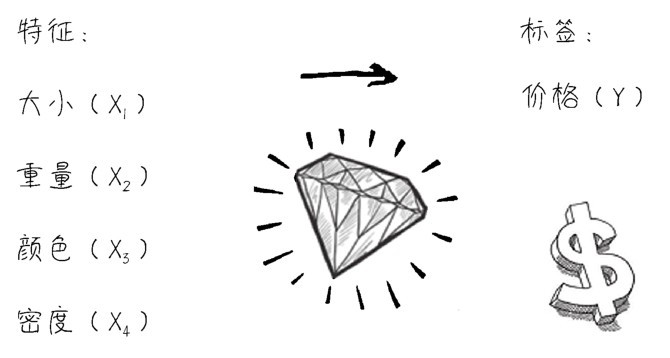

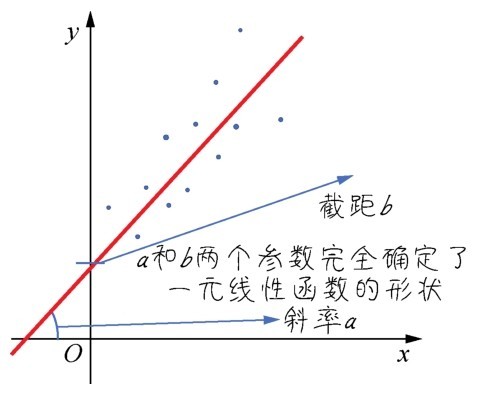

+又比如,一颗钻石的大小(自变量x1)、重量(自变量x2)、颜色(自变量x3)、密度(自变量x4)和它的价格(因变量y)的关系,也体现出了明显的相关性,如下图所示。

+ +

+ 机器学习——从特征到标签

+ 咖哥发言

咖哥发言

有一点你先记住,这些自变量(x1, x2, x3, …, xn),在机器学习领域叫作特征(feature),因变量y,在机器学习领域叫作标签(label),有时也叫标记。这两个名词现在听起来比较怪,但是用着用着就会习惯。

+机器学习,就是在已知数据集的基础上,通过反复的计算,选择最贴切的函数(function)去描述数据集中自变量x1, x2, x3, …, xn和因变量y之间的关系。如果机器通过所谓的训练(training)找到了一个函数,对于已有的1000组钻石数据,它都能够根据钻石的各种特征,大致推断出其价格。那么,再给另一批同类钻石的大小、重量、颜色、密度等数据,就很有希望用同样的函数(模型)推断出这另一批钻石的价格。此时,已有的1000组有价格的钻石数据,就叫作训练数据集(training dataset)。另一批钻石数据,就叫作测试数据集(test dataset)。

+因此,正如下图所示,通过机器学习模型不仅可以推测孩子身高和钻石价格,还可以实现影片票房预测、人脸识别、根据当前场景控制游戏角色的动作等诸多功能。

+ +

+ 机器学习就是从数据中发现关系,归纳成函数,以实现从A到B的推断

+听到这里,小冰叫了起来:“啊?这不就是数学吗,有什么深奥的!——统计学,大学学过的,对不对?”

+咖哥回答道:“小冰,你说得没错。”

+其实所谓机器学习,的确是一个统计建模的过程。但是当特征数目和数据量大到百万、千万,甚至上亿时,原本属于数学家的工作当然只能通过机器来完成喽。而且,机器学习没有抽样的习惯,对于机器来说,数据是多多益善,有多少就用多少。

+下面的图展示了机器从数据中训练模型的过程,而人类的学习,是从经验中归纳规律,两者何其相似!越是与人类学习方式相似的AI,才是越高级的AI!这种从已知到未知的学习能力是机器学习和以前的符号式AI最本质的区别。

+ +

+ 机器:从数据中学习;人类:从经验中学习。两者何其相似

+机器学习的另外一个特质是从错误中学习,这一点也与人类的学习方式非常相似。

+你们看一个婴儿,他总想吞掉他能够拿到的任何东西,包括硬币和纽扣,但是真的吃到嘴里,会发生不好的结果。慢慢地,他就从这些错误经验中学习到什么能吃,什么不能吃。这是通过试错来积累经验。机器学习的训练、建模的过程和人类的这个试错式学习过程有些相似。机器找到一个函数去拟合(fit)它要解决的问题,如果错误比较严重,它就放弃,再找到一个函数,如果错误还是比较严重,就再找,一直到找到相对最为合适的函数为止,此时犯错误的概率最小。这个寻找的过程,绝大多数情况不是在人类的“指导”下进行的,而是机器通过机器学习算法自己摸索出来的。

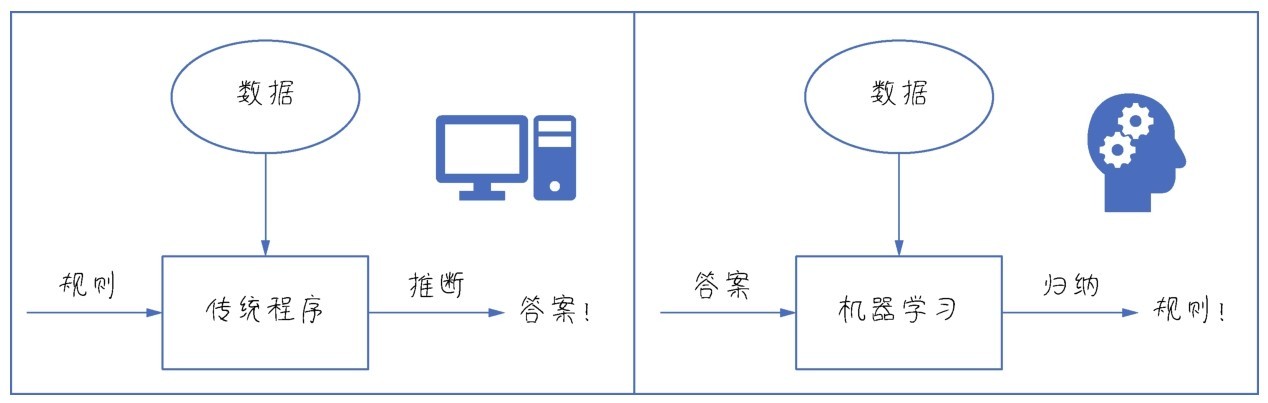

+因此,机器学习是突破传统的学习范式,它与专家系统(属于符号式AI)中的规则定义不同。如下图所示,它不是由人类把已知的规则定义好之后输入给机器的,而是机器从已知数据中不断试错之后,归纳出来规则。

+ +

+ 机器学习是突破传统的学习范式,是从数据中发现规则,而不是接受人类为它设定的规则

+上述这些能够引导机器进行自我学习的算法,我们只是要在“理解的基础上使用”,而算法的设计,那是专业人士才需要进行的工作。因此,重点在于解释这些算法,并应用它们建立机器学习模型(函数)来解决具体问题。

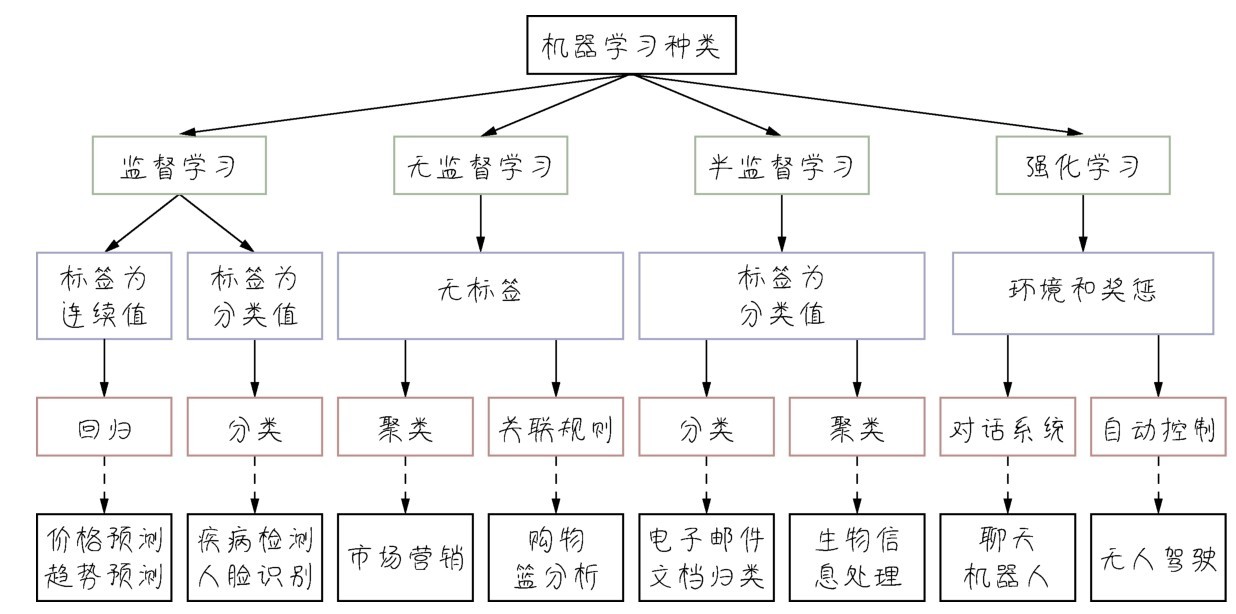

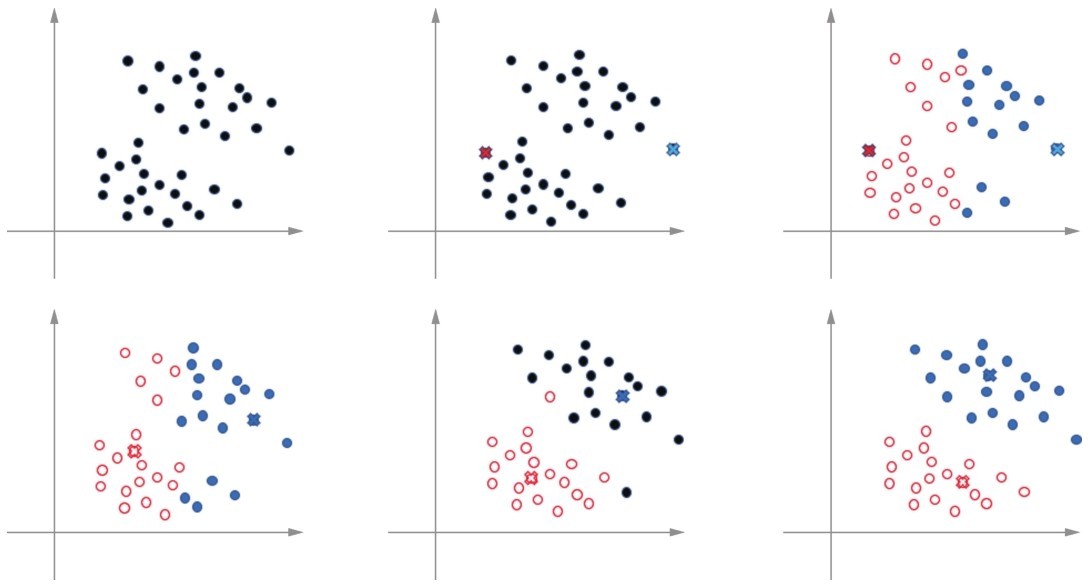

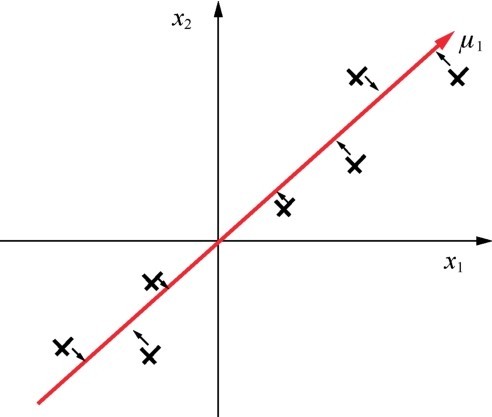

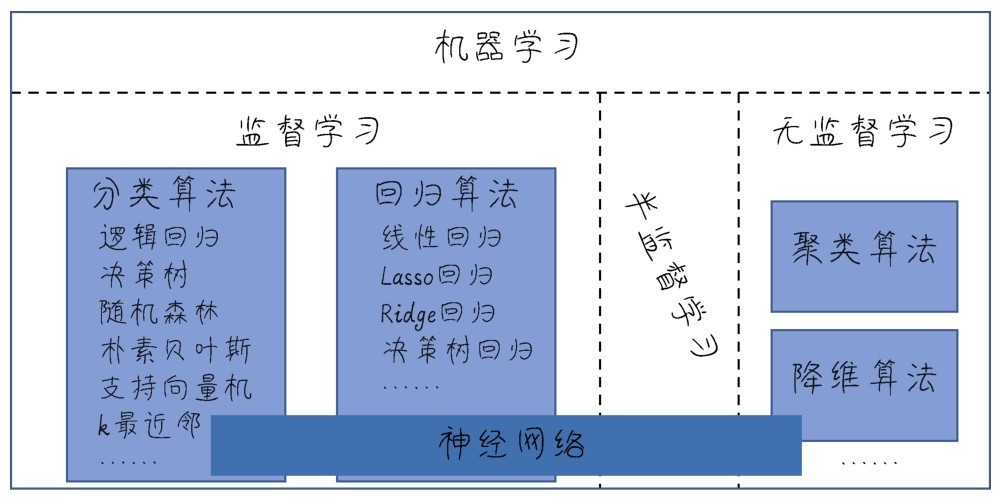

+机器学习的类别多,分类方法也多。最常见的分类为监督学习(supervised learning)、无监督学习(unsupervised learning)和半监督学习(semi-supervised learning)。监督学习的训练需要标签数据,而无监督学习不需要标签数据,半监督学习介于两者之间。使用一部分有标签数据,如下图所示。

+ +

+ 以分类问题展示监督、无监督和半监督学习的区别

+“停,”小冰喊道,“刚才讲的听不大懂!”

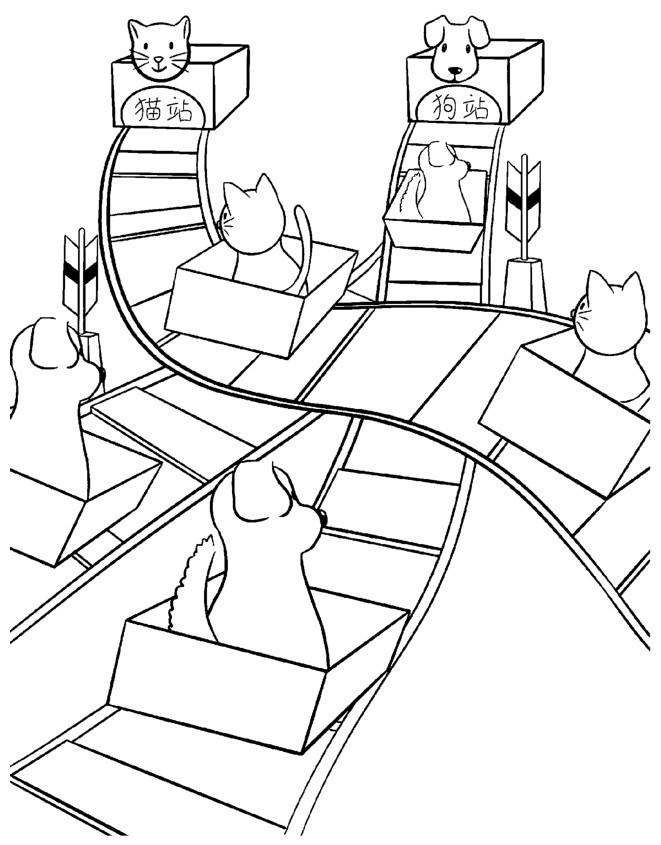

+咖哥说:“那么我换一种比较容易理解的说法。如果训练集数据包含大量的图片,同时告诉计算机哪些是猫,哪些不是猫(这就是在给图片贴标签),根据这些已知信息,计算机继续判断新图片是不是猫。这就是一个监督学习的示例。如果训练集数据只是包含大量的图片,没有指出哪些是猫,哪些是狗,但是计算机经过判断,它能够把像猫的图片归为一组,像狗的图片归为一组(当然它无法理解什么是什么,仅能根据图片特征进行归类而已)。这就是一个无监督学习的示例。”

+“那么半监督学习又是怎么一回事呢?”小冰问。

+简而言之,半监督学习就是监督学习与无监督学习相结合的一种学习方法。因为有时候获得有标签数据的成本很高,所以半监督学习使用大量的无标签数据,同时使用部分有标签数据来进行建模。

+当然,机器学习分类方式并不只有上面一种,有时候人们把监督学习、无监督学习和强化学习并列起来,作为机器学习的几大分类,但各类机器学习之间的界限有时也是模糊不清的。

+上面说的监督学习与无监督学习,主要是通过数据集有没有标签来对机器学习进行分类。本课程中的一个重点内容深度学习(deep learning),则是根据机器学习的模型或者训练机器时所采用的算法进行分类。

+也可以说,监督学习或无监督学习,着眼点在于数据即问题的本身;是传统机器学习还是深度学习,着眼点在于解决问题的方法。

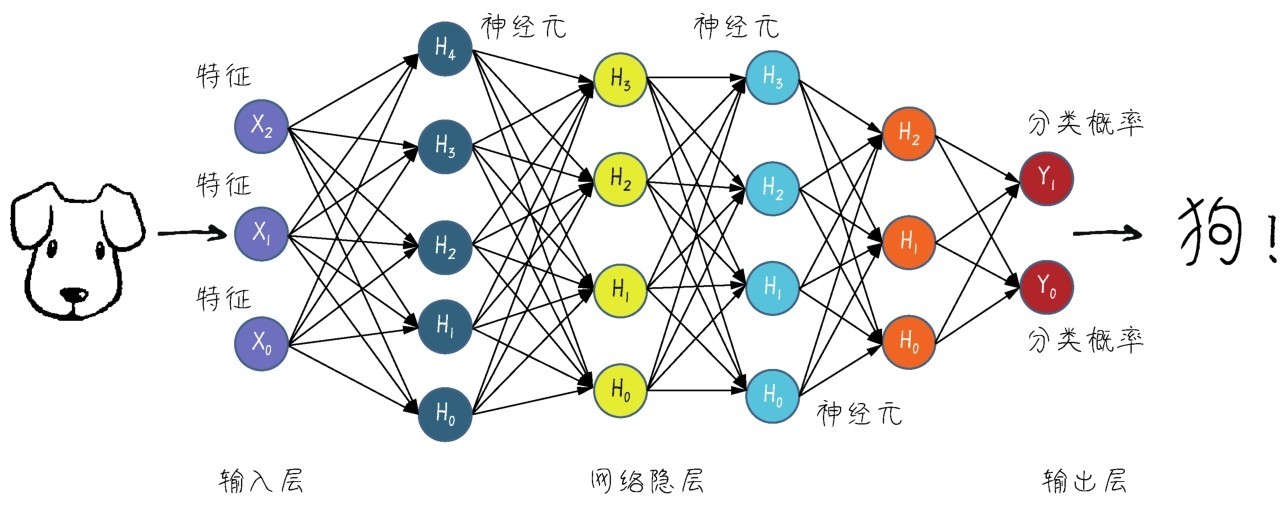

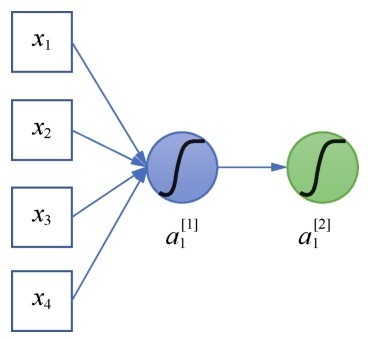

+那么深度学习所采用的机器学习模型有何不同呢?答案是4个字:神经网络。当然这种神经网络不是我们平时所说的人脑中的神经网络,而是人工神经网络(Artificial Neural Network, ANN),是数据结构和算法形成的机器学习模型,由大量的所谓人工神经元相互联结而成,这些神经元都具有可以调整的参数,可以实现监督学习或者无监督学习。

+ 咖哥发言

咖哥发言

大家千万不要被什么人工神经元、神经网络之类的专业名词吓住,觉得这些东西离自己太过于遥远,其实这些数学模型的结构简单得令人吃惊。

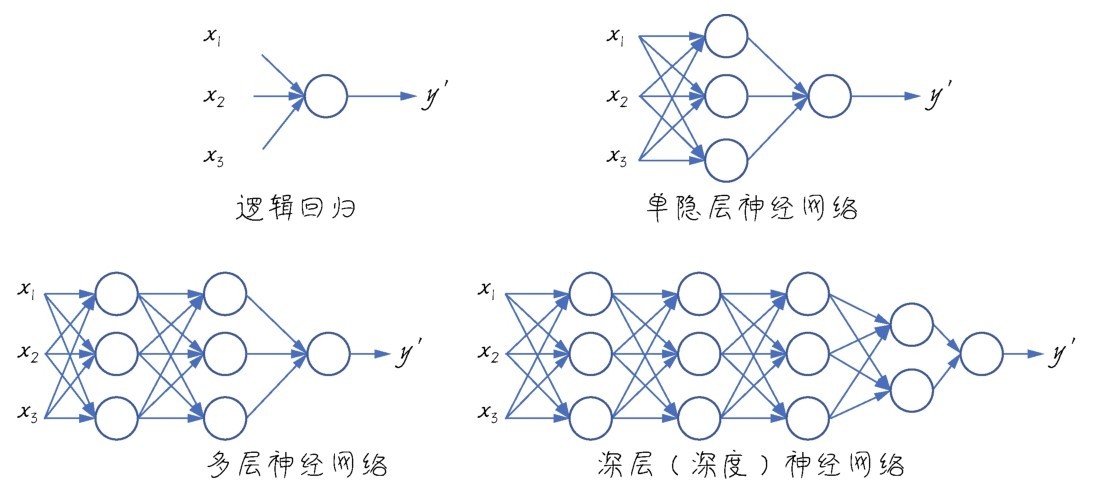

+初期的神经网络模型比较简单,后来人们发现网络层数越多,效果越好,就把层数较多、结构比较复杂的神经网络的机器学习技术叫作深度学习,如下图所示。这其实是一种品牌重塑,因为神经网络在AI业界曾不受重视,起了一个更高大上的名字之后果然“火了起来”。当然,火起来是大数据时代到来后的必然结果,换不换名字其实倒无所谓。

+ +

+ 深度学习中的神经网络是神经元组合而成的机器学习模型

+神经网络本质上与其他机器学习方法一样,也是统计学方法的一种应用,只是它的结构更深、参数更多。

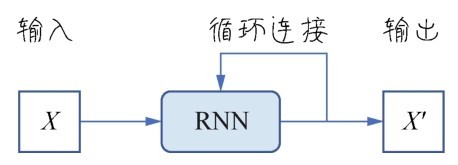

+各种深度学习模型,如卷积神经网络(Convolutional Neural Network, CNN)、循环神经网络(Recurrent Neural Network,RNN),在计算机视觉、自然语言处理(Natural Language Processing,NLP)、音频识别等应用中都得到了极好的效果。这些问题大多很难被传统基于规则的编程方法所解决,直到深度学习出现,“难”问题才开始变简单了。

+而且深度学习的另一大好处是对数据特征的要求降低,自动地实现非结构化数据的结构化,无须手工获取特征,减少特征工程(feature engineering)。特征工程是指对数据特征的整理和优化工作,让它们更易于被机器所学习。在深度学习出现之前,对图像、视频、音频等数据做特征工程是非常烦琐的任务。

+小冰说:“什么是‘自动地实现非结构化数据的结构化’,听着像绕口令,你还是再解释一下。”咖哥:“好,解释一下。”

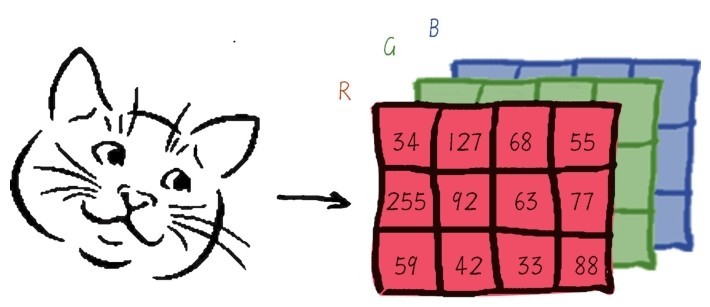

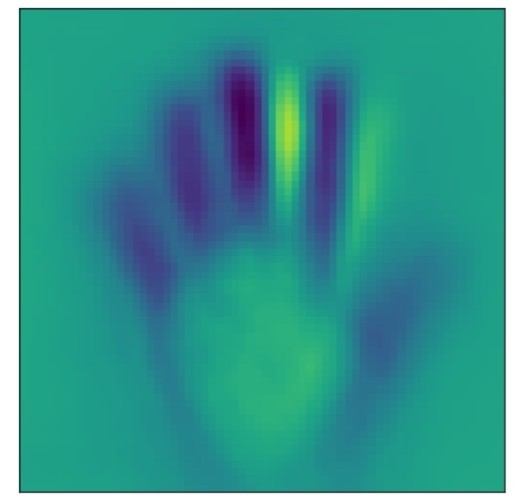

+有些数据人很容易理解,但是计算机很难识别。比如说,下图中一个32px×32px的图片,我们一看到就知道写的是8。然而计算机可不知道这图片8背后的逻辑,计算机比较容易读入Excel表格里面的数字8,因为它是存储在计算机文件系统或者数据库中的结构化数据。但是一张图片,在计算机里面存储的形式是数字矩阵,它很难把这个32px×32px的矩阵和数字8联系起来。

+ +

+ 从图片“8”到数字“8”,图形逐渐变得“计算机友好”

+然而,通过深度学习就能够完成图片上这种从非结构化到结构化的转换,你们可以研究一下上图中的这个从图片“8”到数字“8”的过程。通过卷积神经网络的处理,图片‘8’变成了[0000000010]的编码,虽然这样的编码未必让人觉得舒服,但是对于计算机来说这可比32px×32px数字的矩阵好辨认多了。”

+因此,数据结构化的目标也就是:使数据变得“计算机友好”。

+看一看下图所示的这个图片识别问题的机器学习流程。使用传统算法,图片识别之前需要手工做特征工程,如果识别数字,可能需要告诉机器数字8有两个圈,通常上下左右都对称;如果辨别猫狗,可能需要预定义猫的特征、狗的特征,等等,然后通过机器学习模型进行分类(可麻烦了)。而深度学习通过神经网络把特征提取和分类任务一并解决了(省了好多事儿)!

+ +

+ 深度学习的优势—减少手工进行的特征工程任务

+因此,深度学习的过程,其实也就是一个“数据提纯”的过程!在大数据时代,深度学习能自动搞定这个提纯过程,可是很了不起的事儿。

+强化学习,也是机器学习领域中一个很抢眼的热点。

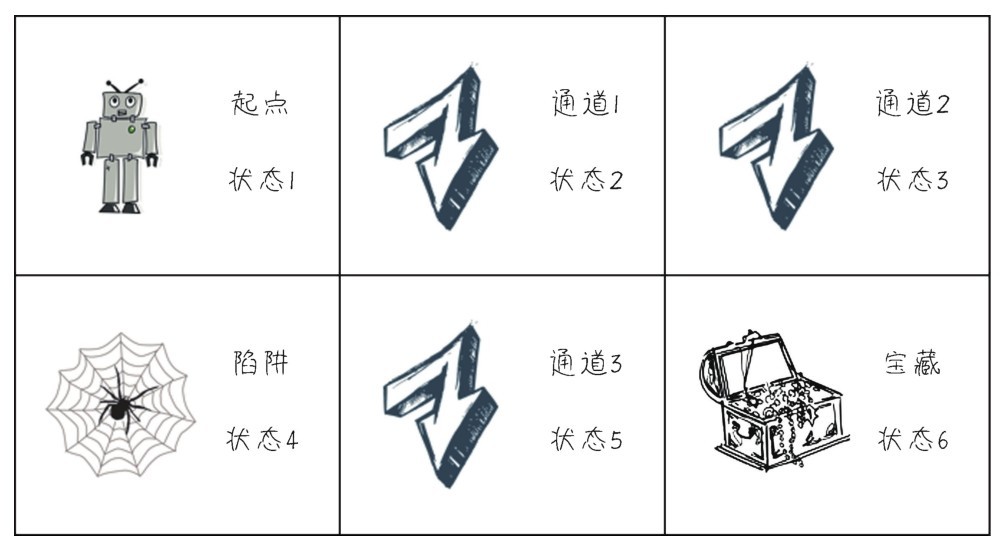

+强化学习(reinforcement learning)研究的目标是智能体(agent)如何基于环境而做出行动反应,以取得最大化的累积奖励。如下图所示,智能体通过所得到的奖励(或惩罚)、环境反馈回来的状态以及动作与环境互动。其灵感据说来源于心理学中的行为主义理论—根据正强化或负强化(也就是奖惩)的办法来影响并塑造人的行为。

+ +

+ 强化学习—智能体通过奖励、状态以及动作与环境互动

+强化学习和普通机器学习的差异在于:普通机器学习是在开放的环境中学习,如自动驾驶,每一次向前驾驶都带给机器新的环境,新环境(新数据)永无止息;而强化学习的环境是封闭的,如智能体玩游戏,击中一个敌人,环境中就减少一个敌人,如Alpha Go下围棋,每落一个子,棋盘就少一个目,棋盘永远不会增大或减小。那么在这样的闭环中,就比较容易实现对机器刚才所采取的策略进行奖惩。

+而强化学习和监督学习的差异在于:监督学习是从数据中学习,而强化学习是从环境给它的奖惩中学习。监督学习中数据的标签就是答案,具有比较明显的对、错倾向,如果把本来是猫的图片当成狗的图片,就要把权重往猫的方向调整;而强化学习得到惩罚后(比如下棋输了),没人告诉它具体哪里做错了,所以它调整策略的时候需要的智能更强,要求它的思路也更加广阔、更为长远。它不一定每次都明确地选择最优动作,而是要在探索(未知领域)和利用(当前知识)之间找到平衡。

+注意了,除了上面说的监督学习、无监督学习、半监督学习、深度学习、强化学习之外,还有很多其他的机器学习方法(算法),比如说集成学习(ensemble learning)、在线学习(online learning)、迁移学习(transfer learning)等,每隔一段时间,就会有新的学习热点涌现。因此,一旦你们踏进了机器学习领域,也就等同于踏进了“终身学习”之旅了。

+“看来,不好好‘学习’真的不行啊。”小冰说。

+机器学习都能做些什么呢?

+它的各种应用早就已经“飞入寻常百姓家”了。从我们每天用的搜索引擎到淘宝的商品推荐系统,哪里没有机器学习的身影呢?因为应用场景太多了,所以已经不可能给出一个完整的机器学习应用列表了。

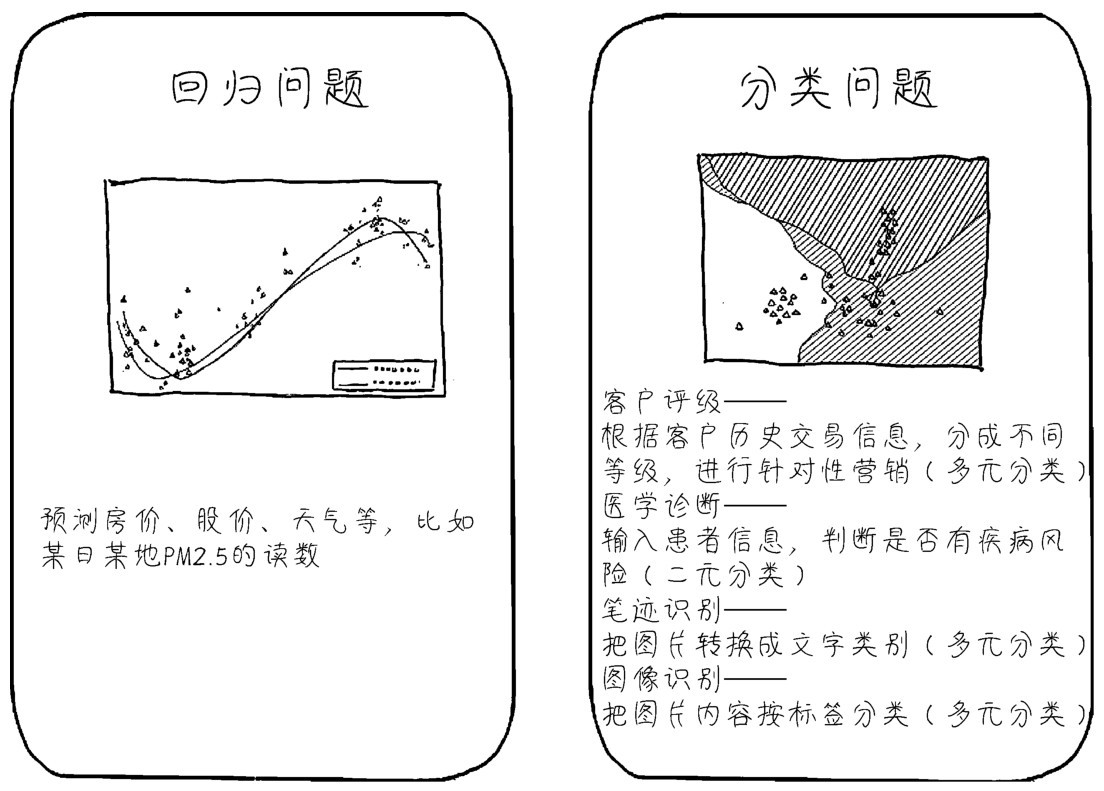

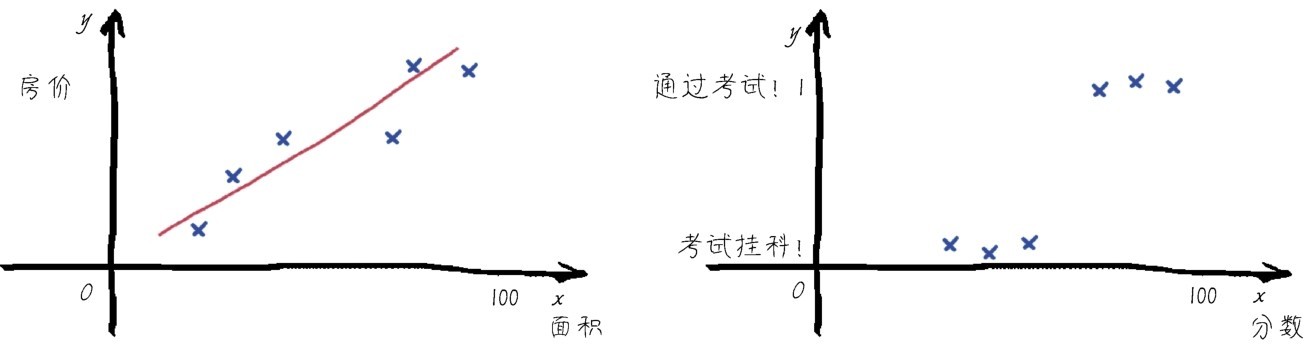

+这样只好从要解决的问题类型来分析机器学习,那么请记住回归(regression)和分类(classification)是两种最常见的机器学习问题类型,如下图所示。

+■回归问题通常用来预测一个值,其标签的值是连续的。例如,预测房价、未来的天气等任何连续性的走势、数值。比较常见的回归算法是线性回归(linear regression)算法以及深度学习中的神经网络等。

+ +

+ 目前分类问题的机器学习应用场景比回归问题的更广泛

+■分类问题是将事物标记一个类别标签,结果为离散值,也就是类别中的一个选项,例如,判断一幅图片上的动物是一只猫还是一只狗。分类有二元分类和多元分类,每类的最终正确结果只有一个。分类是机器学习的经典应用领域,很多种机器学习算法都可以用于分类,包括最基础的逻辑回归算法、经典的决策树算法,以及深度学习中的神经网络等。还有从多元分类上衍生出来的多标签分类问题,典型应用如社交网站中上传照片时的自动标注人名功能,以及推荐系统—在网站或者App中为同一个用户推荐多种产品,或把某一种产品推荐给多个用户。

+当然,除回归问题和分类问题之外,机器学习的应用场景还有很多。比如,无监督学习中最常见的聚类(clustering)问题是在没有标签的情况下,把数据按照其特征的性质分成不同的簇(其实也就是数据分类);还有一种无监督学习是关联规则,通过它可以找到特征之间的影响关系。

+又比如时间序列,指在内部结构随时间呈规律性变化的数据集,如趋势性数据、随季节变化的数据等。时间序列问题其实也就是和时间、周期紧密关联的回归问题。具体应用场景包括预测金融市场的波动,推断太阳活动、潮汐、天气乃至恒星的诞生、星系的形成,预测流行疾病传播过程等。

+还有结构化输出。通常机器学习都是输出一个答案或者选项,而有时需要通过学习输出一个结构。什么意思呢?比如,在语音识别中,机器输出的是一个句子,句子是有标准结构的,不只是数字0~9这么简单(识别0~9是分类问题),这比普通的分类问题更进一步。具体应用场景包括语音识别—输出语法结构正确的句子、机器翻译—输出合乎规范的文章。

+还有一部分机器学习问题的目标不是解决问题,而是令世界变得更加丰富多彩,因此AI也可以进行艺术家所做的工作,例如以下几种。

+■Google的Dreamwork可以结合两种图片的风格进行艺术化的风格迁移。

+■生成式对抗网络GAN能造出以假乱真的图片。

+■挖掘数字特征向量的潜隐空间,进行音乐、新闻、故事等创作。

+我们可以把这种机器学习应用称为生成式学习。

+还有些时候,机器学习的目标是做出决定,这时叫它们决策性问题。决策性问题本质上仍然是分类问题,因为每一个决策实际上还是在用最适合的行为对环境的某一个状态进行分类。比如,自动驾驶中的方向(左、中、右),以及围棋中的落点,仍然是19×19个类的其中之一。具体应用场景包括自动驾驶、智能体玩游戏、机器人下棋等。在很多决策性问题中,机器必须学习哪些决策是有效的、可以带来回报的,哪些是无效的、会带来负回报的,以及哪些是对长远目标有利的。因此,强化学习是这种情况下的常用技术。

+总体来说,机器学习的诀窍在于要了解自己的问题,并针对自己的问题选择最佳的机器学习方法(算法),也就是找到哪一种技术最有可能适合这种情况。如果能把场景或任务和适宜的技术连接起来,就可以在遇到问题时心中有数,迅速定位一个解决方向。下图将一些常见的机器学习应用场景和机器学习模型进行了连接。

+ +

+ 将一些常见的机器学习应用场景和机器学习模型进行连接

+看到有些同学微微皱起了眉头,咖哥说:“同学们不要有畏难情绪嘛,图中的名词儿你们觉得太多、太陌生,这很正常。当我们把课程学完,回头再看它们时,就变得容易啦!”

+还要说一点:机器学习不是万能的,它只能作用于和已知数据集类似的数据,不能抽象推广—在猫狗数据集中已经训练成功的神经网络如果读到第一张人类图片,很可能会“傻掉”。因此,机器的优势仍在于计算量、速度和准确性,尚无法形成类似人类的智力思维模式(因为人类的智力思维模式难以描述,也难以用算法来形容和定义)。这大概是AI进一步发展的瓶颈所在吧。

+不过,虽然道路是曲折的,但前途仍然是光明的,AI的更多突破,指日可待。让我们群策群力,为AI领域已经相对成熟的技术,如机器学习的普及,添砖加瓦。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/2.1.2 \345\277\253\346\215\267\347\232\204\344\272\221\345\256\236\346\210\230\345\255\246\344\271\240\346\250\241\345\274\217/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/2.1.2 \345\277\253\346\215\267\347\232\204\344\272\221\345\256\236\346\210\230\345\255\246\344\271\240\346\250\241\345\274\217/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..a99d807a5e64fe7e677958f1f5e23f4c40a06873 --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/2.1.2 \345\277\253\346\215\267\347\232\204\344\272\221\345\256\236\346\210\230\345\255\246\344\271\240\346\250\241\345\274\217/text.html" @@ -0,0 +1,179 @@ + +大家听了咖哥这一番剖析,感觉概念上清晰多了,也受到了很大的鼓舞,决心“面对”而不是“逃避”老板“丢过来”的挑战。现在,小冰甚至觉得有点小兴奋:攻克一个与未来息息相关的技术是多么有趣的事情。

+咖哥接着说:“说了半天各种‘学习’的类型和特点,那些也只是概念和理论。现在,咱们亲自运行一个机器学习实例,看一看机器学习的项目实战是什么模样,到底能解决什么具体问题。”

+“不过,我听说机器学习对硬件要求挺高的,好像需要配置很贵的GPU?”小冰问。

+“也不一定!”咖哥说。

+咖哥对这个时代的学习方式有他的看法:他觉得,需要去培训中心进修,或者要先安装一大堆东西才能开始上手一项新技术的日子已经一去不复返了。

+“学习新技能的门槛比以前低太多了。因为在线学习这么发达,最新的知识、技术甚至论文每时每刻都会直接被推送至世界的每一个角落,所以相对贫穷的地方也涌现出了一大堆高科技人才。在线学习,这是低成本自我提升的最好方法。”咖哥说,“不管是在通州、德州,还是在徐州、广州,你们完全可以和斯坦福大学的学生学习相同的AI课程。”

+ +

+ 咖哥告诉小冰,在线学习非常方便

+想学机器学习的人,不大可能没有听说过吴恩达。他开设的机器学习课程已经造就了数以万计的机器学习人才,如果英文好,你们可以去他的Coursera网站看看。那是众多的大规模开放在线课程(Massive Open Online Course,MOOC)平台之一,里面还有一些免费课程。

+吴恩达老师采用Octave和MATLAB作为他的机器学习教学环境。我当年学他的课程时,就惊讶于MATLAB Online的强大,什么都不用安装,就可以直接上网实战,如下图所示。

+ +

+ 直接上网使用MATLAB Online进行机器学习项目实战

+小冰插嘴问道:“既然吴老师的机器学习课程这么好,又是免费的,我直接和他学不就好了?”咖哥笑答:“也可以啊,但还是大有不同。吴老师的课程虽然深入浅出,不过仍有门槛,他已经尽量压缩了数学内容,可公式的推导细节还是不少啊!”咖哥喝了一口咖啡,很自信地说:“我会把机器学习的门槛进一步降低,还会着重介绍深度学习的内容。我保证,能让你们更轻松地听懂我设计的全部内容。”

+注意,吴老师课程中的MATLAB环境虽然是机器学习的好工具,但它可不是开源软件,长期使用它需要购买版权。那么,有没有基于Python的免费平台,直接在线进行机器学习的实战?—有,而且还不止一个!

+答案就是使用在线的Jupyter Notebook。你们可以把Jupyter Notebook想象成一个类似于网页的多媒体文档,里面有字、有图、能放公式、有说明。但是,比普通网页更高一筹的是,它还能运行Python代码(如下图所示)。

+ +

+ 一个在线的Jupyter Notebook

+有了在线的Jupyter Notebook,根本不需要在本机安装Python运行环境就可以“玩”机器学习。而且大多的Python库、机器学习库和深度学习库,在线的Jupyter Notebook都支持。

+免费提供在线的Jupyter Notebook的网站有很多,比如Binder、Kaggle Notebooks、Google Colaboratory、Microsoft Azure Notebooks、Co Calc和Datalore等,都挺不错的,但是全部都介绍的话内容太多了。挑两个比较常用的说一说,让大家见识一下上手机器学习实战的速度。

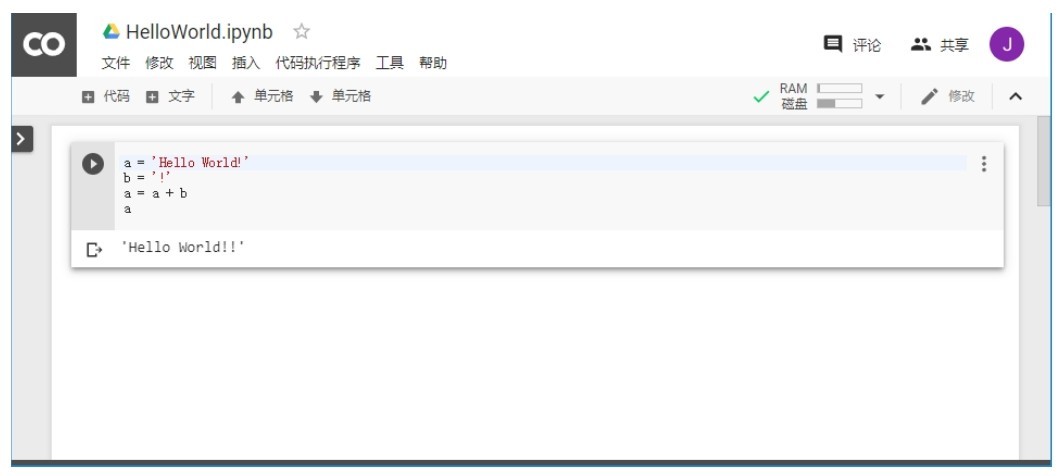

+Google Colaboratory(简称Colab),是Google提供的一个AI研究与开发平台。Colab给广大的AI开发者提供了GPU,型号为Tesla K80。在Colab中可以轻松地运行Keras、Tensor Flow、Py Torch等框架。下面的图中,我随便写了一个“Hello World!!”程序。

+ +

+ 在Colab中写一个Hello World程序

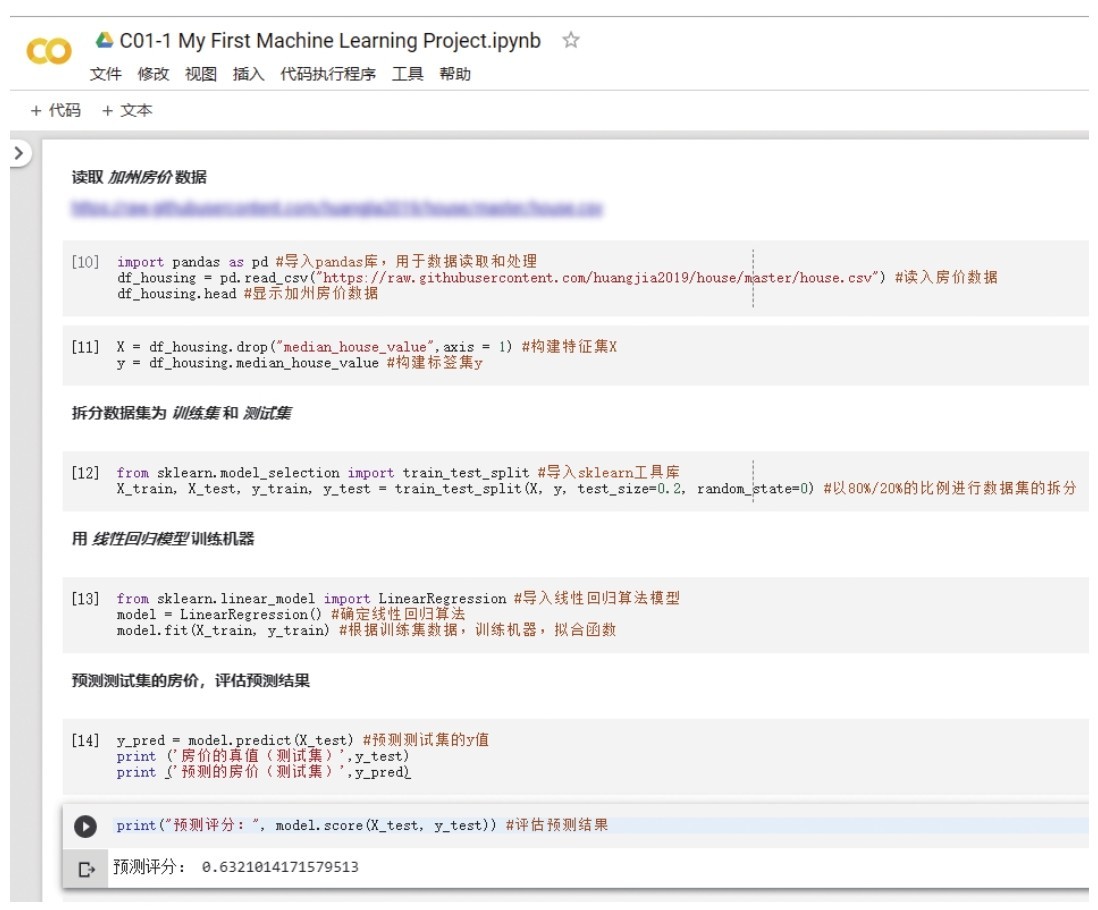

+在Colab中,也自带了很多非常优秀的机器学习入门教程以及示例代码,你们如果有兴趣,也可以去看一看,练习一下那些示例。话不多说,我们现在从头到尾写一个属于自己的机器学习程序。

+本课程有配套的代码包和数据集,第一个程序的文件保存在“X:源码包\第1课 机器学习实战\教学用例1 加州房价预测”中,大家可以自行取用。

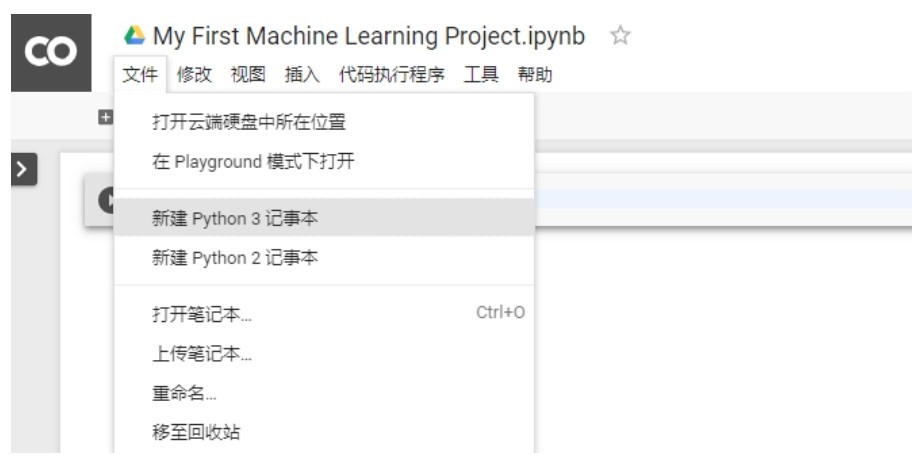

+在搜索引擎中搜一下Colab,通过链接直接进入其环境,选择“文件”→“新建Python 3记事本”,如下图所示。

+ +

+ 在Colab中新建Python 3记事本

+ 咖哥发言

咖哥发言

如果访问Colab有困难,可以试试其他Jupyter Notebook网站,如Kaggle、Binder、Datalore等。代码是通用的,但是要注意各个平台的不同设定选项。比如,在Kaggle中,要访问Internet上的文件和数据集,需打开屏幕右侧Setting中的Internet选项。

+首先,请大家注意这个运行环境里面的代码段和文字信息段都是一块一块的。所以不需要把整个程序都编译完成后才进行调试。写一段,就运行一段。这样很容易及早发现问题。等到程序完成后,也可以通过整体运行功能从头到尾执行全部代码。

+在新创建的Python 3记事本中输入下面几行代码:

+import pandas as pd #导入Pandas, 用于数据读取和处理

+# 读入房价数据,示例代码中的文件地址为internet链接,读者也可以下载该文件到本机进行读取

+# 如,当数据集和代码文件位于相同本地目录,路径名应为"./house.csv",或直接为"house.csv"亦可

+df_housing = pd.read_csv("https://raw.githubusercontent.com/huangjia2019/house/

+master/house.csv")

+df_housing.head #显示加州房价数据

+上面的代码解释如下。

+■先导入了Pandas,这是一个常见的Python数据处理函数库。

+■用Pandas的read_csv函数把一个网上的共享数据集(csv文件)读入DataFrame数据结构df_housing。这个文件是美国加利福尼亚州(后文简称加州)某个时期的房价数据集,我已经提前把它保存在GitHub中了。

+■用Data Frame数据结构的head方法显示数据集中的部分信息。

+单击代码左侧 箭头就可以运行代码,读取并显示出加州房价数据集中的信息,结果如下:

箭头就可以运行代码,读取并显示出加州房价数据集中的信息,结果如下:

< longitude latitude ... median_income median_house_value

+0 -114.31 34.19 ... 1.4936 66900.0

+1 -114.47 34.40 ... 1.8200 80100.0

+2 -114.56 33.69 ... 1.6509 85700.0

+..

+16997 -124.30 41.84 ... 3.0313 103600.0

+16998 -124.30 41.80 ... 1.9797 85800.0

+16999 -124.35 40.54 ... 3.0147 94600.0

+[17000 rows x 9 columns]>

+如果上面这个数据读入和显示的过程通过其他语言来实现,可要费不少力气了。但是Python的功能性在这儿就体现出来了—通过一个函数或一个方法,直接完成一件事儿,不拖泥带水。

+说一下这个数据集。这是加州各地区房价的整体统计信息(不是一套套房子的价格信息),是1990年的人口普查结果之一,共包含17 000个样本。其中包含每一个具体地区的经度(longitude)、纬度(latitude)、房屋的平均年龄(housing_median_age)、房屋数量(total_rooms)、家庭收入中位数(median_income)等信息,这些信息都是加州地区房价的特征。数据集最后一列“房价中位数”(median_house_value)是标签。这个机器学习项目的目标,就是根据已有的数据样本,对其特征进行推理归纳,得到一个函数模型后,就可以用它推断加州其他地区的房价中位数。

+然后构建特征数据集X和标签数据集y,如下段代码所示。注意,Python是大小写区分的,而且在机器学习领域,似乎有一种习惯是把特征集X大写,把标签集y小写。当然,也并不是所有人都会遵循这个习惯。

+X = df_housing.drop("median_house_value", axis = 1) #构建特征集X

+y = df_housing.median_house_value #构建标签集y

+上面的代码使用drop方法,把最后一列median_house_value字段去掉,其他所有字段都保留下来作为特征集X,而这个median_house_value字段就单独赋给标签集y。

+现在要把数据集一分为二,80%用于机器训练(训练数据集),剩下的留着做测试(测试数据集)如下段代码所示。这也就是告诉机器:你看,拥有这些特征的地方,房价是这样的,等一会儿你想个办法给我猜猜另外20%的地区的房价。

+from sklearn.model_selection import train_test_split #导入sklearn工具库

+X_train, X_test, y_train, y_test = train_test_split(X, y,

+test_size=0.2, random_state=0) #以80%/20%的比例进行数据集的拆分

+其实,另外20%的地区的房价数据,本来就有了,但是我们假装不知道,故意让机器用自己学到的模型去预测。所以,之后通过比较预测值和真值,才知道机器“猜”得准不准,给模型打分。

+下面这段代码就开始训练机器:首先选择LinearRegression(线性回归)作为这个机器学习的模型,这是选定了模型的类型,也就是算法;然后通过其中的fit方法来训练机器,进行函数的拟合。拟合意味着找到最优的函数去模拟训练集中的输入(特征)和目标(标签)的关系,这是确定模型的参数。

+from sklearn.linear_model import Linear Regression #导入线性回归算法模型

+model = Linear Regression() #确定线性回归算法

+model.fit(X_train, y_train) #根据训练集数据, 训练机器, 拟合函数

+运行代码段后,Colab会输出Linear Regression模型中一些默认设定项的信息:

+Linear Regression(copy_X=True, fit_intercept=True, n_jobs=None, normalize=False)

+好了,此时已经成功运行完fit方法,学习到的函数也已经存在机器中了,现在就可以用model(模型)的predict方法对测试集的房价进行预测,如下段代码所示。(当然,等会儿我们也可以偷偷瞅一瞅这个函数是什么样……)

+y_pred = model.predict(X_test) #预测验证集的y值print ('房价的真值(测试集)', y_test)

+print ('预测的房价(测试集)', y_pred)

+预测好了!来看看预测值和真值之间的差异有多大:

+房价的真值(测试集)[171400.189600.500001....142900.128300.84700.]

+预测的房价(测试集)[211157.218581.465317....201751.160873.138847.]

+虽然不是特别准确,但基本上预测值还是随着真值波动,没有特别离谱。那么显示一下这个预测能得多少分:

+print("给预测评分:", model.score(X_test, y_test)) #评估预测结果

+结果显示:0.63213234分!及格了!

+给预测评分:0.63213234

+小冰问道:“等等,什么及格了?总得有个标准。0.63213234分到底是怎么来的?”

+咖哥说:“Sklearn线性回归模型的score属性给出的是R2分数,它是一个机器学习模型的评估指标,给出的是预测值的方差与总体方差之间的差异。要理解这个,需要一点儿统计学知识哦,现在你们只要知道,要比较不同的模型,都应采用相同的评估指标,在同样的标准下,哪个分数更高,就说明哪个模型更好!”

+还有,刚才说过可以看这个机器学习的函数是什么样儿,对吧?现在可以用几行代码把它大致画出来:

+import matplotlib.pyplot as plt #导入Matplotlib库

+#用散点图显示家庭收入中位数和房价中位数的分布

+plt.scatter(X_test.median_income, y_test, color='brown')

+#画出回归函数(从特征到预测标签)

+plt.plot(X_test.median_income, y_pred, color='green', linewidth=1)

+plt.xlabel('Median Income') #x轴:家庭收入中位数

+plt.ylabel('Median House Value') #y轴:房价中位数

+plt.show() #显示房价分布和机器学习到的函数模型

+x轴的特征太多,无法全部展示,我只选择了与房价关系最密切的“家庭收入中位数”median_income作为代表特征来显示散点图。下图中的点就是家庭收入/房价分布,而绿色线就是机器学习到的函数模型,很粗放,都是一条一条的线段拼接而成,但是仍然不难看出,这个函数模型大概拟合了一种线性关系。

+ +

+ 函数模型大概拟合了一种线性关系(请见339页彩色版插图)

+加州各个地区的平均房价中位数有随着该地区家庭收入中位数的上升而增加的趋势,而机器学习到的函数也同样体现了这一点。

+“这说明什么呢,同学们?”咖哥自问自答,“物以类聚,人以群分,这显示的就是富人区的形成过程啊!”

+好,现在咱们看一下Colab的界面,这个Jupyter Notebook代码加上一部分输出大致如下图所示。

+ +

+ Colab程序

+至此,一个很简单的机器学习任务就被完成了!麻雀虽小,五脏俱全。不到20行的代码,我们已经应用线性回归算法,预测了大概3000多个加州地区的房价中位数。当然,很多代码你们可能还是一知半解的。而且这个示例很粗糙,没有做特征工程,没有数据预处理,机器学习模型的选择也很随意。但是那并不会影响,随着更深入的学习,同学们会越来越清楚自己在做什么,而且在以后的课程中,还会深入剖析Linear Regression这个模型背后到底隐藏了些什么。

+“现在,最重要的是,你们已经能够开始利用Colab编写自己的Python程序代码了。Jupyter Notebook正是为新手训练所准备的。一边试试代码,一边写一些文字笔记,这真是一种享受啊……”咖哥似乎十分开心,抿了一口手边的咖啡……

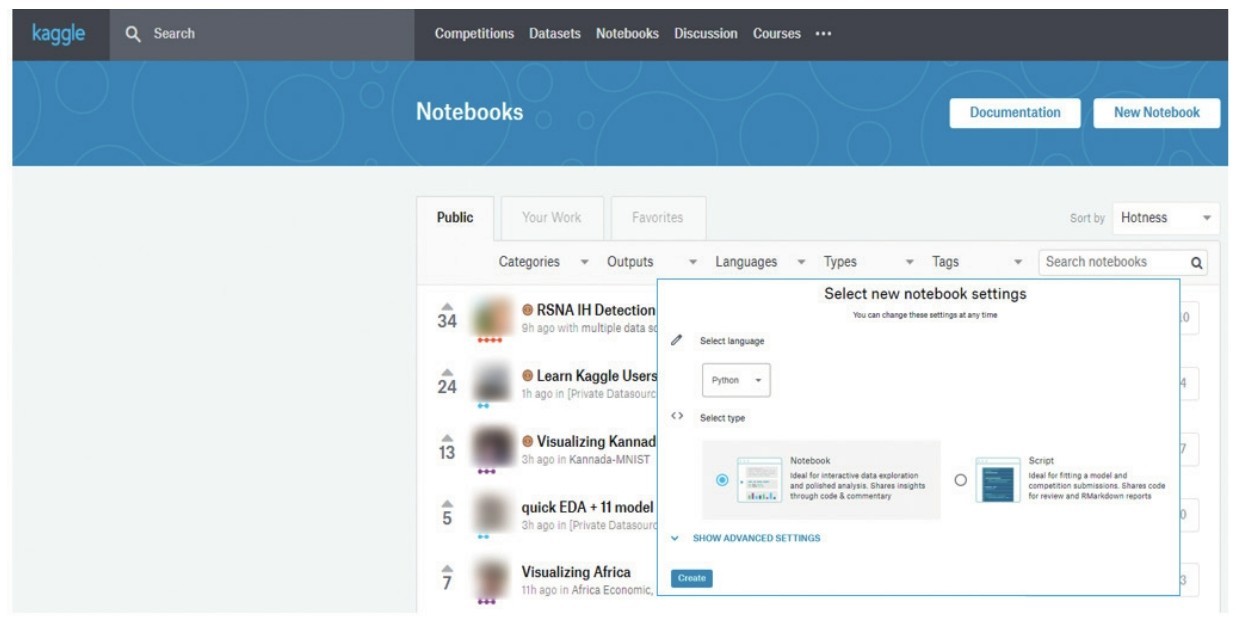

+下面大力推荐我的最爱—Kaggle网站,同学们搜一下“Kaggle”就能找到它。对于机器学习爱好者来说,Kaggle大名鼎鼎,而且特别实用。它是一个数据分析和机器学习竞赛平台:企业和研究者在上面发布数据,数据科学家基于这些数据进行竞赛以创建更好的机器学习模型。Kaggle的口号是Making Data Science a Sport(使数据科学成为一项运动)。

+Kaggle就是一个机器学习小项目集散地。在这里,你们几乎可以找到你们想要的任何东西:竞赛(也就是机器学习实战项目)、数据集、源代码、课程、社区。这里是机器学习初学者的天堂。而且,你们有没有觉得Kaggle、Kaggle这发音很像“咖哥、咖哥”?

+同学们忽然觉得咖哥相当自恋。

+咖哥浑然不觉,接着说:“好,现在你们去那儿先注册一个账号吧。”

+账号注册好之后,在Notebooks中单击“New Notebook”,就可以新建一个自己的机器学习应用程序,页面会提示是创建一个比较纯粹的Python Script还是一个Notebook,如下图所示。不过,我还是更喜欢图文并茂的Notebook。

+ +

+ Kaggle:新建Notebook

+ 咖哥发言

咖哥发言

同学们注意,Kaggle里面的Notebook原来叫作Kernel,后来跟着其他网站的习惯,统一用Notebook。然而在Kaggle网站中,很多地方还是沿用Kernel这个名称。

+比起Colab,Kaggle最大的优势可能在于自带很多的数据集(Datasets),这些数据集各有特色。在Kaggle中,“牛人”们纷纷创建自己的Notebook针对同一个数据集进行机器学习实战,然后互相比拼谁的更优秀,如下图所示。这种学习方式也大大地节省了自己搜集数据的时间。

+ +

+ Kaggle中的数据集:可以基于数据集创建Notebook

+如何把Kaggle Notebook和数据集链接在一起呢?主要有以下几种方法。

+(1)选择任何一个数据集,然后单击“New Notebook”按钮,就可以基于这个数据集开始自己的机器学习之旅了。

+(2)选择Datasets之后,单击“Notebooks”,看看各路“大咖”针对这个数据集已经开发出了一些什么东西,然后喜欢的话单击“Copy and Edit”,复制其Notebook,慢慢研习,在“巨人的肩膀上”继续开发新模型。这里的课程中也是借鉴了一些大咖们的Notebooks代码,当然我已经通过邮件得到了他们的授权。

+(3)直接选择Notebooks,单击“New Notebook”,有了Notebook之后,然后再通过“File”→“Add or upload dataset”菜单项选择已有的数据集,或者把自己的新数据集上传到Kaggle,如下图所示。

+ +

+ 上传自己的新数据集到Kaggle

+我个人比较喜欢用Kaggle而不是用Colab,因为Kaggle强在其大量的共享数据集和大咖们无私分享的Notebooks。另外,要在Colab中使用自己的数据集,需要先上传到Google Drive,然后同特定方式读取,这样总觉得操作起来多了一些麻烦,不如Kaggle的Datasets用起来那么直接。

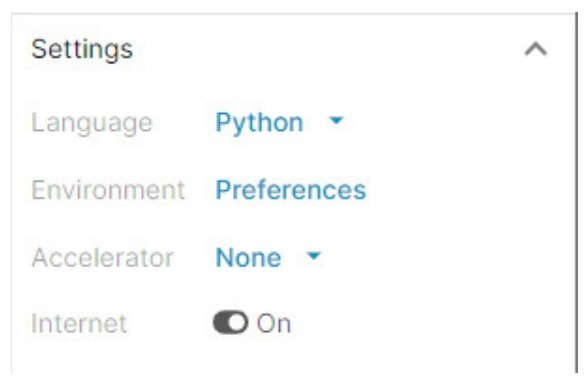

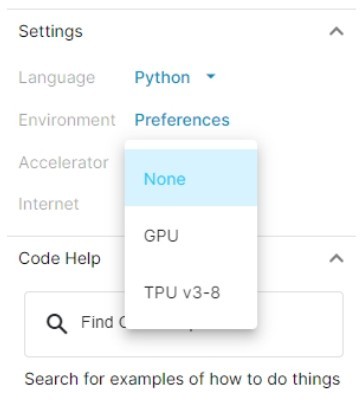

+而且Kaggle也有GPU,型号还是比T80更新的P100!通过Notebooks页面右侧的Settings选项(如下图所示),咱也能用上它(不过好像每周只有几小时的GPU配额)!

+ +

+ Kaggle的GPU选项

+还有,TPU是比GPU更快的硬件加速器,Google和Kaggle都免费提供给大家使用。另外,也有人声称Colab比Kaggle Notebook更稳定,比较不容易在网页的刷新过程中丢失代码。这只是道听途说而已,我使用Kaggle的时候还没出现过丢失代码的情况。

+如果还是希望在自己的电脑上安装一个开发工具,那么Anaconda是首选。Anaconda下载页面如下图所示。

+ +

+ Anaconda下载页面

+Anaconda是当前数据科学领域流行的Python编辑环境之一,安装使用都极为简单。从上面的图示中也可以看出,其中预装了很多Python数据科学工具库,比如Num Py、Pandas等。而且支持多种操作系统,比如Windows、mac OS,以及Linux。

+这里不赘述具体安装过程了,在官网上跟着说明进行安装即可。

+由于Anaconda封装了很多的Python库,安装之后在本机创建Jupyter Notebook非常容易。而且无论是在线还是本机运行,Jupyter Notebook最大优势是简单易用、强交互、易展示结果,即可视化功能很强,我们可以查看每一段代码的输出与运行效果。

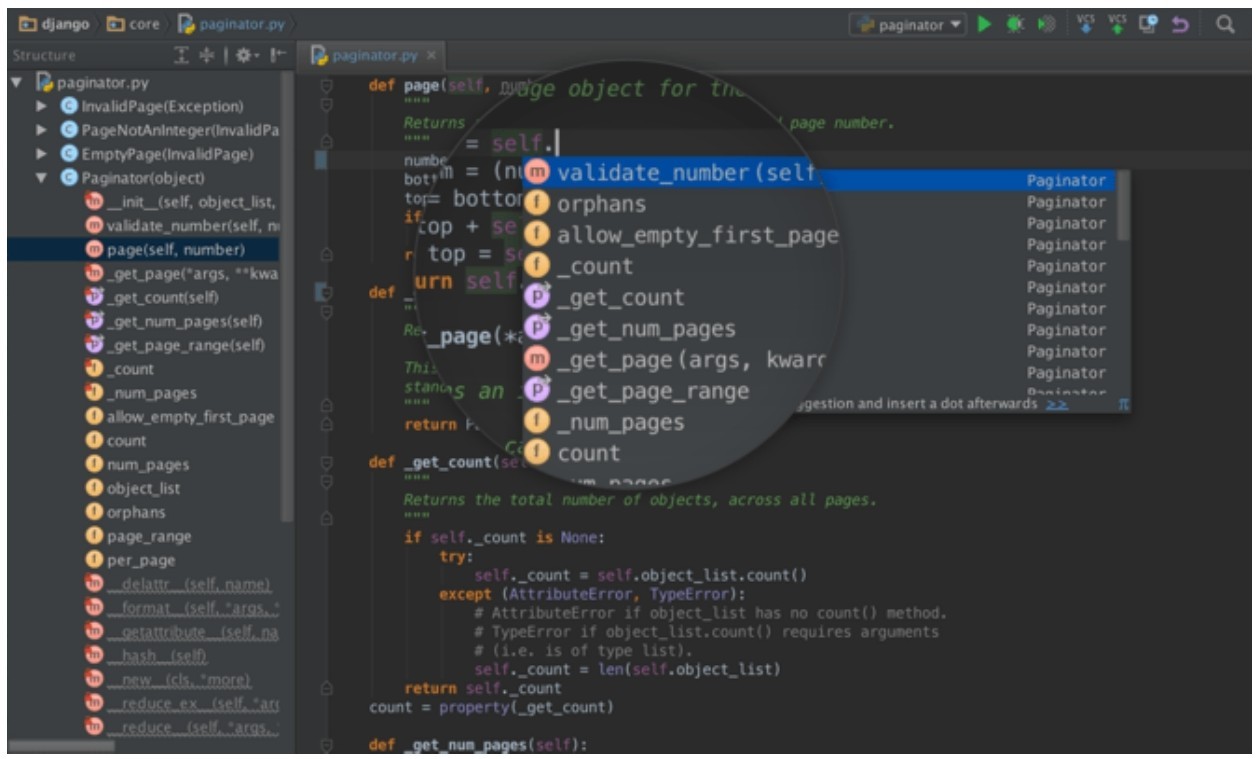

+作为入门学习工具,Jupyter Notebook非常适合,但它也有局限性,比如版本控制难、不支持代码调试(debug)等。因此,在大型、复杂的机器学习和工程实践中,还需要配合更为强大的开发环境来使用。同学们进阶之后,也可以尝试用一用Py Charm这样的能够调试,以及便捷地查看数组结构和交互式图表的Python集成开发环境 (IDE),如下图所示。

+ +

+ Python集成开发环境—Py Charm

+咖哥问:“刚才我们进行了一次简单的机器学习项目实战,并且介绍了几个Jupyter Notebook开发平台。现在考一考同学们已经学过的内容。谁能说说机器学习的定义是什么?”

+一位同学回答:“机器学习,就是机器基于输入数据集中的信息来训练、确立模型,对以前从未见过的数据做出有用的预测。”

+咖哥说:“总结得不错。下面给出机器学习中其他一些基本术语的定义,如表1-1所示。”

+表1-1 机器学习的基本术语

+ +

+再稍微详细地说一说上表中最为重要的3个术语:特征、标签和模型。

+特征是机器学习中的输入,原始的特征描述了数据的属性。它是有维度的。特征的维度指的是特征的数目(不是数据集里面样本的个数),不同的数据集中的数据特征的维度不同,有多有少。

+■少,可以少到仅有一个特征,也就是一维特征数据。比如房价(标签)仅依据房屋面积(特征)而定。

+■多,可以多到几万,几十万。比如一个100px×100px的RGB彩色图片输入,每一个像素都可以视为一个特征,也就是1万维,再乘以RGB 3个颜色通道,那么这个小小的图片数据的特征维度就可以达到3万维。

+举例来说,如果预测商品的销量,把商品的类别、价格和推荐级别这3个属性定义为商品的特征,那么这个数据集就是三维特征数据集。其中的一个样本的格式如下:

+(x1,x2,x3)

+然而,所谓三维特征,其实只是二维数据结构中的一个轴(另一个轴是样本轴)上的数据个数。为了避免混淆,我们以后会把向量、矩阵和其他张量的维度统称为阶,或者称为1D向量、2D矩阵、3D张量等。因此,以后一提“维”,主要指的就是数据集中特征X的数目。一般来说,特征维度越高,数据集越复杂。这里的“维”和“阶”有点绕,以后还会反复强调。

+ 咖哥发言

咖哥发言

这里提到的张量是机器学习的数据结构,其实也就是程序中的数组。在第2课中,才会很详细地讲解各种张量的结构。向量、矩阵都是张量的一种。简单地理解,向量张量是一个1D数组,而矩阵张量是一个2D数组。

+标签,也就是机器学习要输出的结果,是我们试图预测的目标。示例里面的标签是房价。实际上,机器学习要解决什么问题,标签就是什么。比如:未来的股票价格、图片中的内容(猫、狗或长颈鹿)、文本翻译结果、音频的输出内容、Alpha Go的下一步走棋位置、自动导购汽车的行驶方向等。

+下面是一个有标签数据样本的格式:

+(x1,x2,x3;y)

+标签有时候是随着样本一起来的,有时候是机器推断出来的,称作预测标签y'(也叫y-hat,因为那一撇也可放在y的上方,就像是戴了一个帽子的y)。比较y和y'的差异,也就是在评判机器学习模型的效果。

+表1-2显示的是刚才实战案例中加州房价数据集中的部分特征和标签。

+表1-2 加州房价数据集中的特征和标签

+ +

+并不是所有的样本都有标签。在无监督学习中,所有的样本都没有标签。

+模型将样本映射到预测标签y'。其实模型就是函数,是执行预测的工具。函数由模型的内部参数定义,而这些内部参数通过从数据中学习规律而得到。

+在机器学习中,先确定模型的类型(也可以说是算法),比如是使用线性回归模型,还是逻辑回归模型,或者是神经网络模型;选定算法之后,再确定模型的参数,如果选择了线性回归模型,那么模型f(x) = 3x + 2中的3和2就是它的参数,而神经网络有神经网络的参数。类型和参数都确定了,机器学习的模型也就最终确定了。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/4.1.4 Python\345\222\214\346\234\272\345\231\250\345\255\246\344\271\240\346\241\206\346\236\266/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/4.1.4 Python\345\222\214\346\234\272\345\231\250\345\255\246\344\271\240\346\241\206\346\236\266/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..6d2108f4a01144290e83648d2cbecede96c967fc --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/4.1.4 Python\345\222\214\346\234\272\345\231\250\345\255\246\344\271\240\346\241\206\346\236\266/text.html" @@ -0,0 +1,64 @@ + +大家有没有想过,为什么Python不知不觉中成了最流行的机器学习语言之一?

+Python像Java、C++、Basic一样,是程序员和计算机交互的方式。

+但是,为什么选择用Python。有句话大家可能都听过:人生苦短,Python是岸。

+这话什么意思呢?Python易学、易用、接地气。这就好比一个学编程的人,在程序设计的海洋里面遨游,游啊,游啊,总觉得这海实在太浩瀚了,找不着北。突然发现了Python这种语言,就上岸了……

+Python是一种很简洁的语言,容易写、容易读,而且在机器学习方面有独特的优势。

+机器学习的目的是解决实际问题,而不是开发出多强大的应用软件。因此,编写程序代码是工具而非目的,追求的是方便。搞数据科学和机器学习的人并不一定都是资深程序员,他们希望将自己头脑中的公式、逻辑和思路迅速转化到计算机语言。这个转化过程消耗的精力越少越好,而程序代码就不需要有多么高深、多么精致了。

+而Python正是为了解决一个个问题而生的,比如数据的读取、矩阵的点积,一个语句即可搞定,要是用传统的C++、Java,那还真的很费力气。还有切片、广播等操作,都是直接针对机器学习中的数据结构—张量而设计的。

+上面说的数据操作如此容易,很大程度上也是Num Py的功劳,我们以后还会反复提到Num Py这个数学函数库(扩展包)。因此,另外特别重要的一点就是Python的开发生态成熟,除Num Py外,还有非常多的库,这些库就是机器学习的开放框架。有很多库都是开源的,拿来就可以用。

+综上,便捷和实用性强似乎是Python的天然优势。我觉得Python和一些老牌语言相比,有点像口语和文言文的区别,文言文虽然高雅,但是不接地气。因为Python接地气,所以用户社群强大、活跃。机器学习圈的很多大咖们也隶属于这个Python社群,开发了很多优质的库。这样一来Python在AI时代,搭着数据科学和机器学习顺风车,弯道超车Java和C++,成了最流行的编程语言之一。

+大家可能听说过机器学习和深度学习“框架”这个名词,这个框架的作用可是很大的。想象一下,有一天老板说:“来,给你们一个任务,用机器学习的方法给咱们这些图片分类。”你们去Google查询了一下,发现这种图片分类任务用卷积神经网络来解决最好。但是你们很疑惑从头开始编写一个卷积神经网络是好做法吗?

+Python的机器学习框架,也就是各种Python库,里面包含定义好的数据结构以及很多库函数、方法、模型等(即API)。我们只需要选择一个适合的框架,通过调用其中的API,编写少量代码,就可以快速建立机器学习模型了。为什么刚才的机器学习实战中只用了不到20行代码就能够完成预测加州房价这么“艰巨”的任务?其中最大的秘密就是使用了框架中的API。

+良好的框架不仅易于理解,还支持并行化计算(即硬件加速),并能够自动计算微分、链式求导(“不明觉厉”是吧?不要紧,正因为框架把这些都做了,同学们就无须自己做这些不懂的东西)。

+下图中,给出了8个机器学习中常用的库。

+ +

+ 8个机器学习常用的库

+这8个库,可分为3大类:Pandas和Num Py提供数据结构,支持数学运算;Matplotlib和Seaborn用于数据可视化;后面4个库提供算法,其中的Scikit-learn是机器学习框架, Tesnsor Flow、Keras和Py Torch则是深度学习框架,可以选择一个来用。另有一些曾经有影响力的框架,如Theano、Caffe、CNTK等,随着“江山代有才人出”,使用率已经大大下降。而新的更方便的库呢?那也一定会继续涌现。

+下面分别简单说说它们。

+1.Pandas

+我们已经使用过Pandas了!请回头看一下第一个机器学习项目的第一行代码,如下段代码所示。通过这一行代码,就可以把整个Pandas中的所有函数、数据结构导入当前机器学习程序的运行环境。

+import pandas as pd #导入Pandas, 用于数据读取和处理

+Pandas是基于Num Py的数据分析工具,里面预置了大量库函数和标准数据结构,可以高效地操作大型数据集。Pandas,连同其下层的Num Py,是使Python成为强大而高效的数据分析工具的重要因素之一。

+Pandas中的预置数据结构有下面几种。

+■Series:1D数组,它与Num Py中的一维数组(array)类似。这两者与Python基本的数据结构列表(list)也很相似。

+■Time Series:以时间为索引的Series。

+■Data Frame:2D的表格型数据结构,Series的容器。

+■Panel:3D的数组,Data Frame的容器。

+我们这个课程里面Pandas数据结构用得不多,只用到了2D的数据结构Data Frame,这种数据结构用来存储表格式的数据非常方便,可以直接被机器学习模型所读取。比如,刚才的加州房价机器学习项目,就先把数据文件读入一个Data Frame,然后把Data Frame导入了线性回归模型进行学习。

+2.Num Py

+Num Py是Python进行科学计算的基础库,有人称它为Python的数学扩展包。它提供了一个强大的多维数组对象array,还提供了大量API支持数组运算。

+本课程中将重点使用的数据结构就是Num Py中的数组。

+Num Py所自带的向量化运算功能在机器学习中也属于不可或缺的技能。目前的CPU和GPU都有并行处理的处理器,能够无缝衔接Num Py的向量化运算,大幅度提升机器学习的效率。

+后面我们会专门讲Num Py的数组(在机器学习中称为张量)及其基本运算这部分内容。

+3.Matplotlib

+Matplotlib是Python及其数学扩展包Num Py的可视化操作界面,通过应用程序接口(API)向应用程序提供嵌入式绘图功能。其中还有面向其他图像处理库(如开放图形库Open GL)的接口。

+Matplotlib的设计与MATLAB的绘图功能非常相似(名字都很相似!),然而它是开源的、免费的。这自然令大家觉得物超所值。

+Matplotlib好用又强大。刚才的实战过程中导入Matplotlib的绘图工具后,通过短短几行代码,就把加州房价分布的散点图和机器学习到的模型呈现出来了。

+4.Seaborn

+Seaborn是在Matplotlib基础上设计出的绘图库,因此是更高级的视觉化工具,可以画出特别酷炫的数学统计图形。

+5.Scikit-learn

+Scikit-learn刚才也已经用过了,如下段代码所示。用于预测加州房价的机器学习模型Linear Regression就是直接从那儿“拎”出来的。

+from sklearn.linear_model import Linear Regression #导入线性回归算法模型

+model = Linear Regression() #使用线性回归算法

+它简称Sklearn,是一个相当强大的Python机器学习库,也是简单有效的数据挖掘和数据分析工具。Sklearn基于Num Py、Sci Py和Matplotlib构建,其功能涵盖了从数据预处理到训练模型,再到性能评估的各个方面。

+Scikit-learn真的太好用了,它里面包含的大量可以直接使用的机器学习算法,这节省了很多时间。因为不必重复编写算法,更多的精力可以放在问题定义、数据分析、调整参数、模型性能优化等这些具体项目相关的工作上面。本课程的机器学习模型,大多通过调用Scikit-learn库来实现。

+6.Tensor Flow

+Sklearn是机器学习的工具集,而Tensor Flow则是深度学习的设计利器。据说Google主要产品的开发过程都有Tensor Flow的参与,并且它以某种形式进行机器学习。很惊讶吧。

+但对于新手来说有个小小遗憾:Tensor Flow编程建立在“图”这个抽象的概念之上,据说其难度比起其他的深度学习框架更高,至少要研究几天才能搞清楚入门内容。这太耗时了!我们学机器学习和深度学习,目标是几个小时以内上手。因此,本课程的案例不采用Tensor Flow进行设计。

+小冰焦急地问:“你不是说Tensor Flow是很强大的深度学习工具吗?不用Tensor Flow,那你用什么讲课?”

+咖哥回答:“Keras!”

+7.Keras

+Keras建立在TensorFlow、CNTK或Theano这些后端框架之上。这也就是说,Keras比TensorFlow更高级。在计算机领域,高级是“简单”的代名词。高级意味着易学易用。

+Keras才出来没两年时,就已经大受欢迎,到现在已经是除Tensor Flow外最流行的、排行第二位的深度学习框架。

+搞机器学习的人,就喜欢简单易用的工具。

+其实,写Keras的时候是在对其后端进行调用,相当于还是在Tensor Flow上运行程序,只不过将程序经过Keras中转了一下变成Tensor Flow听得懂的语言,再交给Tensor Flow处理。

+鉴于Keras易用且高效的特点,本课程的深度学习模型,都使用Keras来实现。

+8.Py Torch

+Py Torch是Tensor Flow的竞争对手,也是一个非常“优雅”的机器学习框架。相对Tensor Flow而言,Facebook开发的Py Torch上手相对简单一些,里面所有的算法都是用Python写的,源码也很简洁。近期Py Torch用户量的增长也是相当迅速的。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/5.1.5 \346\234\272\345\231\250\345\255\246\344\271\240\351\241\271\347\233\256\345\256\236\346\210\230\346\236\266\346\236\204/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/5.1.5 \346\234\272\345\231\250\345\255\246\344\271\240\351\241\271\347\233\256\345\256\236\346\210\230\346\236\266\346\236\204/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..8cfc971e61bc1cffdda945f2079d4af64fc9a1a5 --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/5.1.5 \346\234\272\345\231\250\345\255\246\344\271\240\351\241\271\347\233\256\345\256\236\346\210\230\346\236\266\346\236\204/text.html" @@ -0,0 +1,282 @@ + +今天课程的最后,我们来重点讲解如何进行机器学习项目的实战:如何开始、关键的步骤有哪些,以及每个步骤中要注意些什么。

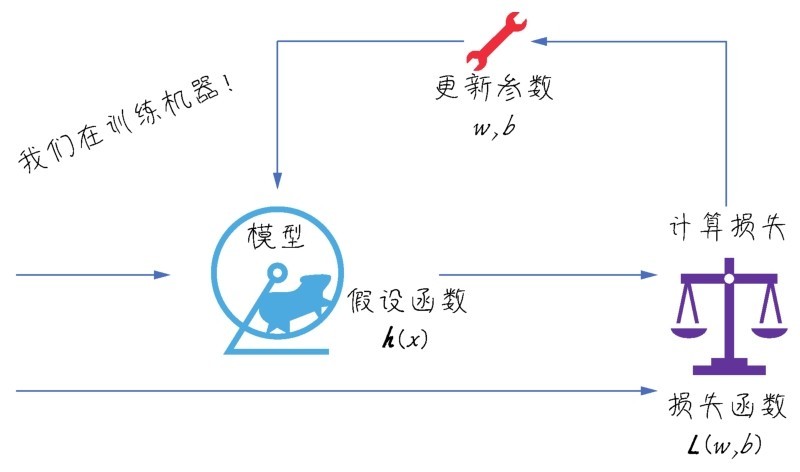

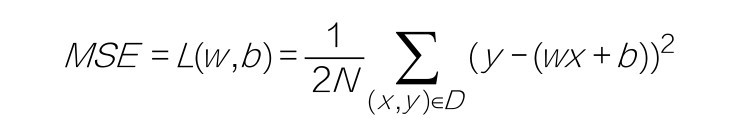

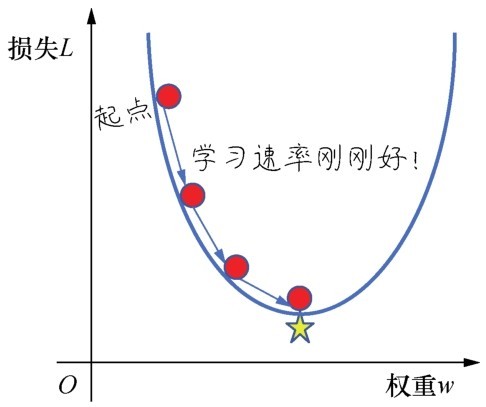

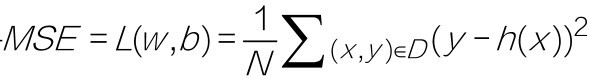

+李宏毅老师曾用将大象装进冰箱来比喻机器学习。大象怎么被装进冰箱?这分为3个步骤:打开冰箱门,将大象放进去,关闭冰箱门。机器学习也就是个“三部曲”:选择函数模型,评估函数的优劣,确定最优的函数,如下图所示。

+ +

+ 机器学习建模三部曲:选择函数模型,评估函数的优劣,确定最优的函数

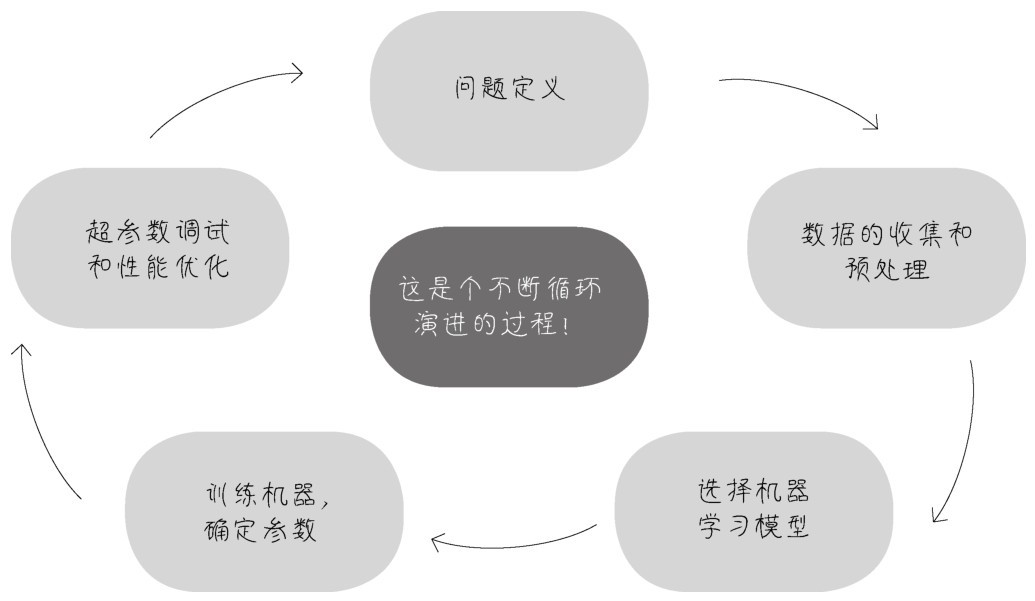

+这个比喻非常精彩,但它主要聚焦于“建模”过程,未强调机器学习项目其他环节。机器学习项目的实际过程要更复杂一些,大致分为以下5个环节。

+(1)问题定义。

+(2)数据的收集和预处理。

+(3)模型(算法)的选择。

+(4)选择机器学习模型。

+(5)超参数调试和性能优化。

+这5个环节,每一步的处理是否得当,都直接影响机器学习项目的成败。而且,如下图所示,这些步骤还需要在项目实战中以迭代的方式反复进行,以实现最优的效果。

+ +

+ 机器学习项目实战的5个环节

+现在就详细说说机器学习项目实战中的每个具体环节都在做些什么。

+机器学习项目是相当直观的。换句话说,机器学习项目都是为了解决实际的问题而存在。

+第一个环节是对问题的构建和概念化。同学们想象一下一个医生接到一个病人后,如果不仔细研究病情,分析问题出在何处,就直接开药、动手术,后果会如何呢?在心理咨询领域,有一个名词叫作 “个案概念化”。它的意思是心理咨询师通过观察分析,先评估界定来访者的问题,以指导后续的咨询进程;否则,可能很多次的咨询、治疗,都是在原地绕圈。

+我们做机器学习项目,道理也很类似。如果每个团队成员都知道项目要解决的是什么问题,那么项目也许已经成功了一半,然而有很多人其实是不知道大方向所在的。

+因此,不是一开始就建立模型,而是首先构建你的问题。反复问一问自己、问一问客户和其他项目干系人,目前的痛点是什么、要解决的问题是什么、目标是什么。对这些关键问题的回答可以说是相当重要的,但是很奇怪的是在现实中最关键的内容反而最有可能被忽略。

+举例来说,看一下下面这个问题的定义。

+■痛点:某商家准备推出一系列促销活动,目的是增加顾客黏性,降低流失率。但是如果促销活动的参与度不高,就不会有好的效果,力气也就白费。因此,只有设计出来的活动是顾客所感兴趣的,才会起到作用。

+■现状:已经收集了过去几年顾客的信息及其行为模式数据,如顾客所购买商品的价格、数量、频率等。

+■目标:根据已有的顾客行为模式数据,推断(学习)出最佳的商品和折扣项目,以确保设计出来的活动有较高的参与度。

+这就是一个定义比较清楚,有可能起到作用的机器学习项目。再看一下下面这个问题的定义。

+■痛点:股票市场的波动性大,难以预测。

+■现状:已经收集了股票市场过去10年的详细信息,例如每一只股票每天的收盘价、月报、季报等。

+■目标:通过学习历史数据,预测股市。

+这个“预测股市”,看起来也许是机器学习问题,实际上可能是一个伪机器学习问题。因为对目标的定义太不具体了。预测股市的什么内容?是某只股票的第二天的价格,还是未来一个月整体的走势?而且机器学习是否能在股市预测中发挥作用?似乎不大可能。我们可以运用这样一个简单的方法去评判机器学习是否会生效:如果机器学习无法预测历史,它就无法预测未来。这是因为机器学习只能识别出它曾经见过的东西。要想在过去的数据的基础上预测未来,其实存在一个假设,就是未来的规律与过去相同。但对于股价而言,事实往往并非如此[6]。也就是说,即使用1998—2007年的全部数据去训练机器,机器也不能预测出2008年的金融危机,因此它也不大可能成功预测未来。

+小冰点头称是。

+咖哥接着说:“下面我们一边讲,一边同步进行另一个机器学习项目的实战。”

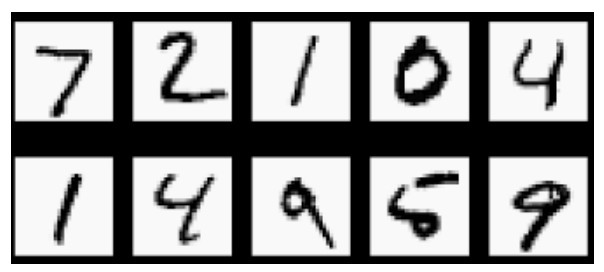

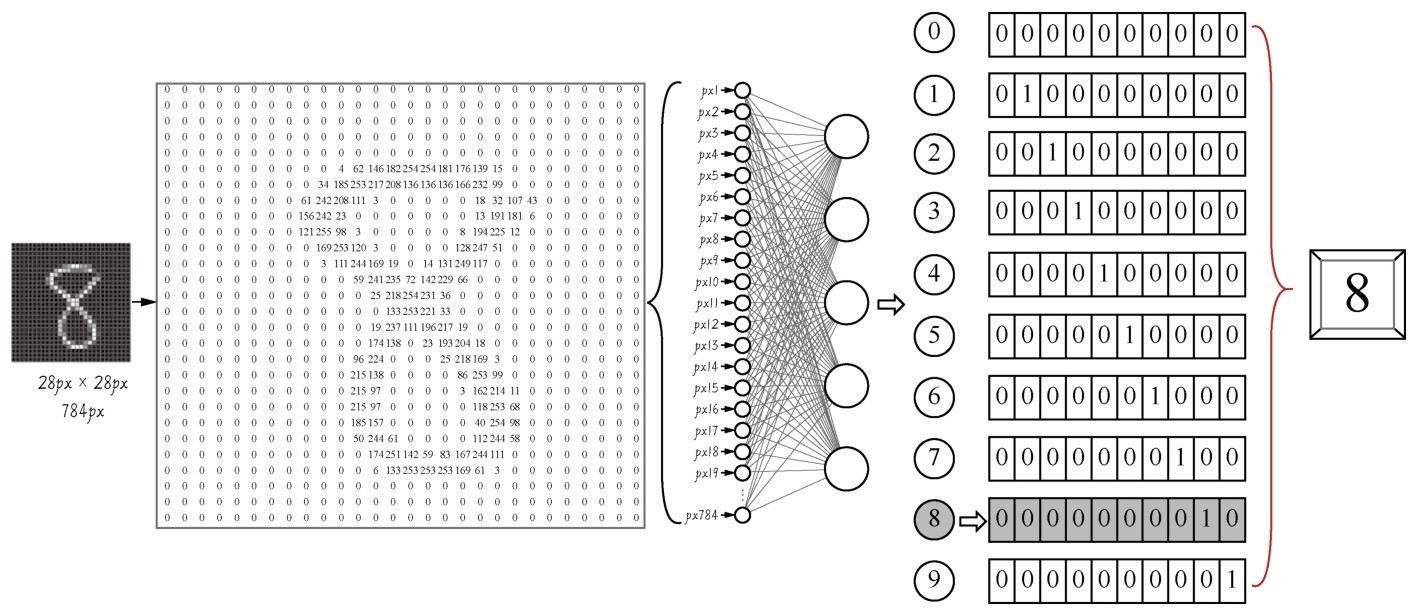

+这里要向大家介绍MNIST数据集。这个数据集相当于是机器学习领域的Hello World,非常的经典,里面包含60 000张训练图像和10 000张测试图像,都是28px×28px的手写数字灰度图像,如下图所示。”

+ +

+ MNIST数据集中的手写数字灰度图像

+此处要解决的问题是:将手写数字灰度图像分类为0,1,2,3,4,5,6,7,8,9,共10个类别。

+ 咖哥发言

咖哥发言

灰度图像与黑白图像不同哦,黑白图像只有黑、白两种颜色,对应的像素的值是0和1;而灰度图像在黑色与白色之间还有许多灰度级别,取值为0~255。

+数据是机器学习的燃料。机器学习项目的成败,数据很可能是关键。

+下面主要介绍以下内容。

+■原始数据的准备。

+■数据的预处理。

+■特征工程和特征提取。

+■载入MNIST数据集。

+1.原始数据的准备

+原始数据如何获得呢?有时候是自有的数据(如互联网公司拥有的大量的客户资料、购物行为历史信息),或者需要上网爬取数据;有时候是去各种开源数据网站下载(Image Net、Kaggle、Google Public Data Explorer,甚至Youtube和维基百科,都是机器学习的重要数据源),或者可以购买别人的数据。

+2.数据的预处理

+从本机或者网络中载入原始数据之后,预处理工作包括以下几个部分。

+■可视化(visualization):要用Excel表和各种数据分析工具(如前面说的Matplotlib或者Seaborn)从各种角度(如列表、直方图、散点图等)看一看数据。对数据有了基本的了解,才方便进一步分析判断。

+■数据向量化(data vectorization):把原始数据格式化,使其变得机器可以读取。例如,将原始图片转换为机器可以读取的数字矩阵,将文字转换为one-hot编码,将文本类别(如男、女)转换成0、1这样的数值。

+■处理坏数据和缺失值:一笔数据可不是全部都能用,要利用数据处理工具来把“捣乱”的“坏数据”(冗余数据、离群数据、错误数据)处理掉,把缺失值补充上。

+■特征缩放(feature scaling):特征缩放方法有很多,包括数据标准化(standardization)和规范化(normalization)等。

+□标准化,是对数据特征分布的转换,目标是使其符合正态分布(均值为0,标准差为1)。因为如果数据特征不符合正态分布的话,就会影响机器学习效率。在实践中,会去除特征的均值来转换数据,使其居中,然后除以特征的标准差来对其进行缩放。

+□标准化的一种变体是将特征压缩到给定的最小值和最大值之间,通常为0~1。因此这种特征缩放方法也叫归一化。归一化不会改变数据的分布状态。

+□规范化,则是将样本缩放为具有单位范数的过程,然后放入机器学习模型,这个过程消除了数据中的离群值。

+□在Sklearn的preprocessing工具中可以找到很多特征缩放的方法。在实战中,要根据数据集和项目特点选择适宜的特征缩放方法。

+数据预处理的原则如下。

+■全部数据应转换成数字格式(即向量、矩阵、3D、4D、5D)的数组(张量)。

+■大范围数据值要压缩成较小值,分布不均的数据特征要进行标准化。

+■异质数据要同质化(homogenous),即同一个特征的数据类型要尽量相同。

+3.特征工程和特征提取

+特征工程和特征提取仍然是在机器对数据集学习之前进行的操作,广义上也算数据预处理。

+■特征工程是使用数据的领域知识来创建使机器学习算法起作用的特征的过程。特征工程是机器学习的重要环节,然而这个环节实施困难又开销昂贵,相当费时费力。

+■特征提取(feature extraction)则是通过子特征的选择来减少冗余特征,使初始测量数据更简洁,同时保留最有用的信息。

+为什么要对数据的特征进行处理?因为机器学习之所以能够学到好的算法,关键看特征的质量。那就需要思考下面的问题。

+(1)如何选择最有用的特征给机器进行学习?(进行特征提取。)

+(2)如何把现有的特征进行转换、强化、组合,创建出来新的、更好的特征?(进行特征 工程。)

+比如,对于图像数据,可以通过计算直方图来统计图像中像素强度的分布,得到描述图像颜色的特征。又比如,通过调整原始输入数据的坐标轴的方向(坐标变换),就有可能使问题得到更好的描述。总而言之,就是通过各种手段让数据更好地为机器所用。

+在深度学习时代,对于一部分机器学习问题,自动化的特征学习可以减少对手动特征工程的需求。但特征工程在另一些机器学习问题中,仍然是不可或缺的环节。

+4.载入MNIST数据集

+下面用1.2.4节中介绍过的方法新建一个Kaggle Notebook,并在其中直接载入Keras自带的MNIST数据集,如下段代码所示(注意,需要打开屏幕右侧Settings的Internet选项才能载入该数据集,如下图所示)。

+import numpy as np # 导入Num Py库

+import pandas as pd # 导入Pandas库

+from keras.datasets import mnist #从Keras中导入MNIST数据集

+#读入训练集和测试集

+(X_train_image, y_train_lable), (X_test_image, y_test_lable) = mnist.load_data()

+ +

+ Kaggle Notebook的Internet选项

+单击Kaggle Notebook中的 图标运行上面的代码后,这个数据集里面的数据就被读入以下Num Py张量。

图标运行上面的代码后,这个数据集里面的数据就被读入以下Num Py张量。

■X_train_image:训练集特征—图片。

+■y_train_lable:训练集标签—数字。

+■X_test_image:测试集特征—图片。

+■y_test_lable:测试集标签—数字。

+数据向量化的工作MNIST数据集已经为我们做好了,可以直接显示这些张量里面的内容:

+print ("数据集张量形状:", X_train_image.shape) #用shape方法显示张量的形状

+print ("第一个数据样本:\n", X_train_image[0]) #注意Python的索引是从0开始的

+代码运行后的输出结果如下:

+数据集张量形状:(60000,28,28)

+第一个数据样本:

+[[ 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0

+0 0 0 0 0 0 0 0 0 0

+… …

+… …

+[ 0 0 0 0 0 0 0 0 30 36 94 154 170 253 253 253 253 253

+225 172 253 242 195 64 0 0 0 0]

+[ 0 0 0 0 0 0 0 49 238 253 253 253 253 253 253 253 253 251

+93 82 82 56 39 0 0 0 0 0]

+… …

+… …

+[ 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0

+0 0 0 0 0 0 0 0 0 0]]

+shape方法显示的是X_train_image张量的形状。灰度图像数据集是3D张量,第一个维度是样本维(也就是一张一张的图片,共60 000张),后面两个是特征维(也就是图片的28px×28px的矩阵)。因为28px×28px的矩阵太大,这里省略了部分输入内容,你们可以发现灰度信息主要集中在矩阵的中部,边缘部分都是0填充,是图片的背景。数字矩阵的内容差不多如下图所示。

+再看一下标签的格式:

+print ("第一个数据样本的标签:", y_train_lable[0])

+ +

+ 数字矩阵存储图片信息的方式—这个矩阵就是机器需要学习的内容

+输出显示数字8—上面这么大的一个数字矩阵,到头来只变成一个简单的信息8:

+第一个数据样本的标签:8

+上面的数据集在输入机器学习模型之前还要做一些数据格式转换的工作:

+from keras.utils import to_categorical # 导入keras.utils工具库的类别转换工具

+X_train = X_train_image.reshape(60000, 28, 28, 1) # 给标签增加一个维度

+X_test = X_test_image.reshape(10000, 28, 28, 1) # 给标签增加一个维度

+y_train = to_categorical(y_train_lable, 10) # 特征转换为one-hot编码

+y_test = to_categorical(y_test_lable, 10) # 特征转换为one-hot编码

+print ("训练集张量形状:", X_train.shape) # 训练集张量的形状

+print ("第一个数据标签:", y_train[0]) # 显示标签集的第一个数据

+输出新的数据格式:

+训练集张量形状:(60000, 28, 28, 1)

+第一个数据标签:[0.0.0.0.0.0.0.0.1.0.]

+解释一下为何需要新的格式。

+(1)Keras要求图像数据集导入卷积网络模型时为4阶张量,最后一阶代表颜色深度,灰度图像只有一个颜色通道,可以设置其值为1。

+(2)在机器学习的分类问题中,标签[0.0.0.0.0.0.0.0.1.0.]就代表着类别值8。这是等会儿还要提到的one-hot编码。

+第3个环节先是选择机器学习模型的算法类型,然后才开始训练机器确定参数。

+各种Python机器学习框架中有很多类型的算法,主要包括以下几种。

+■线性模型(线性回归、逻辑回归)。

+■非线性模型(支持向量机、k最邻近分类)。

+■基于树和集成的模型(决策树、随机森林、梯度提升树等)。

+■神经网络(人工神经网络、卷积神经网络、长短期记忆网络等)。

+那么究竟用哪个呢?

+答案是—这与要解决的问题有关。没有最好的算法,也没有最差的算法。随机森林也许处理回归类型问题很给力,而神经网络则适合处理特征量巨大的数据,有些算法还能够通过集成学习的方法组织在一起使用。只有通过实践和经验的积累,深入地了解各个算法,才能慢慢地形成“机器学习直觉”。遇见的多了,一看到问题,就知道大概何种算法比较适合。

+那么我们为MNIST数据集手写数字识别的问题选择什么算法作为机器学习模型呢?这里挑一个图片处理最强的工具,就是大名鼎鼎的卷积神经网络。

+咖哥此处忽然笑了两声。小冰说:“你笑什么呢?”咖哥说:“卷积神经网络处理这个MNIST小问题,我都觉得‘杀鸡用牛刀’了。下面看看代码吧。”

+from keras import models # 导入Keras模型, 以及各种神经网络的层

+from keras.layers import Dense, Dropout, Flatten, Conv2D, Max Pooling2D

+model = models.Sequential() # 用序贯方式建立模型

+model.add(Conv2D(32, (3, 3), activation='relu', # 添加Conv2D层

+input_shape=(28, 28, 1))) # 指定输入数据样本张量的类型

+model.add(Max Pooling2D(pool_size=(2, 2))) # 添加Max Pooling2D层

+model.add(Conv2D(64, (3, 3), activation='relu')) # 添加Conv2D层

+model.add(Max Pooling2D(pool_size=(2, 2))) # 添加Max Pooling2D层

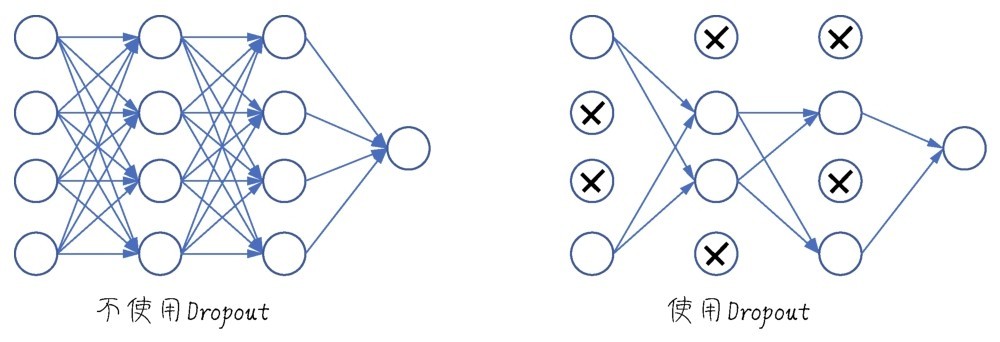

+model.add(Dropout(0.25)) # 添加Dropout层

+model.add(Flatten()) # 展平

+model.add(Dense(128, activation='relu')) # 添加全连接层

+model.add(Dropout(0.5)) # 添加Dropout层

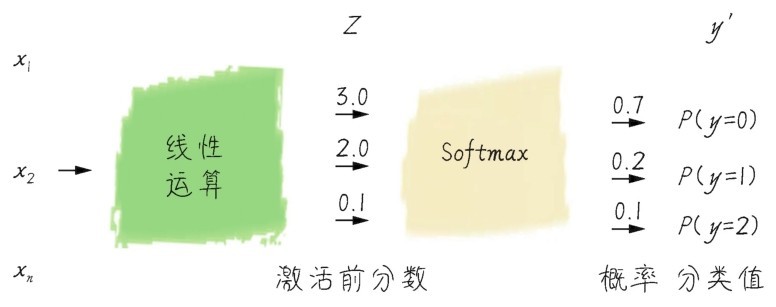

+model.add(Dense(10, activation='softmax')) # Softmax分类激活, 输出10维分类码

+# 编译模型

+model.compile(optimizer='rmsprop', # 指定优化器

+loss='categorical_crossentropy', # 指定损失函数

+metrics=['accuracy']) # 指定验证过程中的评估指标

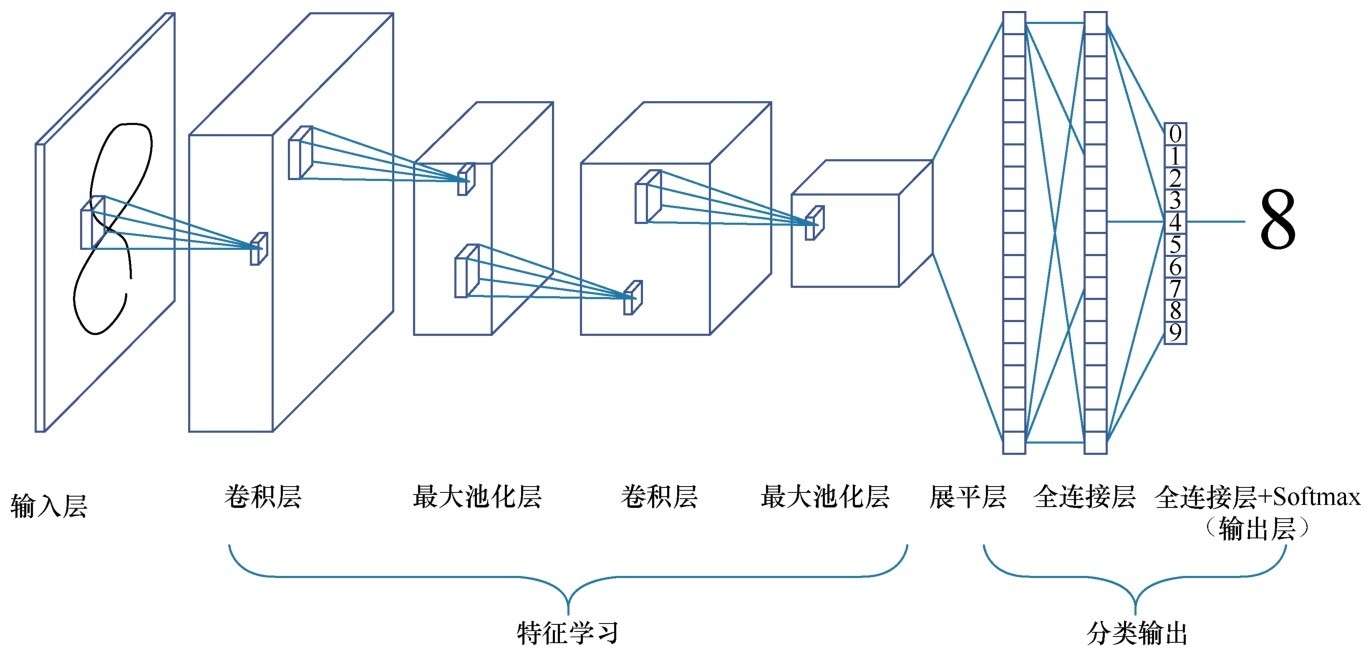

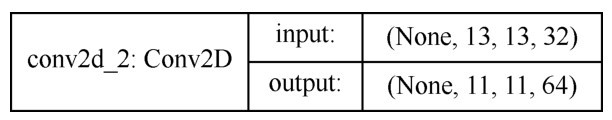

+这里先简单地解释一下代码中都做了些什么(当然更多的细节要以后再说)。这段代码把数据集放入卷积神经网络进行处理。这个网络中包括两个Conv2D(二维卷积)层,两个MaxPooling2D(最大池化)层,两个Dropout层用于防止过拟合,还有Dense(全连接)层,最后通过Softmax分类器输出预测标签y'值,也就是所预测的分类值。这个y'值,是一个one-hot(即“一位有效编码”)格式的10维向量。我们可以将y'与标签真值y进行比较,以计算预测的准确率。整个过程如下图所示。

+ 咖哥发言

咖哥发言

我当然知道上面这段话里面出现了很多生词,比如Softmax、卷积、最大池化、过拟合、one-hot、10维向量等,我们后面将一点一点把这些词语全部搞明白。现在的目的主要是解释项目实战的流程,所以大家先不要害怕新概念,耐心一点跟着我往下走。

+ +

+ 卷积神经网络实现手写数字识别

+确定机器学习模型的算法类型之后,就进行机器的学习,训练机器以确定最佳的模型内部参数,并使用模型对新数据集进行预测。之所以说在这一环节中确定的是模型内部参数,是因为机器学习中还有超参数的概念。

+■内部参数:机器学习模型的具体参数值,例如线性函数y=2x+1,其中的2和1就是模型内参数。在机器学习里面这叫作权重(weight)和偏置(bias)。神经网络也类似,每一个节点都有自己的权重(或称kernel),网络的每一层也有偏置。模型内参数在机器的训练过程中被确定,机器学习的过程就是把这些参数的最佳值找出来。

+■超参数(hyperparameter):位于机器学习模型的外部,属于训练和调试过程中的参数。机器学习应该迭代(被训练)多少次?迭代时模型参数改变的速率(即学习率)是多大?正则化参数如何选择?这些都是超参数的例子,它们需要在反复调试的过程中被最终确定。这是机器学习第5个环节中所着重要做的工作。

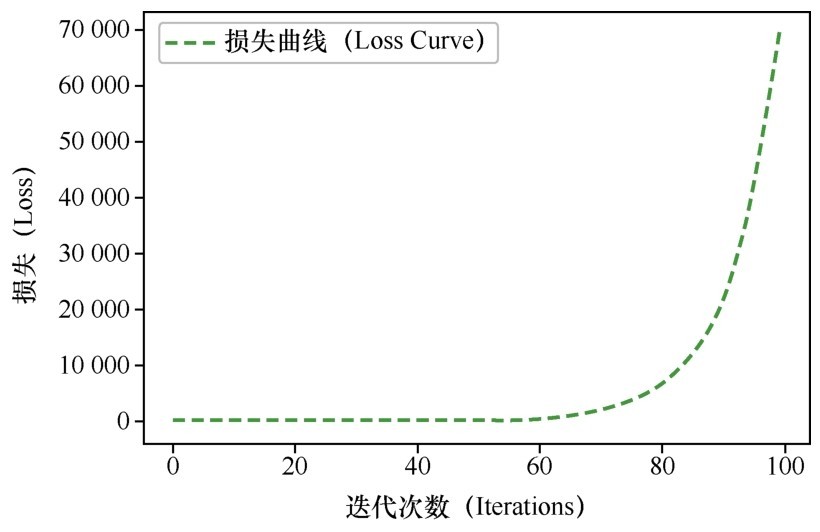

+下面用fit(拟合)方法,开始对机器进行5轮的训练:

+model.fit(X_train, y_train, # 指定训练特征集和训练标签集

+validation_split = 0.3, # 部分训练集数据拆分成验证集

+epochs=5, # 训练轮次为5轮

+batch_size=128) # 以128为批量进行训练

+在上面的训练过程中,fit方法还自动地把训练集预留出30%的数据作为验证集(马上就会讲到什么是验证集),来验证模型准确率。

+输出结果如下:

+Train on 42000 samples, validate on 18000 samples

+Epoch 1/5

+42000/42000 [==============================] - 62s 1ms/step - loss: 0.9428 -

+accuracy: 0.8827 - val_loss: 0.1172 - val_accuracy: 0.9677

+Epoch 2/5

+42000/42000 [==============================] - 61s 1ms/step - loss: 0.1422 -

+accuracy: 0.9605 - val_loss: 0.0917 - val_accuracy: 0.9726

+Epoch 3/5

+42000/42000 ============================== - 62s 1ms/step - loss: 0.1065 -

+accuracy: 0.9700 - val_loss: 0.0735 - val_accuracy: 0.9807

+Epoch 4/5

+42000/42000 [==============================] - 61s 1ms/step - loss: 0.0885 -

+accuracy: 0.9756 - val_loss: 0.0602 - val_accuracy: 0.9840

+Epoch 5/5

+42000/42000 [==============================] - 61s 1ms/step - loss: 0.0813 -

+accuracy: 0.9779 - val_loss: 0.0692 - val_accuracy: 0.9842

+以上显示的5轮训练中,准确率逐步提高。

+■accuracy:代表训练集上的预测准确率,最后一轮达到0.977 9。

+■val_accuracy:代表验证集上的预测准确率,最后一轮达到0.984 2。

+小冰发问:“刚才预测加州房价也是用的fit方法,怎么没看见程序输出这个一轮一轮的训练过程信息呢?”咖哥说:“我们现在训练的是神经网络,训练一次称为一轮。刚才用的是Sklearn里面的Linear Regression模型,训练的过程也是经过了多次迭代,只是该过程已经完全封装在方法内部了,并没有显示出来。”

+小冰又问:“那么训练5轮之后,咱们这个卷积神经网络模型的模型内参数都是什么呢?怎么看呢?”咖哥说:“那是看不到的,因为卷积神经网络中的参数太多了,以万为计。但是我们可以把训练好的模型保存下来,以供将来调用。”

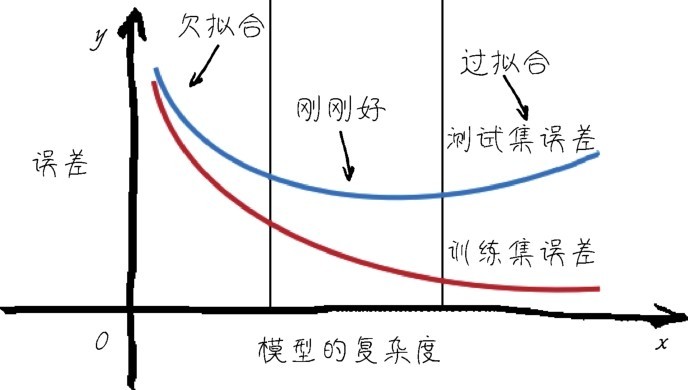

+机器学习重在评估,只有通过评估,才能知道当前模型的效率,才能在不同模型或同一模型的不同超参数之间进行比较。举例来说,刚才的训练轮次—5轮,是一个超参数。我们想知道对于当前的卷积神经网络模型来说,训练多少轮对于MNIST数据集最为合适。这就是一个调试超参数的例子,而这个过程中需要各种评估指标作为调试过程的“风向标”。正确的评估指标相当重要,因为如果标准都不对,最终模型的效果会南辕北辙,性能优化更是无从谈起。

+下面介绍两个重要的评估点。

+■在机器训练过程中,对于模型内部参数的评估是通过损失函数进行的。以后还要详细介绍各种损失函数,例如回归问题的均方误差函数、分类问题的交叉熵(就是本例中的categorical_crossentropy)函数,都是内部参数的评估方法。这些损失函数指出了当前模型针对训练集的预测误差。这个过程在第4个环节中,调用fit方法后就已经完成了。

+■在机器训练结束后,还要进行验证,验证过程采用的评估方式包括前面出现过的R2分数以及均方误差函数、平均绝对误差函数、交叉熵函数等各种标准。目前的这个卷积神经网络模型中的参数设定项metrics=['accuracy'],指明了以accuracy,即分类的准确率作为验证指标。验证过程中的评估,既评估了模型的内部参数,也评估了模型的超参数。

+1.训练集、验证集和测试集

+为了进行模型的评估,一般会把数据划分成3个集合:训练数据集、验证数据集和测试数据集,简称训练集(trainsing set)、验证集(validation set)和测试集(test set)。在训练集上训练模型,在验证集上评估模型。感觉已经找到最佳的模型内部参数和超参数之后,就在测试集上进行最终测试,以确定模型。

+小冰问:“一个训练集和一个测试集还不够吗?”

+咖哥答道:“也许简单的机器学习项目,2个集合也就够了。但是大型机器学习项目,至少需要3个集合”。

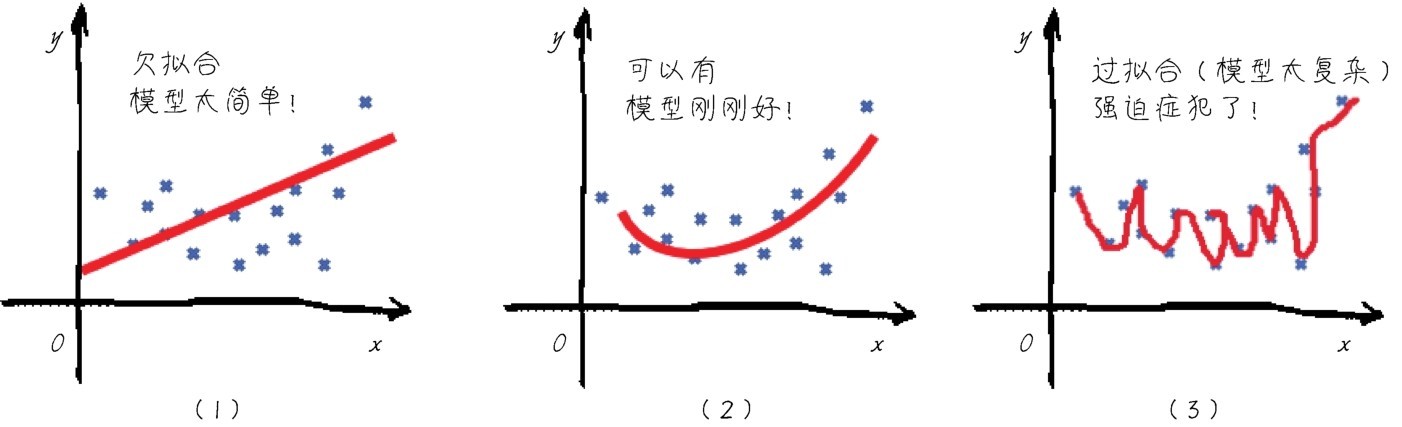

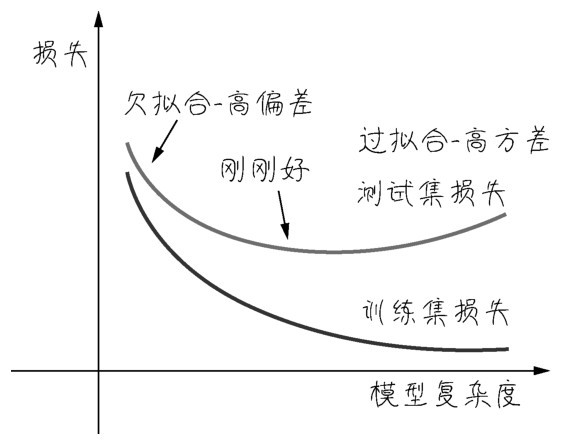

+机器学习模型训练时,会自动调节模型内部参数。这个过程中经常出现过拟合(overfit)的现象。过拟合现在是个新名词,不过后面我们几乎随时都要和过拟合现象作战。目前来说,大家可以把过拟合理解为模型对当前数据集的针对性过强了,虽然对训练集拟合效果很好,但是换一批新数据就不灵了。这叫作模型的泛化能力弱。

+解决了在训练集上的过拟合问题之后,在继续优化模型的过程中,又需要反复地调整模型外部的超参数,这个过程是在训练集和验证集中共同完成的。这个调试、验证过程会导致模型在验证集上也可能过拟合,因为调试超参数本身也是一种训练。这个现象叫作信息泄露(information leak)。也就是说,即使我们选择了对验证集效果最好的超参数,这个好结果也不一定真的能泛化到最终的测试集。

+即使得到的模型在验证集上的性能已经非常好,我们关心的还是模型在全新数据上的性能。因此,我们需要使用一个完全不同的、前所未见的数据集来对模型进行最终的评估和校正,它就是测试集。在最终验证之前,我们的模型一定不能读取任何与测试集有关的任何信息,一次也不行。

+下面就在MNIST测试集上进行模型效率的验证,如下段代码所示。这个测试集的任何数据信息都没有在模型训练的过程中暴露过。

+score = model.evaluate(X_test, y_test) # 在验证集上进行模型评估

+print('测试集预测准确率:', score[1]) # 输出测试集上的预测准确率

+结果显示测试准确率达到0.983 8,成绩相当不错:

+测试集预测准确率: 0.9838

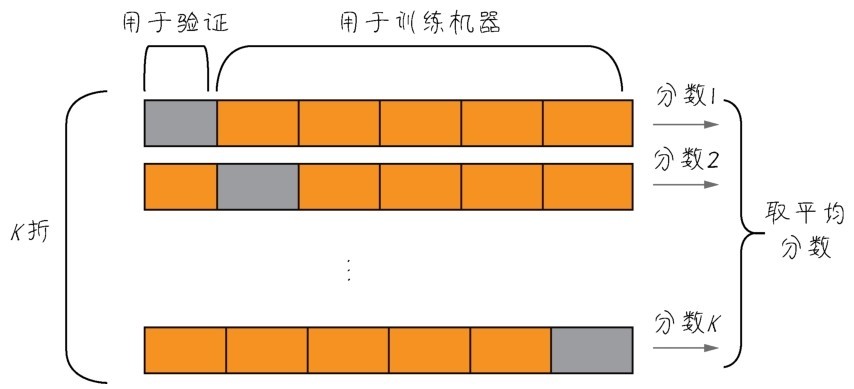

+2.K折验证

+上面的测试集测试结果相当不错,但问题是,如果最终验证结果仍不尽如人意的话,那么继续调试和优化就会导致这个最终的测试集又变成了一个新的验证集。因此需要大量新数据的供给,以创造出新的测试数据集。

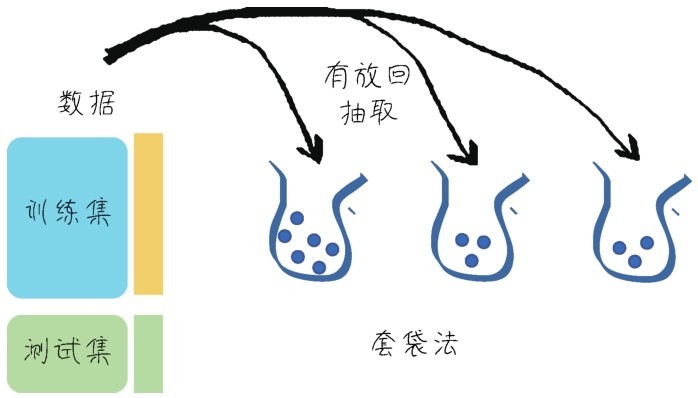

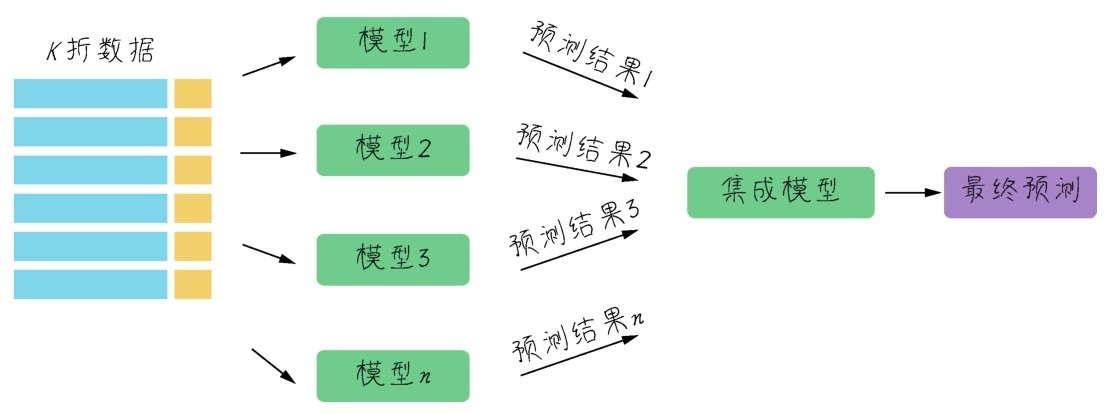

+数据,很多时候都是十分珍贵的。因此,如果有足够的数据可用,一般来说按照60%、20%、20%的比例划分为训练集、验证集和测试集。但是如果数据本身已经不大够用,还要拆分出3个甚至更多个集合,就更令人头疼。而且样本数量过少,学习出来的规律会失去代表性。因此,机器学习中有重用同一个数据集进行多次验证的方法,即K折验证,如下图所示。

+ +

+ K折验证将数据划分为大小相同的K个分区

+K折验证(K-fold validation)的思路是将数据划分为大小相同的K个分区,对于每个分区,都在剩余的K-1个分区上训练模型,然后在留下的分区上评估模型。最终分数等于K个分数的平均值。对于数据集的规模比较小或者模型性能很不稳定的情况,这是一种很有用的方法。注意K折验证仍需要预留独立的测试集再次进行模型的校正[7]。

+3.模型的优化和泛化

+优化(optimization)和泛化(generalization),这是机器学习的两个目标。它们之间的关系很微妙,是一种此消彼长的状态。

+■如何成功地拟合已有的数据,这是性能的优化。

+■但是更为重要的是如何把当前的模型泛化到其他数据集。

+模型能否泛化,也许比模型在当前数据集上的性能优化更重要。经过训练之后100张猫图片都能被认出来了,但是也没什么了不起,因为这也许是通过死记硬背实现的,再给几张新的猫图片,就不认识了。这就有可能是出现了“过拟合”的问题—机器学习到的模型太过于关注训练数据本身。

+关于优化、泛化和过拟合,这里就先蜻蜓点水式地简单说说它们的概念。在后面的课程中还会很详细地讲如何避免过拟合的问题。而对于目前的MNIST数据集,卷积神经网络模型是没有出现过拟合的问题的,因为在训练集、验证集和测试集中,评估后的结果都差不多,预测准确率均为98%以上,所以模型泛化功能良好。

+这时小冰又开口了:“我憋了半天,一直想问一个问题呢。这里预测准确率是给出来了,但是具体的预测结果在什么地方呢?你说的百分之九十八点多少,我也没看见啊?怎么证明呢?”

+小冰一说,其他同学频频点头。

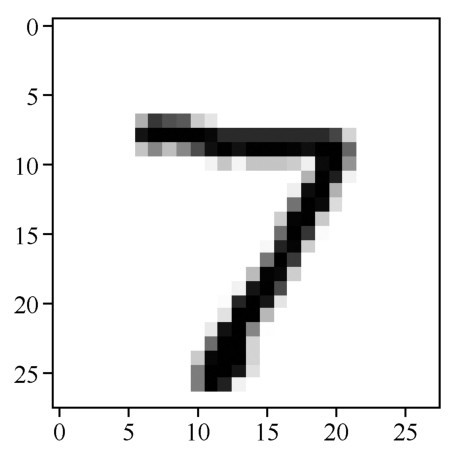

+4.怎么看预测结果

+其实在测试集上进行评估之后,机器学习项目就大功告成了。想知道具体的预测结果,可以使用predict方法得到模型的预测值。下面看看代码吧。

+pred = model.predict(X_test[0].reshape(1, 28, 28, 1)) # 预测测试集第一个数据

+print(pred[0], "转换一下格式得到:", pred.argmax()) # 把one-hot编码转换为数字

+import matplotlib.pyplot as plt # 导入绘图工具包

+plt.imshow(X_test[0].reshape(28, 28), cmap='Greys') # 输出这个图片

+前两行代码,是对测试集第一个数据(Python索引是从0开始的)进行预测,并输出预测结果。argmax方法就是输出数组里面最大元素的索引,也就是把one-hot编码转换为实际数值。

+输出结果如下:

+[[0.0.0.0.0.0.0.1.0.0.]]转换一下格式得到:7

+后面的plt.imshow函数则输出原始图片,如下图所示。

+ +

+ 原始图片:手写数字7

+果然是正确答案7,与预测结果的one-hot编码相匹配,证明预测对了!

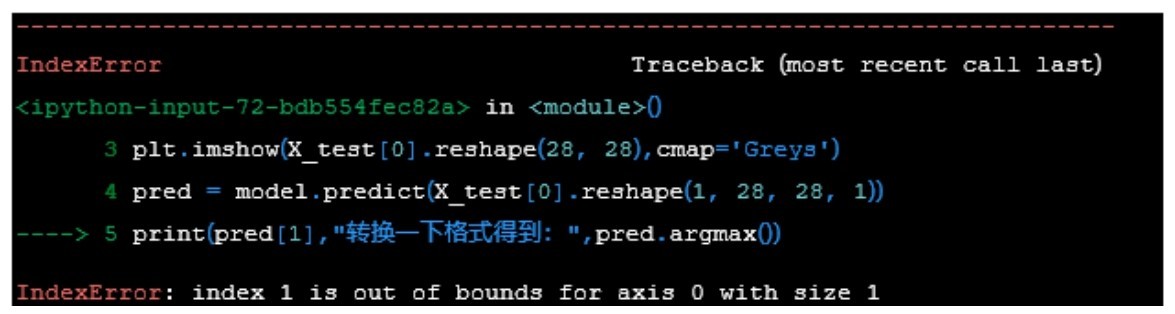

+5.调试过程出错怎么办

+前面的实战过程都比较顺利,那是因为代码都是现成的。然而,在同学们自己进行Python程序调试、运行的时候,难免遇到系统报错。这些信息有时只是Warning(警告),说明一些参数或设置可能要过时了,但是目前还能用。这些警告信息暂时可以忽略,也可以跟着Python的提示进行修正。

+然而,如果出现类似于下图所示的Error信息,说明程序代码出错了。这时不要着急, Python会用箭头指出出错的语句,接着给出出错的具体原因。跟着这些信息,需要进行相应的代码修改。

+ +

+ Error信息

+很难预测到具体实战时会出现什么样的错误。此时,不要恐慌,冷静分析是第一步。如果多次尝试也无法解决问题,去Google搜索一下报错的内容,可能就会得到答案,或者,鼓起勇气请教身边的Python“专家”吧。

+在本节的最后,再强调一下,在机器学习实战开始之前,以及过程当中,应反复问问自己以下几个问题。

+■要解决的问题是什么,即机器学习项目的最终目标是什么?

+■我们目前拥有或者要搜集的数据集是哪种类型?数值型、类别型还是图像?

+■有现成的数据吗?数据集搜集整理过程中可能会遇到哪些困难?

+■以目前的知识来看,哪些算法可能是比较好的选择?

+■如何评判算法的优劣,即如何定义和衡量机器学习的“准确率”?

+那么如果机器学习模型的调试过程中出现了问题,原因会出在哪里呢?可能出在任何一个环节:问题定义得不好,数据集质量不好,模型选得不好,机器训练得不好,评估调试得不好,都有可能使机器学习项目停止,无法进一步优化。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/6.1.6 \346\234\254\350\257\276\345\206\205\345\256\271\345\260\217\347\273\223/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/6.1.6 \346\234\254\350\257\276\345\206\205\345\256\271\345\260\217\347\273\223/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..77f74cc6ffa7fe579108e373ee41cace609098c0 --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/6.1.6 \346\234\254\350\257\276\345\206\205\345\256\271\345\260\217\347\273\223/text.html" @@ -0,0 +1,16 @@ + +同学们,祝贺大家终于学完了这最为基础的一课。万事开头难,本课中理论的东西有点多,目前大家理解起来应该是挺辛苦的。因为基于长期实践总结出来的东西,对于没有上过手的人来说,难免学起来是一头雾水。这是正常的现象。也许上完全部课程后,回过头来复习,你们会有更多的感悟。

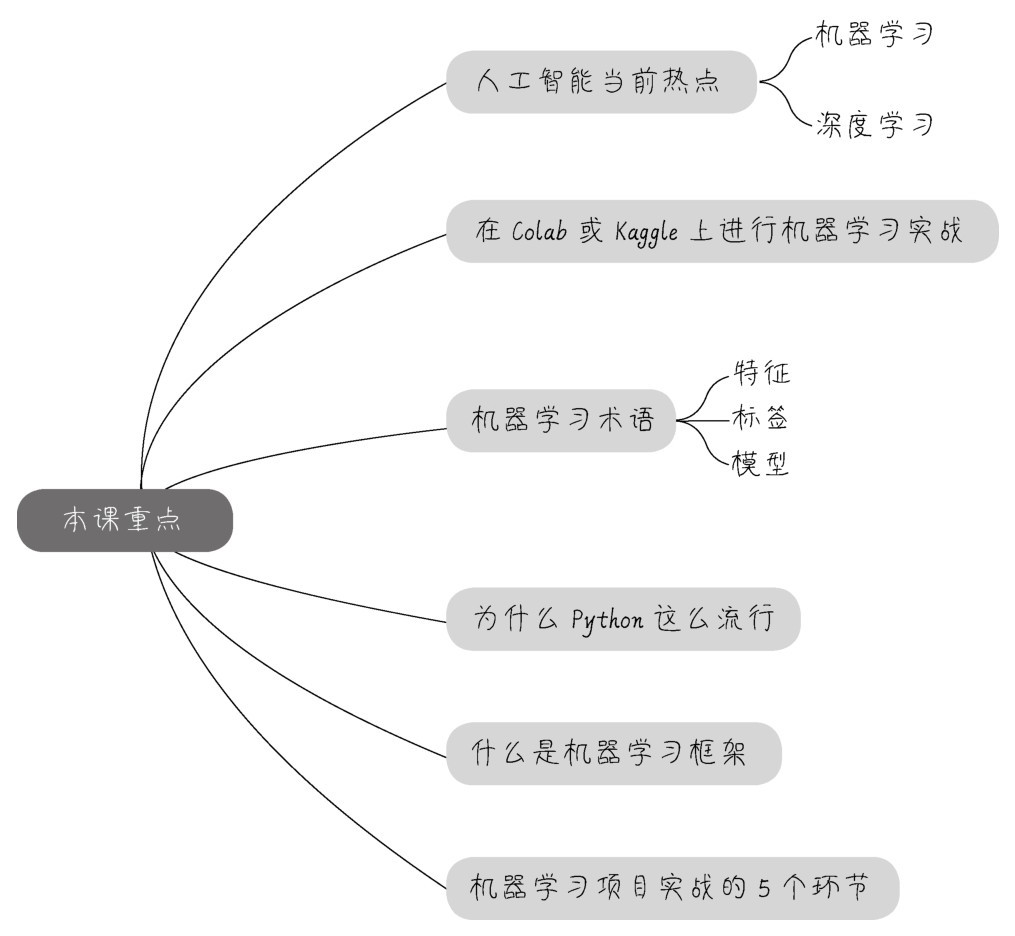

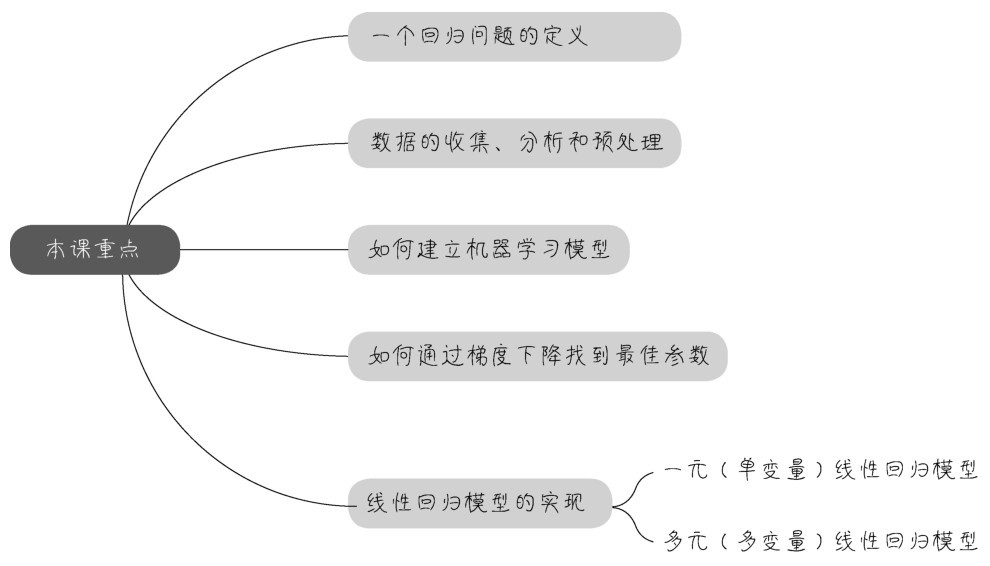

+下面是本课中的重点内容。

+(1)首先是机器学习的内涵:机器学习的关键内涵在于从大量的数据中发现一个“模型”,并通过它来模拟现实世界事物间的关系,从而实现预测或判断的功能。

+■从这个定义出发,机器学习可以分为监督学习、无监督学习、半监督学习,以及深度学习、强化学习等类型。这些学习类型之间的界限是比较模糊的,彼此之间有交集,也可以相互组合。比如,深度学习和强化学习技术同时运用,可以形成深度强化学习模型。

+■我们也给出了最基本的机器学习术语,如特征、标签和模型等。

+(2)通过在线的Jupyter Notebook,可以方便快捷地进行机器学习实战。Colab和Kaggle,是两个提供免费Jupyter Notebook的平台,可以在其中通过Python编写机器学习源代码。

+机器学习是一个有很强共享精神的领域,不仅免费在线开发工具多,无论是数据集、算法,还是库函数和框架方面,都有很多开源的项目可供选择。

+■Scikit-learn是重点介绍的机器学习算法库。

+■Keras是重点介绍的深度学习算法库。

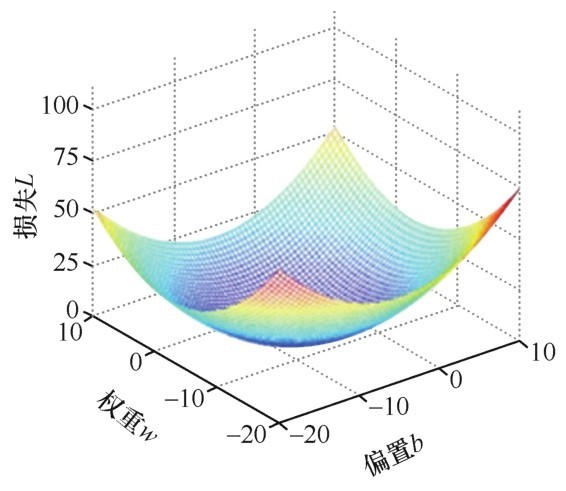

+(3)最后给出了机器学习项目实战流程中的5个环节,指导我们进行实战,具体包括问题定义、数据的收集和预处理、选择机器学习模型、训练机器,确定参数、超参数调试和性能优化,如下图所示。

+ +

+ 不断优化,找到最佳模型

+总而言之,机器学习实战的各个环节就像机器学习模型训练一样,是一个反复迭代的过程。只有不断优化,才能找到最完善的模型、达到最佳状态,这也是符合敏捷(agile)和Dev Ops那种快捷的、迭代式IT产品开发原则的。其秘密就是:迅速拿出一个可用产品的雏形,然后持续完善它。嗯,跑题了,下课吧。不过,别忘记完成课后的练习哦。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/7.1.7\342\200\202\350\257\276\345\220\216\347\273\203\344\271\240/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/7.1.7\342\200\202\350\257\276\345\220\216\347\273\203\344\271\240/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..fdebef7f9222c031a0a62b7bc05d4cb797c65c6c --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/7.1.7\342\200\202\350\257\276\345\220\216\347\273\203\344\271\240/text.html" @@ -0,0 +1,16 @@ + +练习一 请同学们列举出机器学习的类型,并说明分类的标准。

+练习二 解释机器学习术语:什么是特征,什么是标签,什么是机器学习模型。

+练习三 我们已经见过了Google中的加州房价数据集和Keras自带的MNIST数据集,请同学们自己导入Keras的波士顿房价(boston_housing)数据集,并判断其中哪些是特征字段,哪些是标签字段。

+(提示:使用语句from keras.datasets import boston_housing导入波士顿房价数据集。)

+练习四 参考本课中的两个机器学习项目代码,使用Linear Regression线性回归算法对波士顿房价数据集进行建模。

+[1].肖莱.Python深度学习[M].张亮,译.北京:人民邮电出版社,2018.

+[2].从本节开始,所有正文文字除小冰和同学们的提问之外,都是咖哥课程讲述内容,为保证真实课堂体验,将以咖哥为第一人称叙述。其中的“我”均指代咖哥。

+[3].Magnus Lie Hetland.Python基础教程(第3版)[M].袁国忠,译.北京:人民邮电出版社,2018.

+[4].HARRINGTON P.机器学习实战[M].李锐,李鹏,曲亚东等译.北京:人民邮电出版社:2013.

+[5].FLACH P.机器学习[M].段菲,译.北京:人民邮电出版社:2016.

+[6].肖莱.Python深度学习[M].张亮,译.北京:人民邮电出版社,2018.

+[7].肖莱.Python深度学习[M].张亮,译.北京:人民邮电出版社,2018.

\ No newline at end of file diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..603530c5f5b5a17e3a65b4a4bca6c946233af061 --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25401\350\257\276 \346\234\272\345\231\250\345\255\246\344\271\240\345\277\253\351\200\237\344\270\212\346\211\213\350\267\257\345\276\204\342\200\224\342\200\224\345\224\257\346\234\211\345\256\236\346\210\230/text.html" @@ -0,0 +1,12 @@ +第二天清晨,小冰准时来到上课地点。

+出乎她的意料,等待他们的讲师—老板口中的“大厂资深数据科学家”竟然是她很久没见的高中同桌。这位哥从小喜欢编程,经常熬夜,年纪轻轻就养成了喝浓咖啡的习惯,因此人称“咖哥”。毕业时小冰只知道他考入了某校计算机系,之后就再也没联系过了。

+意外重逢,二人很是激动。不过,他们只能简单寒暄几句,咖哥迅速进入正题。

+“同学们好,”咖哥说,“你们可知道为什么来上这门课程?”

+“要做机器学习项目。”3人很默契地回答道。

+“好,既然是为了做项目而学,那么我们会非常强调实战。当然理论是基础,在开始应用具体技术之前,总要先厘清概念。机器学习,是属于人工智能领域的技术,小冰,你怎么理解‘人工智能’这个概念?”

+“啊,你还真问倒我了,”小冰说,“成天说人工智能,可是我还真说不清楚它到底是什么。”

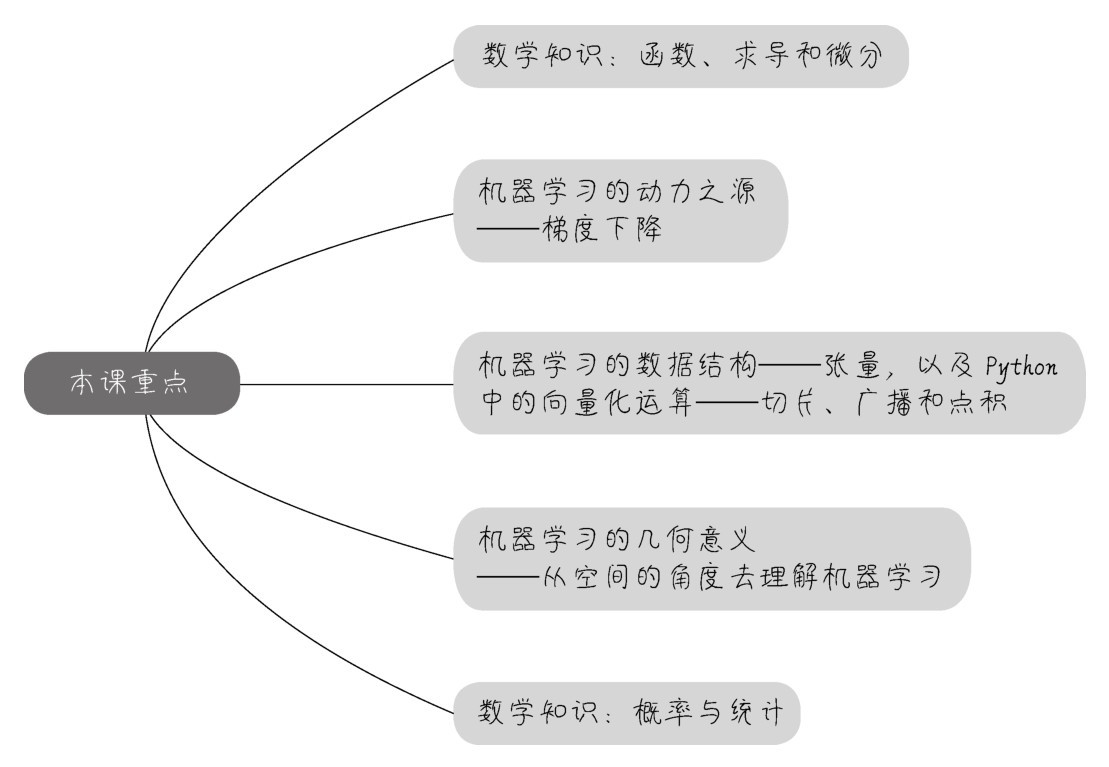

+咖哥说:“好,我们就从人工智能究竟是什么说起。不过,先给出本课重点。”

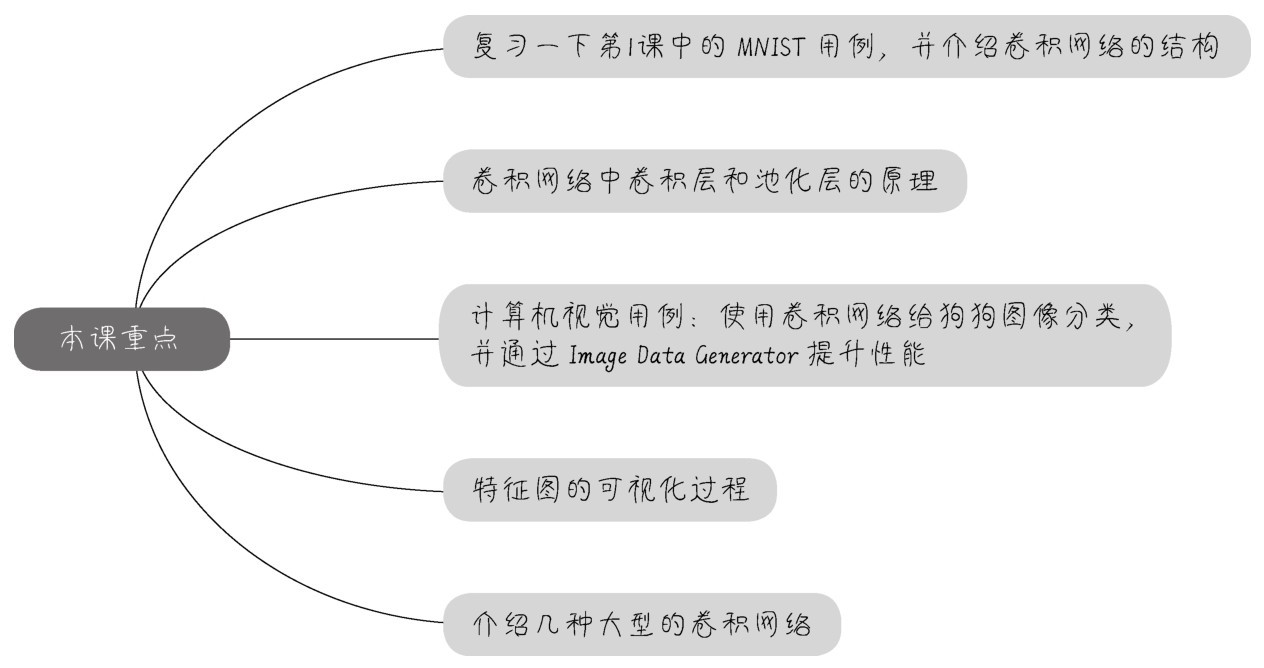

+ +

+“四方上下曰宇,往古来今曰宙。”我们所生活的世界上至无限苍穹,下至微观粒子,瞬息万变。“仰观宇宙之大,俯察品类之盛。”想要把握其中的全部奥妙,难度极大。然而,人类一直在努力探寻事物之间的联系和规律,从而把复杂的现象简单化、抽象化,使之尽量变得有条理,变得可以预测。

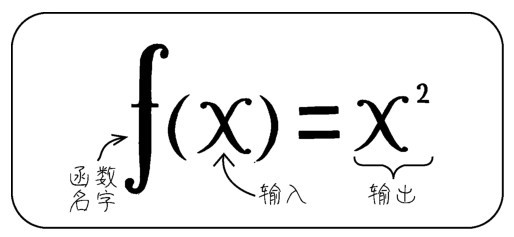

+整个科学体系就试图整理出“宇宙的运行规则”。而函数,可以视为一种模型,这种模型是对客观世界复杂事物之间的关系的简单模拟。有了这种模拟,从已知到未知的运算、预测或判断,就成为可能。

+函数描述了输入与输出的关系。在函数中,一个事物(输出)随着另一个(或一组)事物(输入)的变化而变化,如下图所示。

+ +

+ 输入与输出的关系

+一般情况下,用x(或x1,x2,x3,…)表示输入,用y表示输出,并把它们叫作变量,同时用f(x)来表示从x到y之间转换的过程,它也是函数的名字,如下图所示。

+ +

+ 用解析式表述函数

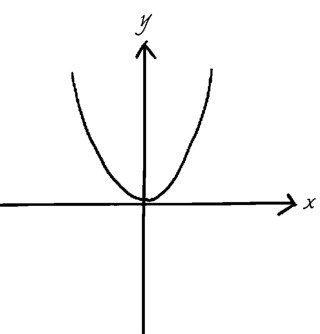

+上面这种表述函数的方法叫作解析式法,除此之外,还可以用列表法、图像法和语言叙述法等表述函数。其中,最直观的是通过图像来描述自变量和因变量之间的关系,如下图所示。但并不一定所有的函数都能够或者需要用图像来表述。

+ +

+ 用图像表述函数

+函数的输入和输出,很多情况下都是数字,但是也不完全如此。函数可以反映非数字之间的关系。比如,函数的输入可以是编号,输出可以是人名,关系就是“S1105560Z”→“黄先生”。在机器学习中,反映非数字之间的关系的函数就更常见了,比如,从狗的图片(输入)到狗的种类(输出)。

+因此需要用一个更强大的工具来帮助定义函数—集合。集合里面的每个东西(如“数字1”“狗的图片”或“黄先生”),不管是不是数字,都是集合成员或元素。所以,函数的输入是一个集中的元素,通过对应法则来输出另一个集中的元素。因此,大家可能还记得,初中的时候学过:定义域(也就是输入集)、值域(也就是输出集)和对应法则(也就是关系)被称为函数三要素。

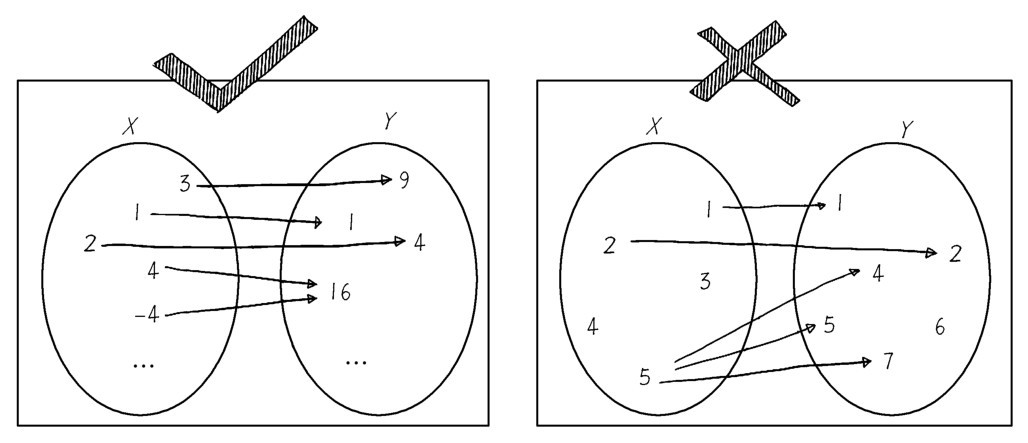

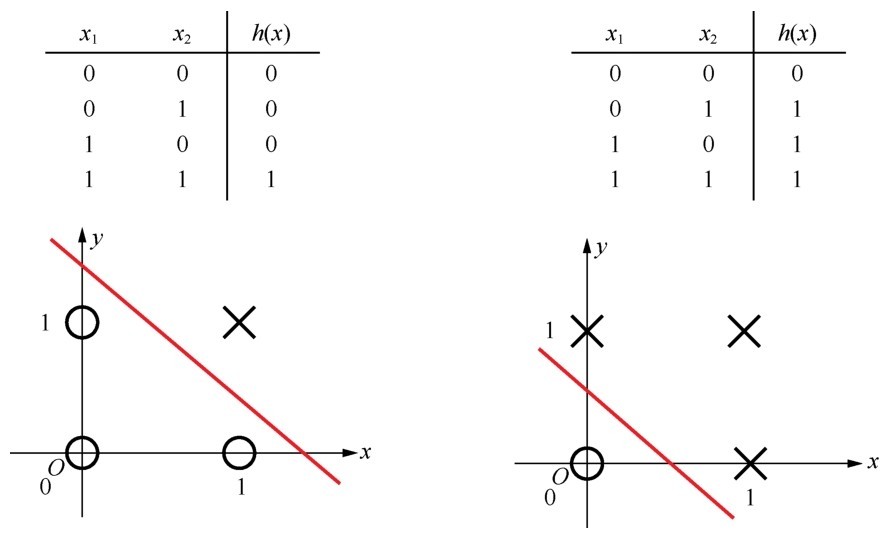

+那么说到此处,函数的定义就完善了吗?还没有。函数把一个集里的每一个元素联系到另一个集里一个独一的值(该定义参考自“数学乐”网站的文章《函数是什么》)。这才算是较严谨的函数定义,如下图所示。

+ +

+ 函数反映了两个集合之间的对应关系

+有以下两点需要注意。

+(1)输入集中的每一个元素X都要被“照顾”到(不过输出集Y并不一定需要完全覆盖。想象一下有一组狗的图片,全部鉴别完之后,发现其中缺少一个类型的狗,这是可能的)。

+(2)函数的输出值是独一无二的。一个输入绝对不能够对应多个输出。比如,一张狗的图片,鉴定后贴标签时,认为既是哈士奇,又是德国牧羊犬。这种结果令人困惑,这样的函数我们也不接受。

+如下面左图,是函数无疑;而右图,虽然也体现了从输入到输出之间的关系,但是有的X值同时对应了几个Y值,不满足函数的定义,所以它不是函数。

+ +

+ 左图满足函数定义,右图不满足函数定义

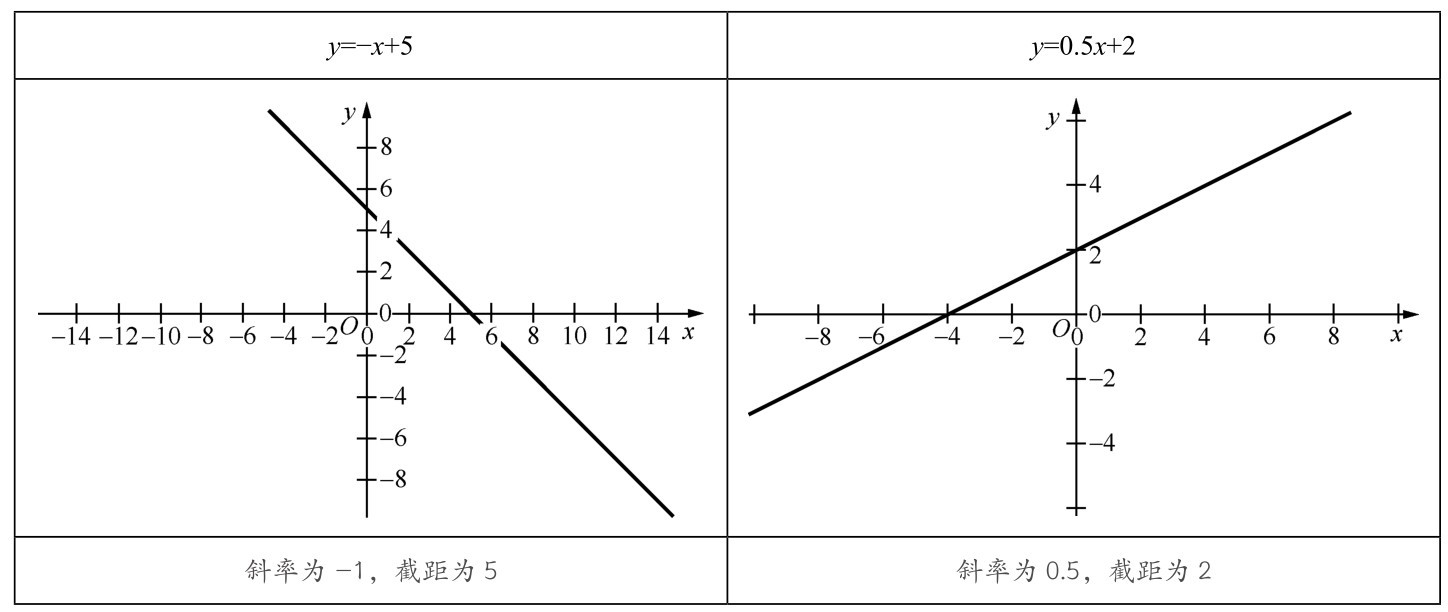

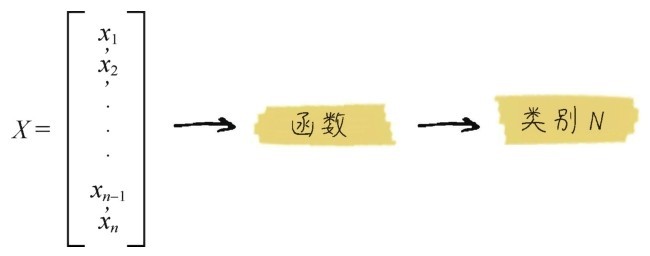

+机器学习基本上等价于寻找函数的过程。机器学习的目的是进行预测、判断,实现某种功能。通过学习训练集中的数据,计算机得到一个从x到y的拟合结果,也就是函数。然后通过这个函数,计算机就能够从任意的x,推知任意的y。这里的自变量x,就是机器学习中数据集的特征,而特征的个数,通常会多于一个,记作x1, x2, …, xn。如下图中的示例:机器学习通过电影的成本、演员等特征数据,推测这部电影可能收获的票房。

+ +

+机器学习到的函数,实现了从特征到结果的一个特定推断。

+机器学习到的函数模型有时过于复杂,并不总是能通过集合、解析式或者图像描述出来。然而,不能直观描述,并不等于函数就不存在了,机器学习所得到的函数正是事物之间的关系的体现,并发挥着预测功能。换句话说,大数据时代的机器学习,不是注重特征到标签之间的因果逻辑,而是注重其间的相关关系。

+那么如何衡量通过机器学习所得到的函数是不是好的函数呢?在训练集和验证集上预测准确,而且能够泛化到测试集,就是好函数。对结果判断的准确性,是机器学习函数的衡量标准,在这个前提之下,我们把科学体系中原本的核心问题“为什么”,转移到了“是什么”这个更加实用的目标。

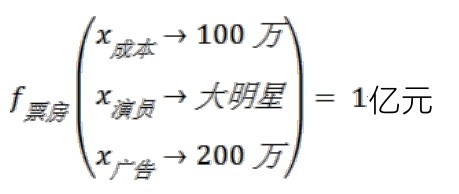

+Kaggle上面有一个很知名的竞赛,其训练集中包含泰坦尼克号登船乘客的详细信息(这是特征),以及生还与否的记录(这是标签),目标则是去预测测试集中的每一位乘客是存活还是死亡。这个竞赛数据集的说明如下图所示。

+ +

+ 存活或死亡?—泰坦尼克号机器学习竞赛数据集

+面对这样的数据集,如何去寻找一个好的函数呢?你们可能听说过,当时船长曾提议让女士和儿童优先离船,登上救生艇。因此,如果预测女性全部存活,准确率会超过预测男性全部存活。“登船女性全部存活,男性全部遇难”,这也是从特征到标签的简单映射关系,算是一个函数。而且应用这个函数大概可以得到60%的预测准确率。然而,这个函数过于简单了,没有含金量。

+通过机器学习,可以实现更准确的预测,能够更有效地找到数据特征以及标签之间错综复杂的联系。也就是说,机器通过学习发现了一个更为复杂的函数,能够从各种看似不相关的特征x中,预测或者推导出更加靠谱的y值。

+此时,从数据特征到生还与否的结果间的关系通过机器学习算法拟合到了极为细微的程度。比如,某个家庭的成员情况(如孩子的个数)、所住的舱位、所在的甲板,以及他们的生活习惯(如是否吸烟)等特征信息,都有可能在冥冥之中影响着乘客们的生命。这些很难用肉眼或者统计学方法去发现的关联性,竟能够通过机器学习算法的推演,得到相当准确的答案。可以说,机器学习算法得到的函数,往往能看到数据背后隐藏着的、肉眼所不能发现的秘密。

+就这个竞赛来说,“高手”的机器学习模型,甚至可达到99%以上的预测准确率。也就是说,如果能够穿越时空,带上机器交给我们的函数来到泰坦尼克号启航的码头,询问每一位乘客几个私人问题,根据他们的回答,就可以基本知晓他们的命运。

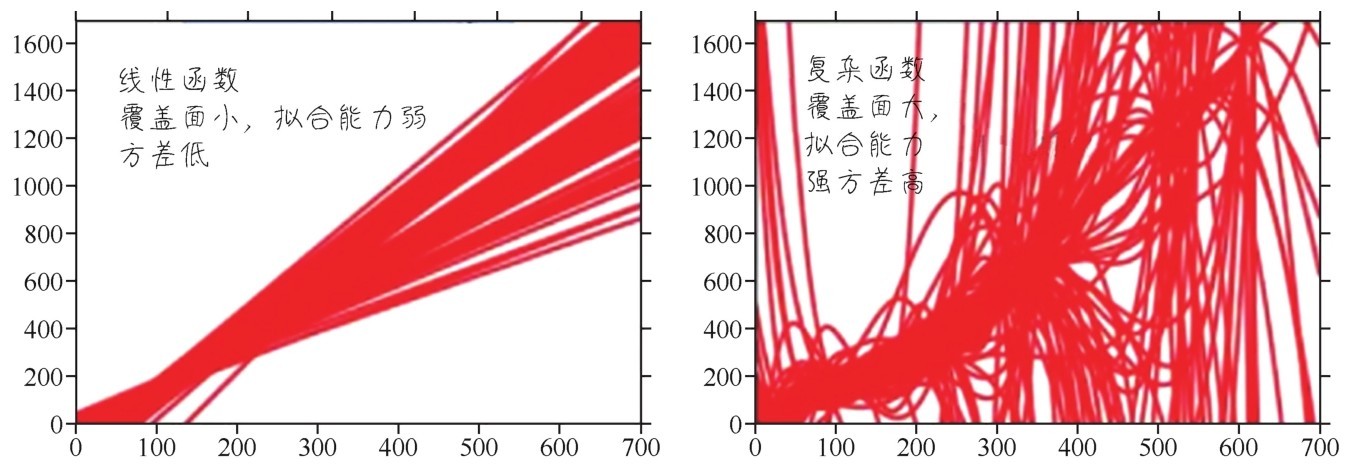

+传统的机器学习算法包括线性回归、逻辑回归、决策树、朴素贝叶斯等,通过应用这些算法可以得到不同的函数。而深度学习的函数具有复杂的神经网络拓扑结构,网络中的参数通过链式求导来求得,相当于一大堆线性函数的跨层堆叠。它们仿佛存在于一片混沌之中,虽然看不见摸不着,却真实地存在着。

+无论是传统的机器学习,还是深度学习,所得到的函数模型都是对样本集中特征到标签的关系的总结,是其相关性的一种函数化的表达。

+下面简单说说我们这次机器学习之旅中会见到的一些函数。

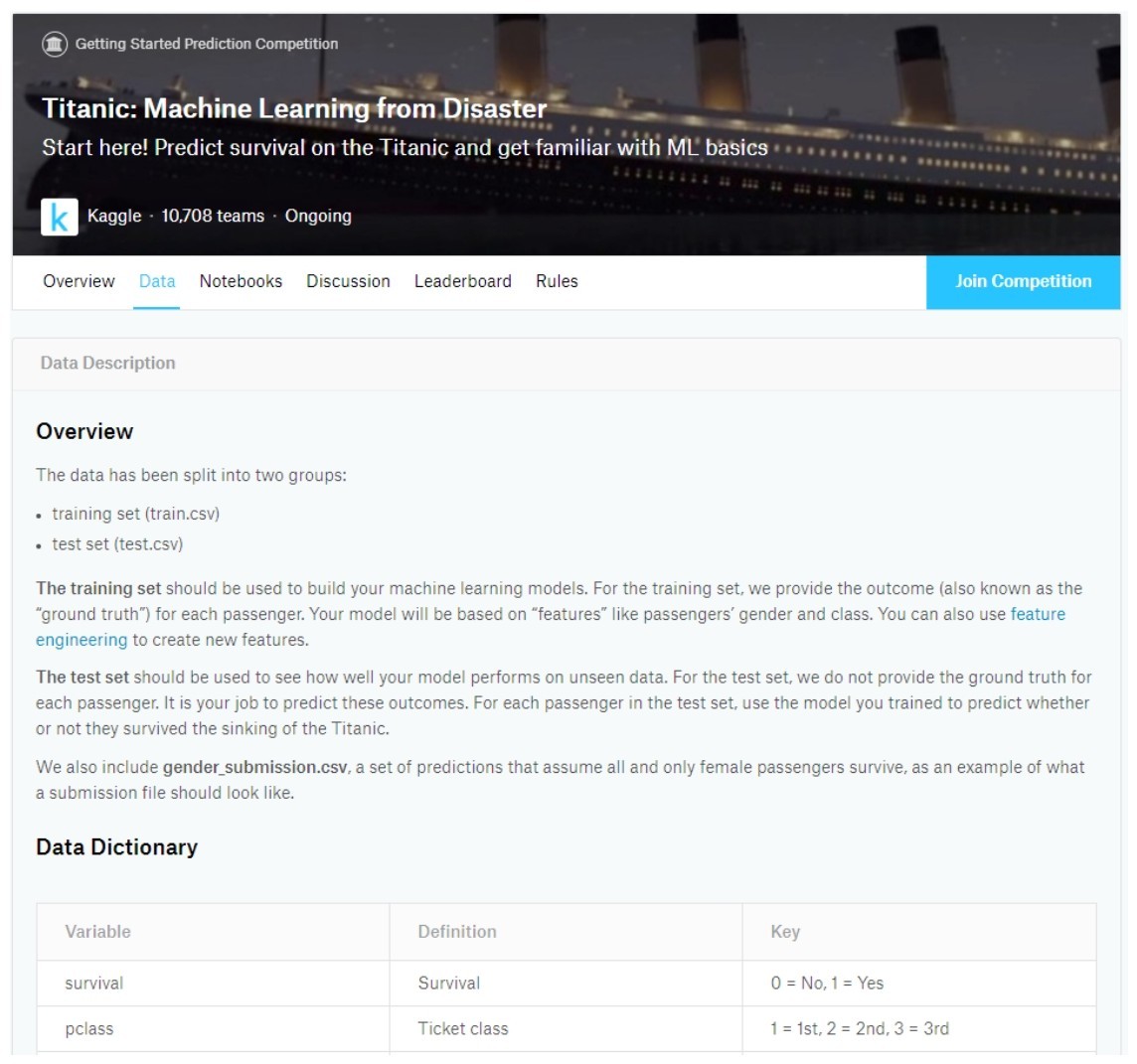

+1.线性函数

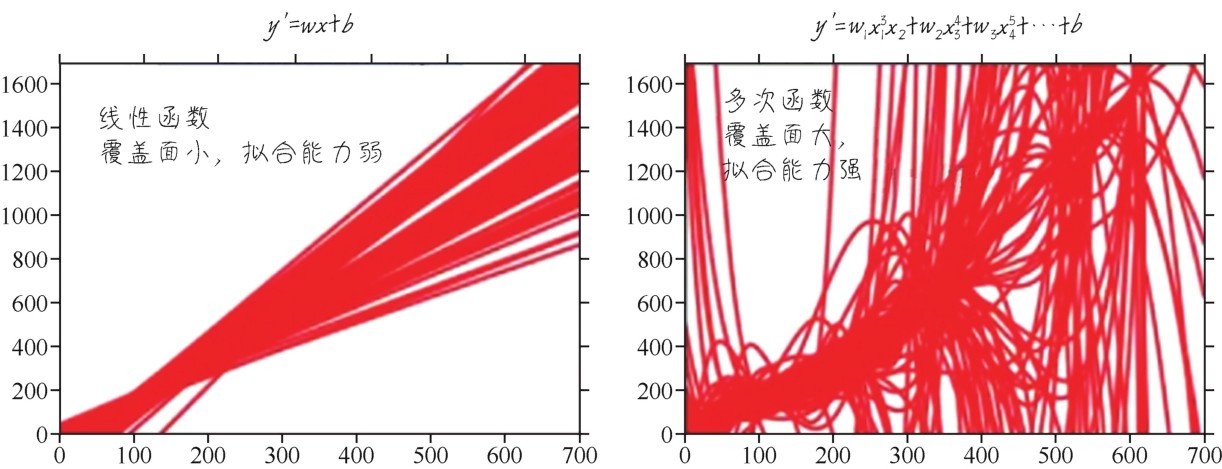

+线性函数是线性回归模型的基础,也是很多其他机器学习模型中最基本的结构单元。线性函数是只拥有一个变量的一阶多项式函数,函数图像是一条直线。下图给出了两个线性函数。

+ +

+ 两个线性函数

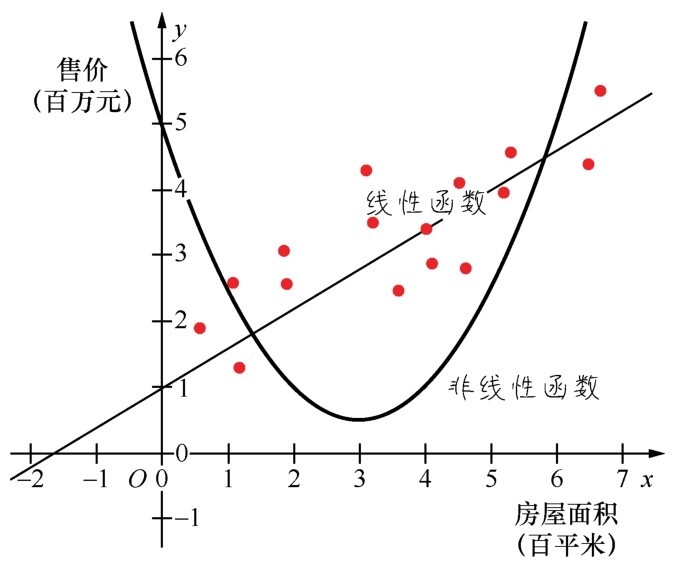

+线性函数适合模拟简单的关系,比如,同一个小区房屋的面积和其售价之间可能会呈现线性的关系。

+2.二次函数和多次函数

+函数中自变量x中最大的指数被称为函数的次数,比如y=x2就是二次函数。二次函数和多次函数的函数图像更加复杂,因而可以拟合出更为复杂的关系,如下图所示。

+ +

+ 二次函数和多次函数

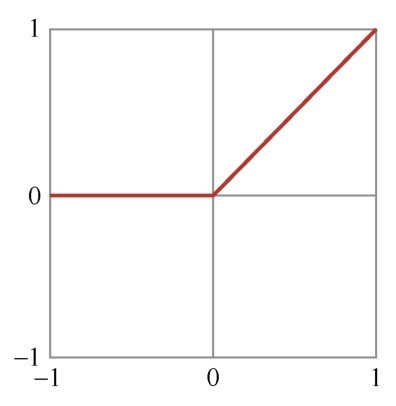

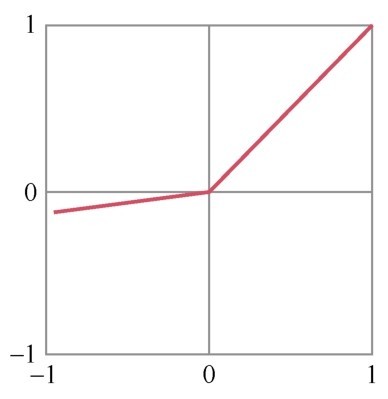

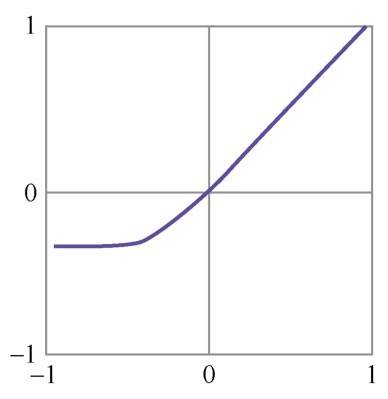

+3.激活函数

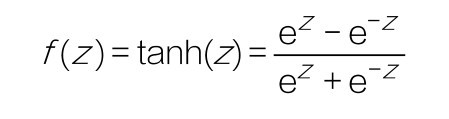

+还有一组函数在机器学习中相当重要,它们是神经网络中的激活函数(activation function)。这组函数我们在数学课上也许没见过,但是它们都十分简单,如下图所示。它们的作用是在机器学习算法中实现非线性的、阶跃性质的变换。其中的Sigmoid函数在机器学习的逻辑回归模型中起着重要的作用。

+ +

+ 激活函数

+ 咖哥发言

咖哥发言

Sigmoid函数中的e叫自然常数,是一个无理数,约等于2.72。

+4.对数函数

+对数函数是指数函数(求幂)的逆运算。原来的指数就是对数的底。从几何意义上说,对数是将数轴进行强力的缩放,再大的数字经对数缩放都会变小。对数函数图像如下图所示。

+ +

+ 对数函数图像

+下面给出对数函数的Python代码示例:

+import math # 导入数学工具包

+y = math.log(100000000, 10)# 以10为底, 在x值等于一亿的情况下

+print("以10为底, 求一亿的对数:", y)# 求出y的值为8

+以10为底, 求一亿的对数:8.0

+如果不指定对数的底,则称logx为自然对数,是以自然常数e为底数的对数[1]。在逻辑回归算法中,我们会见到自然对数作为损失函数而出现。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/2.2.2 \346\215\225\346\215\211\345\207\275\346\225\260\347\232\204\345\217\230\345\214\226\350\266\213\345\212\277/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/2.2.2 \346\215\225\346\215\211\345\207\275\346\225\260\347\232\204\345\217\230\345\214\226\350\266\213\345\212\277/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..655af1beba153cb9a851cabe0612b998bb0f80c7 --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/2.2.2 \346\215\225\346\215\211\345\207\275\346\225\260\347\232\204\345\217\230\345\214\226\350\266\213\345\212\277/text.html" @@ -0,0 +1,42 @@ + +机器学习所关心的问题之一是捕捉函数的变化趋势,也就是研究y如何随着x而变,这个趋势是通过求导和微分来实现的。

+连续性是函数的性质之一,它是可以对函数求导的前提条件。

+具有连续性的函数,y值随x值的变化是连贯不间断的。并不是所有函数都具有连续性,像上面提到的阶跃函数从-1到1的跃迁明显就不具有连续性。

+然而,有连续性的函数对于机器学习来说至关重要。因为机器学习的过程总体来说是对趋势和函数的变化规律的学习。失去了连续性,趋势和变化的规律也就难以用下面所要介绍的方法寻找了。

+导数(derivative)是定义在连续函数的基础之上的。想要对函数求导,函数至少要有一段是连续的。导数的这个“导”字命名得好,导,是引导,是导航,它与函数上连续两个点之间的变化趋势,也就是与变化的方向相关。

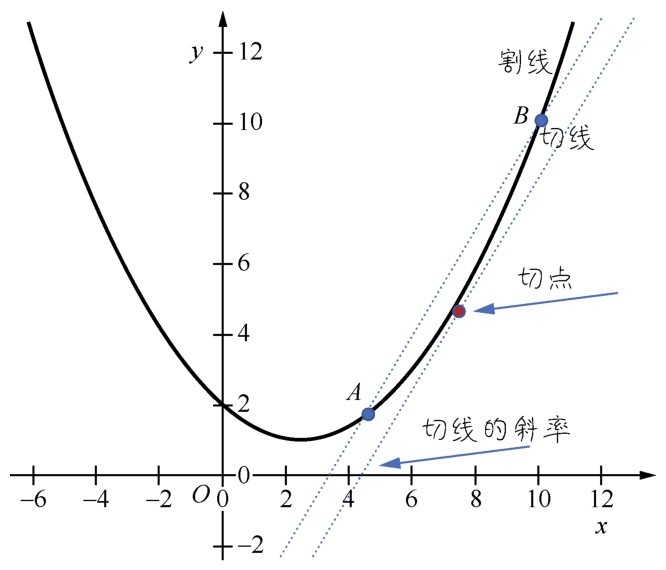

+看下面这张图,在一段连续函数的两个点A、B之间,y值是怎么从A点逐渐过渡到B点的?是因为x的变化,y也随之发生了变化,这个变化记作dx,dy。

+为了演示得比较清楚,A、B两点离得比较远,通过一条割线,就可以把dx,dy割出来。这个割线给出的方向,就是从A点到B点的变化,也就是割线的斜率。初中数学讲过,直线的斜率就是它相对于横轴的倾斜程度,求法是dy/dx,也等价于从A点到B点的变化方向。

+ +

+ x变化,导致y随之发生了变化

+那么当A点和B点的距离越来越小,两个点无限接近,逼近极限的时候,在即将重合而又未重合的一刹那,割线就变成切线了,如下图所示。

+ +

+ 对切点求导所得的值,就是切线的斜率

+而此时,对切点求导所得的值,就是切线的斜率。

+■当斜率为正的时候,说明函数目前变化趋势是在上升。

+■当斜率为负的时候,说明函数目前变化趋势是在下降。

+■当斜率为0的时候,说明函数正处于全局或者局部的最低点,趋势即将发生改变。

+总结一下:函数变化的趋势至少由两个点体现,即当A趋近于B的时候,求其变换的极限,这就是导数。导数的值和它附近的一小段连续函数有关。如果没有那么一段连续的函数,就无法计算其切线的斜率,函数在该点也就是不可导的。

+通过求导,实现了以直代曲,也发现了y值随x值而变化的方向。引申到机器学习领域,通过导数就可以得到标签y随特征x而变化的方向。

+导数是针对一个变量而言的函数变化趋向。而对于多元(即多变量)的函数,它关于其中一个变量的导数为偏导数,此时保持其他变量恒定。如果其中所有变量都允许变化,则称为全导数。

+ 咖哥发言

咖哥发言

我们经常听说n元n次方程式,或者n元n次函数,其中的“元”,指的是自变量x的个数;其中的“次”,指的是x的指数的最大值。

+在微积分中,可微函数是指那些在定义域中所有点都存在导数的函数。

+ +

+ 一个可微的二元函数

+右图所示为一个可微的二元函数(对应机器学习中特征轴是二维的情况),这时候对函数求导,切线就变成了切面。

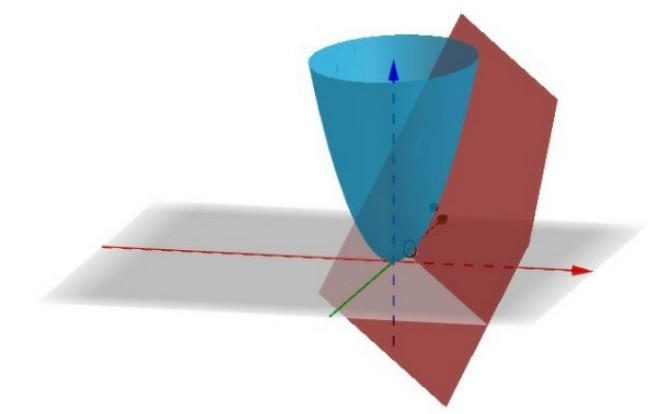

+凹凸性也是函数的性质之一(函数还有很多其他性质,如奇偶性、单调性、周期性等),在这里只说说什么是凸函数。凸函数的定义比较抽象,这里只通过函数图形从直观上去理解。首先,函数形状必须是连续的,而不是断续的。其次,函数平滑,只存在一个最低点,整个函数呈现碗状。而非凸函数,可能呈现各种形状,有很多个底部(机器学习里面叫作局部最低点)。下图所示的函数f1就是一个凸函数,而函数f2就不是一个凸函数。

+在连续函数图像上的局部或者全局最低点对函数求导,导数值都为0。

+ +

+ 凸函数和非凸函数

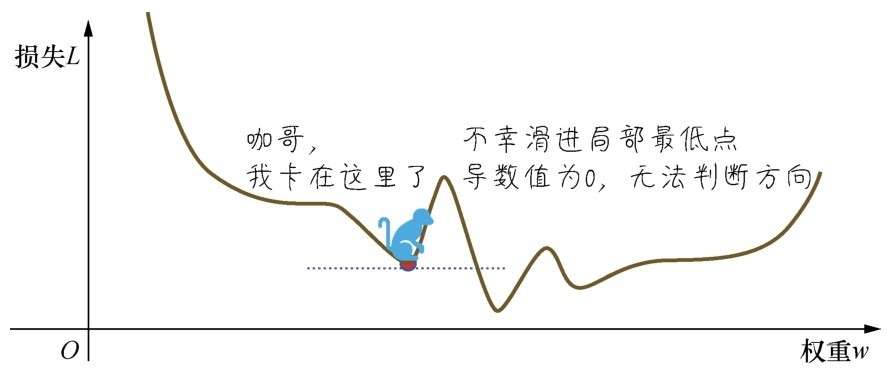

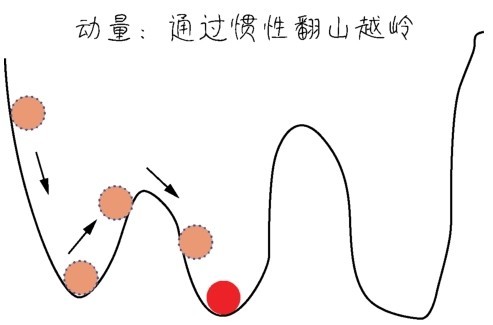

+为什么要特别讲这个凸函数呢?因为在机器学习的梯度下降过程中,只有凸函数能够确保下降到全局最低点。你们可能注意到我在上面的图像里面画了一个小球,凸函数的小球不管初始位置放在哪里,都可以沿着导数给出的方向滚到最低点;而在其他非凸函数中,小球就可能卡在半路,也就是那个叫作局部最低点的地方。在机器学习中,无法达到全局最低点是很不理想的情况(这是后话,暂且不讲解)。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/3.2.3 \346\242\257\345\272\246\344\270\213\351\231\215\346\230\257\346\234\272\345\231\250\345\255\246\344\271\240\347\232\204\345\212\250\345\212\233\344\271\213\346\272\220/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/3.2.3 \346\242\257\345\272\246\344\270\213\351\231\215\346\230\257\346\234\272\345\231\250\345\255\246\344\271\240\347\232\204\345\212\250\345\212\233\344\271\213\346\272\220/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..9c12d0b7a8faba25e1a879c98ffef2a400b4592a --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/3.2.3 \346\242\257\345\272\246\344\270\213\351\231\215\346\230\257\346\234\272\345\231\250\345\255\246\344\271\240\347\232\204\345\212\250\345\212\233\344\271\213\346\272\220/text.html" @@ -0,0 +1,21 @@ + +经过前面两节内容的铺垫,我们可以开始讲一讲机器学习的动力之源:梯度下降。

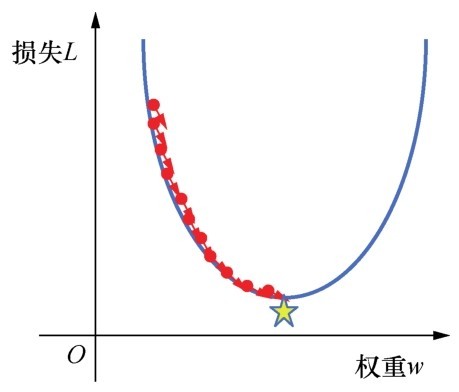

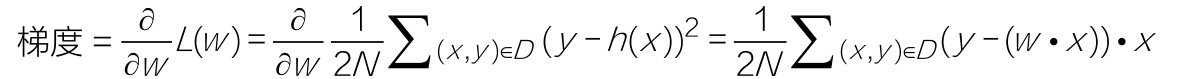

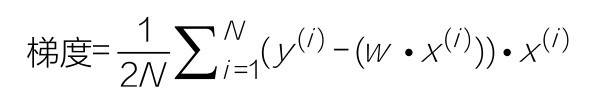

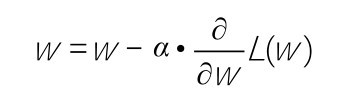

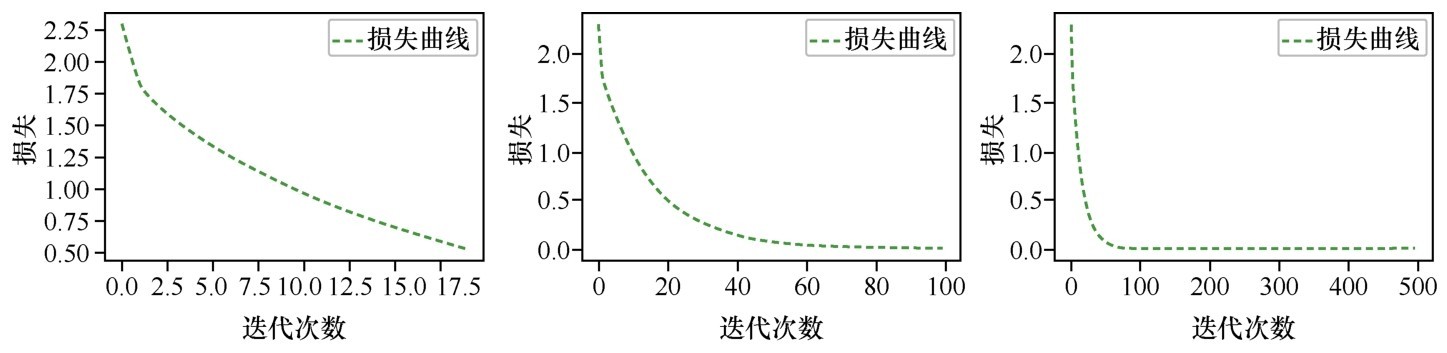

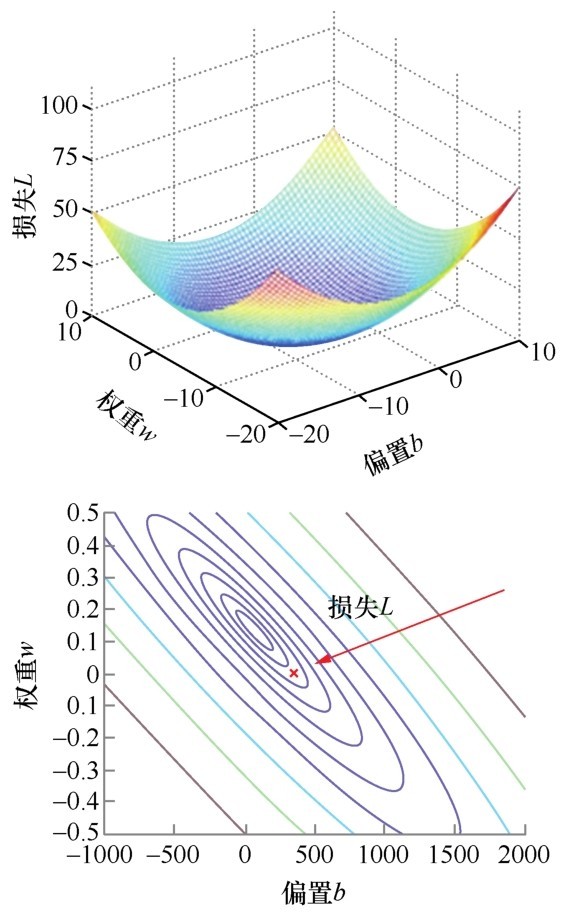

+梯度下降并不是一个很复杂的数学工具,其历史已经有200多年了,但是人们可能不曾料到,这样一个相对简单的数学工具会成为诸多机器学习算法的基础,而且还配合着神经网络点燃了深度学习革命。

+对多元函数的各参数求偏导数,然后把所求得的各个参数的偏导数以向量的形式写出来,就是梯度。

+具体来说,两个自变量的函数f(x1,x2),对应着机器学习数据集中的两个特征,如果分别对x1,x2求偏导数,那么求得的梯度向量就是(∂f/∂x1,∂f/∂x2)T,在数学上可以表示成Δf(x1,x2)。

+那么计算梯度向量的意义何在呢?其几何意义,就是函数变化的方向,而且是变化最快的方向。对于函数f(x),在点(x0,y0),梯度向量的方向也就是y值增加最快的方向。也就是说,沿着梯度向量的方向Δf(x0),能找到函数的最大值。反过来说,沿着梯度向量相反的方向,也就是 -Δf(x0)的方向,梯度减少最快,能找到函数的最小值。如果某一个点的梯度向量的值为0,那么也就是来到了导数为0的函数最低点(或局部最低点)了。

+在机器学习中用下山来比喻梯度下降是很常见的。想象你们站在一座大山上某个地方,看着远处的地形,一望无际,只知道远处的位置比此处低很多。你们想知道如何下山,但是只能一步一步往下走,那也就是在每走到一个位置的时候,求解当前位置的梯度。然后,沿着梯度的负方向,也就是往最陡峭的地方向下走一步,继续求解新位置的梯度,并在新位置继续沿着最陡峭的地方向下走一步。就这样一步步地走,直到山脚,如下图所示。

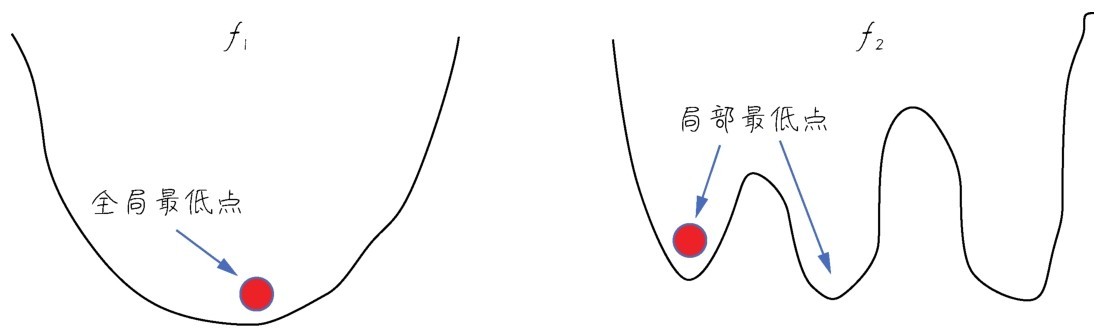

+ +

+ 梯度下降的隐喻和一个二元函数的立体图像

+从上面的解释中,就不难理解为何刚才我们要提到函数的凹凸性了。因为,在非凸函数中,有可能还没走到山脚,而是到了某一个山谷就停住了。也就是说,对应非凸函数梯度下降不一定总能够找到全局最优解,有可能得到的只是一个局部最优解。然而,如果函数是凸函数,那么梯度下降法理论上就能得到全局最优解。

+梯度下降在机器学习中非常有用。简单地说,可以注意以下几点。

+■机器学习的本质是找到最优的函数。

+■如何衡量函数是否最优?其方法是尽量减小预测值和真值间的误差(在机器学习中也叫损失值)。

+■可以建立误差和模型参数之间的函数(最好是凸函数)。

+■梯度下降能够引导我们走到凸函数的全局最低点,也就是找到误差最小时的参数。

+也许上面的说明还是挺抽象的,不要着急,在第3课线性回归的梯度下降实现部分,我将保证你们会完全理解梯度下降在机器学习中的意义。

diff --git "a/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/4.2.4 \346\234\272\345\231\250\345\255\246\344\271\240\347\232\204\346\225\260\346\215\256\347\273\223\346\236\204\342\200\224\342\200\224\345\274\240\351\207\217/text.html" "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/4.2.4 \346\234\272\345\231\250\345\255\246\344\271\240\347\232\204\346\225\260\346\215\256\347\273\223\346\236\204\342\200\224\342\200\224\345\274\240\351\207\217/text.html" new file mode 100644 index 0000000000000000000000000000000000000000..a2c46fdcf791cb0876447667e89780b5383d105c --- /dev/null +++ "b/data/\351\233\266\345\237\272\347\241\200\345\255\246\346\234\272\345\231\250\345\255\246\344\271\240/\347\254\25402\350\257\276 \346\225\260\345\255\246\345\222\214Python\345\237\272\347\241\200\347\237\245\350\257\206\342\200\224\342\200\224\344\270\200\345\244\251\346\220\236\345\256\232/4.2.4 \346\234\272\345\231\250\345\255\246\344\271\240\347\232\204\346\225\260\346\215\256\347\273\223\346\236\204\342\200\224\342\200\224\345\274\240\351\207\217/text.html" @@ -0,0 +1,220 @@ + +咖哥说:“下面开始介绍与机器学习程序设计相关的一些基础知识。机器学习,是针对数据集的学习。因此,机器学习相关的程序设计,我认为有两大部分:一是对数据的操作,二是机器学习算法的实现。算法,是本书后续课程中的重点。而在本课中,先介绍如何用Python操作数据。数据操作的基础是数据结构。还记得线性代数‘矩阵’这个概念吗?还有数据结构课程中的‘数组’,这些对我们来说并不陌生,对吗?”

+“对,矩阵和数组,我都有印象。”小冰回答,“我记得矩阵也就是二维数组。”

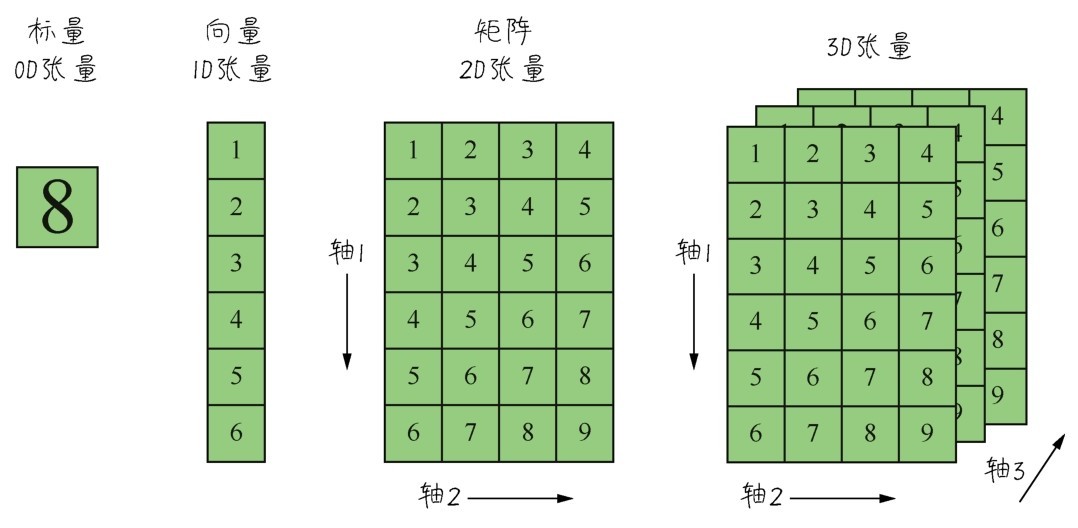

+咖哥说,“在机器学习中,把用于存储数据的结构叫作张量(tensor),矩阵是二维数组,机器学习中就叫作2D张量。”

+张量是机器学习程序中的数字容器,本质上就是各种不同维度的数组,如下图所示。我们把张量的维度称为轴(axis)(就是数学中的x轴,y轴,……),轴的个数称为阶(rank)(也就是俗称的维度,但是为了把张量的维度和每个阶的具体维度区分开,这里统一把张量的维度称为张量的阶。NumPy中把它叫作数组的轶)。

+ +

+ 各种张量

+张量的形状(shape)就是张量的阶,加上每个阶的维度(每个阶的元素数目)。

+张量都可以通过Num Py来定义、操作。因此,把Num Py数学函数库里面的数组用好,就可以搞定机器学习里面的数据结构。

+我们从最简单的数据结构开始介绍。仅包含一个数字的张量叫作标量(scalar),即0阶张量或0D张量。

+标量的功能主要在于程序流程控制、设置参数值等。

+下面创建一个Num Py标量:

+import numpy as np #导入Num Py库

+X = np.array(5) #创建0D张量, 也就是标量

+print("X的值", X)

+print("X的阶", X.ndim) #ndim属性显示标量的阶

+print("X的数据类型", X.dtype) #dtype属性显示标量的数据类型

+print("X的形状", X.shape) #shape属性显示标量的形状

+输出结果如下:

+X的值5

+X的阶0

+X的数据类型int64

+X的形状 ()

+此处标量的形状为(),即标量的阶为0,同学们要习惯一下这个表达形式。

+ 咖哥发言

咖哥发言

注意了,NumPy中,不管是阶的索引,还是数组的索引,永远是从0开始的。

+刚才的代码用array函数创建了标量,其实对于标量往往直接赋值即可,如下面这段代码通过for循环语句操作标量n:

+n = 0

+for gender in [0, 1]:

+n = n + 1 #Python中用4个空格表示语句块缩进

+ 咖哥发言

咖哥发言

Python中用4个空格表示语句块缩进,而且它的缩进决定了代码的作用域范围。也就是说,相同缩进的相邻代码都隶属于同一个语句块。这和C++、Java中通过花括号{}确定代码块的方式有很大不同。还要注意,不要用Tab键代替空格键处理缩进。

+由一组数字组成的数组叫作向量(vector),也就是一阶张量,或称1D张量。一阶张量只有一个轴。

+下面创建一个Num Py向量:

+X = np.array([5, 6, 7, 8, 9]) #创建1D张量, 也就是向量

+print("X的值", X)

+print("X的阶", X.ndim) #ndim属性显示向量的阶

+print("X的形状", X.shape) #shape属性显示向量的形状

+输出结果如下:

+X的值[5 6 7 8 9]

+X的阶1

+X的形状 (5, )

+创建向量的时候要把数字元素放进方括号里面,形成一个包含5个元素的1D张量。需要再次强调的是,机器学习中把5个元素的向量称为5维向量。千万不要把5维向量和5阶张量混淆。

+ 咖哥发言

咖哥发言

向量的维度,这的确是机器学习过程中比较容易让人感到混乱的地方。其原因在于:维度(dimensionality)(也就是英文字母D)可以表示沿着某个轴上的元素个数(如5D向量),也可以表示张量中轴的个数(如5D张量),这的确会令人感到混乱。还是那句话,为了区别两者,把5D张量称为5阶张量,而不称为5维张量。

+再看一下X向量的形状(5,)。这个描述方式也是让初学者比较困惑的地方,如果没有后面的逗号,可能看起来更舒服一点儿。但是我们要习惯,(5,)就表示它是一个1D张量,元素数量是5,也就是5维向量。

+下面这个语句又创建了一个向量,这个向量是一个1维向量:

+X = np.array([5]) #1维向量, 也就是1D数组里面只有一个元素

+这个语句和刚才创建标量的语句“X = np.array(5)”的唯一区别只是数字5被方括号括住了。正是因为这个方括号,这个语句创建出来的就不是数字标量,而是一个向量,即1D张量。它的轴的个数是1,形状是(1,),而不是()。

+1.机器学习中的向量数据

+向量非常的重要。在机器学习中,普通的连续数值数据集中的每一个独立样本都是一个向量,因此普通的连续数值数据集也可以叫作向量数据集。而数据集中的标签列也可以视为一个向量。

+ 咖哥发言

咖哥发言

同学们注意,向量数据集说的是数据集中的每一行,或每一列,都可以视为向量,但是数据集整体是一个矩阵。

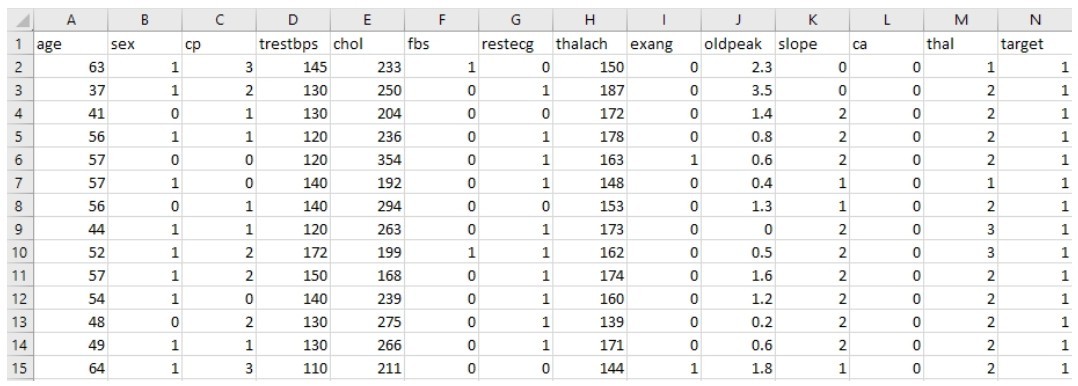

+现在,我们载入一个机器学习数据集来看一看:

+from keras.datasets import boston_housing #波士顿房价数据集(需要打开Internet选项)

+(X_train, y_train), (X_test, y_test) = boston_housing.load_data()

+print("X_train的形状:", X_train.shape)

+print("X_train中第一个样本的形状:", X_train[0].shape)

+print("y_train的形状:", y_train.shape)

+这个是Keras内置的波士顿房价数据集,是一个2D的普通数值数据集。

+输出结果如下:

+X_train的形状 (404, 13)

+X_train中第一个样本的形状 (13, )

+y_train的形状 (404, )

+X_train是一个2D矩阵,是404个样本数据的集合。而y_train的形状,正是一个典型的向量,它是一个404维的标签向量。其实几乎所有的标签集的形状都是向量。

+X_train[0]又是什么意思呢?它是X_train训练集的第一行数据,这一行数据,是一个13维向量(也是1D张量)。也就是说,训练集的每行数据都包含13个特征。

+同学们也可以用print(X_test)、print(y_test)语句输出测试集中波士顿房价的信息。

+ 咖哥发言

咖哥发言

初学者在进行机器学习程序调试过程中,要坚持不懈地输出检查向量的维度,以及张量的形状。因为一旦维度或张量形状出错了,机器学习建模过程是难以继续的……切记!

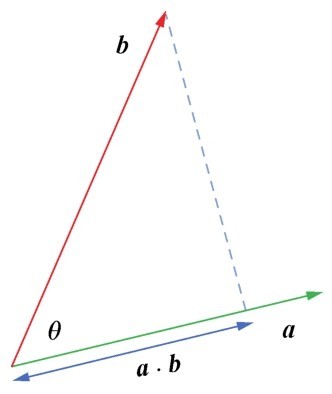

+2.向量的点积

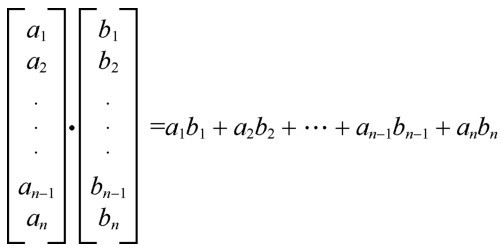

+两个向量之间可以进行乘法运算,而且不止一种,有点积(dot product)(也叫点乘)和叉积(cross product)(也叫叉乘),其运算法则不同。这里介绍一下在机器学习中经常出现的点积运算。

+向量的点积运算法则如右图所示。

+ +

+ 向量的点积运算法则

+简单地说,就是两个相同维度的向量对应元素先相乘,后相加,形成等号右边的多项式。

+这里通过一小段代码展示一下两个向量点积运算的Python实现:

+weight = np.array([1, -1.8, 1, 1, 2]) #权重向量(也就是多项式的参数)

+X = np.array([1, 6, 7, 8, 9]) #特征向量(也就是一个特定样本中的特征值)

+y_hat = np.dot(X, weight) #通过点积运算构建预测函数

+print('函数返回结果:', y_hat) #输出预测结果

+输出结果如下:

+函数返回结果:23.2

+下面的语句也可以实现相同的功能:

+y_hat = weight.dot(X) # X.dot(weight)也可以实现同样效果

+注意向量点积的结果是一个值,也就是一个标量,而不是一个向量。

+ 咖哥发言

咖哥发言

通过向量、矩阵等数据结构进行向量化运算是机器学习中的一个关键技术。而Python能够方便地实现向量化运算,正是Python核心优势之一。在上面两段代码中,点积运算就是通过向量化运算直接实现的,过程中没有出现任何for循环语句。

+另外,在向量的点积运算中,A·B=B·A,向量可以互换位置。不过,下面要介绍的矩阵间的点积,或者矩阵和向量之间的点积,就没有这么随意了。

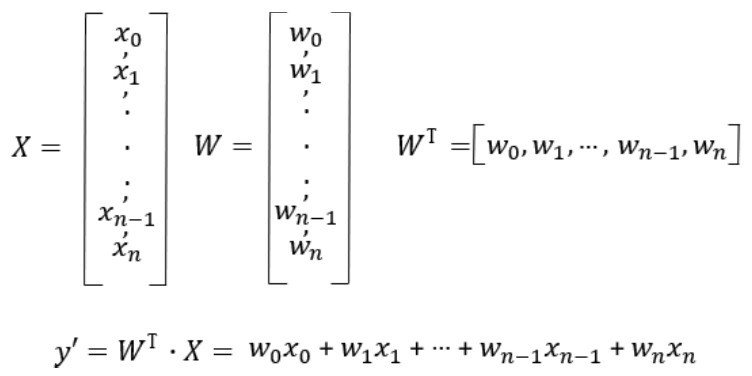

+这里提前透露一点下一课中的内容:机器学习中最基础的线性回归方法就是根据线性函数去拟合特征和标签的关系,其中的参数w是一个向量,x也是一个向量,x是特征向量,w是权重向量。通过将特征向量(一个样本)和权重向量做点积,就得到针对该样本的预测目标值y'。其公式如下:

+y'=w0x0+w1x1+w2x2+…+wnxn

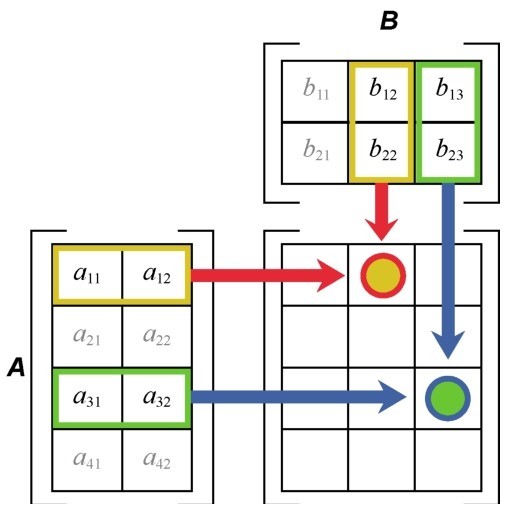

+矩阵(matrix)是一组一组向量的集合。矩阵中的各元素横着、竖着、斜着都能构成不同的向量。而矩阵,也就是 2 阶张量,或称 2D 张量,其形状为(m,n)。比如,右图所示是一个形状为(4,3)的张量,也就是4 行 3 列的矩阵。

+矩阵里面横向的元素组称为“行”,纵向的元素组称为“列”。一个矩阵从左上角数起的第i行第j列上的元素称为第(i,j)项,通常记为a(i,j)。

+ +

+ 矩阵

+1.机器学习中的矩阵数据

+机器学习中的矩阵数据比比皆是,因为普通的向量数据集都是读入矩阵后进行处理。

+矩阵是2D张量,形状为 (样本,特征)。第一个轴是样本轴,第二个轴是特征轴。

+我们来看一看刚才载入的波士顿房价数据集的特征矩阵,这个矩阵的形状是(404,13),也就是404个样本,13个特征:

+print("X_train的内容:", X_train) #X_train是2D张量, 即矩阵

+每一行实际包括13个特征,输出时通过省略号忽略了中间8个特征列的输出。整个张量共404行(中间的数据样本也通过省略号忽略了):

+X_train的内容:

+[[1.23247e+00 0.00000e+00 8.14000e+00 ...3.96900e+02 1.87200e+01]

+[2.17700e-02 8.25000e+01 2.03000e+00 ...3.95380e+02 3.11000e+00]

+...

+[2.14918e+00 0.00000e+00 1.95800e+01 ...2.61950e+02 1.57900e+01]

+[1.43900e-02 6.00000e+01 2.93000e+00 ...3.76700e+02 4.38000e+00]]

+除房价数据集外,再举两个其他类似数据集的例子。

+■公司客户数据集,用于分析客户,包括客户的姓名、年龄、银行账户、消费数据等4个特征,共10 000个客户。此数据集形成的张量形状为(10 000,4)。

+■城市交通数据集,用于研究交通状态,包括城市的街道名、经度、维度、交通事故数量等28个交通数据特征,共800个街道。此数据集形成的张量形状为(800,28)。

+这些数据集读入机器之后, 都将以2D张量,也就是矩阵的格式进行存储。

+2.矩阵的点积

+矩阵之间也可以进行点积。具体来说,是第一个矩阵的行向量,和第二个矩阵的列向量进行点积,然后把结果标量放进新矩阵,作为结果矩阵中的一个元素。这个规则如右图所示。

+请注意,当两个矩阵相乘时,第一个矩阵的列数必须等于第二个矩阵的行数。即形状为(m,n)的矩阵乘以形状为(n, m)的矩阵,结果得到一个矩阵(m,m)。也就是说,如果一个矩阵A的形状是(1,8),一个矩阵B的形状是(3,2),那么它们之间就无法进行点积运算。

+ +

+ 矩阵的点积规则

+一个可行的解决方案是,将A矩阵变形为4x2矩阵,并将B变形为2x3矩阵,而后进行点积,就得到一个形状为(4,3)的4x3矩阵。在Python中可以用reshape方法对矩阵进行变形操作。

+和向量的点积一样,矩阵的点积也是通过Num Py的dot方法实现,这节省了很多的for循环语句。否则,矩阵的运算是需要循环嵌套循环才能实现的。

+ +

+ 3D张量

+在矩阵数据的基础上再增加一个阶,就形成了3D张量,像一个类似右图的数字立方体。

+Num Py的3D张量数据结构是这样定义的:

+# 创建3D张量

+X = np.array([[[1, 22, 4, 78, 2],

+[2, 59, 6, 56, 1],

+[3, 31, 8, 54, 0]],

+[[4, 56, 9, 34, 1],

+[5, 78, 8, 35, 2],

+[6, 34, 7, 36, 0]],

+[[7, 45, 5, 34, 5],

+[8, 53, 6, 35, 4],

+[9, 81, 4, 36, 5]]])

+咖哥说:“下面问题来了:我们知道,一般的数据集,都是两阶,一个轴代表特征,一个轴代表数据样本。那么机器学习中什么样的数据集会形成3D张量?小冰同学,你回答一下。”

+小冰想了一下,答:“是不是MNIST那样的图像数据集?”

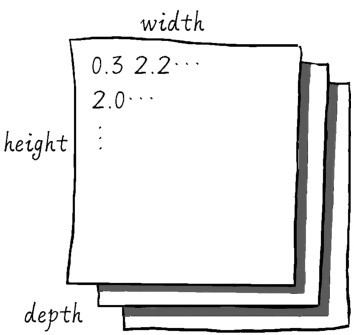

+咖哥回答说:“思路正确。不过图像数据集除去长、宽,还多了一个深度轴,因此再加上数据轴,就形成了4D张量。虽然灰度图像数据集深度轴只有1维,理论上可以通过3D张量处理,但是机器学习中统一把灰度图像和彩色图像视为4D张量。在实际应用中,序列数据集才是机器学习中的3D张量。而时间序列(time series)(简称时序)是最为常见的序列数据集,其数据结构如右图所示。”

+ +

+ 时间序列数据集的张量结构

+咖哥又问:“刚才说到的2D数据集是哪两个轴来的?”

+一个同学高声说:“样本轴,特征轴。”

+咖哥说:“好,记得不错。这种重复正是在巩固我们的机器学习知识。”

+那么序列数据多出来哪个轴呢?就是序列的步长。对于时间序列数据来说,就是时戳(timestamp),也叫时间步。

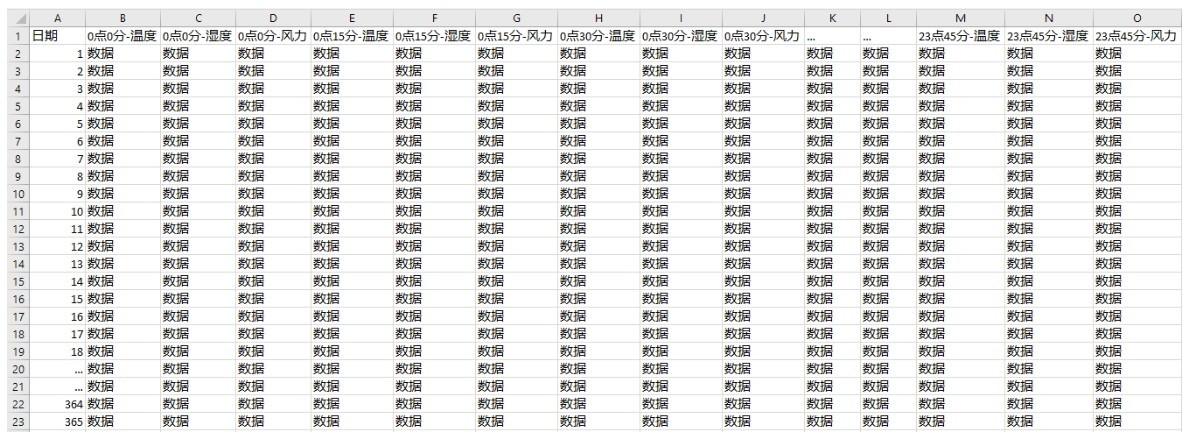

+举个例子来看,假如已经记录了北京市区一年的天气情况,这个数据集在Excel表格中大概如下图所示。

+ +

+ 带时戳的数据集

+因为增加了时戳,所以表里面的行列结构显得更为复杂。读取入机器进行处理时,需要把行里面的时间步拆分出来。

+■第一个轴—样本轴,一年记录下来的数据共365个,也就是365维。

+■第二个轴—时间步轴,每天一共是24小时,每小时4个15分钟,共96维。

+■第三个轴—特征轴,一共是温度、湿度、风力3个维度。

+因此,这个数据集读入机器之后的张量形状是(365,96,3)。

+也就是说,时序数据集的形状为3D张量:(样本,时戳,标签)。

+类似地,还有文字序列数据集。假设有一些客户的评论数据,每条评论编码成100个字组成的序列,而每个字来自1000个汉字的简易字典。在这种情况下,每个字符可以被编码为1 000字节的二进制向量(只有在该字符对应的索引位置,值为1,其他二进制位值都为0,这种编码就是one-hot编码)。那么每条评论就被编码为一个形状为(100,1 000)的2D张量。如果收集了 10 000条的客户评论,这个客户评论数据集就可以存储在一个形状为(10 000,100,1 000) 的张量中,供机器去学习。

+此时,文字序列数据集的形状为3D张量:(样本,序号,字编码)。

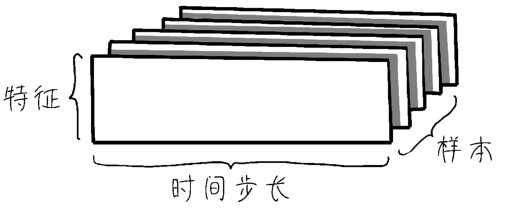

+图像数据本身包含高度、宽度,再加上一个颜色深度通道。MNIST数据集中是灰度图像,只有一个颜色深度通道;而GRB格式的彩色图像,颜色深度通道的维度为3。

+因此,对于图像数据集来说,长、宽、深再加上数据集大小这个维度,就形成了 4D 张量 (如下图所示),其形状为(样本,图像高度,图像宽度,颜色深度),如MNIST特征数据集的形状为 (60 000,28,28,1)。

+ +

+ 图像数据集的张量结构

+在机器学习中,不是对上万个数据样本同时进行处理,那样的话机器也受不了,而是一批一批地并行处理,比如指定批量大小为64。此时每批的100px×100px的彩色图像张量形状为(64, 100,100,3),如果是灰度图像,则为(64,100,100,1)。

+机器学习的初学者很少有机会见到比4D更高阶的张量。如果有,视频数据的结构是其中的一种。

+视频可以看作是由一帧一帧的彩色图像组成的数据集。

+■每一帧都保存在一个形状为(高度,宽度,颜色深度) 的3D张量中。

+■一系列帧则保存在一个形状为(帧,高度,宽度,颜色深度) 的4D张量中。

+因此,视频数据集需要5D张量才放得下,其形状为(样本,帧,高度,宽度,颜色深度)。

+可以想象,视频数据的数据量是非常大的(例如,一个10分钟的普通视频,每秒采样3~4帧,这个视频转换成机器能处理的张量后,可能包含上亿的数据量)。面对这种规模的数据,普通的机器学习模型会感到手足无措,只有深度学习模型才能够搞定。

+1.数据的维度

+前面说过,“维度”这个概念有时会造成一些混淆。因为我们会听到,一维数组、二维数组、三维数组之类的话。而在机器学习中,又时常听说数据集中的特征,是一个向量,可能是一维、二维、三维、一百维甚至一万维的向量。

+迷惑来了—向量不应该都是一维(1D)的数组吗?怎么又说是一百维、一万维的向量?好奇怪!到底是多少维?

+其实,在机器学习中,维度指的是在一个数据轴上的许多点,也就是样本的个数(样本轴上点的个数)或者特征的个数(特征轴上点的个数)。一万个不同的特征,就是一万维;而一万个数据样本,也同样可称为一万维。

+为了标准化叙述,我们把张量的每一个数据轴,统称为阶。因此,我们说一阶(1D)向量、二阶(2D)矩阵、三阶(3D)张量,而不是说维。

+但事实上,很多机器学习的教程也没有实现这种统一的标准化叙述。因此,在外面听到一维向量、二维矩阵、三维数组这样的叫法也毫不奇怪,而且这些叫法也没有错,只是容易让人混淆而已。

+2.空间的维度

+还有一点需要注意,在实际项目中,特征(也就是自变量x)的个数,都是很多的。然而在画图说明的时候,大多以一个特征x或两个特征x1、x2为例来表现x和y的关系,很少画出超过两个特征维度的情况,这是为什么呢?

+因为仅有一个特征的数据集,关系很容易被展示,从房屋面积到房价,很直接,x轴特征,y轴标签。此时一个特征维,加上一个标签维,就是二维图形,在纸面上显示没有难度。

+如果有两个特征,x1代表房屋面积,x2代表楼层,这两个特征和房价y之间的函数,怎么展示?那么可以画出一个有深度的平面显示x1、x2坐标,立体显示y值。这是从二维的平面上显示三维图形,已经需要一些透视法的作图技巧。

+对于分类问题,也可以x1作为一个轴,x2作为一个轴,用圈、点、叉,或者不同颜色的点显示y的不同分类值。这是另一种用平面显示三维信息的方法。

+那么特征再多一维呢?很难展示。比如,凸函数,一维特征的凸函数,是一条曲线,而二维特征的凸函数,就像一个碗。三维特征的凸函数是什么样的呢?我们不知道。如果非要描绘x1、x2、x3与y的关系,就需要先应用降维(dimensionality reduction)算法处理数据,把维度降到二维以内。

+这个局限来自空间本身只有3个维度,长、宽、深。绘图的时候,如果特征有两维,再加一维标签y,就把三维空间占全了。因此,我们既无法想象,也无法描绘更多维的函数形状。

+尽管空间结构限制了人类的展示能力和想象力,同学们仍然要相信:多维特征的函数图像是存在的(也许存在于其他空间中),多元凸函数也一定可以梯度下降到全局最低点……