Merge branch 'develop' of http://github.com/paddlepaddle/paddle into patch-1

Showing

cmake/inference_lib.cmake

0 → 100644

doc/api/CMakeLists.txt

0 → 100644

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

doc/design/cpp_data_feeding.md

0 → 100644

doc/dev/index_cn.rst

0 → 100644

doc/dev/index_en.rst

0 → 100644

doc/dev/write_docs_cn.rst

0 → 100644

doc/dev/write_docs_en.rst

0 → 100644

doc/getstarted/quickstart_cn.rst

0 → 100644

doc/getstarted/quickstart_en.rst

0 → 100644

文件已移动

文件已移动

doc/howto/capi/index_cn.rst

0 → 100644

文件已移动

文件已移动

doc/howto/cluster/index_cn.rst

0 → 100644

doc/howto/cluster/index_en.rst

0 → 100644

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

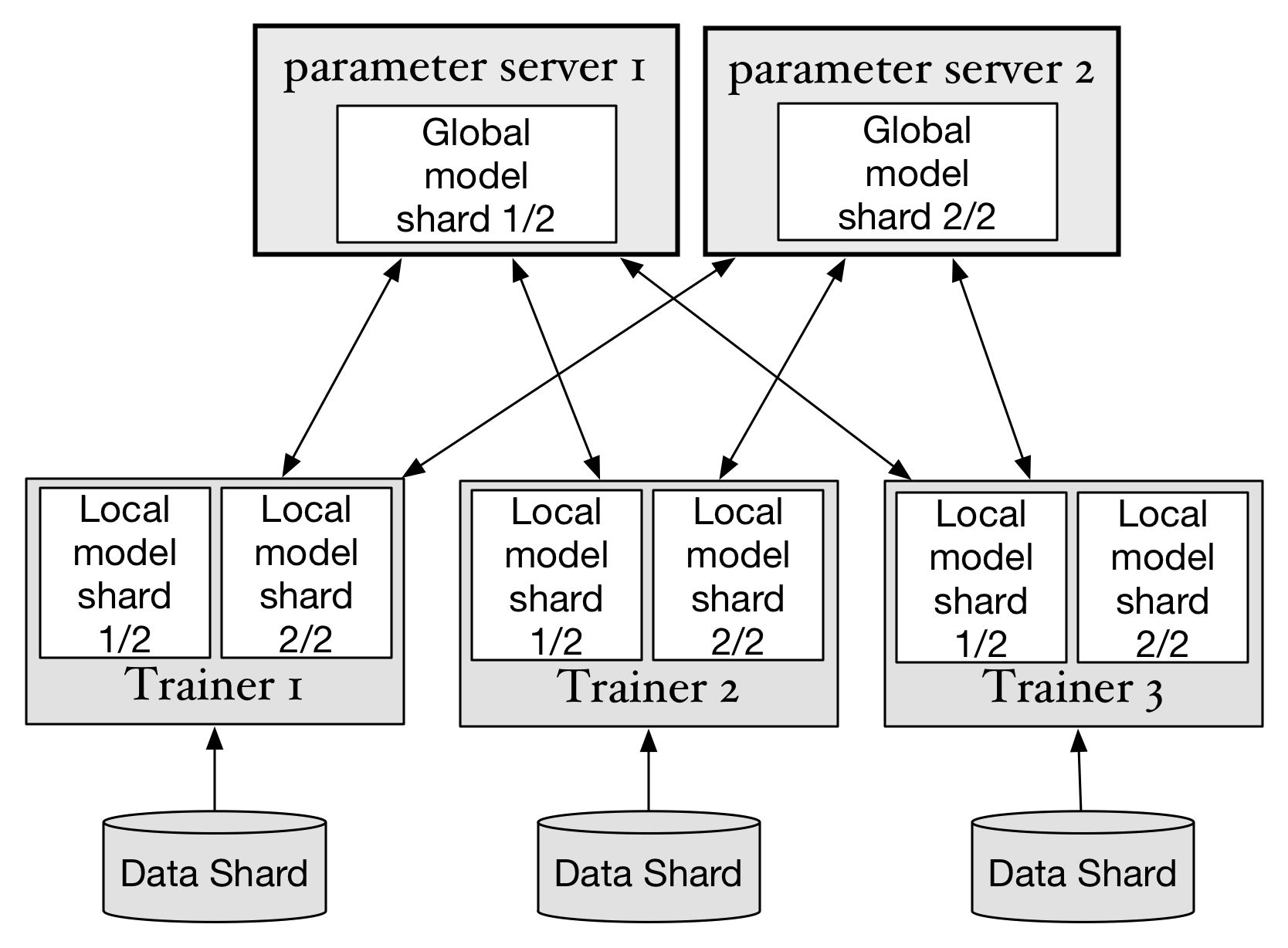

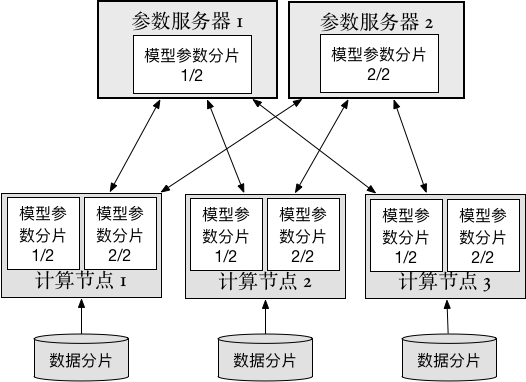

doc/howto/cluster/src/trainer.png

0 → 100644

141.7 KB

33.1 KB

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

此差异已折叠。

文件已移动

文件已移动

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

文件已移动

文件已移动

doc/howto/rnn/index_cn.rst

0 → 100644

此差异已折叠。

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

doc/mobile/index_cn.rst

已删除

100644 → 0

此差异已折叠。

doc/mobile/index_en.rst

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

paddle/fluid/CMakeLists.txt

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/backward.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/channel.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/ddim.cc

0 → 100644

此差异已折叠。

paddle/fluid/framework/ddim.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/dim.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/eigen.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/executor.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/init.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/op_desc.cc

0 → 100644

此差异已折叠。

paddle/fluid/framework/op_desc.h

0 → 100644

此差异已折叠。

paddle/fluid/framework/op_info.cc

0 → 100644

此差异已折叠。

paddle/fluid/framework/op_info.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/operator.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/prune.cc

0 → 100644

此差异已折叠。

paddle/fluid/framework/prune.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/reader.cc

0 → 100644

此差异已折叠。

paddle/fluid/framework/reader.h

0 → 100644

此差异已折叠。

paddle/fluid/framework/scope.cc

0 → 100644

此差异已折叠。

paddle/fluid/framework/scope.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/tensor.cc

0 → 100644

此差异已折叠。

paddle/fluid/framework/tensor.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/var_desc.h

0 → 100644

此差异已折叠。

paddle/fluid/framework/var_type.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/framework/variable.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/inference/io.cc

0 → 100644

此差异已折叠。

paddle/fluid/inference/io.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

paddle/fluid/memory/memcpy.cc

0 → 100644

此差异已折叠。

paddle/fluid/memory/memcpy.h

0 → 100644

此差异已折叠。

paddle/fluid/memory/memory.cc

0 → 100644

此差异已折叠。

paddle/fluid/memory/memory.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/adam_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/adam_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/adam_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/auc_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/auc_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/cast_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/cast_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/cast_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/clip_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/clip_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/clip_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/cond_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/cond_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/conv_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/conv_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/crop_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/crop_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/crop_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/cum_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/feed_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/fill_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/ftrl_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/ftrl_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/ftrl_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/gather.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/gru_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/gru_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

文件已移动

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/load_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/lrn_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/lrn_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/lrn_op.h

0 → 100644

此差异已折叠。

paddle/fluid/operators/lstm_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/lstm_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/lstmp_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/mean_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/mean_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/mean_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/minus_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/mul_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/mul_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/nccl_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/nce_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/nce_op.h

0 → 100644

此差异已折叠。

paddle/fluid/operators/net_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/net_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/norm_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/norm_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/norm_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

文件已移动

文件已移动

文件已移动

文件已移动

paddle/fluid/operators/pad_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/pad_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/pad_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/pool_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/pool_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/prelu_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/read_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/recv_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/save_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/scale_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/scatter.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/send_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/sgd_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/sgd_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/sgd_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/sign_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/sign_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/sign_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/split_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/spp_op.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/spp_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/sum_op.cc

0 → 100644

此差异已折叠。

paddle/fluid/operators/sum_op.cu

0 → 100644

此差异已折叠。

paddle/fluid/operators/sum_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/operators/top_k_op.h

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/platform/assert.h

0 → 100644

此差异已折叠。

paddle/fluid/platform/cpu_info.cc

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

文件已移动

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/platform/enforce.cc

0 → 100644

此差异已折叠。

paddle/fluid/platform/enforce.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/platform/for_range.h

0 → 100644

此差异已折叠。

paddle/fluid/platform/gpu_info.cc

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/platform/place.cc

0 → 100644

此差异已折叠。

paddle/fluid/platform/place.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/platform/profiler.cc

0 → 100644

此差异已折叠。

paddle/fluid/platform/profiler.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/platform/transform.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/fluid/pybind/.clang-format

0 → 100644

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/fluid/pybind/const_value.h

0 → 100644

此差异已折叠。

paddle/fluid/pybind/exception.cc

0 → 100644

此差异已折叠。

paddle/fluid/pybind/exception.h

0 → 100644

此差异已折叠。

paddle/fluid/pybind/protobuf.cc

0 → 100644

此差异已折叠。

paddle/fluid/pybind/protobuf.h

0 → 100644

此差异已折叠。

paddle/fluid/pybind/pybind.cc

0 → 100644

此差异已折叠。

paddle/fluid/pybind/tensor_py.h

0 → 100644

此差异已折叠。

此差异已折叠。

paddle/framework/attribute.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/attribute.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/backward.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/backward.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/block_desc.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/channel.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/data_type.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/ddim.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/ddim.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/ddim_test.cc

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/dim.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/dim_test.cu

已删除

100644 → 0

此差异已折叠。

paddle/framework/eigen.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

paddle/framework/executor.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/executor.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/init.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/init_test.cc

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/lod_tensor.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/op_desc.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/op_desc.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/op_info.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/op_info.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/operator.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/operator.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/prune.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/prune.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

paddle/framework/scope.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/scope.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/tensor.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/tensor.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/threadpool.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/type_defs.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/var_desc.cc

已删除

100644 → 0

此差异已折叠。

paddle/framework/var_desc.h

已删除

100644 → 0

此差异已折叠。

paddle/framework/var_type.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/framework/variable.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/inference/io.cc

已删除

100644 → 0

此差异已折叠。

paddle/inference/io.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/memory/.clang-format

已删除

120000 → 0

此差异已折叠。

paddle/memory/CMakeLists.txt

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/memory/memcpy.cc

已删除

100644 → 0

此差异已折叠。

paddle/memory/memcpy.h

已删除

100644 → 0

此差异已折叠。

paddle/memory/memory.cc

已删除

100644 → 0

此差异已折叠。

paddle/memory/memory.h

已删除

100644 → 0

此差异已折叠。

paddle/memory/memory_test.cc

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/operators/adagrad_op.h

已删除

100644 → 0

此差异已折叠。

paddle/operators/adam_op.cc

已删除

100644 → 0

此差异已折叠。

paddle/operators/adam_op.cu

已删除

100644 → 0

此差异已折叠。

paddle/operators/adam_op.h

已删除

100644 → 0

此差异已折叠。

paddle/operators/adamax_op.cc

已删除

100644 → 0

此差异已折叠。

paddle/operators/adamax_op.cu

已删除

100644 → 0

此差异已折叠。

paddle/operators/adamax_op.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/operators/assign_op.cc

已删除

100644 → 0

此差异已折叠。

此差异已折叠。

此差异已折叠。

此差异已折叠。

paddle/operators/auc_op.cc

已删除

100644 → 0

此差异已折叠。

paddle/operators/auc_op.h

已删除

100644 → 0

此差异已折叠。

此差异已折叠。